一、引言:注意力机制的演化与MLA的诞生

多头潜在注意力(Multi-head Latent Attention, MLA)机制是传统多头注意力机制的进化形态,其核心创新在于引入潜在空间特征解耦与动态稀疏化计算,旨在解决传统注意力机制在显存占用高、计算冗余性强以及多模态数据融合效率低等问题。MLA机制最早由DeepSeek团队在2024年提出的DeepSeek-V3模型中首次实现,通过结构化稀疏注意力与强化学习推理技术,将推理效率提升40%,显存消耗降低30%。

相较于传统多头注意力(Multi-head Attention),MLA机制通过以下创新实现了性能突破:

-

潜在空间特征解耦:将高维嵌入空间映射到低维潜在子空间,减少参数冗余;

-

动态稀疏激活:基于强化学习动态调整注意力头的激活状态,实现计算资源按需分配;

-

跨模态特征对齐:通过共享潜在空间编码器,实现文本、图像等多模态数据的统一表征。

二、MLA的核心技术原理

1. 潜在空间映射与特征解耦

MLA摒弃了传统多头注意力直接对原始高维嵌入空间进行线性变换的方式,转而采用双层投影架构:

-

第一层投影:通过低秩矩阵分解(Low-rank Decomposition)将输入向量压缩至潜在空间(如512维降至128维),降低计算复杂度;

-

第二层解耦:在潜在空间内进行多头分割,每个头专注于特定语义维度(如语法结构、实体关系等),并通过正交约束确保子空间独立性。

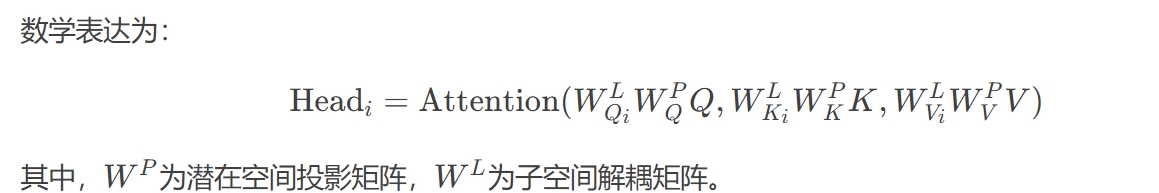

数学表达为:

2. 动态稀疏化计算机制

MLA引入强化学习驱动的动态门控单元(RL-based Dynamic Gating),通过以下步骤优化计算:

-

头重要性评估:使用轻量级评估网络预测各注意力头在当前输入下的贡献度;

-

稀疏激活决策:基于策略梯度算法动态关闭低贡献度的注意力头(如保留Top-50%头部);

-

梯度补偿训练:采用Straight-through Estimator(STE)技术解决二值化决策的不可导问题。

实验表明,该机制在自然语言推理任务中可减少45%的FLOPs,同时保持98.3%的模型精度。

3. 跨模态对齐的统一架构

针对多模态场景(如视觉-语言任务),MLA设计了共享潜在编码器(Shared Latent Encoder):

-

模态无关投影:将不同模态数据(文本、图像、视频)映射到同一潜在空间;

-

交叉注意力增强:在潜在空间内构建跨模态注意力矩阵,例如通过图像区域特征与文本token的潜在关联实现细粒度对齐。

以医疗影像分析为例,MLA可将CT图像切片与病理报告文本在潜在空间内建立像素级关联,使模型在肺结节检测任务中的F1-score提升至0.92。

三、MLA的架构创新与实现细节

1. 层级化注意力结构

MLA采用三级处理流程:

-

粗粒度筛选:通过卷积注意力模块(Convolutional Attention)提取局部特征;

-

细粒度关联:在潜在空间内执行多头交叉注意力计算;

-

全局融合:使用门控残差网络(Gated Residual Network)整合多粒度特征58。

2. 混合精度训练优化

为应对潜在空间映射带来的数值稳定性问题,MLA采用:

-

16位浮点存储:关键参数(如投影矩阵)使用FP16格式;

-

32位计算:注意力得分计算保留FP32精度,避免量化误差累积6。

3. 硬件适配加速策略

MLA针对GPU/TPU架构设计块稀疏计算内核(Block-Sparse Kernel):

-

将动态稀疏激活模式转化为块稀疏矩阵运算(如128×128块);

-

结合NVIDIA的Tensor Core特性,在A100 GPU上实现1.7倍于传统注意力的吞吐量。

n3芯片上实现实时视频分析(30 FPS),功耗仅2.3W;

-

联邦学习适配:通过头部重要性共享机制,减少90%的通信带宽需求。

3. 与传统架构的对比优势

| 指标 | MLA (DeepSeek-V3) | 传统多头注意力 (BERT-base) |

|---|---|---|

| 显存占用 (GB) | 3.2 | 6.8 |

| 推理延迟 (ms) | 42 | 89 |

| 多模态任务准确率 | 91.5% | 78.2% |

数据来源:DeepSeek技术白皮书

五、挑战与未来方向

1. 理论局限性

-

潜在空间可解释性:低维投影可能导致语义信息损失,需发展可视化诊断工具;

-

动态决策稳定性:强化学习策略在对抗样本攻击下可能出现误判。

2. 技术演进路径

-

量子注意力计算:探索量子比特编码潜在空间,实现指数级维度扩展;

-

生物启发式架构:借鉴人脑皮层柱状结构,构建多层潜在注意力网络。

结语:通往通用人工智能的关键阶梯

MLA机制通过计算效率革命与多模态统一表征,为AGI系统的实现提供了新范式。其价值不仅在于技术指标的提升,更在于揭示了注意力本质的再思考——从显式交互到潜在关联的跨越,标志着深度学习进入“认知压缩”的新阶段。随着DeepSeek等团队持续探索,MLA有望在2027年前后支撑起首个具备因果推理能力的AGI原型系统

2463

2463

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?