研究意义

随着GNN的应用越来越广,在安全非常重要的应用中应用GNN,存在漏洞可能是非常严重的。

比如说金融系统和风险管理,在信用评分系统中,欺诈者可以伪造与几个高信用客户的联系,以逃避欺诈检测模型;或者垃圾邮件发送者可以轻松地创建虚假的关注者,向社交网络添加错误的信息,以增加推荐和传播重大新闻的机会,或者操控在线评论和产品网站。

因此,我们需要研究对图神经网络的攻击和防御,在我们真正部署一个模型前,应该确认一下这个模型在面对对抗攻击的时候足够健壮?

参考资料

https://zhuanlan.zhihu.com/p/88934914

https://blog.csdn.net/b224618/article/details/82025371

https://blog.csdn.net/travalscx/article/details/84677646

https://www.in.tum.de/en/daml/all-news/news-single-view-en/article/best-paper-award-at-kdd-2018/

- 项目:https://www.in.tum.de/daml/nettack/

- 项目:https://www.in.tum.de/en/daml/research/nettack/

- 代码:https://github.com/danielzuegner/nettack

- poster:https://www.in.tum.de/fileadmin/w00bws/daml/nettack/kdd_poster.pdf

- paper:https://arxiv.org/abs/1805.07984

- talk ppt:https://www.in.tum.de/fileadmin/w00bws/daml/nettack/kdd_talk.pdf

介绍

来自KDD 2018,最佳论文。图神经网络上的对抗攻击的开山之作。

场景

备注:

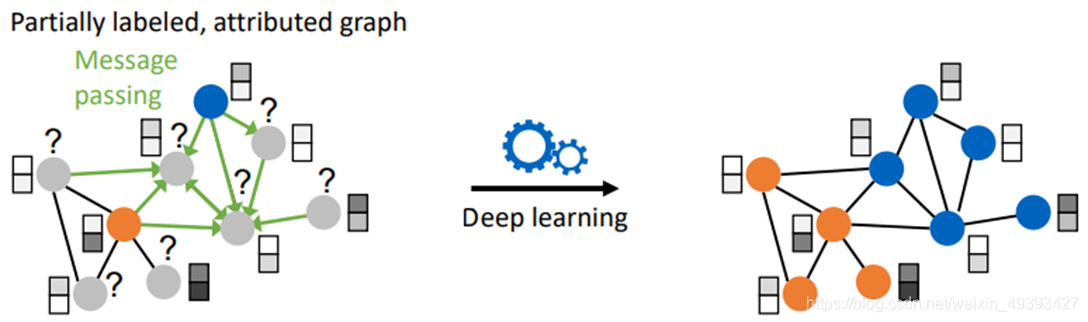

考虑一个简单且经典的场景,图上的结点分类任务。

给定一张图,图上部分结点有标签,通过训练一个深度学习模型来预测图上结点的分类。

一方面预测不基于单独的示例而是联合了图上很多实

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

512

512

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?