书生·浦语大模型趣味 Demo

第二次课程内容是跑通已经预设的3个demo:

1.InternLM-Chat-7B 智能对话

2.Lagent工具调用解简单数学题

3.浦语·灵笔多模态图文创作和理解

原视频链接:https://www.bilibili.com/video/BV1Ci4y1z72H/

InternStudio:https://studio.intern-ai.org.cn/

github教程链接:https://github.com/InternLM/tutorial/blob/main/helloworld/hello_world.md

————————————————

版权声明:本文为CSDN博主「墨香温存」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/Hyt_foxxx/article/details/135396145

1、内容回顾

internLM是模型训练框架;lagent是智能体构建框架;

2、对话demo

创建开发机环境: GPU 1/4A100; 56G内存;

创建和激活conda环境、并安装相应的python包,注意使用 pytorch 2.0.1的版本

将internlm-chat-7b模型下载到指定目录

使用InternLM的代码并切到这个3028f07cb79e5b1d7342f4ad8d11efad3fd13d17commit位置

运行cli_demo.py可以得到命令行版本的对话

如果运行web_demo.py,可以得到网页版本的demo

3、Lagent智能体demo

同样准备coda环境、模型

这次使用lagent的代码InternLM/lagent

修改/root/code/lagent/examples/react_web_demo.py的内容并运行,得到网页版本的agent对话框

这个文件的内容较多,目前没有详细看。

4、灵笔图文理解创作 Demo

这个需要更多的显存,1/4A100 * 2的配置,就是40g显存

同样准备coda环境、模型

使用的代码是InternLM/InternLM-XComposer

智能对话 Demo

配置服务器环境

选择A100(1/4) 的配置,镜像选择 Cuda11.7-conda(就这一个选项。。)

进入开发机。

在终端输入 bash 命令,进入 conda 环境。

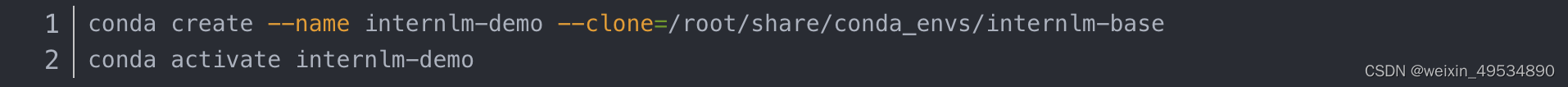

从本地克隆一个已有的 pytorch 2.0.1 的环境。

安装所需依赖

模型下载

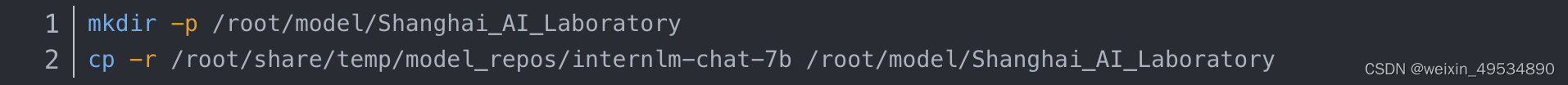

直接复制 share 目录下的 InternLM 模型。-r 选项表示递归地复制目录及其内容

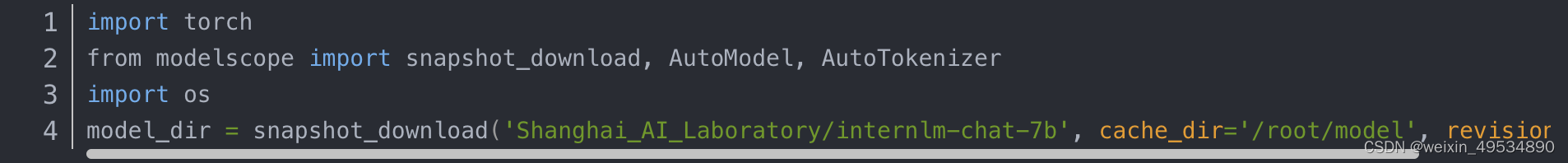

也可以使用 modelscope 中的 snapshot_download 函数下载模型,第一个参数为模型名称,参数 cache_dir 为模型的下载路径。

在 /root 路径下新建目录 model,在目录下新建 download.py 文件并在其中输入以下内容,保存文件。并在终端运行 python /root/model/download.py 执行下载。

————————————————

版权声明:本文为CSDN博主「墨香温存」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/Hyt_foxxx/article/details/135396145

代码准备

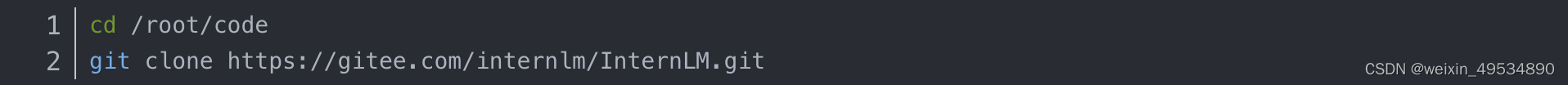

在 /root 路径下新建 code 目录,clone 代码.

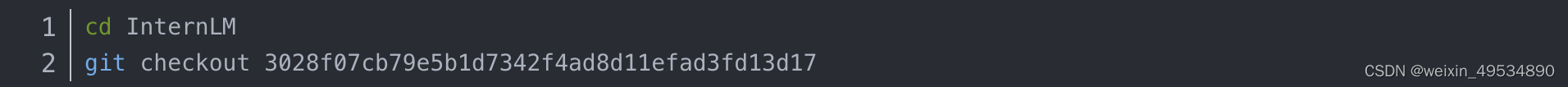

切换 commit 版本,这一步是为了与教程 commit 版本保持一致。

更改web_demo.py 中模型的路径,更改为/root/model/Shanghai_AI_Laboratory/internlm-chat-7b。

终端运行

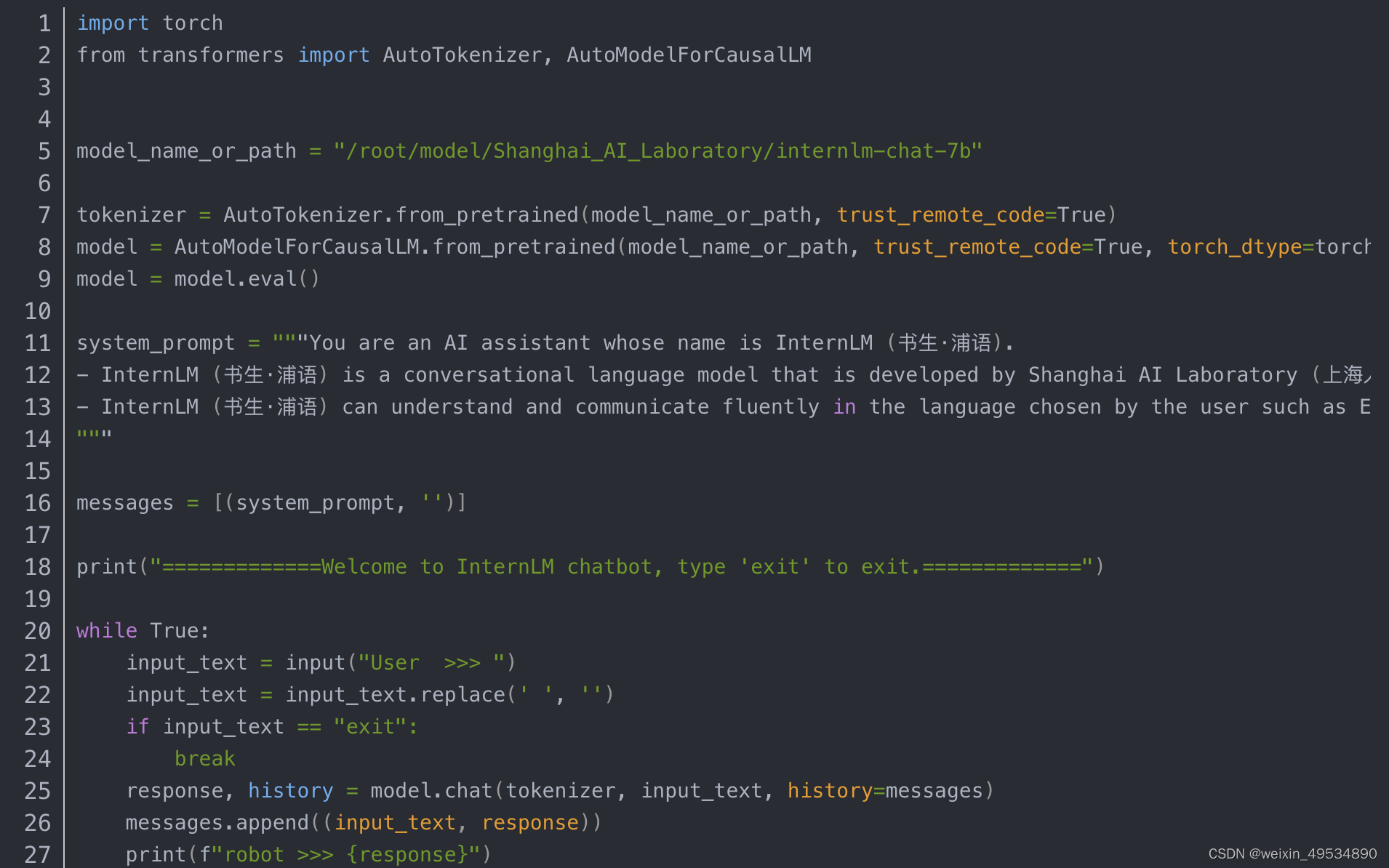

在 /root/code/InternLM 目录下新建一个 cli_demo.py 文件,其中代码如下:

终端运行cli_demo.py

运行web demo

访问服务器上的web 应用需要先配置本地端口。

配置本地端口

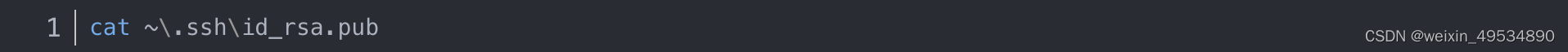

step1:在本地机器上打开终端。运行以下命令来生成 SSH 密钥对

step2: 将被提示选择密钥文件的保存位置,默认情况下是在 ~/.ssh/ 目录中。按 Enter 键接受默认值或输入自定义路径。

step3:公钥默认存储在 ~/.ssh/id_rsa.pub,通过cat 工具查看文件内容:

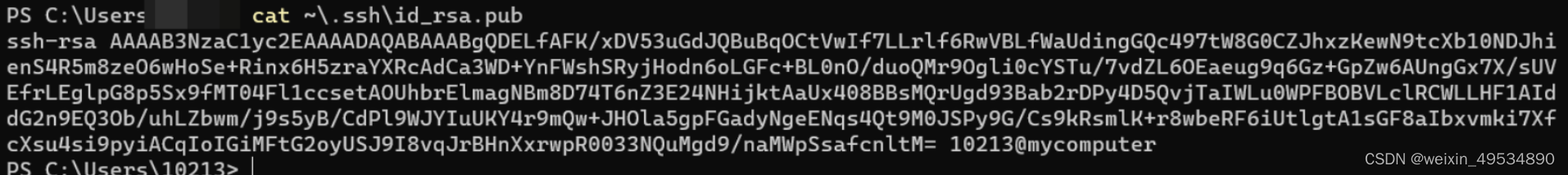

公钥

step4:在InternStudio的控制台中配置SSH Key。

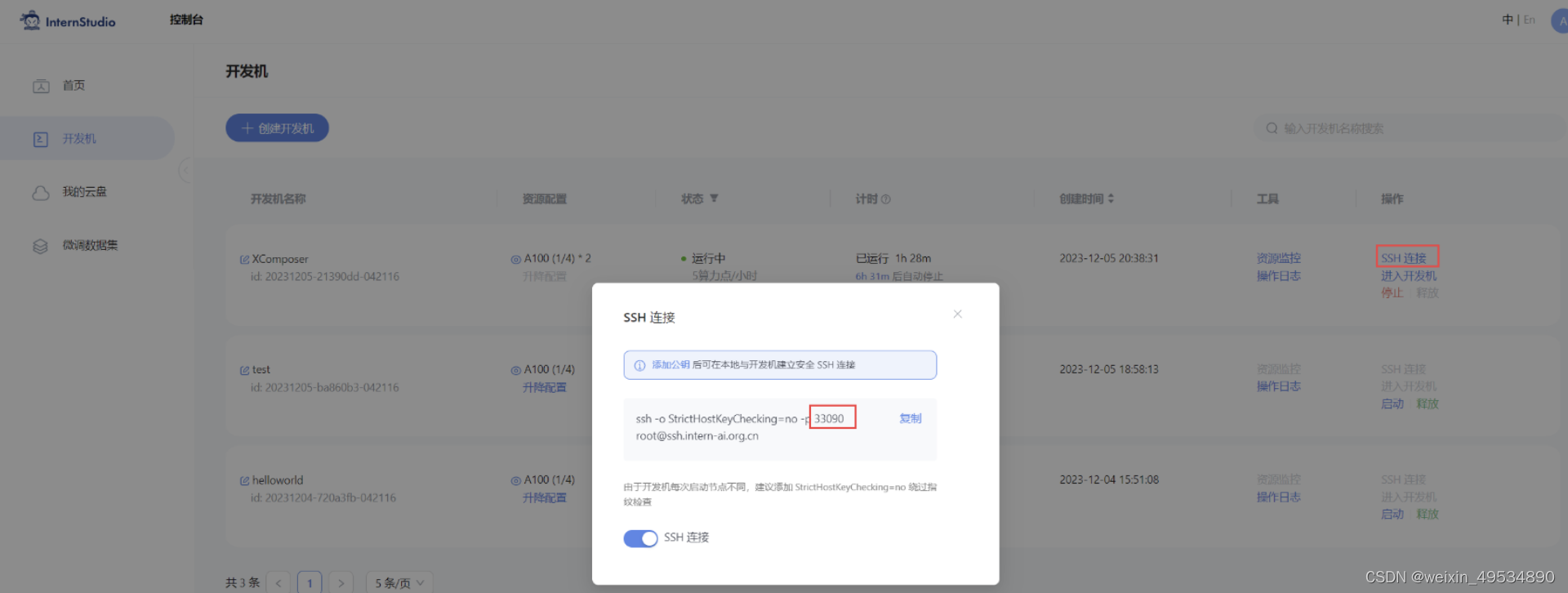

step5:在开发机界面里点击SSH链接可以看到连接服务器的代码,33090 是根据开发机的端口进行更改的,每个人的可能不一样。复制这一行代码到终端/vscode中可以连接服务器。

运行

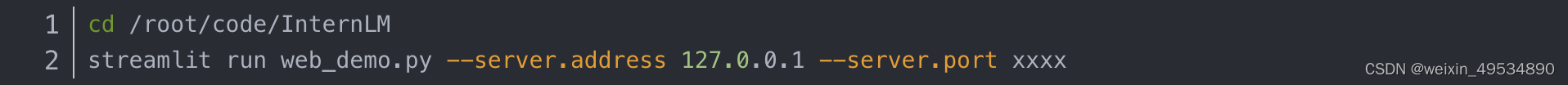

配置好本地端口之后在终端运行/root/code/InternLM 目录下的 web_demo.py 文件,并设置地址和端口号。(注意要在配置好的虚拟环境中运行)

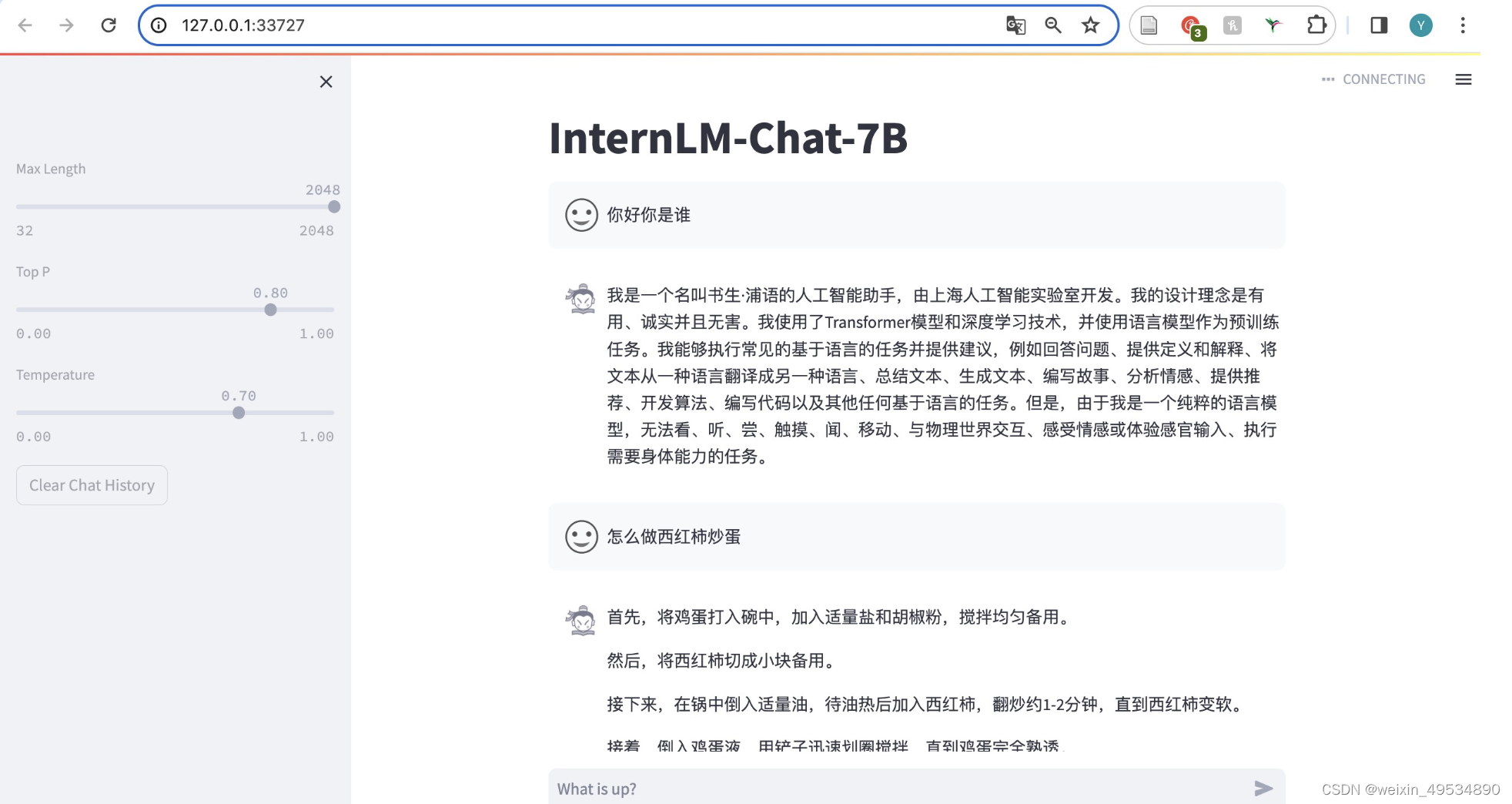

进入网站之后才会开始加载模型,效果如下:

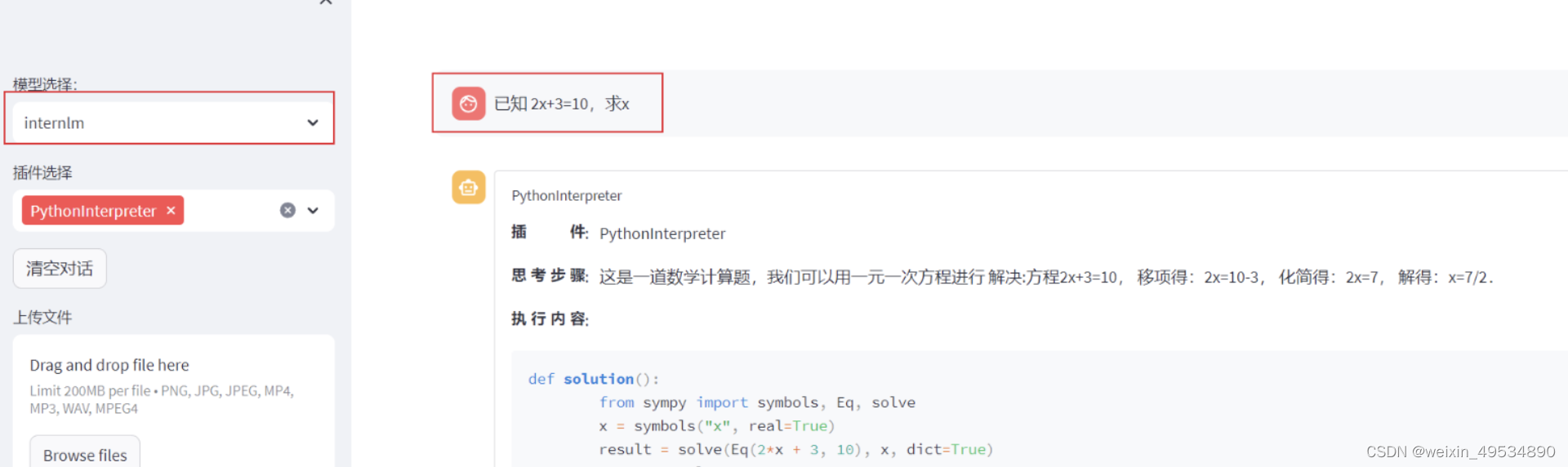

Lagent 智能体工具调用 Demo

Lagent 安装

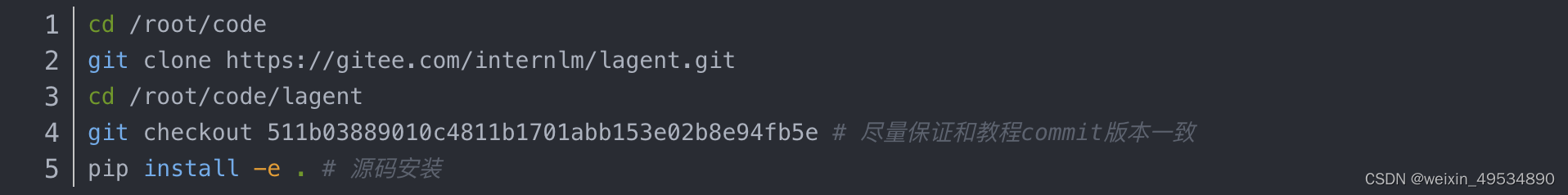

首先切换路径到 /root/code 克隆 lagent 仓库,并通过 pip install -e . 源码安装 Lagent

修改代码

由于代码修改的地方比较多,直接将 /root/code/lagent/examples/react_web_demo.py 内容替换为以下代码:

Demo运行

在 Web 页面选择 InternLM 模型,等待模型加载完毕后,输入数学问题 已知 2x+3=10,求x ,此时 InternLM-Chat-7B 模型理解题意生成解此题的 Python 代码,Lagent 调度送入 Python 代码解释器求出该问题的解。

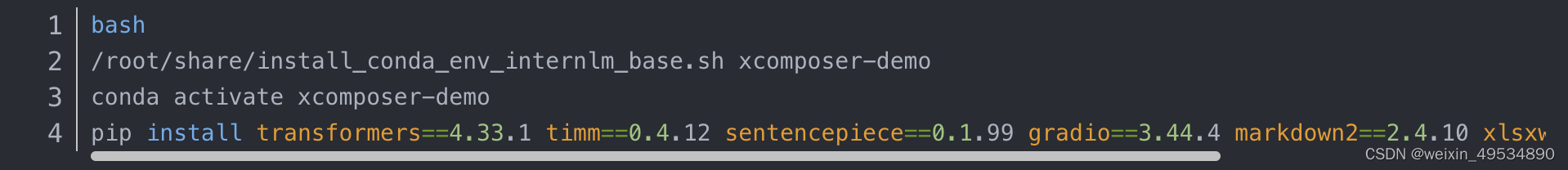

浦语·灵笔图文理解创作 Demo

本小节我们将使用 InternStudio 中的 A100(1/4) * 2 机器和 internlm-xcomposer-7b 模型部署一个图文理解创作 Demo 。

环境准备

首先在 InternStudio 上选择 A100(1/4)*2 的配置。coda11.7。

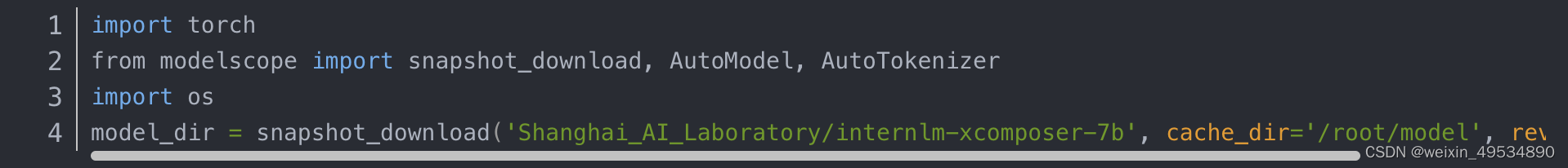

模型下载

安装 modelscope pip install modelscope==1.9.5

在 /root/model 路径下新建 download.py 文件并在其中输入以下内容,并运行 python /root/model/download.py 执行下载

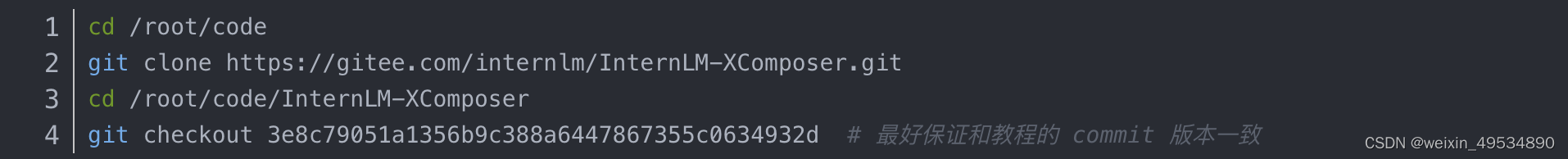

代码准备

在 /root/code git clone InternLM-XComposer 仓库的代码

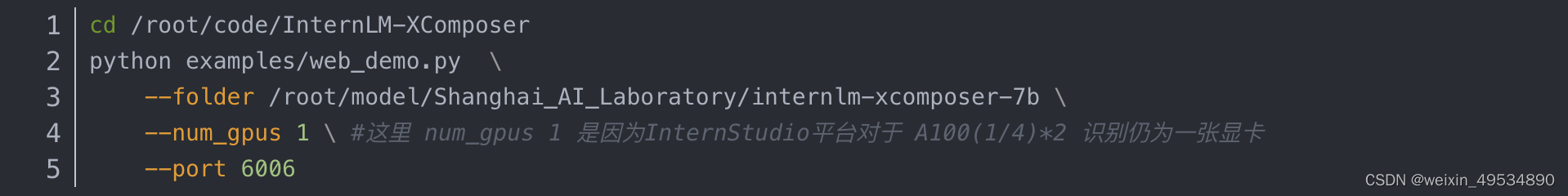

demo运行

在终端输入

1615

1615

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?