EfficientSAM: Leveraged Masked Image Pretraining for Efficient Segment Anything

文章汇总

前提必读(本文的基础模型):论文解读:Segment Anything-CSDN博客

问题

SAM功能强大的原因是一个数据大,另一个encoder足够大足够强,但是也由于encoder足够的大所以不能做到实时分割,如Segment Anything | Meta AI中加载demo图片为encoder的过程,需要2-4s左右。

动机

提出一种轻量级的SAM模型,它既表现出良好的性能,与SAM效果相当,而且能够大大降低了encoder网络结构复杂性

解决办法

其实相当于知识蒸馏,让SAM生成的图像特征作为伪标签给轻量级的encoder学习,类似于让SAM做teacher,轻量级的Light-weight Encoder做student。

maks自动化编码

类似于bert,mask掉其中一个词,模型的目标是通过其他词也能把被mask掉的词还原回来。而在视觉当中,也是通过mask某一块特征,通过附件的特征来还原回原来的特征。

这里掩码比率(如75%),即mask比例达到了75%,也就是一个图片3/4将会被mask掉,等待被还原。比如上面的总体结构图中 Masked image就mask了6个图片区域,剩3未被mask的图片区域。

摘要

细分一切模型(SAM)已经成为许多视觉应用的强大工具。驱动零样本迁移和高通用性令人印象深刻的性能的关键组件是在广泛的高质量SA-1B数据集上训练的超大Transformer模型(me:SAM功能强大的原因是一个数据大,另一个encoder足够大足够强)。虽然SAM模型是有益的,但其巨大的计算成本限制了其在实际应用中的广泛应用。

为了解决这个限制,我们提出了efficientsam,这是一种轻量级的SAM模型,它表现出良好的性能,同时大大降低了复杂性。我们的想法是基于利用mask图像预训练SAMI,它学习从SAM图像编码器中重建特征,以实现有效的视觉表征学习。此外,我们采用sami预训练的轻量级图像编码器和掩码解码器来构建高效sams,并对SA-1B上的模型进行微调以进行分段任何任务。我们对多个视觉任务进行了评估,包括图像分类、目标检测、实例分割和语义目标检测,并发现我们提出的预训练方法SAMI始终优于其他掩模图像预训练方法。在分割任何任务(如零镜头实例分割)上,我们的高效sams与sami预训练的轻量级图像编码器相比其他快速SAM模型表现良好,具有显着增益(例如,在COCO/LVIS上约4 AP)。

(me:类似知识蒸馏,通过训练好的大encoder即SAM,想办法训练出一个小的SAM)

图1所示。对比分析结果。(上)通过采用经过良好预训练的轻量级图像编码器进行实例分割,大大降低了复杂性的effentsam模型概述。(下)效率SAM、MobileSAM、FastSAM和SAM在COCO上进行零射击实例分割的吞吐量/参数/性能比较。我们在单个NVIDIA A100上对所有型号的吞吐量(每秒图像)进行基准测试,并给出一个框提示。输入图像分辨率为1024 × 1024。我们的efficientsam在相当复杂的情况下,比MobileSAM和FastSAM的性能高出约4 AP。我们的EfficientSAM-S将SAM的推理时间减少了约20倍,参数大小减少了约20倍,性能下降很小,分别为44.4 AP和46.5 AP。

3. 方法

图2。EfficientSAM框架概述。我们提出的EfficientSAM包含两个阶段:ImageNet上的SAMI预训练(上)和SA-1B上的SAM调优(下)。对于SAMI预训练,掩码自编码器以SAM图像编码器的特征嵌入作为重建目标。SAMI预训练完成后,丢弃解码器,将轻量级编码器作为EfficientSAM的图像编码器,在SA-1B上进行微调。

3.1. 准备

maks自动化编码

掩码自动编码器(MAE)模型有两个组成部分,一个编码器和一个解码器。编码器和解码器都建立在Transformer层上[55]。MAE将图像标记,即来自输入图像的非重叠patch作为输入。这些输入令牌按给定的屏蔽比率分组为未屏蔽令牌和被屏蔽令牌。在自监督学习(MIM)过程中,将未被屏蔽的token作为MAE解码器需要重构的学习目标,以供编码器提取特征。MAE[26]采用了较高的掩码比率(如75%),防止了预训练阶段的信息泄露(如简单地根据邻域推断掩码像素)。

me:类似于bert,mask掉其中一个词,模型的目标是通过其他词也能把被mask掉的词还原回来。而在视觉当中,也是通过mask某一块特征,通过附件的特征来还原回原来的特征。

这里掩码比率(如75%),即mask比例达到了75%,也就是一个图片3/4将会被mask掉,等待被还原。

3.2. SAM杠杆蒙面图像预训练

我们现在采用MAE框架来获得分割任意模型的高效图像编码器。由于SAM的高通用性[31],我们探索来自SAM图像编码器的潜在特征作为利用MAE的重建目标。我们的方法强调传递嵌入在SAM中的知识。图2(上)说明了所提出的利用sam的掩膜图像预训练SAMI的概述。编码器将未掩码标记转换为潜在特征表示,解码器通过从编码器嵌入的输出特征来重建被掩码标记的表示。重构的表示学习是由SAM的潜在特征引导的。

Cross-Attention解码器

在SAM特征的监督下,我们观察到只有掩码令牌需要通过解码器重建,而编码器的输出可以在重建期间充当锚点。在交叉注意解码器中,查询来自掩码令牌,键和值来自编码器和掩码特征的非掩码特征。我们将来自交叉注意解码器的掩码令牌的输出特征与来自编码器的未掩码令牌的输出特征进行合并,用于MAE的输出嵌入。然后,这些组合的特征将被重新排序到最终MAE输出的输入图像标记的原始位置。

线性投影头

我们通过编码器和交叉注意解码器获得图像输出。然后我们将这些特征输入到一个小的项目头中,用于对齐来自SAM图像编码器的特征。为了简单起见,我们只使用线性投影头来解决SAM图像编码器和MAE输出之间的特征维度不匹配。

重建的损失

在每次训练迭代中,SAMI由SAM图像编码器的前馈特征提取和MAE的前馈和反向传播过程组成。比较了SAM图像编码器和MAE线性投影头的输出,计算了重建损失。

SAMI是高效的SAM

经过预训练,我们的编码器提取各种视觉任务的特征表示,解码器被放弃修改。特别是,为了为分割任何任务构建有效的SAM模型,我们将sami预训练的轻量级编码器(如viti - tiny和viti - small)作为我们的EfficientSAM的图像编码器和SAM的默认掩码解码器,如图2(底部)所示。我们对SA-1B数据集上的EfficientSAM模型进行了优化,以用于分段任何任务。我们的EfficientSAM框架的概述如图2所示。

4. 实验

4.1. 实验设置

准备的数据集

我们的遮罩图像预训练方法SAMI是在包含120万张图像的ImageNet-1K训练集上进行的。在蒙面图像预训练[26]之后,我们不使用标签信息。我们使用来自[31]的SAM ViT- h图像编码器在预训练我们的ViT模型、vittiny、ViTSmall和vitbase时生成重建特征。

4.2. 主要结果

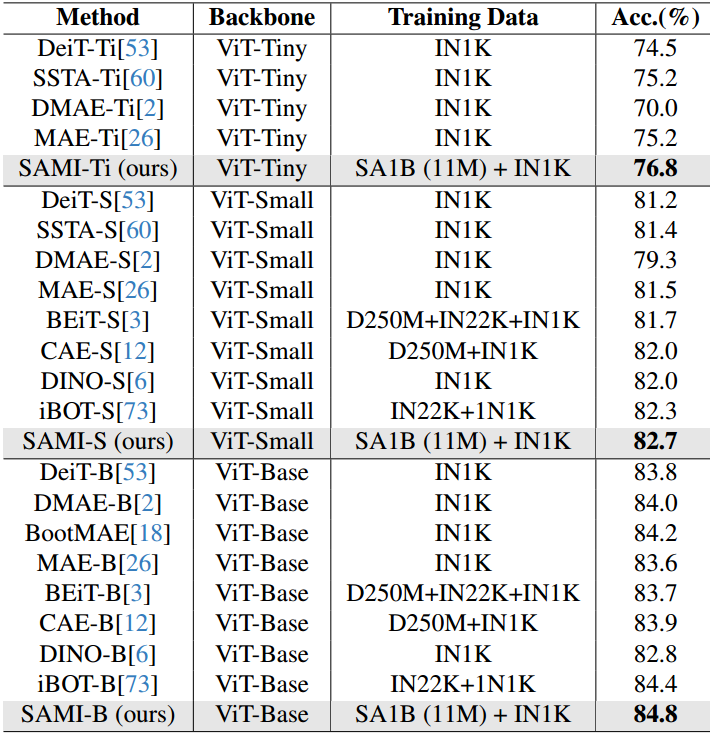

图像分类

为了评估我们提出的技术在图像分类任务上的有效性,我们将提出的SAMI思想应用于ViT模型,并在ImageNet-1K的基线上比较它们的性能。如表1所示,我们的SAMI与MAE、iBOT、CAE、BEiT等预训练方法以及DeiT、SSTA等蒸馏方法进行了对比。SAMI-B达到了84.8%的top1准确率,比预训练基线、MAE、DMAE、iBOT、CAE和BEiT分别高出1.2%、0.8%、1.1%、0.9%和0.4%。与DeiT和SSTA等蒸馏方法相比,SAMI也有较大的改进。对于轻量级模型,如viti - tiny和viti - small,与DeiT、SSTA、DMAE和MAE相比,SAMI报告了显著的增益。

表1。ImageNet-1K图像分类结果。IN是ImageNet的缩写。

4.4. 消融实验

现在,我们通过ViT主干的一系列消融研究来分析SAMI和efficientsam。

Reconstruction Loss的设计

在ImageNet-1K上研究了重建损失对SAMI性能的影响。我们比较了均方误差(MSE)重建损失和余弦相似度损失。我们发现MSE重构损失表现更好,如表6所示。这建议直接重建SAM特征,而不是具有高角度相似性的目标。

表6所示。消融术对SAMI训练损失的影响。MSE损失在ImageNet-1K上给出了更好的分类结果

Cross-Attention译码器

为了重建SAM特征,我们直接使用编码器的输出令牌,只使用解码器对交叉注意的掩码令牌进行转换。我们研究了通过解码器作为MAE的所有令牌的性能变化[26]。当查询解码器中的掩码令牌时,我们发现SAMI-Ti在ImageNet-1K上的性能比将所有令牌作为MAE馈送到解码器中进行目标重建要好3%[26]。与AnchorDETR中的锚点类似[58],编码器的输出标记已经通过直接对齐SAM特征学习得很好,SAM特征可以作为锚标记,通过交叉注意解码器帮助屏蔽标记对齐。

调优步骤对efficientsam的影响

我们将探讨调优步骤对efficientsam的影响。如图7所示,即使在0.1 epoch, EfficientSAM-Ti和EfficientSAM-S也能取得不错的性能。对于1 epoch,性能增益大于2.5 mIoU。EfficientSAM-S的最终性能达到76.9 mIoU,仅比SAM低1.5 mIoU。这些结果证明了sami预训练图像编码器和我们的高效sams的优势。

图7。MS COCO数据集上高效sams训练步骤的消融研究。零样本单点有效掩模评估与一个单一的框提示进行消融。

5. 结论

我们提出了一种掩膜图像预训练方法SAMI,在SAM基础模型的指导下,探索ViTs的潜力。SAMI通过重建SAM图像编码器的潜在特征来改进掩膜图像的预训练,将视觉基础模型中的知识转移到vit中。在图像分类、目标检测和实例分割、语义分割以及任意分割任务上的大量实验一致验证了SAMI的优势。我们还证明了SAMI有助于使用预训练的轻量级编码器构建高效的SAMs。我们的初步工作表明,SAMI在高效分段任何任务之外具有潜在的应用。

参考资料

论文下载(2024 CVPR满分论文)

https://arxiv.org/abs/2312.00863

909

909

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?