目录

一、数据清洗及特征处理

1.1缺失值观察与处理

缺失值观察

#方法一

df.info()<class 'pandas.core.frame.DataFrame'> RangeIndex: 891 entries, 0 to 890 Data columns (total 12 columns): # Column Non-Null Count Dtype --- ------ -------------- ----- 0 PassengerId 891 non-null int64 1 Survived 891 non-null int64 2 Pclass 891 non-null int64 3 Name 891 non-null object 4 Sex 891 non-null object 5 Age 714 non-null float64 6 SibSp 891 non-null int64 7 Parch 891 non-null int64 8 Ticket 891 non-null object 9 Fare 891 non-null float64 10 Cabin 204 non-null object 11 Embarked 889 non-null object dtypes: float64(2), int64(5), object(5) memory usage: 83.7+ KB

#方法二

df.isnull().sum()PassengerId 0 Survived 0 Pclass 0 Name 0 Sex 0 Age 177 SibSp 0 Parch 0 Ticket 0 Fare 0 Cabin 687 Embarked 2 dtype: int64

# 方法三

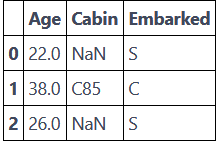

df[['Age','Cabin','Embarked']].head(3)

对缺失值进行处理

| 函数 | 功能 |

|---|---|

| df[df['Age']==None]=0 | 把缺失值赋为0 |

| df[df['Age'].isnull()] = 0 | 把缺失值赋为0 |

| df[df['Age'] == np.nan] = 0 | 把缺失值赋为0 |

| df.dropna().head(3) | 删去有缺失值的行 |

| df.fillna(0).head(3) | 把缺失值赋为0 |

P.S.检索空缺值用np.nan,None以及.isnull()哪个更好?

数值列读取数据后,空缺值的数据类型为float64所以用None一般索引不到,比较的时候最好用np.nan

重复值观察与处理

# 查看数据中的重复值

df[df.duplicated()]

对重复值进行处理

| 函数 | 功能 |

|---|---|

| df = df.drop_duplicates() | 清理重复值行 |

1.2 特征观察与处理

我们对特征进行一下观察,可以把特征大概分为两大类:

数值型特征:Survived ,Pclass, Age ,SibSp, Parch, Fare,其中Survived, Pclass为离散型数值特征,Age,SibSp, Parch, Fare为连续型数值特征

文本型特征:Name, Sex, Cabin,Embarked, Ticket,其中Sex, Cabin, Embarked, Ticket为类别型文本特征。

数值型特征一般可以直接用于模型的训练,但有时候为了模型的稳定性及鲁棒性会对连续变量进行离散化。文本型特征往往需要转换成数值型特征才能用于建模分析。

对连续型变量进行分箱(离散化)处理

#将连续变量Age平均分箱成5个年龄段,并分别用类别变量12345表示

df['AgeBand'] = pd.cut(df['Age'], 5,labels = [1,2,3,4,5])

df.head()

#将连续变量Age划分为(0,5] (5,15] (15,30] (30,50] (50,80]五个年龄段,并分别用类别变量12345表示

df['AgeBand'] = pd.cut(df['Age'],[0,5,15,30,50,80],labels = [1,2,3,4,5])

df.head(3)

#将连续变量Age按10% 30% 50 70% 90%五个年龄段,并用分类变量12345表示

df['AgeBand'] = pd.qcut(df['Age'],[0,0.1,0.3,0.5,0.7,0.9],labels = [1,2,3,4,5])

df.head()

对文本变量进行变换

#查看类别文本变量名及种类

#方法一: value_counts

df['Sex'].value_counts()male 453 female 261 0 1 Name: Sex, dtype: int64

#方法二: unique

df['Sex'].unique()array(['male', 'female', 0], dtype=object)

#将类别文本转换为12345

#方法一: replace

df['Sex_num'] = df['Sex'].replace(['male','female'],[1,2])

df.head()

#方法二: map

df['Sex_num'] = df['Sex'].map({'male': 1, 'female': 2})

df.head()

#将类别文本转换为one-hot编码

#方法一: OneHotEncoder

for feat in ["Age", "Embarked"]:

# x = pd.get_dummies(df["Age"] // 6)

# x = pd.get_dummies(pd.cut(df['Age'],5))

x = pd.get_dummies(df[feat], prefix=feat)

df = pd.concat([df, x], axis=1)

#df[feat] = pd.get_dummies(df[feat], prefix=feat)

df.head()# 从纯文本Name特征里提取出Titles的特征(所谓的Titles就是Mr,Miss,Mrs等)

df['Title'] = df.Name.str.extract('([A-Za-z]+)\.', expand=False)

df.head()二、数据重构

2.1 数据的合并

# 将data文件夹里面的所有数据都载入,与之前的原始数据相比,观察他们的之间的关系

text_left_up = pd.read_csv("data/train-left-up.csv")

text_left_down = pd.read_csv("data/train-left-down.csv")

text_right_up = pd.read_csv("data/train-right-up.csv")

text_right_down = pd.read_csv("data/train-right-down.csv")

# 使用concat方法:将数据train-left-up.csv和train-right-up.csv横向合并为一张表,并保存这张表为result_up

list_up = [text_left_up,text_right_up]

result_up = pd.concat(list_up,axis=1)

result_up.head()# 使用DataFrame自带的方法join方法和append完成表格的横纵合并

resul_up = text_left_up.join(text_right_up)

result_down = text_left_down.join(text_right_down)

result = result_up.append(result_down)

result.head()

# 使用Panads的merge方法和DataFrame的append方法完成表格的横纵合并

result_up = pd.merge(text_left_up,text_right_up,left_index=True,right_index=True)

result_down = pd.merge(text_left_down,text_right_down,left_index=True,right_index=True)

result = resul_up.append(result_down)

result.head()2.2 将我们的数据变为Series类型的数据

# 将完整的数据加载出来

text = pd.read_csv('result.csv')

text.head()

# 代码写在这里

unit_result=text.stack().head(20) # stack()将列旋转到行

unit_result.head()

2.3 数据运用

GroupBy机制

# 计算男性女性的平均票价

df = text['Fare'].groupby(text['Sex'])

means = df.mean()Sex female 44.479818 male 25.523893 Name: Fare, dtype: float64

# 多个列同时分析时,可以通过agg()函数来计算,并且可以使用rename函数修改列名。

# 例子:计算男性与女性的平均票价和男女的存活人数

text.groupby('Sex').agg({'Fare': 'mean', 'Pclass': 'count'}).rename(columns=

{'Fare': 'mean_fare', 'Pclass': 'count_pclass'})三、数据可视化

# 可视化展示泰坦尼克号数据集中男女中生存人数分布情况

sex = text.groupby('Sex')['Survived'].sum()

sex.plot.bar()

plt.title('survived_count')

plt.show()

# 可视化展示泰坦尼克号数据集中不同年龄的人生存与死亡人数分布情况。

facet = sns.FacetGrid(text, hue="Survived",aspect=3)

facet.map(sns.kdeplot,'Age',shade= True)

facet.set(xlim=(0, text['Age'].max()))

facet.add_legend()

# 可视化展示泰坦尼克号数据集中不同仓位等级的人年龄分布情况。

text.Age[text.Pclass == 1].plot(kind='kde')

text.Age[text.Pclass == 2].plot(kind='kde')

text.Age[text.Pclass == 3].plot(kind='kde')

plt.xlabel("age")

plt.legend((1,2,3),loc="best")

520

520

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?