论文地址: https://arxiv.org/abs/2310.06625

代码: GitHub - thuml/iTransformer: Official implementation for "iTransformer: Inverted Transformers Are Effective for Time Series Forecasting" (ICLR 2024 Spotlight), https://openreview.net/forum?id=JePfAI8fah

摘要

最近线性预测模型的繁荣对基于 Transformer 的预测器的架构修改的持续热情提出了质疑。这些预测器利用 Transformer 对时间序列的时间标记的全局依赖性进行建模,每个标记由同一时间戳的多个变量形成。然而,由于性能下降和计算爆炸,Transformers 在预测具有较大回溯窗口的序列时面临挑战。此外,每个时间标记的嵌入融合了表示潜在延迟事件和不同物理测量的多个变量,这可能无法学习以变量为中心的表示并导致无意义的注意力图。在这项工作中,我们反思了 Transformer 组件的职责,并在不对基本组件进行任何修改的情况下重新调整了 Transformer 架构的用途。我们提出 iTransformer,它简单地将注意力和前馈网络应用于反转维度。具体来说,各个系列的时间点被嵌入到变量标记中,注意力机制利用变量标记来捕获多元相关性;同时,前馈网络应用于每个变量标记来学习非线性表示。 iTransformer 模型在具有挑战性的现实世界数据集上达到了最先进的水平,这进一步增强了 Transformer 系列的性能、跨不同变量的泛化能力,以及更好地利用任意回溯窗口,使其成为基础模型的一个不错的替代方案。时间序列预测的支柱。代码可在此存储库中找到:https://github.com/thuml/iTransformer。

1 简介

Transformer (Vaswani et al, 2017) 在自然语言处理 (Brown et al, 2020) 和计算机视觉 (Dosovitskiy et al, 2021) 方面取得了巨大成功,成长为遵循缩放定律的基础模型 (Kaplan et al, 2020) )。受广泛领域巨大成功的启发,具有描述成对依赖关系和提取序列中多级表示的强大能力的 Transformer 在时间序列预测中正在兴起(Wu et al, 2021;Nie et al, 2023)。然而,研究人员最近开始质疑基于 Transformer 的预测器的有效性,这些预测器通常将同一时间戳的多个变量嵌入到不可区分的通道中,并关注这些时间标记以捕获时间依赖性。考虑到时间点之间的数字但语义关系较少,研究人员发现简单的线性层(可以追溯到统计预测器(Box & Jenkins,1968))在性能和效率上都超过了复杂的 Transformer(Zeng 等人,2023;达斯等人,2023)。同时,保证变量的独立性,利用相互的最近的研究更加强调了信息的重要性,这些研究明确地模拟多元相关性以实现准确的预测(Zhang & Yan,2023;Ekambaram 等人,2023),但如果不颠覆普通的 Transformer 架构,这一目标就很难实现。

图 1:iTransformer 的性能。平均结果 (MSE) 按照 TimesNet (2023) 报告。

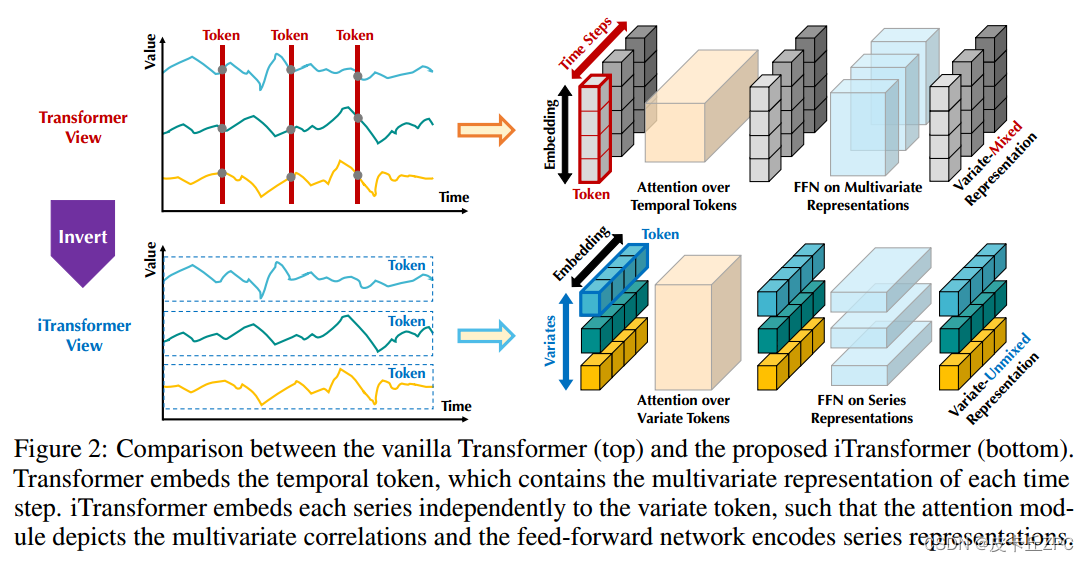

考虑到基于 Transformer 的预测器的争议,我们反思为什么 Transformer 在时间序列预测方面表现比线性模型更差,而在许多其他领域却占据主导地位。我们注意到基于 Transformer 的预测器的现有结构可能不适合多元时间序列预测。如图 2 顶部所示,值得注意的是,同一时间步长的点基本上代表了由不一致的测量记录的完全不同的物理含义,这些点被嵌入到一个具有消除多元相关性的标记中。由于过度局部的感受野和由同时时间点表示的时间未对齐事件,由单个时间步形成的令牌可能难以揭示有益的信息。此外,虽然序列变化会受到序列顺序的很大影响,但在时间维度上不正确地采用了排列不变注意机制(Zeng et al, 2023)。因此,Transformer 捕获基本序列表示和描绘多元相关性的能力被削弱,限制了其对不同时间序列数据的容量和泛化能力。

图 2:普通 Transformer(上)和建议的 iTransformer(下)之间的比较。Transformer 嵌入了时间标记,其中包含每个时间步的多元表示。 iTransformer 将每个系列独立地嵌入到变量标记中,以便注意力模块描述多元相关性,前馈网络对系列表示进行编码。

考虑到将时间戳的多元点嵌入为(时间)标记的潜在风险,我们对时间序列采取倒置的观点,并将每个变量的整个时间序列独立地嵌入到(变量)标记中,这是修补的极端情况(Nie et al, 2023)扩大了局部感受野。通过反转,嵌入的令牌聚合了系列的全局表示,这些表示可以更加以变量为中心,并通过蓬勃发展的多变量关联注意力机制更好地利用。同时,前馈网络可以足够熟练地学习从任意回溯序列编码并解码以预测未来序列的不同变量的通用表示。基于以上动机,我们认为并不是Transformer对于时间序列预测无效,而是它使用不当。在本文中,我们重新审视 Transformer 的结构,并提倡 iTransformer 作为时间序列预测的基本支柱。从技术上讲,我们将每个时间序列嵌入为变量标记,采用多变量相关性的注意力,并采用前馈网络进行序列表示。通过实验,所提出的 iTransformer 在图 1 所示的现实世界预测基准上实现了最先进的性能,并且令人惊讶地解决了基于 Transformer 的预测器的痛点。我们的贡献在于三个方面:

• 我们对Transformer 的架构进行了反思,并完善了原生Transformer 组件在多元时间序列上的能力尚未得到充分探索。

• 我们提出iTransformer,将独立时间序列视为令牌,通过自注意力捕获多元相关性,并利用层归一化和前馈网络模块来学习更好的序列全局表示以进行时间序列预测。

• 通过实验,iTransformer 在实际基准测试中达到了最先进的水平。我们广泛分析了倒置模块和架构选择,为基于 Transformer 的预测器的未来改进指明了一个有希望的方向。

2 相关工作

随着自然语言处理和计算机视觉领域取得的逐步突破,精心设计的 Transformer 变体被提出来解决普遍存在的时间序列预测应用。超越同期 TCN(Bai 等,2018;Liu 等,2022a)和基于 RNN 的预测器(Zhao 等,2017;Rangapuram 等,2018;Salinas 等,2020),Transformer 展示了强大的序列建模能力和有前景的模型可扩展性,导致了针对时间序列预测的热情修改的趋势。

通过对基于 Transformer 的预测器的系统回顾,我们得出结论,现有的修改可以根据是否修改组件和架构分为四类。

如图3所示,第一类(Wu et al, 2021; Li et al, 2021; Zhou et al, 2022)是最常见的做法,主

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1390

1390

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?