Seeing Beyond the Brain: Conditional Diffusion Model with Sparse Masked Modeling for Vision Decoding

摘要

-

研究目标:旨在通过脑-计算机接口从fMRI记录中解码视觉刺激,以加深对人类视觉系统的理解,并为人类与计算机视觉的桥梁奠定基础。

-

挑战:从脑记录中重建具有正确语义的高质量图像是一项具有挑战性的任务,原因在于脑信号的复杂性和数据标注的稀缺性。

-

提出的方法:提出了MinD-Vis方法,即采用稀疏掩码脑建模的双重条件潜在扩散模型(SC-MBM和DC-LDM)来实现人类视觉解码。

- 使用稀疏编码和掩码建模的自监督学习来学习fMRI数据的有效表示。

- 通过双重条件增强潜在扩散模型的生成能力,以在少量配对标注下生成语义匹配的图像。

-

实验结果:在语义映射(100类别语义分类)和生成质量(FID指标)上,MinD-Vis分别优于当前最优方法66%和41%。

-

消融实验:进行了详细的消融研究,以分析该框架的不同组成部分对最终结果的影响。

1 介绍

xxxxxx 省略

基于上述分析,我们提出了MinD-Vis:一种用于人类视觉解码的稀疏掩码脑建模和双重条件潜在扩散模型框架,该框架利用了大规模表示学习的强大功能,并模拟了大脑中的稀疏编码(包括视觉皮层的信息编码)。不同于文献[18],我们使用了更大的表示空间与数据空间的比例,以增强所学表示的信息容量。我们的贡献如下:

- 我们提出了稀疏编码掩码脑建模(SC-MBM),在生物学指导下设计,作为一种有效的视觉解码脑特征学习方法。

- 通过双重条件(DC-LDM)增强潜在扩散模型,我们在保持语义一致性的同时允许生成的多样性。

- 将SC-MBM的表示能力与DC-LDM的生成能力相结合,MinD-Vis生成的图像更为逼真,并且保留了更好的语义信息,与之前的方法相比效果更佳。

- 在多个数据集上进行了定量和定性测试,其中包括一个以前未用于该任务的新数据集。

2 相关工作

传统解码方法

传统方法依赖于使用fMRI数据和预训练的VGG模型提取的分层图像特征进行训练【21, 46】。在测试过程中,预测的图像特征会被用于分类,或输入到生成模型(如GAN【45】)中以重建原始的视觉刺激。与直接学习有限的训练对不同,文献【2】提出了一种重新配置自编码器的设计,使得可以在无配对的fMRI和图像上进行无监督学习。文献【16】进一步将该方法扩展到来自不同语义类别的图像。然而,与传统方法一样,fMRI仍然直接用于训练和解码。在文献【31, 33】中,使用回归模型提取fMRI的潜在表示,然后利用该表示对预训练的条件bigGAN进行微调以实现图像解码。Mind Reader【27】将fMRI信号编码到一个预对齐的视觉-语言潜在空间中,并使用StyleGAN2生成图像。这些方法能够生成更为逼真且具有语义意义的图像。

值得注意的是,Takagi和Nishimoto【13】提出了一项与我们平行的工作,他们提出了一种使用Stable Diffusion从fMRI重建图像的方法。该方法通过将脑活动解码为文本描述,然后利用Stable Diffusion将其转化为自然图像。

掩蔽信号建模(Mask signal modeling)

MSM在从大规模数据集中学习表示方面的强大功能首次被文献【8】利用,随后被应用到计算机视觉中【18, 60, 62】。在下游任务中的成功应用表明,通过将MSM作为预训练任务,模型学到了有用的上下文知识。本质上,MSM是一种广义的去噪自编码器,旨在从剩余的数据中恢复被掩盖的原始数据【4】。对于不同的数据模式,掩码的比例是不同的。例如,对于视觉信号,通常使用极高的掩码比例(75%)【18】。相较之下,由于信息密度的差异,自然语言通常使用较低的掩码比例(25%)【8】。

扩散概率模型

扩散模型【49】是一种新兴的生成模型,能够生成高质量的内容。在其基本形式中【20】,扩散模型是由状态的双向马尔可夫链定义的概率模型。该链中有两个过程:

- 前向扩散过程:逐渐向数据中添加噪声,直到数据完全被破坏成各向同性的高斯噪声。

- 反向过程:通过在每个状态下建模后验分布 ( p(x) ),逐步恢复被破坏的数据,最终获得符合原始数据分布的样本【20, 49, 50】。

形式化地,假设一个固定长度为 ( T ) 的马尔可夫链,那么反向条件概率可以表示为

q

(

x

t

−

1

∣

x

t

)

q(x_{t-1}|x_t)

q(xt−1∣xt),其中

t

=

1

,

…

,

T

t = 1, \ldots, T

t=1,…,T,并且

x

t

x_t

xt 是通过向

x

t

−

1

x_{t-1}

xt−1 添加高斯噪声得到的。

经过参数化后,可以通过优化变分下界来学习该条件概率,该下界简化为以下目标函数【20】:

L

t

simple

=

E

x

,

ϵ

∼

N

(

0

,

1

)

,

t

∥

ϵ

−

ϵ

θ

(

x

t

,

t

)

∥

2

2

L^{\text{simple}}_t = \mathbb{E}_{x, \epsilon \sim \mathcal{N}(0,1), t} \| \epsilon - \epsilon_\theta (x_t, t) \|^2_2

Ltsimple=Ex,ϵ∼N(0,1),t∥ϵ−ϵθ(xt,t)∥22

其中

ϵ

θ

(

x

t

,

t

)

\epsilon_\theta(x_t, t)

ϵθ(xt,t) 是一组去噪函数,通常通过UNet实现【9, 41, 42】。详细的扩散模型描述可参考文献【20】。

潜在扩散模型(LDM)

与在原始数据空间中生成样本的传统扩散模型不同,另一类在潜在特征空间中生成样本的扩散模型被提出【41, 48】。[优势]在潜在特征空间中操作减少了计算成本,并引入较少的空间下采样,从而提供更好的图像合成质量。

文献【41】中提出的LDM由两个组件组成:

- 向量量化(VQ)正则化的自编码器【12】:该自编码器将图像压缩为低维潜在特征,然后从同一空间中的特征重建图像。

- 基于UNet的去噪模型,带有注意力模块:将注意力机制集成到UNet中,允许在马尔可夫链转换过程中通过键/值/查询向量灵活地对图像生成进行条件控制。

【41】Robin Rombach, Andreas Blattmann, Dominik Lorenz, Patrick Esser, and Bjorn Ommer. High-resolution image synthesis with ¨latent diffusion models. In Proc. CVPR’22, pages 10684–10695, 2022.

【12】Patrick Esser, Robin Rombach, and Bjorn Ommer. Taming transformers for high-resolution image synthesis. In Proc.CVPR’21, pages 12873–12883, 2021

3 方法

3.1. 动机和概述

在本小节中,对fMRI数据进行了详细分析,并阐述了我们设计的动机。

- fMRI的测量:fMRI通过3D体素来测量大脑的血氧水平依赖(BOLD)变化,这些体素是反映大脑活动变化的代理。相邻体素通常具有相似的幅度,这表明fMRI存在空间冗余【53】。

- 时间平均:fMRI数据在刺激呈现的时间内取平均值。通常会提取平均数据的感兴趣区域(ROI),并将其作为1D体素向量(在视觉处理层次结构中)使用。ROI的大小(体素数)通常小于图像的像素数量。例如,文献【21】中视觉皮层的体素约为4500个,远小于256×256的RGB图像。这在将fMRI转换为图像时会产生维度上的巨大差异。

- 域的差异:不同数据集的fMRI数据可能由于实验条件和扫描仪设置的不同而具有显著的域偏移。即使在相同的扫描条件下,由于个体差异,ROI的大小和位置也会存在不匹配(见图2)。

图 2. 对视觉刺激做出反应的区域的个体差异。在同一视觉任务期间激活的感兴趣区域的掩模在不同受试者的位置和大小上有所不同。显示了左半球(红色)和右半球(橙色)的初级视觉皮层。

基于这一分析,我们提出了MinD-Vis,设计为两个顺序阶段,如图3所示。简要来说,在阶段A中,通过在一个大型fMRI数据集上训练的自编码器,使用掩码信号建模作为预训练任务来学习fMRI表示。学到的表示将作为条件,用于下一阶段的图像生成过程。在阶段B中,预训练的fMRI编码器通过跨注意力和时间步条件与LDM整合,以实现条件生成。在该阶段,编码器与LDM中的跨注意力头通过配对标注共同进行微调。

图3. MinD-Vis.

阶段A(左):使用SC-MBM在fMRI上进行预训练。对fMRI进行分块处理,随机遮盖部分数据,然后将其转化为大型嵌入。训练一个自编码器 E_{MBM} 和 D_{MBM} 来恢复被遮盖的分块。

阶段B(右):通过双重条件将LDM与fMRI嵌入整合。通过两个路径将fMRI潜在表示 L_{fMRI} 投射到LDM的条件空间,其中一个路径直接连接到LDM的跨注意力头,另一个路径将fMRI潜在表示添加到时间嵌入中。LDM在一个低维、压缩版的原始图像(即图像潜在空间)上运行,但这里为了演示使用了原始图像。

3.2. 阶段A : 稀疏编码 MBM (SC-MBM)

这段描述强调了通过稀疏编码和掩码建模来提高模型在fMRI数据表示上的效率,以及如何通过设计一个高效的非对称架构减少计算成本。

-

大脑活动的复杂性:人脑中有大约860亿个神经元细胞,它们之间存在非线性相互作用,使得大脑活动非常复杂【32, 40】。fMRI测量的是BOLD(血氧水平依赖)信号,这是一种间接的、汇总的神经活动指标。fMRI数据可以通过功能网络进行分层分析,这些网络包含了对外部刺激反应的功能性关联的体素【1, 6, 59】。

-

隐含的体素关联:fMRI数据中的功能网络由多个体素组成,这些体素之间对外部刺激的响应存在隐含关联【54, 68】。通过恢复被掩盖的体素,可以让预训练模型学习到fMRI数据的深层上下文关系,从而获得对数据更深入的理解。

-

分块与嵌入:该方法将体素向量分成小块(patches),并通过1D卷积层将其转换为嵌入,卷积步幅与patch大小相同【18】。fMRI的BOLD信号受血流动力学响应和空间平滑函数影响,这些因素会导致数据模糊化,产生空间冗余,与自然图像相似【11, 47】。这种冗余性允许即使在掩盖大量数据的情况下,仍然能够有效恢复fMRI信息(见图4)。

-

掩码建模的计算节省:在MinD-Vis的第一阶段,掩盖大量fMRI小块能够减少计算量,同时由于空间冗余性,不会削弱掩码建模的学习能力。

-

大嵌入比率的设计:在传统的掩码图像建模(MIM)中,嵌入与patch大小的比率通常接近1【18】,使得表示空间与原始数据大小相近。然而,MinD-Vis使用了更大的嵌入-to-patch比率,这显著提高了信息容量,为fMRI表示创建了一个更大的空间。这种设计也与大脑中的稀疏编码策略有关,即通过稀疏编码来表征感觉信息【25】。

-

非对称架构:参考文献【18】,该方法采用了非对称架构:编码器专注于学习fMRI的有效表示,而解码器则尝试预测被掩盖的patch。由于解码器的任务较轻,因此它的规模较小,并在第一阶段预训练收敛后被丢弃,不再用于第二阶段。

视觉编码和类脑稀疏编码

在这一部分中,作者解释了为什么使用SC-MBM(稀疏编码掩码脑建模)来学习大脑中视觉刺激的表示是有生物学基础的,并从视觉编码机制的角度进行了说明。

-

视觉皮层的稀疏编码:理论和实证研究表明,视觉刺激在初级视觉皮层中是以稀疏的方式编码的【32, 38, 56】。大多数自然图像只激活视觉皮层中的一部分神经元。这种稀疏编码策略提高了信息传输效率,并在大脑中生成了最小的冗余【38】。

-

信息重建:由于这种编码方式,自然场景的视觉信息可以从在初级视觉皮层中收集的小部分数据重建出来,这些数据可以通过包括fMRI在内的不同成像方式采集【15, 64】。这种现象对于计算机视觉领域来说具有启发性,因为稀疏编码也可以作为计算机视觉中一种高效的视觉编码方式【25, 63】。

-

稀疏编码的定义:稀疏编码是一种编码策略,本质上使用过完备基底来表示数据,从而增加了数据的局部性,以生成更平滑的表示【57, 65】。在SC-MBM中,fMRI数据被划分为小块,以引入局部约束。然后,每个块被编码为一个维度远大于原始数据空间的高维向量,从而为fMRI表示创建了一个过完备空间(见附录)。

-

模拟大脑的视觉编码:通过模拟大脑的视觉编码方式,SC-MBM成为一种在生物学上有效且适用于fMRI解码的脑特征学习方法。

附录 图 D.6。蒙面大脑预测的例子。第一列:原始fMRI数据(视觉皮层)扁平化;第二列:掩蔽功能磁共振成像;第三列:从 SC-MBM 解码器恢复的数据。掩模比:0.75。还显示了原始功能磁共振成像和恢复后的功能磁共振成像之间的相关性。

3.3. 阶段B

在Stage A完成了大规模的上下文学习后,fMRI编码器将fMRI数据转化为具有局部约束的稀疏编码表示。为了从这种抽象表示中进一步解码视觉内容,并允许生成的多样性,我们将解码任务表述为一个条件合成问题,并通过预训练的LDM(潜在扩散模型)来实现。

LDM在图像的潜在空间中操作,用 E ( x ) \mathcal{E}(x) E(x)表示该空间,其中 x x x是像素空间中的图像, E ( ⋅ ) \mathcal{E}( \cdot ) E(⋅)是一个VQ编码器。在我们的设置中,我们省略 E ( x ) \mathcal{E}(x) E(x)而直接用 z z z表示LDM的潜在变量,以简化表述。具体来说,给定fMRI数据 z z z,我们旨在学习逆扩散过程的条件概率 q ( x t − 1 ∣ x t , z ) q(x_{t-1}|x_t, z) q(xt−1∣xt,z)。

如文献【41】所述,条件信息通过基于注意力的UNet中的cross-attention头实现。在cross-attention机制中,表示为:

CrossAttention

(

Q

,

K

,

V

)

=

softmax

(

Q

K

T

d

)

V

\text{CrossAttention}(Q, K, V) = \text{softmax}\left(\frac{QK^T}{\sqrt{d}}\right)V

CrossAttention(Q,K,V)=softmax(dQKT)V

其中,

Q

=

W

Q

(

i

)

φ

i

(

x

t

)

Q = W_Q^{(i)}\varphi_i(x_t)

Q=WQ(i)φi(xt),

K

=

W

K

(

i

)

τ

0

(

z

)

K = W_K^{(i)}\tau_0(z)

K=WK(i)τ0(z),

V

=

W

V

(

i

)

τ

0

(

z

)

V = W_V^{(i)}\tau_0(z)

V=WV(i)τ0(z)。

这里, τ 0 \tau_0 τ0是具有合适维度投影器的fMRI编码器, φ i ( x t ) \varphi_i(x_t) φi(xt)表示UNet的中间层值, W Q ( i ) , W K ( i ) , W V ( i ) W_Q^{(i)}, W_K^{(i)}, W_V^{(i)} WQ(i),WK(i),WV(i)是带有可学习参数的投影矩阵。

在生成模型的采样中,多样性和一致性是两个相互对立的目标。在大多数图像生成任务中,例如从标签到图像、从文本到图像的生成任务中,保持多样性通常是很重要的。然而,fMRI到图像的转换更依赖于生成一致性——即由脑信号解码的图像期望在语义上相似。因此,为了确保这种生成一致性,尤其是在概率扩散模型中,我们需要更强的条件机制。

为此,将cross-attention条件与另一种称为时间步条件的条件机制整合,以在任务中提供更强的指导。在时间步条件中,在UNet的中间层加入

σ

0

(

τ

0

(

z

)

)

\sigma_0(\tau_0(z))

σ0(τ0(z))来进行时间步嵌入,其中

σ

0

(

⋅

)

\sigma_0(\cdot)

σ0(⋅)是另一个合适的维度投影器。时间步嵌入用于将fMRI嵌入与UNet的不同层重新投影,使得

φ

i

(

x

t

)

=

φ

i

(

x

t

,

σ

0

(

τ

0

(

z

)

)

)

\varphi_i(x_t) = \varphi_i(x_t, \sigma_0(\tau_0(z)))

φi(xt)=φi(xt,σ0(τ0(z)))。

进一步重新表述优化目标方程(1),将其改为双重条件目标,如下所示:

L t cmd = E x t , ϵ ∼ N ( 0 , 1 ) , t [ ∥ ϵ − ϵ θ ( x t , t , τ ( z ) , σ ( z ) ) ∥ 2 2 ] L_{t}^{\text{cmd}} = \mathbb{E}_{x_t, \epsilon \sim \mathcal{N}(0,1), t} \left[\left\| \epsilon - \epsilon_\theta(x_t, t, \tau(z), \sigma(z)) \right\|_2^2\right] Ltcmd=Ext,ϵ∼N(0,1),t[∥ϵ−ϵθ(xt,t,τ(z),σ(z))∥22]

省略了参数符号 τ \tau τ和 σ \sigma σ的下标“0”以简化符号表示。此外, φ ( x t ) ∈ R M × d x \varphi(x_t) \in \mathbb{R}^{M \times d_x} φ(xt)∈RM×dx和 σ ( z ) ∈ R 1 × d z \sigma(z) \in \mathbb{R}^{1 \times d_z} σ(z)∈R1×dz,其中 d x d_x dx和 d z d_z dz分别是图像特征和嵌入维度,而(M)是一个可调参数。

微调

在fMRI编码器通过SC-MBM进行预训练后,它与预训练的LDM通过双重条件整合在一起。通常,编码器的输出会被取平均,或者附加一个分类(cls)token,以生成用于下游任务的固定长度的1D特征向量【8, 18】。这种策略在预测和分类等任务中效果很好,因为在这些任务中,模型提取的知识通常是被浓缩和可区分的特征。

然而,将fMRI表示简化为1D向量并不适合保留fMRI表示的稀疏性和信息容量。因此,我们使用卷积层将编码器的输出汇集到具有较大潜在维度的 R M × d z \mathbb{R}^{M \times d_z} RM×dz空间中(见公式(2))。

在微调阶段,fMRI编码器、cross-attention头和投影头是共同优化的,而其他部分保持固定。微调cross-attention头对于在预训练的条件空间和fMRI潜在空间之间建立桥梁至关重要。微调是端到端地进行的,使用fMRI-图像对数据,在此过程中,fMRI和图像特征之间的更清晰的关联将通过大容量的fMRI表示学习到。

4 实验

4.1 数据集和实现

数据集

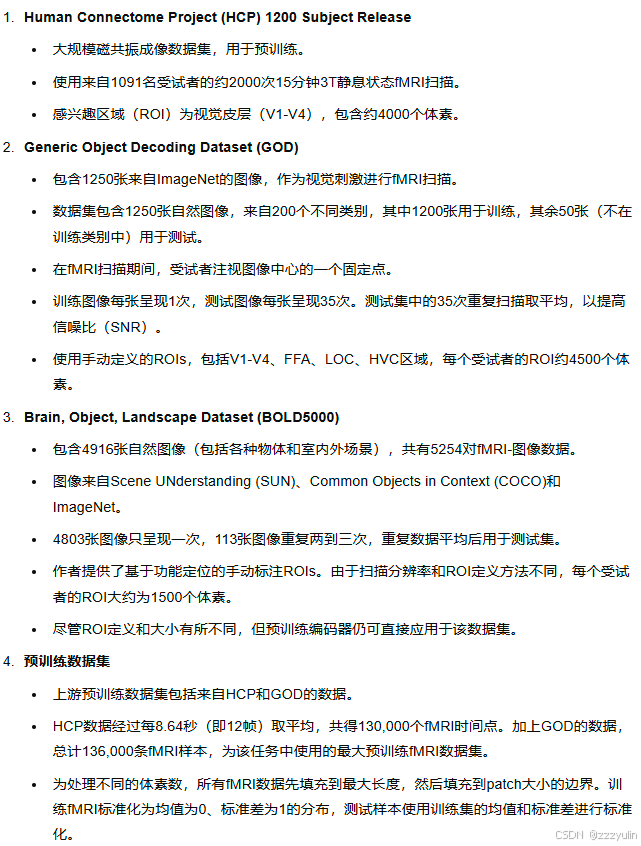

本研究使用了三个公共数据集:

- Human Connectome Project (HCP) 1200 Subject Release [55]

- Generic Object Decoding Dataset (GOD) [21]

- Brain, Object, Landscape Dataset (BOLD5000) [5]

我们的上游预训练数据集包含来自HCP和GOD的数据。结合这两个数据集,我们获得了来自340小时fMRI扫描的136,000个fMRI片段,这是迄今为止用于fMRI-图像解码任务的最大fMRI预训练数据集。

HCP数据集在神经科学研究中常用,包含的仅是fMRI数据。而GOD是一个为fMRI解码设计的fMRI-图像配对数据集。在我们的主要分析中,GOD数据集中的配对数据用于微调。GOD包含1250张不同的图像,来自200个不同的类别,其中1200张用于训练集,其余50张用于测试集。训练集和测试集的类别没有重叠。

在我们的研究中,BOLD5000数据集被用作验证数据集。它包含4916张不同图像的5254对fMRI-图像配对数据,其中113张图像用于测试。这是BOLD5000数据集首次被用于fMRI解码任务。

附录B 数据集和fMRI的预处理细节

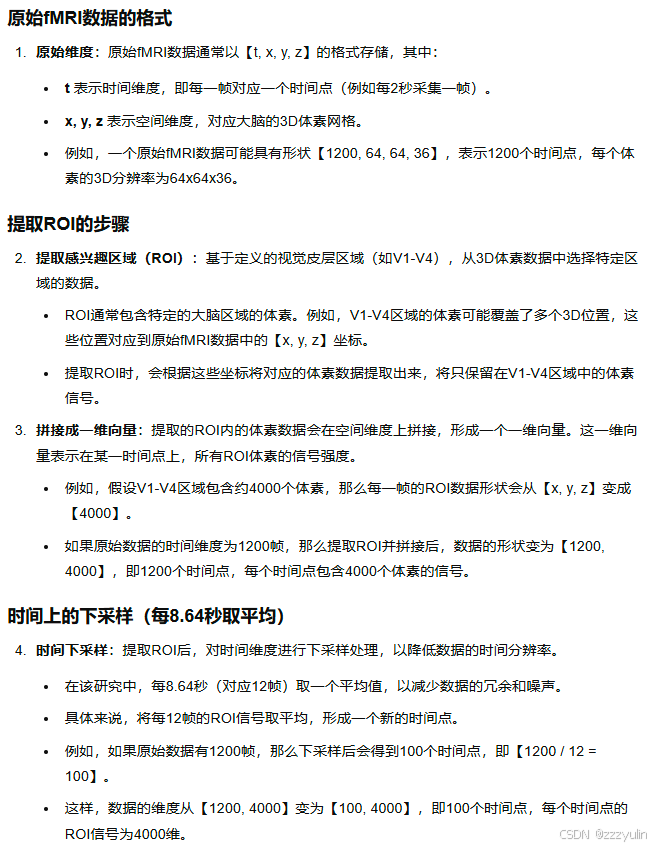

如何处理原始fMRI(我的理解):

实现

fMRI预训练模型类似于ViT-Large [10],并使用1D patch嵌入。我们使用了16的patch大小、1024的嵌入维度、24的编码器深度以及0.75的掩码比率,作为我们的Full模型设置,配合ImageNet类别条件预训练的LDM。不同的参数选择在消融研究中进行了探索。除非另有说明,Full模型预训练500个epoch,微调另500个epoch。报告了最佳模型的结果。图像以256 × 256的分辨率生成,使用250步的PLMS [29]。数据集和实现细节见附录。

4.2.评估指标

N路分类准确率 根据文献【16】,我们使用n路top-1和top-5分类任务来评估生成结果的语义正确性。在多次试验中,top-1和top-5的准确率是在n-1个随机选择的类别加上正确类别中计算的。请注意,我们不考虑像素级的度量,因为我们旨在恢复语义上正确的图像。

在【16】中,作者为每个类别生成了一个典型特征,并计算重建图像与典型特征之间的距离。然而,这个度量在【16】中很难再现,并且语义分类结果很大程度上依赖于特征的计算方式。因此,我们提出了一种更直接和更具可重复性的方法,即使用预训练的ImageNet1K分类器【10, 35】来确定生成图像的语义正确性,而不是手工生成的特征。我们在算法D.1中描述了这种评估方法。具体来说,将真实图像和生成图像输入分类器,然后检查生成图像在选定类别中的top-k分类是否与真实图像的分类相匹配。该度量不要求真实图像必须属于ImageNet1K的类别。只要真实图像和生成图像的语义分类结果一致,就认为是正确的。

弗里歇特嵌入距离(FID) FID【19】是一种常用的度量,用于评估图像生成的质量。在我们的实验中,我们测量了测试集中真实图像和生成图像之间的FID值。请注意,由于GOD中图像数量有限,FID仅作为参考指标,这可能导致低估偏差。

5 结果

我们的主要结果基于GOD数据集,该数据集的训练集和测试集类别没有重叠。训练和测试在同一受试者上进行,因为个体差异在群体水平的解码中仍然是一个障碍【2, 16, 21, 31, 33】。为了与文献进行比较,我们在此报告了受试者3的结果,其他受试者的结果在附录中提供。我们将结果与Ozcelik等人【33】、Gaziv等人【16】和Beliy等人【16】的研究进行了比较。Gaziv等人和Beliy等人使用了传统方法,这些方法生成的图像具有更高的像素相似度,但在合理性和语义细节方面较少。另一方面,Ozcelik等人使用预训练的GAN生成了更合理且语义上更有意义的图像。

基于这些方法的最佳重建样本(调整到256×256大小),我们进行了如算法D.1所述的1000次试验的n分类top-k准确率识别任务。实验在GOD测试集中分别针对n=50,100和k=1,5进行重复。根据图6,我们在50分类的top-1准确率任务中比Ozcelik等人高出39%,在100分类的top-1准确率任务中高出66%,分别达到了0.274和0.212的成功率。

从图5可以观察到,Gaziv等人和Beliy等人生成的图像在像素层面上接近真实图像,但几乎不包含有意义的语义细节。例如,我们的方法生成了合理的细节,如第一张和第二张图像中的水和波浪、保龄球上的图案、马车的车轮等,而这些细节在之前的解码图像中并不存在。图像质量也在FID指标中得到反映,我们在最佳样本中达到了1.67,而Ozcelik等人和其他方法的最佳样本则为2.36或更高。有趣的是,在某些情况下观察到颜色不匹配,尽管颜色差异被很好地保留。这可以用【3】中的观点解释,即颜色类别信息作为认知过程在额叶中处理,而视觉皮层仅识别颜色差异。

5.1 生成一致性

通过对相同的fMRI数据进行多次解码并使用不同的随机状态,我们测试了方法的一致性。对每个fMRI数据在测试集中进行了五次不同随机状态的采样。在50分类和100分类的top-1准确率识别任务中,我们在五次采样中的平均成功率分别为0.2385±0.030和0.1736±0.029,分别比Ozcelik等人方法的最佳采样结果高出21%和35%。

在图像质量方面,我们在五次采样中的平均FID为2.22±0.3。五次采样的标准差表明,生成的图像总是处于相同的语义类别。在图7中也可以看出,同构采样之间共享相似的细节,例如形状、颜色、纹理和语义,并且在多次实验中与真实图像相匹配。

5.2 SC-MBM设计

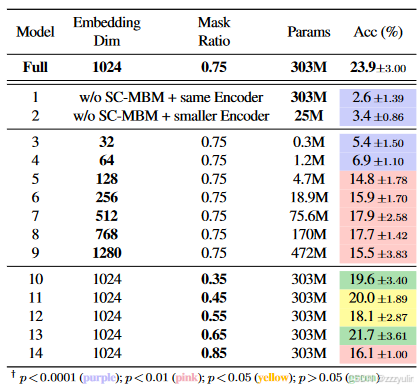

本节将讨论在SC-MBM预训练阶段对各种重要参数进行的消融研究。结果总结在表1中。在本节的所有实验中,使用最佳模型进行50分类、top-1准确率的语义识别任务,模型是在微调500个epoch后获得的。报告了五次采样的平均结果。

不使用SC-MBM的测试 为了证明SC-MBM学习到了有用的表示,我们直接使用fMRI-图像配对数据训练了两个不经过SC-MBM预训练的模型。

- 第一个模型包含一个未经训练的fMRI编码器,其架构与Full模型相同。

- 第二个模型包含一个深度只有2的未经训练的fMRI编码器。设计第二个模型的目的是减少参数量,从而降低其对数据过拟合的可能性。其他设置均相同。

结果对应于表1中的模型1和模型2,Full模型显著优于没有SC-MBM预训练的其他两个模型,表明预训练至关重要。事实上,没有SC-MBM预训练,这两个模型甚至无法生成合理的图像(见附录)。

Patch Embedding Dimension(补丁嵌入维度)

使用大补丁嵌入提升了fMRI表示的维度,这与大脑中视觉信息处理的稀疏编码机制相匹配。此外,较大的补丁嵌入维度增加了表示的信息容量。然而,较大的嵌入维度也意味着更多的训练参数,从而导致模型对数据的需求增加。为了平衡这一权衡,我们测试了不同补丁嵌入维度的SC-MBM模型,范围从32到1280(表1中的模型3-9)。我们发现,随着补丁嵌入维度的增加,准确率总体上升,并在1024维的补丁嵌入(即Full模型)时达到峰值,达到23.9%的准确率;此后,随着嵌入维度的进一步增加,准确率反而下降。

表 1. SC-MBM 消融结果。 Params:fMRI编码器中的可训练参数;单元格颜色反映了与完整模型相比准确度上的统计显着性差异(双样本 t 检验)。

Mask Ratios(掩码比例)

由于fMRI数据中存在较高的空间冗余性,在SC-MBM中使用了较高的掩码比例。在表1的模型10-14中,显示出高掩码比例在最初并不会影响解码性能,其中0.75的高掩码比例获得了最高的平均准确率。重要的是,使用高掩码比例显著减少了内存消耗,因为编码器只在未掩码的补丁上操作。这对fMRI来说尤为重要,因为SC-MBM由于较高的嵌入到补丁大小的比例而比MIM更占用内存。

5.3. DC-LDM微调设计

本节将讨论DC-LDM微调设计的消融研究,从三个方面进行分析:条件设定方法、优化设计和预训练的LDM选择。在所有消融实验中,使用的fMRI编码器与Full模型相同,仅在微调阶段改变重要参数。进行了1000次实验、50分类、top-1语义识别测试。结果汇总在表2中,每个条件下进行了五次不同采样的平均计算。

条件设定方法

我们在表2中展示了双重条件方法增强了条件设定的强度,仅使用cross-attention条件的识别准确率为15.6%(模型1),显著低于Full方法的准确率。

表 2. DC-LDM 消融结果。 1:仅交叉注意力条件; 2:仅优化fMRI编码器; 3:LDM在文本条件上预训练(LAION); 4:LDM 在布局条件 (OpenImages) 上进行预训练。缩写:C(交叉注意条件); T(时间条件); E(编码器); A(交叉注意力头)。单元格颜色反映了与完整模型相比准确度的统计显着性(双样本 t 检验)。

优化LDM

我们建议对fMRI编码器和cross-attention头进行联合微调,因为LDM在不同的条件空间中进行了预训练。例如,使用ImageNet类条件预训练的LDM时,cross-attention头被预训练为接收类别标签信息。为了验证这一选择,我们测试了一个仅微调fMRI编码器而不调整cross-attention头的模型。正如表2中的模型2所示,仅微调fMRI编码器的平均识别准确率降至13.7%,表明双重条件提供了更强的语义指导。生成图像的视觉质量及与真实图像的一致性也显著下降(见附录)。

预训练的LDM

预训练的LDM决定了模型的生成能力以及fMRI编码器需要适应的条件潜在空间。我们考虑了文献【41】中提供的三个预训练LDM,这些模型在不同的条件任务数据集上进行了训练,即ImageNet(标签条件)、LAION(文本条件)【44】和OpenImages(布局条件)【24】。正如表2中的模型3-4所示,在相同的解码任务中,使用ImageNet预训练的LDM(Full模型使用的LDM)表现最佳。值得注意的是,使用LAION和OpenImages预训练的模型生成的图像在视觉上不如ImageNet模型生成的合理(见附录)。这一结果令人惊讶,因为LAION和OpenImages都包含来自各种类别的多样化图像。我们将其表现不佳的主要原因归结于其条件潜在空间的复杂性。在训练对数量有限的情况下,与文本条件模型和布局条件模型相比,类条件的潜在空间更容易适应。

5.4.复制数据集

我们的方法在BOLD5000数据集上的验证

我们使用相同的预训练fMRI编码器在BOLD5000上验证了我们的方法。类似地,首先在BOLD5000的测试集中对预训练的编码器进行20个epoch的微调,并使用循环填充来补偿与预训练集不相等的ROI大小,之后使用BOLD5000中的fMRI-图像训练对进一步微调模型。其他设置与Full模型相同。对于BOLD5000数据集中的四位受试者,我们在1000次实验、50分类、top-1准确率的语义识别任务中达到了19%到34%的最佳准确率(见附录)。生成的图像在语义和低级特征上都与真实刺激图像相匹配(见图8)。我们的模型能够准确重建包含物体、动物、建筑和景观的图像。

图 8. 复制数据集 (BOLD5000)。它取得了与 GOD 数据集类似的定量结果。 50路top-1识别准确率:34%; FID:1.2(Subject 1)。

有趣的是,对于一些自然场景,我们还重建出了不在真实刺激图像中的额外细节。这些额外细节,例如图9中的河流和蓝天,可能反映了受试者在观看视觉刺激时想象中的景象,这些在他们的大脑活动中得以体现。如文献[21,46]所述,想象图像的特征也可以从视觉皮层中解码。据我们所知,这是第一次在BOLD5000数据集上进行fMRI解码。此外,将相同的预训练模型适配到该数据集上表明,SC-MBM预训练确实学习到了有用的大脑记录表示,即便存在明显的领域偏差。这些学习到的表示可以被共享,并且可以推广到具有不同扫描协议和预处理管道的数据集。

图 9. 解码的额外功能。图像相关的细节可以用我们的方法解码。例如河流和蓝天被自然风光刺激解码(顶排);当房子被展示时(底排),室内环境的类似室内装饰被解码。

6 讨论与总结

局限性

MinD-Vis 目前的形式缺乏强大的像素级指导和解释分析,这限制了其像素级性能(参见 G.5)以及对 MBM 学到的特征的生物学理解。

附录G 像素级指标

我们还执行了像素级指标(MSE 和 LPIPS)以进行额外评估(下表)。面向语义的方法、Ozelik [33] 和我们的方法在语义指标方面优于其他方法,但在像素级指标方面则不然。像素级和语义级解码从两个角度恢复视觉刺激,需要考虑保真度和意义之间的权衡。在这项工作中,我们优先考虑功能磁共振成像中视觉语义的恢复,这对于理解人类感知的复杂机制至关重要。

未来的工作

与之前的所有工作类似,MinD-Vis 专注于仅使用视觉皮层的个体解码。但作为一个复杂的认知过程,人类视觉可能会受到视觉皮层以外区域的影响。因此,未来的研究应该扩展到跨学科概括以及其他大脑区域的整合。此外,MinD-Vis的两阶段解耦设计使我们能够探索认知神经科学中新兴的大规模模型和表征学习技术的潜力,这也有待未来的研究。

结论

提出了一个两阶段框架 MinD-Vis,仅使用大脑记录中的几个配对的功能磁共振成像图像注释来解码视觉刺激。

- 在 A 阶段,我们采用带有掩模建模的 fMRI 预训练方案,从大规模未标记的 fMRI 数据集中学习可概括的上下文知识。

- 在 B 阶段,我们使用具有双重条件的潜在扩散模型,从学习的功能磁共振成像表征中生成可信的可见图像。

我们在多个数据集上验证了 MinD-Vis 的解码结果,并表明与以前的方法相比,我们的模型生成了更合理且语义相似的图像,将最先进的技术向前迈出了相当大的一步。

1966

1966

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?