目录

一、集成学习

1.定义

对于训练集数据,我们通过训练若干个个体学习器,通过一定的结合策略,就可以最终形成一个强学习器,以达到博采众长的目的。

也就是说,集成学习有两个主要的问题需要解决:第一是如何得到若干个个体学习器(即:如何产生个体学习器);第二是如何选择一种结合策略(即:如何结合个体学习器),将这些个体学习器集合成一个强学习器。

2.个个体学习器的选择

个体学习器的训练一般遵循两点:

①采用同质个体学习器(比异质更常见),使用最多的模型是CART和神经网络。

②采用弱学习器,一般准确率在55%~85%之间

(笔记byshj:因为集成学习的目的是提高准确率,强学习器的准确率已经很高了,再进行集成学习的话效果不显著)

3.算法的选择

由个体学习器间的依赖程度进行选择:若强依赖:boosting;若弱依赖:bagging或随机森林

4.集成学习的研究核心

集成学习的研究核心问题是:如何产生并结合“好而不同”的个体学习器。

①好:个体学习器性能好(虽然是弱学习器,但是性能需要尽可能的好,这样产生的集成学习器的性能也会很好)

②不同:个体学习器之间应该具有多样性

二、Bagging

1.定义

基于自助采样法(从n个样本中有放回的抽取n次)。

包括自助采样、学习器结合、包外估计三个步骤。

2.自助采样bootstrap sampling

(1)定义

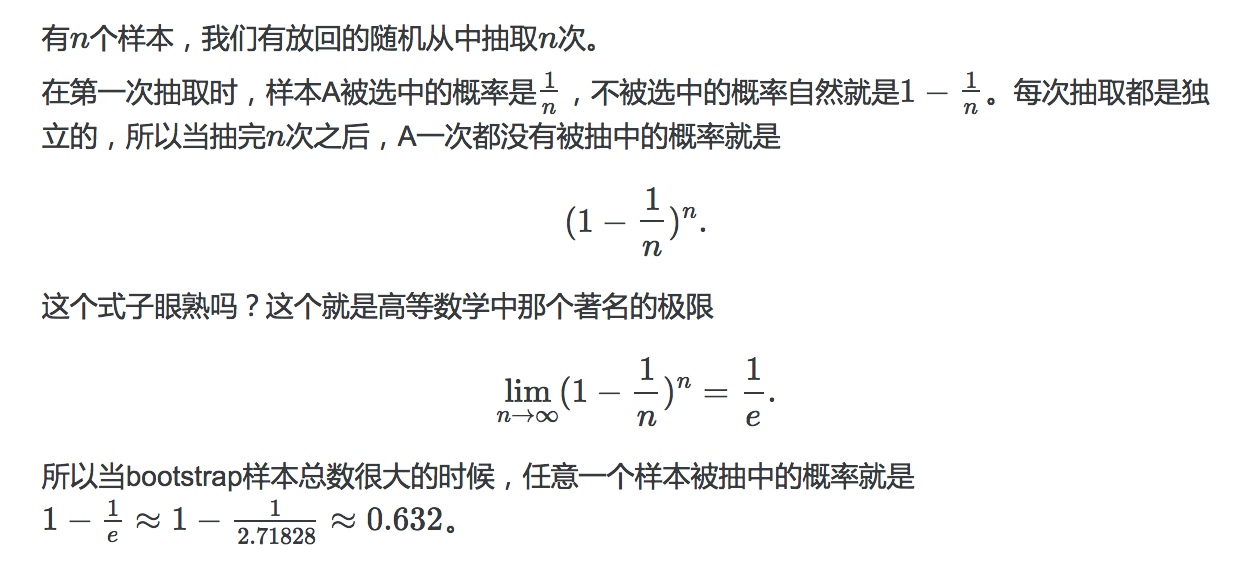

设原始训练集为D(其中有n个样本),采样后的训练集为D'。

从D中有放回的抽取n次,将抽取的样本复制到D',由此可以得到与原始训练集规模一致的新的训练集D'。

其中,任意一个样本一次都没有抽中的概率0.368。可见,可以将一次都没有抽中的样本组成测试集。用剩下(未抽中)的样本去测试学习器的这种方法,又被称为包外估计 out-of-bag estimate。

(2)对于集成学习的意义

因为集成学习中,有若干个个体学习器,但是数据集只有一个,不可能让所有个体学习器都学习相同的数据集,因为这样最终学习完后他们之间的差异就没有大,不利于集成学习。那怎么办呢?可以通过采样,将一个数据集变成若干个,且数据集中的样本大部分不重合。

那为什么选择自助采样呢?

通过一次自助采样,对于包含 m 个样本的原始数据集,我们可以得到包含 m 个样本的训练集,训练集与原始数据集大小一致。

①因为训练数据集规模与之前的一致,个体学习器不存在少学一些数据(少学的概率很小),即:可以进行充分的学习,得到更优的性能。

②多次自助采样后产生的多个训练集是不同的(尽管也有重叠的样本),因此从每个训练集中学习到的个体学习器之间有比较大的差异,我们可以把这种机制叫做样本扰动。

基于这两点,Bagging 集成的泛化性能是比较强的。

(3)补充

在集成学习中,如果希望个体学习器能够形成泛化性能较强的集成,那么一方面要求每个个体学习器自身的性能比较好,另一方面要求个体学习器之间尽可能具有较大的差异(笔记byshj:因为是同质学习器,学习器本身的性质已无法改变,只能改变训练集。若每一个学习器的训练集都一样,那学习器之间的差异可能就不大,可能会出现相似的学习器(因为其本身就是同质的了),所以尽量让每一个学习器都使用不同的训练集,来扩大差异)。

这也是之前所说的集成学习的研究核心内容——“好而不同”

3.学习器结合

(1)在分类任务中:采用简单投票法(也就是:少数服从多数)

若出现两个类票数相同,就随机二选一或者进一步考察基学习器投票的置信度来确定。

(2)在回归任务中:采用简单平均法(也就是:取平均值)

4.包外估计 out-of-bag estimate

(1)定义

通过自助采样得到的训练集,对其去重后得到的样本量约为原始数据集的 63.2% ,那么剩下约 36.8% 的样本正好可以用来作为验证集,评估模型的泛化误差,这种评估方法就叫做包外估计。

5.bagging复杂度

因为是并行产生个体学习器,所以使用bagging训练许多个体学习器和训练一个个体学习器的复杂度是相同的。

三、随机森林 Random forest

1.定义

是bagging的一种扩展变体。是基于bagging+个体学习器采用决策树+在训练个体学习器时引入了属性扰动。

即:

RF=bagging+决策树+属性扰动

2.属性扰动

在建立决策树时,在某个结点选择最优属性时。

假设此结点的属性集维数为d,则先随机选出一个子属性集(维数为k),再从此子属性集中随机选择出最优属性,再进行划分。

推荐k取值为 log2d(2为底数,不会打??)

3.效率

RF的效率一般都高于bagging,因为bagging需要遍历所有属性,而RF只需要遍历那一个子属性集即可。

四、补充知识

1.个体学习器

(1)定义

个体学习器是集成学习中,被结合的那些学习器。

(2)分类

按照个体学习器的种类是否相同分为:同质、异质

①同质个体学习器

所有的个体学习器都是一个种类的,此时又称为“基学习器”

比如都是决策树个体学习器,或者都是神经网络个体学习器

②异质个体学习器

不全是一个种类。 此时又称为“组件学习器”

比如我们有一个分类问题,对训练集采用支持向量机个体学习器,逻辑回归个体学习器和朴素贝叶斯个体学习器来学习,再通过某种结合策略来确定最终的分类强学习器。

2.强学习器、弱学习器

弱学习器:准确率比随机猜测高,但高不到多少

强学习器:准确率在90%以上

转载:

一个分类器的分类准确率在60%-80%,即:比随机预测略好,但准确率却不太高,我们可以称之为“弱分类器”,比如CART(classification and regression tree分类与回归树)。

反之,如果分类精度90%以上,则是强分类器。

西瓜书上说:

弱学习器常指泛化性能略优于随机猜测的学习器(例如在二分类问题上精度略高于50%的分类器)

————————————————

版权声明:本文为CSDN博主「hxxjxw」的原创文章,遵循CC 4.0 BY-SA版权协议,转载请附上原文出处链接及本声明。

原文链接:https://blog.csdn.net/hxxjxw/article/details/108269092

3.自助采样法

4.样本扰动

向模型中引入随机性的方法中的一种,除此之外,还有属性扰动,参数设置等其他方法。

其基于采样法。如自助采样法,序列采样法等,都是样本扰动的方法。

一般适用于不稳定学习器(unstable learner),如决策树,神经网络。这些学习器都容易受到数据集变动的影响,即:样本扰动。

5.属性扰动

适用于稳定学习器,如:svm,线性学习器等。

1086

1086

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?