【摘要】

训练域和目标域之间的分布变化可能会降低学习模型的预测精度,这主要是因为这些模型通常学习与输出仅具有相关性而非因果关系的特征。这种相关性在统计学上被称为“伪相关性”,是依赖于域的,因此可能无法推广到看不见的域。为了避免这种虚假的相关性,我们提出了潜在因果不变性模型(LaCIM ),它指定了数据的潜在因果结构和分布变化的来源,指导我们只追求因果因素进行预测。具体而言,LaCIM引入了一对相关的潜在因素:(a)因果因素和(b)其他因素,而这种相关性的程度由表征分布变化的域变量控制。在此基础上,我们证明了以潜在变量为条件的观测变量的分布是平移不变的。有了这样的不变性,我们证明了因果因子可以在不混合其他信息的情况下恢复,这就引出了地面真实预测机制。我们提出了一种基于变分贝叶斯的方法来学习这种预测不变性。我们的方法的实用性通过对各种真实世界数据上的分布变化的改进的推广得到了验证。我们的代码在https://github.com/wubotong/LaCIM.

1简介

当前数据驱动的深度学习模型虽然在各种任务中是具有革命性的,但通常利用各种类型的相关性来拟合数据,而在这些相关性中,可能存在与从所提供的数据中继承的偏差(例如,由于第三个看不见的因素的存在而导致的混杂偏差)相对应的虚假相关性。这种依赖于数据的虚假相关性可能会削弱对分布变化的未知领域的预测能力,这可能会导致严重的后果,特别是在医疗保健等安全关键任务中。

最近,机器学习中的因果关系有所复兴,预计将追求因果关系[59]以实现跨领域的稳定推广。所谓的“因果关系”领域是由结构因果模型[51]开创的,作为人类头脑中掌握的这一形而上学概念的数学表述。这些关于因果关系的人类先验的结合赋予了模型识别因果结构的能力[51],这不仅需要数据,还需要它们如何产生的潜在过程。为了实现因果建模,老派方法[52,10]直接将输出标签Y与协变量X的子集进行因果关联,然而,这在具有感官水平数据的应用中在概念上是不合理的(例如,作为输出的因果因素的模型像素在图像分类中没有意义[11])。

对于此类应用,我们更倾向于采用人类视觉感知的方式[8,9,80]将标签Y与S表示的未观察到的抽象进行因果关联,即Y ← S。我们进一步假设存在另一个(Y的)非因果潜在因子,表示为Z,它与S一起生成输入X: X ← (S,Z)。文献[25,27,35,75,71]中也采用了类似的假设。为了对跨域的移位进行建模,我们允许Z与S伪相关(因此也是输出),如图1 (a)中的双向箭头所示。以图像分类为例,S和Z分别指与对象相关的抽象(例如,轮廓、纹理)和上下文信息(例如,背景、视图)。由于这种相关性,模型可以将上下文信息学习到预测中,这可能无法推广到该领域,从而破坏了这种相关性。

图1:从(a)的骨架开始,引入潜因不变模型,即在(c)中用领域变量D增强了一组SCM。具体来说,从(a)到(b):S和Z之间的虚假相关是由一个未观察到的混杂因素C引起的,分布性转变是指P(C)和P(S, Z|C)在不同领域的变化;从(b)到(c):我们把这种转变归于领域变量D,作为分布性转变的来源。这里,观察到的和未观察到的变量分别用实心圆圈和虚心圆圈标记;定向箭头("→"或"←")代表直接因果关系;而双定向箭头("↔")代表可以跨域变化的假性相关;红色和蓝色分别代表不变的和变化的值/分布。

我们将上述假设封装到图1 (a)所示的框架中,其中S和Z之间的杂散相关性跨域变化,如图1 (b)中红色双向箭头所示。仔细观察,这种依赖于域的伪相关由图1 (c)中的辅助域变量D控制,这导致了域偏移。我们把用D扩充的因果模型集合称为潜在因果不变性模型(LaCIM)。这里,“因果不变性”指的是P(Y |S),在嵌入LaCIM的因果结构中的假设下,可以证明P(Y|S)与P(X | S,Z)一起对于跨域的移位是稳定的。配备了这样的不变性,我们证明了S和对于从(s*,z*)生成的x的ground truth预测:P(Y |s*),关于混合非因果信息的变换都是可识别的。(Equipped with such an invariance, we prove that the S and the ground-truth predictor: P(Y |s *) for x generated from (s * , z* ), are identifiable up to transformations that do not mix the non-causal information.)

在这种可识别性保证下,我们建议通过改造变分自动编码器(VAE) [37]来学习P(Y |S)和P(X|S,Z),以拟合来自训练域的输入和输出变量的联合分布。在测试阶段,我们首先通过优化潜在空间上的估计P(X|S,Z)来推断S的值,随后是用于预测的学习P(Y |S)。我们首先使用模拟数据来验证可识别性主张的正确性。然后,为了证明其实用性,我们在真实世界的数据上测试了我们的方法,始终实现了对新分布的更好的推广;此外,我们发现,我们推断的因果因素可以集中在高度解释的图像分类任务的语义区域。

我们总结我们的贡献如下:在方法上(在第二节。4.1),我们提出了LaCIM,其中包含了两个潜在因素的因果假设和分布转移;理论上(在定理4.4中),我们证明了因果因子和基础事实预测机制的可识别性;算法上(sec. 4.3)在可辨识性的指导下,改进变分贝叶斯方法学习P(X|S,Z),P(Y |S)进行预测;实验上(sec. 5.2),与其他方法相比,我们的方法更好地概括了分布变化。

2.相关工作

领域泛化的因果关系。由于其稳定的可转移性,因果关系的概念已被引入最近的许多工作中,用于领域概括[39, 59, 52, 10, 40, 21, 68]。这些工作中的大多数都学习了假定的(因果关系)不变性,用于泛化到未见过的领域。然而,它们的缺点是:i)缺乏明确的因果模型;或者ii)为输出的因果关系不恰当。具体来说,对于i),[39, 59]仍然是数据驱动的方法来学习稳定的相关性(即不变性),而没有纳入数据之外的因果假设[51],这可能会阻碍其推广到更广泛的领域;对于ii),[52, 10, 40, 21, 68]将输出与协变量进行因果关系,这对于感官层面的数据是不合适的。

我们的规范。我们明确地纳入了因果假设。具体来说,我们引入了i)隐变量,并将其分为因果和非因果因素;ii)领域变量D,作为一种选择机制,产生不同领域的S-Z相关性。这样的因果模型使得恢复因果因素S的泛化成为可能。在独立的、同时进行的工作中,[75]和[28]也探讨了因果关系中的潜变量。作为比较,[75]没有区分S和Z,[28]中的假性相关被限制在域和输出之间的相关性;而在我们的设置中,它被允许存在于单一的域中,这更符合真实的场景,例如,当大多数样本在晴朗的早晨收集时,狗与草而不是雪在一个域中更相关。

其他概念上的相关工作:i)转移学习,在领域适应[60,81,17]或领域泛化[43,63]的背景下利用不变性;(ii)因果推理[51,53],建立结构性因果模型,并为因果推理和反事实学习定义干预(又称 "do-操作");以及(iii)潜在生成模型,假设从潜在空间到观察数据的生成[37,71],但旨在无监督情况下的学习生成器。

3.Preliminaries

问题设置。让X、Y分别表示输入和输出变量。训练数据{D^e}_{e∈E_{train}}是从多个环境e∈E_{train}中收集的,其中每个e与X×Y上的分布P^e(X,Y)相关联,对任意k∈Z +。我们的目标是学习一个稳健的预测器f : X → Y,只利用因果因素进行预测,并对所有领域E⊃Etrain有良好的推广性。我们分别用大、小写字母和草书字母来表示随机变量、实例和空间,例如,a是随机变量A空间中的一个实例。

![]() 中的[f(x)]_{A}表示限制在A的维度上的f(x),即,[f(x)]_A := [f_i_1 (x), ..., f_i_k (x)]。Sobolev空间W^{k,p}(A)包含所有f,使得

中的[f(x)]_{A}表示限制在A的维度上的f(x),即,[f(x)]_A := [f_i_1 (x), ..., f_i_k (x)]。Sobolev空间W^{k,p}(A)包含所有f,使得

![]()

结构性因果模型。结构性因果模型(SCM)被定义为一个三联体M := <G, F, P(ε)>,其中i)因果结构G := (V, E)(V, E分别表示节点和边集)由一个有向无环图(DAG)描述;ii)结构方程F := {fk}_{V_k∈V}是自动的,也就是说,对V_k的干预不会影响其他的,在此基础上,我们可以定义do-算子并计算因果效应;iii)P(ε)是外生变量{ε_k}_k的概率度量。通过假设{ε_k}_k之间的独立性,我们根据因果马尔科夫条件得到,每个与G兼容的P都有P({V_k = v_k}_{V_k∈V} )=Π_kP(V_k = v_k|Pa(k) = pa(k))。无环有向混合图(ADMG)可以进一步允许双向箭头↔的存在,这意味着两个变量之间的虚假相关关系被连接。

4方法

我们首先在sec4.1.中将因果假设并入LaCIM。在这样的假设下,我们确定了不变分布P(X|S,Z)和P(Y |S ),它们分别被称为生成不变性和因果不变性,对域偏移是鲁棒的。有了这些不变量,在sec4.2中我们证明在预测过程中,无需混合来自非因果因素的信息,即可识别因果因素。最后,我们在sec4.3.介绍了我们的学习方法估计P(X|S,Z)和P(Y |S),它们分别在推理和预测中重新排序,构成测试阶段的稳健预测值。

4.1潜在因果不变性模型

在本节中,我们介绍一组被称为潜在因果不变性模型(LaCIM)的结构因果模型,其结合了上述因果假设以及分布偏移的来源。LaCIM的相应因果结构在图1 (c)中示出,我们将从图1 (a)中的骨架逐步引入。

图1 (a)。具体而言,图1 (a)中的ADMG引入了潜在因子V := {S,Z}来对生成观察变量(X,Y)的抽象/概念进行建模,这与在用于图像生成的无监督潜在生成模型[37]中的假设类似。进一步,我们将V显式地分离为S和Z,只有S与标签Y有因果关系,在图像分类中,这样的因果因子指的是需要分类的物体的(形状,轮廓);而图像X还受到诸如光线、视野等上下文因素的影响。

图1 (a) →图1 (b)。此外,我们假设s与z虚假相关,如图1 (a)中的红色“↔”所示。这种伪相关对应于从数据继承的偏差,例如图像分类中的上下文信息。因此,这种相关性的大小是分布相关的,因此可以在不同的域之间变化。从统计学上来说,“假相关”意味着存在第三个未观察到的(我们用圆点表示未观察到的变量)混杂因素,在图1 (b)中用C表示。由C引起的从Z到Y的畅通路径可以导致在数据拟合期间学习非因果因子,如果该非因果因子和输出之间的相关性被破坏,这可以降低在看不见的域上的性能。

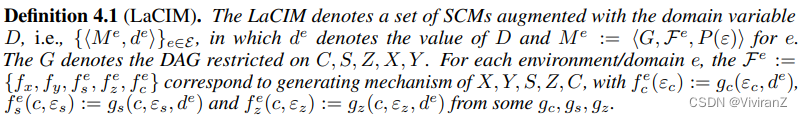

图1 (b) →图1 (c)。进一步观察图1 (b ),不同程度的相关性可能是由于S、Z|C的分布偏移或C本身跨域的偏移(我们使用红色表示不同的分布)。由于这两种移位都是域相关的,我们在图1 (c)中将其归因于域变量D,这导致其子节点分布的突变,即S、Z和c。这种域变量已在[69,68]中类似地引入,以生成可变变量。在我们的场景中,我们不需要观察D;相反,我们只需要域索引\u d e(长度为m的独热编码向量:= |Etrain|)。用D扩充的SCMs集,具有与图1 (c)中C,S,Z,X,Y的DAG兼容的SCM马尔可夫,被称为潜在因果不变性模型(LaCIM ),其形式定义如下:

Rmk1 与X生成[28]或Y生成[1]的情况不同,我们考虑X和Y同时生成的情况,这种情况广泛存在,但在文献中被忽略。例如,在医疗诊断期间,临床医生在实施超声测试的同时记录疾病状态。

作为说明,我们考虑下面的例子,其中由域变量D引起的分布偏移可以指数据中的采样偏差。

例4.1(采样偏差)。考虑一下猫/狗的分类,每张图片中的动物要么与雪联系在一起,要么与草联系在一起。D指的是采样器,它生成C,表示收集每个样本的时间和天气。S、Z分别指动物的特征和语境。由于每个采样器可能具有固定的采样模式(例如,习惯于在阳光明媚的早晨(或下雪的晚上)外出),所以一个人收集的数据可能具有采样偏差:在阳光明媚的早晨(或下雪的晚上),狗(猫)更多地与草(雪)相关联。

定义4.1指定了跨环境的生成机制以及它们之间的区别。有了这样的规范,我们就可以识别对域移位稳定的不变机制:

命题4.2(因果不变性&生成不变性)。对于定义4.1中的LaCIM。P(Y |S)和P(X|S,Z)对于E上的移位是不变的,并且分别被表示为因果不变性(CI)和生成不变性(GI)。

Rmk2。从潜变量到观察变量的生成过程遵循物理规律,例如,形状、轮廓、颜色、视图、光线应满足物理约束以生成合理的图像。因此,自然认为这种生成过程是不变的。

P(X|S,Z)和P(Y |S)可以诱导一种不变的预测机制。具体来说,对于一个新样本x ← fx(s*,z*,ε_x),y ← fy(s*,ε_y),我们可以先通过使p_{f_x} (x|s,z)在S × Z上的对数似然最大化推断出因果因素s*,然后将估计的S馈入p_{f_y} (y|s*)进行预测。为了确保这种两步不变预测的鲁棒性,我们需要回答以下两个可识别性问题:

1 .推断出的因果因素S不能混合(脱离)他人的信息吗?

2.这样一个不变预测器能恢复预测器P(Y |s)吗?

我们将在接下来的部分回答这些问题,然后是我们的学习方法,以确定因果因素和预测的因果/生成不变性。

4.2可识别性分析

我们给出了关于(i)推断的因果因素S与非因果因素Z的分离,以及(ii)由x ← fx(s*,z*,εx)诱导的真实预测机制P(Y |s*),分别呼应上一节提出的两个问题。

我们的主要结果在定理4.4中给出。为了区分因果因素S和其他因素,我们的结果要求跨环境的S-Z相关性的多样性程度足够大,这在可识别性文献[52,1]中也有类似的假设。这种多样性条件意味着Z和Y之间相关性的戏剧性变化,从而提供了解开s的线索。这种解开分析对因果预测至关重要,但在现有的关于可识别性的文献中被忽略,例如那些识别离散潜在混杂因素的文献[32,62],或那些依赖加性噪声模型(ANM)假设的文献[31],或线性独立成分分析(ICA) [14,35,36,75](有关更详尽的综述,请参考附录D.1)。更重要的是,我们将在定理4.5中展示上述分析从P(S,Z|C)的指数族到Sobelev空间的扩展;以及从Y的ANM到Y的分类分布。

我们假设f_x(s,z,ε_x)=ˇf_x(s,z) + ε_x的ANM(为简单起见,我们用f_x替换ˇf_x),这已被广泛用于确定因果因素[30,54,35]。我们假设f_x是双射的和可逆的(我们将在后面讨论)。我们首先将我们的兴趣缩小到表示为P_{exp}的LaCIM的子集,其中P_{exp}中的任何模型满足(I)S,Z属于指数族;以及(ii)Y是从以下ANM产生的:

对于t = s,z和e ∈ E,其中q_t,k_t分别表示t = s,z的维数和各维中自然参数的个数。表示充分统计量和自然参数,

表示基本测度和归一化常数,以确保分布的积分等于1。令

,(

).

(

),我们进一步假设P^e(C)表示在集合{c_1,..c_R}上的离散概率,其中

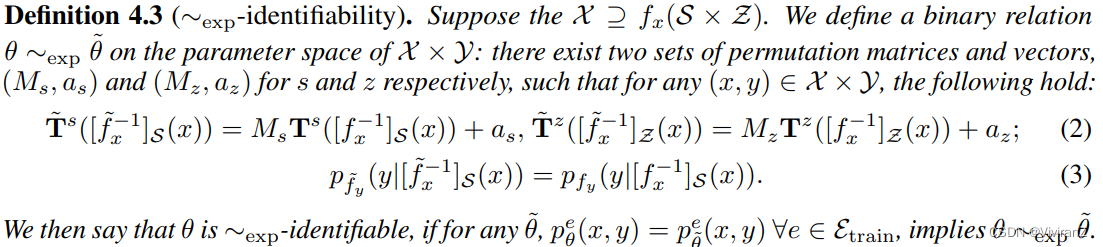

可以看作是指数族分布的混合。不是唯一的推断,我们的目标是从Z中解开S,并且还恢复对ground truth的预测,其被正式定义为如下的指数可识别性:

该定义受非线性ICA [27,35]中考虑的无监督场景的启发,但超出了该场景的范围,因为前者进一步将S与Z分开(在Eq.(2)中)并识别真正的预测机制(在等式(3)中).要了解缠结(disentanglement),请注意,对于任何干净(无噪声)的样本,x ← fx(s*,z*),Eq(2)确保推断出的因果因子不混合其他人的信息,除非S和Z之间存在确定性函数的极端情况,在这种情况下S不可能被识别。有了这样一个s的标识,Eq.(3)进一步保证学习后的

能够恢复ground truth预测概率密度,即

.有了噪音,s*可以推断出一些不确定性。正式结果在定理4.4中给出.

这个定义说了两个事情

(2)指的是,本身假设了features之间是线性关系的前提下,s可以只表示成s的函数(与z无关)、z只表示成z的函数(而与s无关)

(3)保证了学到概率密度是一定的、那么一定能学到“真实”(我们真正想要的)概率密度(for some s*)。

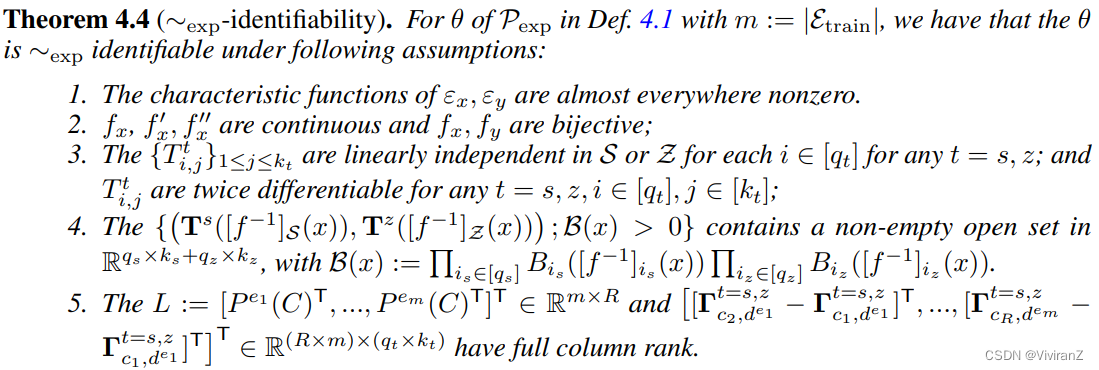

(1)假设1-3是平凡的,很容易满足。对于大多数连续变量,如高斯、指数、贝塔、伽玛分布,εx,εy的特征函数几乎处处非零。这个假设可以确保p(f^{-1}(x))的可识别性,如附录所示。

(2)fx和fy的双射性在[30,54,53,35,75]中被广泛假设为可识别性的基本条件。fx自然是双射的,因为在自动编码器[38]中已经通过经验证明了低维嵌入(即qs + qz < qx)可以很好地恢复原始输入,并且变分自动编码器可以从x中提取有意义的表示。对于具有分类Y的θ,使得,f_y可能不满足双射条件。我们将在定理4.5的后面证明这种分类情况的可识别性。

(3)对于强指数族中的所有分布,假设3可以一致满足。

(4)假设(4)中![]() 0}的开集的包含性意味着由充分统计量扩展的空间在某些开集上是稠密的,这是混合分布P^e (C)和P^e (X,Y |c)可识别的一个充分条件。

0}的开集的包含性意味着由充分统计量扩展的空间在某些开集上是稠密的,这是混合分布P^e (C)和P^e (X,Y |c)可识别的一个充分条件。

(5)假设(5)暗示 i) m ≥ R且m*R≥max(kz*qz,ks*qs)+1;并且 ii)不同的环境在S-Z相关性方面是足够多样的,这几乎是识别不变环境的必要条件(在[1]中假设了不同的版本)。在附录B.2中,我们将证明ii)可以成立,除非γ的空间属于零(Lebesgue)测度集。如公式所示,较大的m将更容易满足条件,这与更多的环境可以提供更多的互补信息的直觉相一致。此外,我们的结果可以推广到{s1,...,s_{q_s} }(或{z1,...,z_{q_z} }),即

我们将定理4.5中的LaCIM推广到一般形式,在下面的定理中,只要它的P(S,Z|C = c) ∈ W^{r,2} (S × Z)(对于某些r ≥ 2)和分类Y。这是通过证明LaCIM中的任何模型都可以通过P_{exp}中的参数化分布序列来近似实现的,其动机是[3]中的指数族在具有有界支持的分布集中是密集的,以及[44]中的多项式logit模型的连续变量可以通过一系列具有i.i.d Gumbel噪声的分布来近似,因为温度收敛到无穷大。证明留在补编里。

我们的证明建立在[3]的基础上,即Sobolev空间中的任何概率都可以用自然参数的数量趋于无穷大的分布序列来近似,即kt → ∞的分布序列

我们的证明建立在[3]的基础上,即Sobolev空间中的任何概率都可以用自然参数的数量趋于无穷大的分布序列来近似,即kt → ∞的分布序列

4.3学习和推理

在可识别性结果的指导下,我们建议通过遵循图1 (c)的生成建模来学习P(X|S,Z)和P(Y |S)。然后从(s*,z*)预测新样本x的标签。我们先利用学习到的p(x|s,z)来推断s*确保不会混合非因果信息,然后学习P(y | s`*)进行预测。

4.3.1学习方法

为了学习用于不变预测的P(X|S,Z),P(Y |S ),我们在监督场景中重构变分自动编码器(VAE)的目标函数,以便适合。作为一种潜在生成模型,VAE最初是为从潜在变量V到高维输入变量x的无监督生成而提出的。为了使这种生成易于处理,VAE引入了由ψ参数化的变分分布q_ψ,以通过最大化以下证据下限(ELBO)

![]() 来逼近难以处理的后验概率,其中等式在q_ψ(v|x) = p_θ(v|x) 时实现。因此,在p_θ和q_ψ上最大化ELBO将驱动(i) qψ(v|x)逼近pθ(v | x);(ii) pθ以估计地面实况模型p。

来逼近难以处理的后验概率,其中等式在q_ψ(v|x) = p_θ(v|x) 时实现。因此,在p_θ和q_ψ上最大化ELBO将驱动(i) qψ(v|x)逼近pθ(v | x);(ii) pθ以估计地面实况模型p。

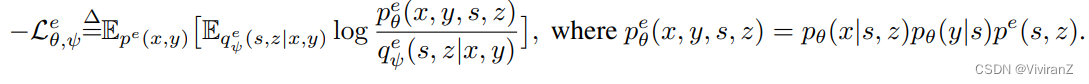

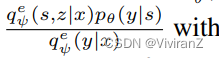

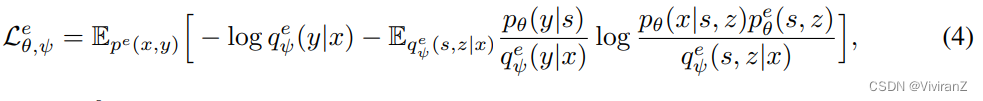

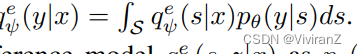

为了使上述替代损失适应图1 (c)中的DAG,我们为每个环境e引入变分分布q^e_ψ (s,z|x,y)。e的对应ELBO为 其中p^e_θ (x,y同样,最小化L e θ,ψ可以驱动pθ(x|s,z),pθ(y|s)来逼近p(x|s,z),p(y|s),也可以驱动q e ψ (s,z|x,y)来估计p e θ (s,z|x,y)。因此,qψ可以继承pθ的性质。由于

其中p^e_θ (x,y同样,最小化L e θ,ψ可以驱动pθ(x|s,z),pθ(y|s)来逼近p(x|s,z),p(y|s),也可以驱动q e ψ (s,z|x,y)来估计p e θ (s,z|x,y)。因此,qψ可以继承pθ的性质。由于![]() 对于图1 (c)中的DAG,我们可以类似地将q e ψ (s,z|x,y)重新参数化为

对于图1 (c)中的DAG,我们可以类似地将q e ψ (s,z|x,y)重新参数化为 其中qψ(y|s)由pθ(y|s)代替(因为qψ的目标是模拟pθ的行为)那么,L e θ,ψ可以改写为

其中qψ(y|s)由pθ(y|s)代替(因为qψ的目标是模拟pθ的行为)那么,L e θ,ψ可以改写为

其中 。我们相应地将先验模型p e θ (s,z)和推理模型q e ψ (s,z|x)参数化为pθ(s,z | \d e)和qψ(s,z|x,\d e),其中d~^e(环境e的)表示可以由长度为m:= |Etrain|的独热编码向量表示的域索引。整体损失函数为

。我们相应地将先验模型p e θ (s,z)和推理模型q e ψ (s,z|x)参数化为pθ(s,z | \d e)和qψ(s,z|x,\d e),其中d~^e(环境e的)表示可以由长度为m:= |Etrain|的独热编码向量表示的域索引。整体损失函数为

应用训练数据集{D^e}e∈Etrain来优化先验模型{p(s,z | d~^e)} _e、推理模型{qψ(s,z|x,d~^e)} 、生成模型pθ(x|s,z)和预测模型pθ(y|s)。特别地,pθ(x|s,Z)和pθ(y|s)的参数在所有环境中是共享的,这是由P(X|S,Z)和P(Y |S)在所有域中的不变性引起的。

4.3.2推理和预测。

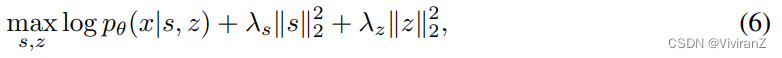

我们利用学习到的P(X|S,Z),P(Y |S)进行预测。根据Prop.4.2和Eq.(3)在定理4.4中,通过P(X|S,Z),P(Y |S)的诱导预测器可以恢复来自e的任何分布偏移的真实预测机制。首先,对于任意从(s*,z*)得到的新样本x,我们优化下面的pθ(x|s,Z)对S × Z的对数似然来推断s*,z*, 用超参数λs > 0和λz > 0为了将学习到的s,z控制在合理的范围内。注意Eq。(6)不同于最大后验估计,因为后验q e ψ (s,z|x)对于不同的E参数化不同,而pθ(x|s,z)对于E参数化不变(这是因为p(x|s,z)不变)。对于优化,我们采用[61]中的策略,即首先从N (0,I)中采样一些候选点,并根据等式选择最优点。(6)作为初始点;然后使用Adam优化另一个测试迭代。实现细节和优化效果见补充E.2 .最后用预估s \\?,z \\?,我们实现学习到的pθ(y | s \\?)进行预测:

用超参数λs > 0和λz > 0为了将学习到的s,z控制在合理的范围内。注意Eq。(6)不同于最大后验估计,因为后验q e ψ (s,z|x)对于不同的E参数化不同,而pθ(x|s,z)对于E参数化不变(这是因为p(x|s,z)不变)。对于优化,我们采用[61]中的策略,即首先从N (0,I)中采样一些候选点,并根据等式选择最优点。(6)作为初始点;然后使用Adam优化另一个测试迭代。实现细节和优化效果见补充E.2 .最后用预估s \\?,z \\?,我们实现学习到的pθ(y | s \\?)进行预测:![]()

5实验

我们首先在sec5.1.中验证定理4.4的可辨识性要求。然后我们在sec5.2.中在真实世界的数据上评估LaCIM.有背景的非身份识别图像数据集(NICO);有色MNIST(CMNIST);阿尔茨海默病神经成像倡议(www.loni.ucla.edu/ADNI ADNI,用于阿尔茨海默病的早期预测),以验证我们的方法在具有分布偏移的目标域上的推广能力。

5.1模拟

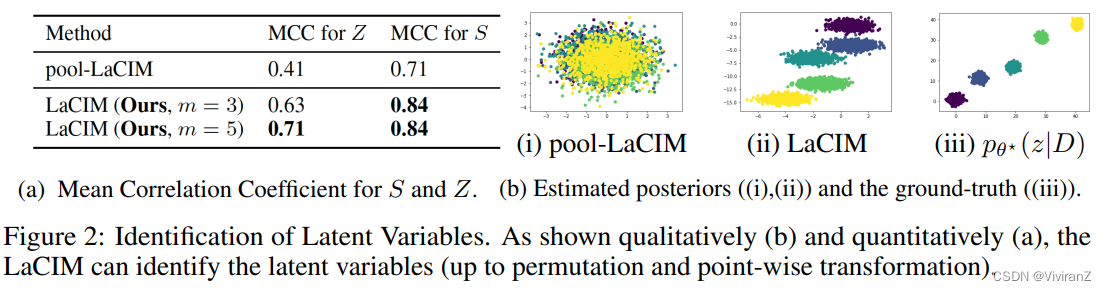

为了验证可识别性声明,我们对合成数据实施LaCIM。我们按照图1生成C,S,Z,X,Y(细节留在附录中)。我们选择m = 3,5,样本总数相同。为了验证在多个不同域(m > 1)上学习的优势,我们比较了pool-LaCIM:最小化损失等式。(4)基于来自所有m个域的汇集数据。我们计算了[35]中采用的平均相关系数(MCC ),它通过引入成本优化将每个学习组件分配给源组件来测量排列下的可识别性的良好程度。我们运行所有方法100次,平均值记录在图2a中。LaCIM优于pool-LaCIM,以及m = 5的LaICM比m = 3的LaICM执行得更好的事实,验证了更多域满足分集条件的好处。为了说明学习效果,我们在图2b中可视化学习的Z(S留在补充E.1中)。

5.2真实世界数据

我们在NICO、CMNIST和ADNI三个数据上验证了LaCIM的泛化能力。

数据集。我们将数据集描述如下(X,Y表示输入和输出;d未观察到):

NICO。我们考虑NICO“动物”数据集中的猫/狗分类,这是[20]中非独立身份问题的基准。每种动物都与“草”、“雪”相关联。D表示采样器的属性。C表示采样的时间和天气,这产生分别表示语义和上下文特征的S、Z。我们将数据集分为m个训练域和测试域,其中每个域具有与每只动物相关联的不同比例的上下文,即(草地中的猫百分比、雪地中的猫百分比、草地中的狗百分比、雪地中的狗百分比),这是由于d确定了不同的采样策略。3.分布转移指的是上下文和标签之间的虚假关联。

CMNIST:根据MNIST,我们将数字0-4和5-9重新标记为y = 0和y = 1。然后,我们将y = 0 (y = 1)的图像的p e(1 p e)着色为绿色,其他图像为红色。我们设m = 2,p e1 = 0.95,pe2 = 0.99而测试域的p测试被设置为0.1。D表示画家的特征。Z、S分别表示与颜色和数字相关的特征。他们的混杂因素C表示画家D绘制数字和颜色的时间和天气,例如,在阳光明媚的早晨,画家倾向于绘制红色0而不是绿色1。在这方面,分布偏移指的是颜色和标签之间的伪相关性。

ADNI。Y := {0,1,2},其中0,1,2分别表示正常对照、轻度认知障碍和AD。X是结构磁共振成像。我们将数据分成m = 2个训练域和测试域,用不同的D值表示年龄τ(一种生物标志物[24])。C、S (Z)分别表示影响脑结构发育和与疾病相关(-不相关)脑区的激素水平。所有域之间的分布变化是由于不同的d值。

比较基线和实现细节。我们比较了(I)从X → Y (ERM)的经验风险最小化,(ii)领域对立神经网络(DANN) [15],(iii)与对立自动编码器(MMD-AAE) [43]的最大平均差异,(iv)领域不变变变分自动编码器(DIVA) [29],(v)不变风险最小化(IRM) [1],(vi)监督VAE (sVAE):我们的LaCIM由VAE实施,没有解开S,z7, 8).我们实现SGD作为优化器,CMNIST的学习率(lr)为0.5,权重衰减(wd)为1e-5;lr 0.01,每60个周期衰减0.2倍,NICO和ADNI的wd为5e-5(wd为2e-4)。对于ADNI NICO的CMNIST,批量大小被设置为256、30和4。

主要结果和讨论。我们报告每种方法运行10次以上的准确度。如表中所示。1,我们的LaCIM在所有数据上始终优于其他产品。具体来说,优于IRM和风险管理的优势可能是由于纳入了图1 (c)中嵌入的因果假设。此外,对sVAE的改进得益于S与其他S的分离,以避免伪相关。此外,较大的m(在总样本量固定的情况下)可以给NICO带来进一步的好处,这可能是因为定理4.4中的多样性条件更容易满足。

可解释性。我们在CMNIST和NICO上想象学到的S和Z。具体来说,对于CMNIST,我们通过用固定的Z(和S)插值S(和Z)来可视化生成的图像(所有属于Y = 0的类中只有数字“0”,所有属于Y = 1的类中只有数字“7”);对于NICO,我们采用梯度法[67],这种方法将S的导数可视化。(即,与Y具有最高相关性的S的维度)。

如图3a所示,随着s的增加,第1和第2行中生成的顺序图像看起来更像从“0”到“7”;而第二行中的连续图像随着z的增加从红色变为绿色。此外,S的不同维度可以学习不同的区分语义信息。比如第一维可以学习在手写“7”中加破折号;而二次元可以学习去除插值的“0”到“7”的左边部分。对于Z维度,它学习了其他非区分因素,如宽度、颜色。这个结果反映了所学习的S和Z对应于数字(Y的原因因素)和颜色相关的特征。对于NICO,图3b示出了识别比ERM更可解释的LaCIM语义特征的能力,其中所学习的特征可以混合背景信息。附录E.5提供了更多结果。

6结论和讨论

我们建议恢复潜在的因果因素,这对于由域变量引起的分布变化是鲁棒的。我们引入了彼此虚假相关的因果和非因果潜在因素,并通过不变机制生成输入和输出。在这种不变性下,因果因素被保证从非因果因素中分离出来,这导致了在所有域上都成立的基础真值预测器。提出了一种重构的生成模型,用于推理因果因子和预测。我们的模型的一个可能的缺点在于我们对可识别性的环境数量的要求,其放宽留在未来的工作中。

449

449

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?