学习率可以是自定义的,也可以通过一些算法或工具进行自动调整。在训练机器学习模型时,学习率是一个非常重要的超参数,它决定了模型的参数(如权重)在每次迭代中更新的步长。

1. 自定义学习率

通常在模型训练的初期,你可以根据经验或实验手动设定一个学习率。这种方法称为固定学习率,即在整个训练过程中,学习率保持不变。以下是一些常用的设定方式:

- 手动设置学习率:你可以根据模型复杂性和数据集特点来设定一个合适的学习率。常见的学习率范围是 0.01 到 0.0001。

- 如果学习率太大,训练过程中会导致震荡,模型难以收敛。

- 如果学习率太小,训练过程会非常缓慢,收敛速度降低。

2. 动态调整学习率

为了提高训练效果,避免过大或过小的学习率对训练的影响,常常会采用动态调整学习率的方法。以下是几种常见的动态调整策略:

(1) 学习率衰减

随着训练的进行,逐渐减小学习率。这样做的目的是让模型在初期快速更新权重,后期逐渐细化权重,达到更精确的优化。

-

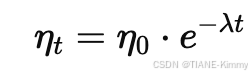

指数衰减:学习率随着时间呈指数衰减。

其中 η 是初始学习率,t是迭代次数,λ是衰减率。

-

阶梯衰减:在训练的某些阶段,突然减小学习率。例如,训练到一定轮次时,将学习率减半。

(2) 自适应学习率算法

一些优化算法能够根据梯度信息自动调整学习率,无需手动设定或调整。常见的自适应优化算法包括:

- Adam(Adaptive Moment Estimation):Adam 会根据一阶矩和二阶矩的估计动态调整每个参数的学习率,适用于大多数深度学习任务。

- Adagrad:通过积累以前的梯度信息,自动缩小频繁更新参数的学习率,使其在后续更新中减少步长。

- RMSprop:与 Adagrad 类似,RMSprop 会对历史梯度进行加权平均,用于更新学习率,适合处理稀疏数据和非平稳梯度。

(3) 学习率调度器

一些深度学习框架(如 TensorFlow、PyTorch 等)提供了学习率调度器,能够根据模型的训练表现自动调整学习率。例如:

- ReduceLROnPlateau:当验证集上的损失不再下降时,自动减小学习率。

- Cyclic learning rates (CLR):学习率在一定范围内进行周期性变化,能帮助模型逃离局部最优解。

3. Warm-up学习率

有时,在训练的初期使用较小的学习率(称为 warm-up phase),然后逐渐增加到设定的学习率,可以避免初期梯度过大导致的不稳定训练。这种方法特别适用于大规模深度神经网络。

4. 如何选择学习率

选择学习率是模型调参过程中非常重要的一步,常见的方法有:

- 试验和观察:通过实验和观察损失函数的变化,选择合适的学习率。你可以使用较大的学习率开始测试,观察损失是否迅速减少,是否有震荡等现象。

- 学习率调优工具:使用一些工具或框架提供的学习率调优算法(如网格搜索、随机搜索等)来找到最优的学习率范围。

- 可视化:通过绘制损失随学习率变化的图像(如学习率查找器),帮助选择合适的学习率。

总结

- 学习率可以是自定义的,用户可以根据经验手动设定,也可以通过动态调整策略或自适应算法进行优化。

- 固定学习率适用于一些简单的场景,而动态调整和自适应学习率算法通常在复杂任务中表现更好,能够提高训练效率和模型效果。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?