6 决策树:CART算法

6.1 CART算法简介

从名字也可看出,是用树来进行分类与回归。

CART算法的树 是 二叉树!

之前那些多叉的决策树是可以转成二叉树的:

对于特征:纹理。 可分为清晰,与非清晰,这就变为二叉了;非清晰再分为模糊与否。

这样,就把多叉变为二叉了。

6.2 CART算法---基尼指数

决策树都得使用一个指标去选择特征,之前我们学过用信息增益,信息增益比。

而CART算法是用基尼指数来选择特征。基尼指数反映的是不确定性的大小,用来度量不同特征的分类能力,基尼指数越小,说明不确定性就越小,说明该特征的分类能力越好。

样本中是不知道某一个分类它的出现概率是多少的,只能按经验方法,用该类个数/总个数。

特征下的基尼指数:

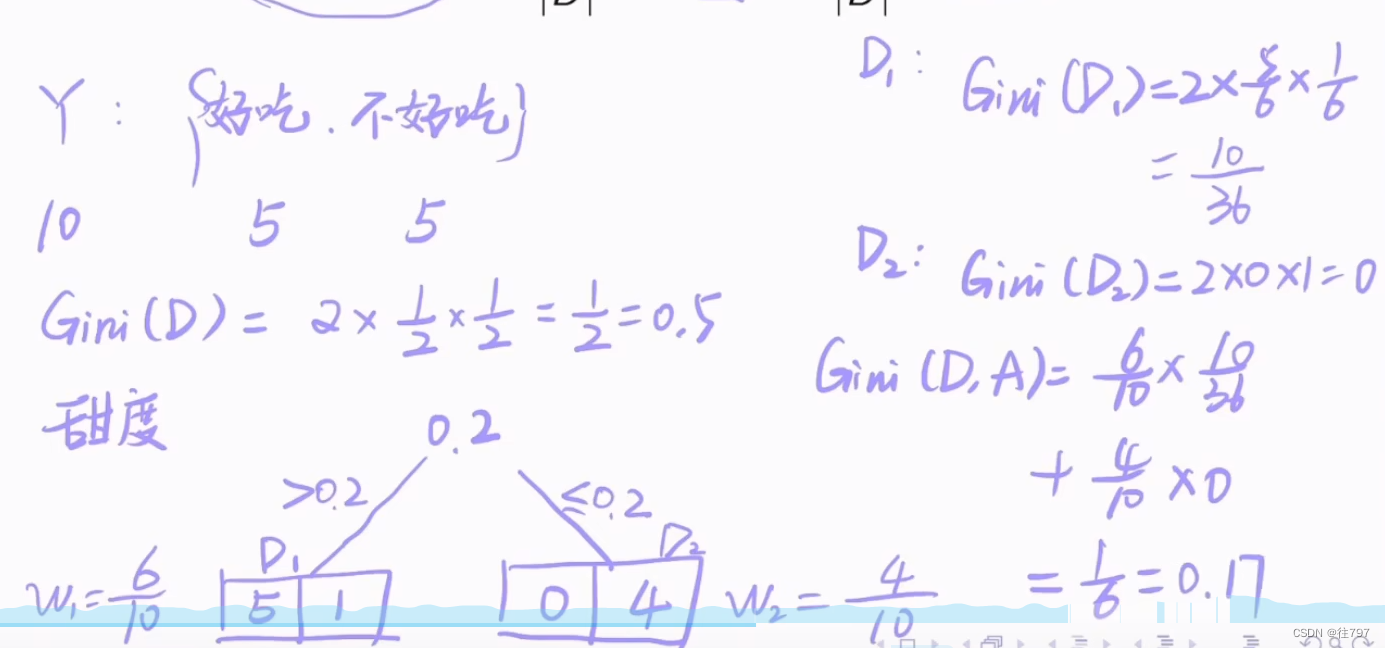

举例说明:水蜜桃例子

水蜜桃有两种分类:好吃 与 不好吃

这是没有特征下计算的基尼指数。

这是没有特征下计算的基尼指数。

假设有个特征是甜度,根据甜度进行分类

假设还有个特征是硬度

甜度特征下的基尼指数更小,即分类的不确定性更小,分类能力更好,故应该选择甜度特征。

6.3CART分类树算法

例题解说:

对于特征“年龄”,它虽有三个分类:青年,中年,老年。

但我们可将其分为:青年与非青年(第一种分法);中年与非中年(第二种分法);老年与非老年(第三种分法)

接着按照三种分法分别计算基尼指数,如上图。

以上是第二个特征:有工作与否

以上是第三个特征:有房子与否

以上是第四个特征

比较四个特征的基尼指数,发现第三个特征“有自己的房子”的基尼指数最小

故根节点的特征选择“有自己的房子”

得到如下决策树:

那么,没有自己的房子的样本数据中,应该选择哪个特征作为分类呢?

计算剩下的特征在剩下的样本中的基尼指数。

对于这里,我们人眼能直接看出“有工作”特征的基尼指数为0而已,但是计算机不会,对于实际使用来说,计算机它还要经过计算才能得到。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?