贝叶斯分类器:机器学习中的经典算法

-

引言

什么是贝叶斯分类器?

贝叶斯分类器是一类基于贝叶斯定理的统计分类算法。它使用概率推理来预测给定样本属于某个类别的概率。在贝叶斯分类器中,通常假设特征之间是相互独立的,这种假设下的分类器被称为朴素贝叶斯分类器。贝叶斯分类器在处理分类问题时,特别是在文本分类和垃圾邮件检测等应用中表现出色。

贝叶斯分类器在机器学习中的地位和应用

贝叶斯分类器在机器学习中占有重要地位,主要由于其简单性、高效性和适用于高维数据的能力。它被广泛应用于各种实际问题中,例如:

- 文本分类(如新闻分类、情感分析)

- 垃圾邮件检测

- 医疗诊断(如疾病预测)

- 图像识别

- 金融预测(如信用评分)

这些应用展示了贝叶斯分类器在处理实际问题中的强大能力。

本文目标:介绍贝叶斯分类器的基本概念、原理、实现和应用

本文旨在全面介绍贝叶斯分类器。我们将从基本概念开始,详细解释贝叶斯定理、条件概率、先验概率和后验概率,然后介绍朴素贝叶斯分类器的原理和实现。接下来,我们会展示如何使用Python实现朴素贝叶斯分类器,并讨论其在不同领域的应用。最后,我们将分析贝叶斯分类器的优缺点,并提出一些常见问题的解决方案。

1.基本概念

贝叶斯定理简介

贝叶斯定理是概率论中的一个重要定理,它描述了如何根据新的证据更新事件的概率。贝叶斯定理的公式如下:

P

(

A

∣

B

)

=

P

(

B

∣

A

)

⋅

P

(

A

)

P

(

B

)

P(A|B) = \frac{P(B|A) \cdot P(A)}{P(B)}

P(A∣B)=P(B)P(B∣A)⋅P(A)

其中:

- ( P(A|B) ) 是在事件B发生的条件下事件A发生的概率,即后验概率。

- ( P(B|A) ) 是在事件A发生的条件下事件B发生的概率。

- ( P(A) ) 是事件A发生的先验概率。

- ( P(B) ) 是事件B发生的先验概率。

条件概率

条件概率是指在一个事件发生的前提下,另一个事件发生的概率。用数学语言表示为:

P ( A ∣ B ) = P ( A ∩ B ) P ( B ) P(A|B) = \frac{P(A \cap B)}{P(B)} P(A∣B)=P(B)P(A∩B)

这表示在事件B已经发生的条件下,事件A发生的概率。

先验概率和后验概率

- 先验概率(Prior Probability):先验概率是指在没有新证据的情况下,一个事件发生的概率。在贝叶斯定理中,先验概率通常用 ( P(A) ) 表示。

- 后验概率(Posterior Probability):后验概率是指在考虑了新证据之后,一个事件发生的概率。在贝叶斯定理中,后验概率通常用 ( P(A|B) ) 表示。

贝叶斯定理的核心思想是通过先验概率和新的证据(条件概率)来更新事件的概率,从而获得后验概率。这一过程在机器学习和统计推断中具有广泛的应用。

通过理解这些基本概念,我们可以更好地理解贝叶斯分类器的工作原理和实现方法。在接下来的部分中,我们将详细介绍朴素贝叶斯分类器的假设、公式推导及其实际应用。

2.贝叶斯分类器原理

朴素贝叶斯分类器的假设

朴素贝叶斯分类器(Naive Bayes Classifier)基于贝叶斯定理,并作出一个重要假设:假设特征之间是条件独立的。也就是说,给定类别的条件下,每个特征是独立的。这一假设虽然在现实中不总是成立,但在很多实际应用中,朴素贝叶斯分类器仍然表现良好。该假设大大简化了计算复杂度,使得算法在高维数据上也能高效运行。

朴素贝叶斯分类器公式推导

假设我们有一个由n个特征向量 x = ( x 1 , x 2 , . . . , x n ) \mathbf{x} = (x_1, x_2, ..., x_n) x=(x1,x2,...,xn)表示的样本,我们希望确定样本属于某个类别 C k C_k Ck的概率,即 P ( C k ∣ x ) P(C_k | \mathbf{x}) P(Ck∣x)。根据贝叶斯定理,我们有:

P ( C k ∣ x ) = P ( x ∣ C k ) ⋅ P ( C k ) P ( x ) P(C_k | \mathbf{x}) = \frac{P(\mathbf{x} | C_k) \cdot P(C_k)}{P(\mathbf{x})} P(Ck∣x)=P(x)P(x∣Ck)⋅P(Ck)

由于我们只关心在不同类别下的相对概率,可以忽略分母 P ( x ) P(\mathbf{x}) P(x):

P ( C k ∣ x ) ∝ P ( x ∣ C k ) ⋅ P ( C k ) P(C_k | \mathbf{x}) \propto P(\mathbf{x} | C_k) \cdot P(C_k) P(Ck∣x)∝P(x∣Ck)⋅P(Ck)

在朴素贝叶斯分类器中,假设特征之间是条件独立的,因此:

P ( x ∣ C k ) = P ( x 1 , x 2 , . . . , x n ∣ C k ) = ∏ i = 1 n P ( x i ∣ C k ) P(\mathbf{x} | C_k) = P(x_1, x_2, ..., x_n | C_k) = \prod_{i=1}^{n} P(x_i | C_k) P(x∣Ck)=P(x1,x2,...,xn∣Ck)=i=1∏nP(xi∣Ck)

于是,公式变为:

P ( C k ∣ x ) ∝ P ( C k ) ⋅ ∏ i = 1 n P ( x i ∣ C k ) P(C_k | \mathbf{x}) \propto P(C_k) \cdot \prod_{i=1}^{n} P(x_i | C_k) P(Ck∣x)∝P(Ck)⋅i=1∏nP(xi∣Ck)

我们需要计算每个类别 C k C_k Ck 的后验概率,并选择后验概率最大的类别作为预测结果:

C ^ = arg max C k P ( C k ) ⋅ ∏ i = 1 n P ( x i ∣ C k ) \hat{C} = \arg\max_{C_k} P(C_k) \cdot \prod_{i=1}^{n} P(x_i | C_k) C^=argCkmaxP(Ck)⋅i=1∏nP(xi∣Ck)

多项式朴素贝叶斯 vs. 高斯朴素贝叶斯

多项式朴素贝叶斯

多项式朴素贝叶斯(Multinomial Naive Bayes)适用于离散型数据,特别是文档分类任务。在多项式朴素贝叶斯中,假设特征 x i x_i xi是离散的计数值(如单词的频率),其概率 P ( x i ∣ C k ) P(x_i | C_k) P(xi∣Ck) 可以通过样本中每个类别的特征频率计算得到。

公式为:

P ( x i ∣ C k ) = count ( x i , C k ) + 1 ∑ x ′ count ( x ′ , C k ) + ∣ V ∣ P(x_i | C_k) = \frac{\text{count}(x_i, C_k) + 1}{\sum_{x'} \text{count}(x', C_k) + |V|} P(xi∣Ck)=∑x′count(x′,Ck)+∣V∣count(xi,Ck)+1

其中, count ( x i , C k ) \text{count}(x_i, C_k) count(xi,Ck) 表示类别 C k C_k Ck 中特征 x i x_i xi 出现的次数, ∣ V ∣ |V| ∣V∣ 是特征总数(词汇表大小),平滑参数(如拉普拉斯平滑)可以防止概率为零。

高斯朴素贝叶斯

高斯朴素贝叶斯(Gaussian Naive Bayes)适用于连续型数据,假设特征 x i x_i xi 服从高斯(正态)分布。在这种情况下,特征的条件概率 P ( x i ∣ C k ) P(x_i | C_k) P(xi∣Ck) 可以用高斯分布的概率密度函数表示:

P ( x i ∣ C k ) = 1 2 π σ C k 2 exp ( − ( x i − μ C k ) 2 2 σ C k 2 ) P(x_i | C_k) = \frac{1}{\sqrt{2 \pi \sigma_{C_k}^2}} \exp\left(-\frac{(x_i - \mu_{C_k})^2}{2 \sigma_{C_k}^2}\right) P(xi∣Ck)=2πσCk21exp(−2σCk2(xi−μCk)2)

其中, μ C k 和 σ C k \mu_{C_k} 和 \sigma_{C_k} μCk和σCk 分别是类别 $ C_k $ 中特征 $ x_i $的均值和标准差。

高斯朴素贝叶斯常用于处理连续特征,如在图像分类和传感器数据处理中的应用。

通过上述分析,我们可以根据数据的性质选择合适的朴素贝叶斯分类器类型。在接下来的部分中,我们将探讨如何实现朴素贝叶斯分类器,并讨论其在实际中的应用。

3.贝叶斯分类器的实现

数据准备

数据集选择

选择一个合适的数据集是构建贝叶斯分类器的第一步。常用的数据集包括:

- Iris数据集:包含150个花的样本,分为三类,每个样本有四个特征(萼片和花瓣的长度和宽度)。

- Spambase数据集:包含4601封电子邮件的特征,用于垃圾邮件检测。

- 20 Newsgroups数据集:包含约20000篇新闻文章,分为20个类别,用于文本分类。

为了便于演示,我们将使用一个简单的自定义数据集。

数据预处理

数据预处理包括数据清洗、特征选择、数据归一化等步骤。对于贝叶斯分类器,重要的预处理步骤包括:

- 处理缺失值:可以使用均值、中位数或常数填补缺失值。

- 数据归一化:对于高斯朴素贝叶斯,特征值需要归一化到相似的范围。

- 编码分类变量:将分类特征转换为数值型。

朴素贝叶斯分类器的实现步骤

使用Python实现朴素贝叶斯分类器

首先,我们定义一个简单的自定义数据集:

# 示例数据集

data = [

{"features": [1, 2], "label": "A"},

{"features": [1, 3], "label": "A"},

{"features": [2, 2], "label": "B"},

{"features": [2, 3], "label": "B"}

]

# 将数据集划分为特征和标签

features = [item["features"] for item in data]

labels = [item["label"] for item in data]

然后,我们定义一个函数来计算先验概率:

def calculate_prior_probabilities(labels):

label_counts = {}

total_count = len(labels)

for label in labels:

if label not in label_counts:

label_counts[label] = 0

label_counts[label] += 1

prior_probabilities = {}

for label, count in label_counts.items():

prior_probabilities[label] = count / total_count

return prior_probabilities

prior_probabilities = calculate_prior_probabilities(labels)

print("先验概率:", prior_probabilities)

接下来,我们定义一个函数来计算条件概率:

def calculate_conditional_probabilities(features, labels):

from collections import defaultdict

import math

feature_count = len(features[0])

label_feature_counts = defaultdict(lambda: [defaultdict(int) for _ in range(feature_count)])

label_counts = defaultdict(int)

for feature, label in zip(features, labels):

label_counts[label] += 1

for i, value in enumerate(feature):

label_feature_counts[label][i][value] += 1

conditional_probabilities = {}

for label, feature_dicts in label_feature_counts.items():

conditional_probabilities[label] = []

for i, feature_dict in enumerate(feature_dicts):

total_count = label_counts[label]

feature_probs = {value: (count + 1) / (total_count + len(feature_dict)) for value, count in feature_dict.items()}

conditional_probabilities[label].append(feature_probs)

return conditional_probabilities

conditional_probabilities = calculate_conditional_probabilities(features, labels)

print("条件概率:", conditional_probabilities)

最后,实现预测函数:

def predict(features, prior_probabilities, conditional_probabilities):

import math

best_label = None

max_prob = -math.inf

for label, prior in prior_probabilities.items():

prob = math.log(prior)

for i, value in enumerate(features):

if value in conditional_probabilities[label][i]:

prob += math.log(conditional_probabilities[label][i][value])

else:

prob += math.log(1 / (sum([len(prob_dict) for prob_dict in conditional_probabilities[label]]) + 1))

if prob > max_prob:

max_prob = prob

best_label = label

return best_label

# 测试预测

test_sample = [1, 2]

predicted_label = predict(test_sample, prior_probabilities, conditional_probabilities)

print("预测标签:", predicted_label)

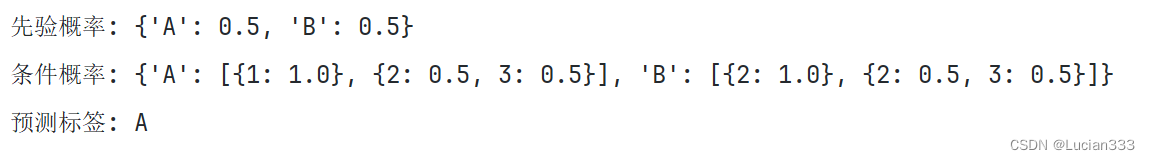

结果:

4.优缺点分析

贝叶斯分类器的优点

简单高效

贝叶斯分类器由于其数学基础简单,易于实现且计算速度快。无论是在训练还是预测阶段,贝叶斯分类器都能够快速地处理大规模数据。这使得它在实际应用中非常高效,尤其是在实时预测和在线学习场景中。

处理高维数据能力强

贝叶斯分类器能够很好地处理高维数据。即使在特征数量远大于样本数量的情况下,它依然能够给出较为准确的预测。这使得贝叶斯分类器在文本分类、图像识别等高维数据场景中表现出色。

贝叶斯分类器的缺点

假设属性独立性

贝叶斯分类器的一个主要缺点是其假设特征之间是条件独立的。在很多实际问题中,这一假设并不成立。如果特征之间存在强烈的相关性,贝叶斯分类器的性能可能会受到影响,导致预测结果不准确。

对数据缺失值敏感

贝叶斯分类器对数据缺失值较为敏感。缺失值会影响条件概率的计算,从而影响分类器的性能。在处理缺失值较多的数据集时,需要特别小心,采用适当的方法填补缺失值,以避免对模型产生负面影响。

5.常见问题与解决方案

如何处理数据中的缺失值?

-

删除包含缺失值的样本:在缺失值较少时,可以直接删除包含缺失值的样本。不过,这种方法可能会导致信息损失。

-

使用均值、中位数或众数填补:对于数值型数据,可以用该特征的均值或中位数填补缺失值;对于分类变量,可以使用众数填补。

-

使用插值或回归方法填补:利用插值方法或训练一个回归模型来预测并填补缺失值。

-

使用K近邻填补:使用K近邻算法,根据最近邻的样本值来填补缺失值。

如何选择合适的贝叶斯分类器类型?

-

根据数据类型选择:如果数据是离散型的(如文本数据、计数数据),多项式朴素贝叶斯分类器(Multinomial Naive Bayes)是一个合适的选择;如果数据是连续型的(如传感器数据、图像数据),高斯朴素贝叶斯分类器(Gaussian Naive Bayes)则更为合适。

-

根据任务需求选择:不同的任务可能需要不同类型的贝叶斯分类器。例如,在垃圾邮件检测中,多项式朴素贝叶斯分类器通常效果较好;在医学诊断中,高斯朴素贝叶斯分类器可能更合适。

如何提高贝叶斯分类器的性能?

-

特征选择:选择与目标变量关系密切的特征,去除冗余或无关的特征,能够提高分类器的性能。

-

特征工程:通过对特征进行归一化、标准化、变换等预处理,提高特征的可分性,从而提高分类器的性能。

-

使用平滑技术:在计算条件概率时使用拉普拉斯平滑(Laplace Smoothing),可以防止因某些特征值未出现在训练数据中而导致的概率为零的问题。

-

模型集成:将朴素贝叶斯分类器与其他机器学习算法(如决策树、随机森林)结合,构建集成模型,能够进一步提高预测性能。

-

优化超参数:通过交叉验证等方法调节模型的超参数,找到最优参数配置,从而提升模型的性能。

通过以上方法,可以有效地提高贝叶斯分类器的预测性能,使其在不同的应用场景中表现更佳。

2106

2106

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?