1.打开本地ollama服务

键盘win+R->输入cmd,回车->输入ollama serve,回车

2.下载安装AnythingLLM

点击前往官网,选择适合自己的操作系统下载,这里是windows,下载好后双击安装,修改路径即可,安装过程可能需要几分钟。

下载成功

安装

3.配置

3.1 下面是打开后的界面,点击进入

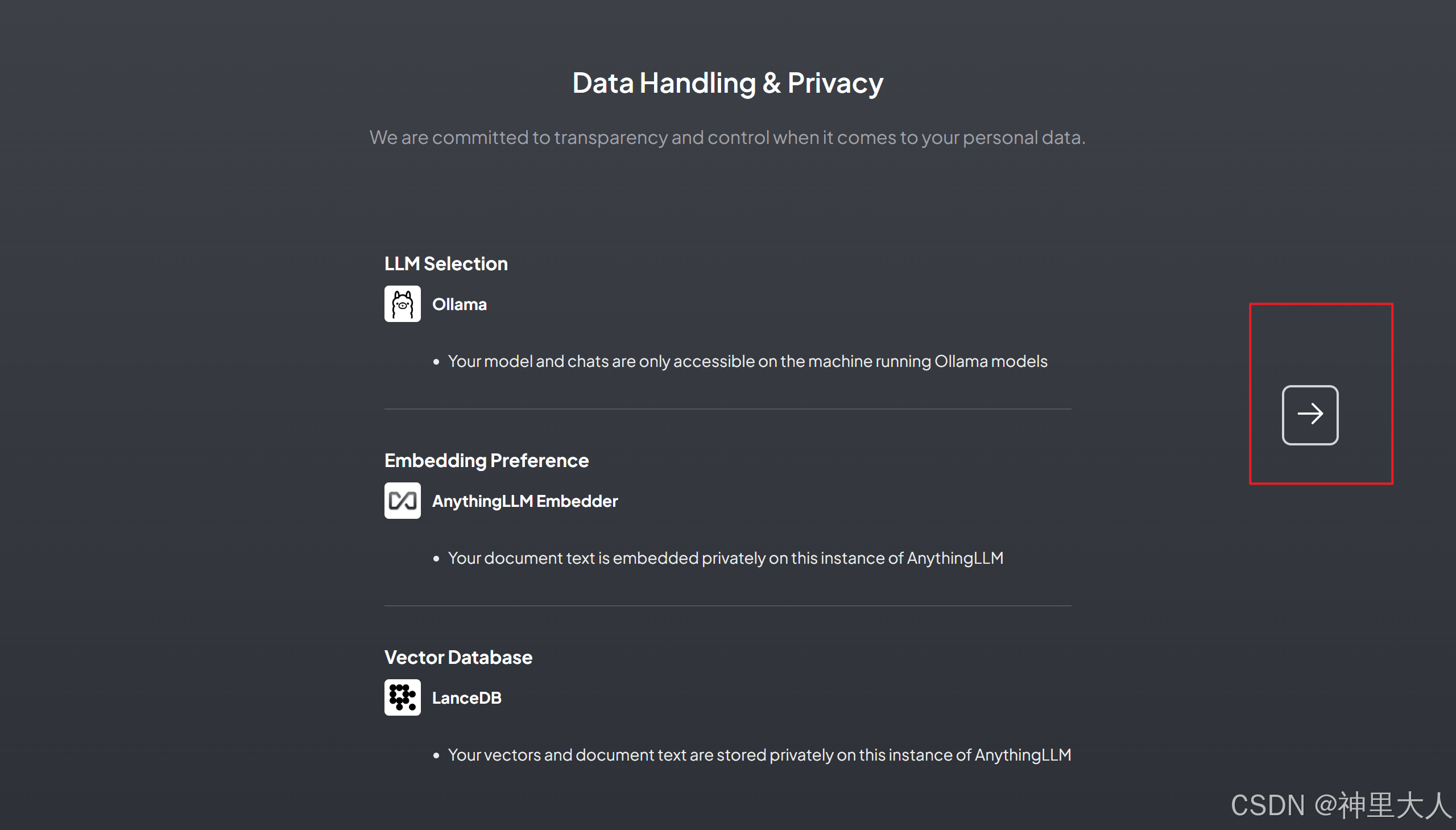

3.2 下滑找的Ollama,选择本地下载好的模型(这里是llama3.1:8b),然后点击下一步两次

3.3 输入邮箱地址,选择个人,点击下一步

3.4 起一个工作区名称,点击下一步

3.5 进入欢迎界面,点击进行测试基础的模型对话,比如讲个笑话

3.6 修改语言,进入设置,改成Chinese

4.知识库上传

4.1 上传前测试

4.2 点击上传按钮,这里可以上传本地的,也可以是网页,这里是网页(小米13价格)

4.3 下滑输入网页,点击获取

https://www.mi.com/shop/buy/detail?product_id=17971&cfrom=search

4.4 获取成功后选中,点击移动到工作区

4.5 下滑到最后,点击嵌入,显示成功后就关闭这个上传页面回到对话

4.6 上传后测试,可以看到虽然已经有价格了,但是是不对的

4.7 查看大模型找到的数据,可以看到并没有关于价格的,而且还非常的不“干净”,说明这种通过网页获取的数据的回答不行。

4.8 选择本地数据,新建一个文本test.txt

4.9 上传test.txt,重复4.4-4.6

4.10 再次测试,可以看到这次就成功了

3261

3261

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?