以下是安装deepseek-r1模型本地化。

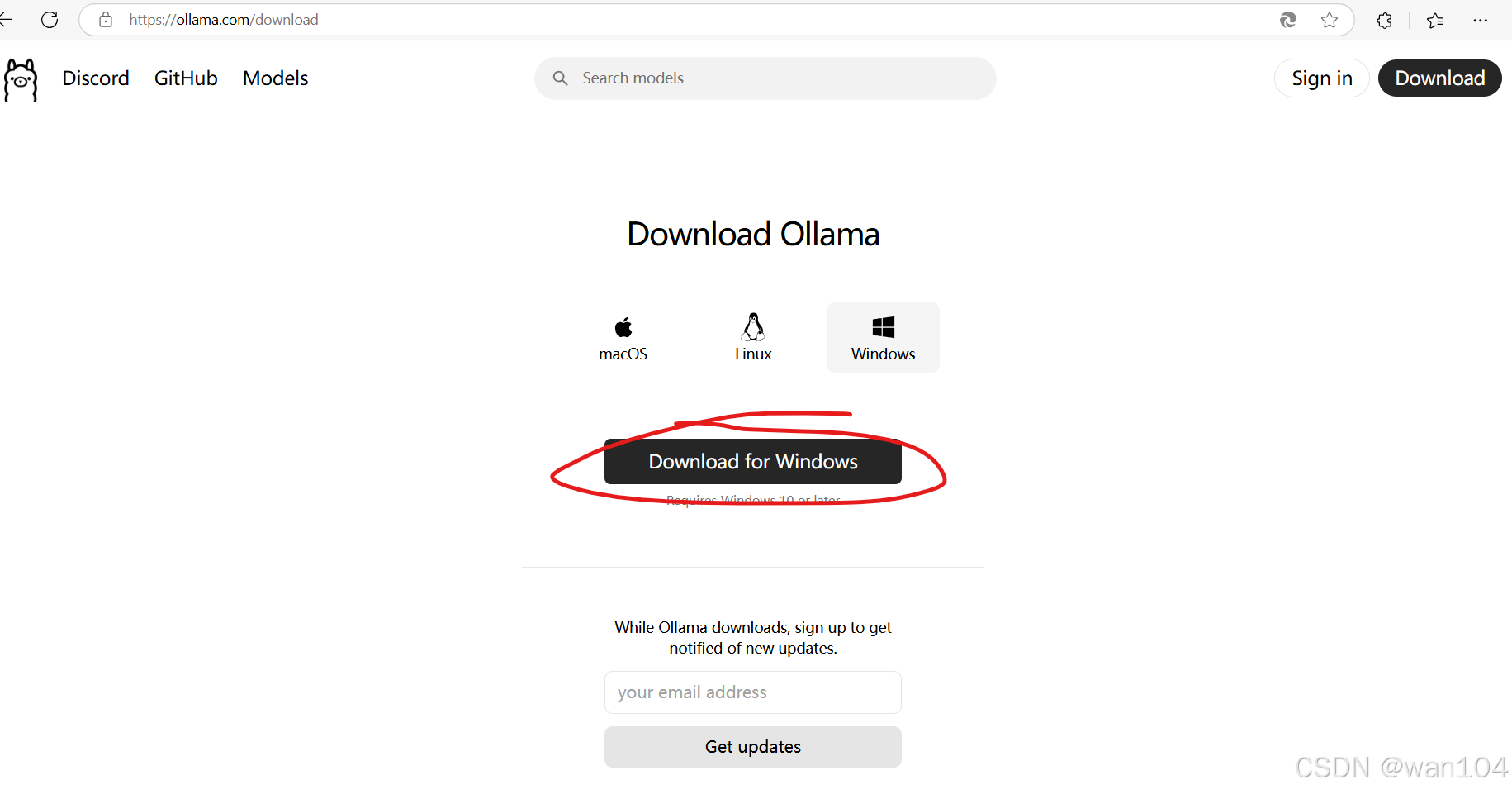

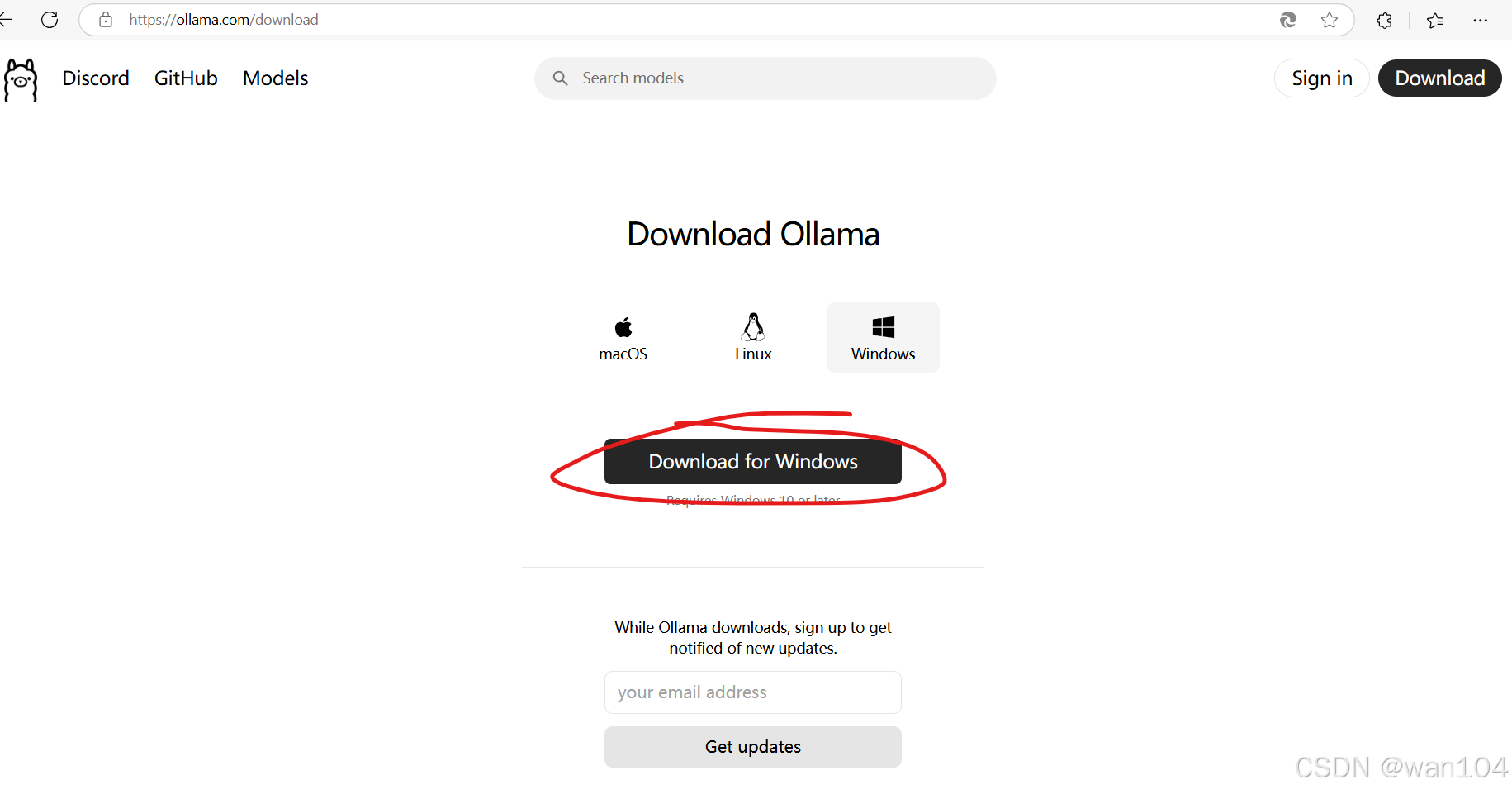

第一步:打开ollama官网下载软件。我的是windows电脑。下载后和正常软件一样的安装方法。安装后右下角会有羊驼的标志,证明安装成功了。

第二步:设置环境变量,以后模型都下载到你设置的文件夹内。

第三步:下载模型,并运行。在cmd中执行以下命令下载模型。

ollama run deepseek-r1:8b

下载后就可以对话了。但是比较丑,需要UI界面,也需要联网。

以下是UI和联网的方法。

第一步:①打开下面的网址,获取浏览器插件。

以下是安装deepseek-r1模型本地化。

第一步:打开ollama官网下载软件。我的是windows电脑。下载后和正常软件一样的安装方法。安装后右下角会有羊驼的标志,证明安装成功了。

第二步:设置环境变量,以后模型都下载到你设置的文件夹内。

第三步:下载模型,并运行。在cmd中执行以下命令下载模型。

ollama run deepseek-r1:8b

下载后就可以对话了。但是比较丑,需要UI界面,也需要联网。

以下是UI和联网的方法。

第一步:①打开下面的网址,获取浏览器插件。

804

804

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?