1 目标检测与YOLO

1.1 包围框与置信度

1.1.1 YOLO包围框

我们有个框,每个框的bb个数为B,分类器可以识别出C种不同的物体,那么所有整个ground truth的长度为S × S × (B × 5 + C)

YOLO v1中,这个数量是30

YOLO v2和以后版本使用了自聚类的anchor box为bb, v2版本为B = 5, v3中B = 9

处理细节——归一化:

四个关于位置的值,分别是𝑥, 𝑦, ℎ和𝑤,均为整数,实际预测中收敛慢因此,需要对数据进行归一化,在0-1之间。

例子是一个448*448的图 片,有3*3的grid,每个 cell是149。 目标中心点是(220,190)

1.1.2 YOLO置信度

置信度计算公式:

- Pr(𝑜𝑏𝑗)是一个grid有物体的概率

- IOU是预测的bb和真实的物体位置的交并比

1.1.3 训练值与预测值

处理细节——真实值:

Pr(obj)的ground truth:三个目标中点对应格子为1,其它为0。

1.2 损失函数

第2项要开根号让误差更显著,保证回归精度

1.3 训练与NMS

1.3.1 预训练与训练

保留了这么多边界框,预测中一个物体可能被多个边界框包围;实际物体只对应一个边界

框,如何解决个问题呢?NMS核心思想是:选择得分最高的作为输出,与该输出重叠的去掉,不断重复这一过程直到所有备选处理完。

1.3.2 NMS算法要点

2 语义分割与FCN

2.1 语义分割问题

语义分割:找到同一画面中的不同类型目标区域

2.2 语义分割基本思想

2.2.1 目标

对图中每一个像素进行分类,得到对应标签

2.2.2 基本思想

由于滑动窗口滑动次数太多,计算太慢,重复计算太多的缺点,采用FCN网路结构

FCN网络结构:

2.3 反卷积与反池化

1x1卷积:

转置卷积:

上池化:

2.4 FCN具体实现

FCN网络结构:卷积部分

传统卷积神经网络:

FCN中第6、7、8层都是通过1 × 1卷积得到的,第6层的输出是4096 × 7 × 7, 第7层的输出是4096 × 7 × 7 ,第8层的输出是1000 × 7 × 7,即1000个大小是 7 × 7的特征图(称为heatmap)

输出的特征图(称为heatmap),颜色越贴近红色表示对应数值越大。

FCN网络结构:反卷积部分,跳级结构

蓝色:卷积层;绿色:Max Pooling层;黄色: 求和运算;灰色: 裁剪

3 循环神经网络与NLP

3.1 数据预处理

3.1.1 特征编码

其中第1列表示年龄,是一个数值特征,第2列表示性别,是一个只有一位(0,1)的特征 0 -> Male, 1 -> Female,第3列表示国籍,目前有197个国家 1 -> US, 2 -> China, …

对于国家类别,可以用一个整数来表示,或者用一个独热向量来表示, 如US: [1,0, ….,0]

数值特征不适合表示类别,因此一般使用独热编码 ;

国家编码从1开始,1~197,因为实际国籍有可能不填(对应0)。

3.1.2 文本处理

按字母处理:

给定文本片段,如:S = “… to be or not to be…”.

将文本切分为字母序列:L = […, ‘t’, ‘o’, ‘ ’, ‘b’, ‘e’, …]

按单词处理:

给定文本片段,如:S = “… to be or not to be…”.

将文本切分为单词序列:L = […, to, be, or, not, to, be, …]

3.2 文本预处理与词嵌入

文本预处理:

一篇文章可以被简单地看作一串单词序列,甚至是一串字符序列。 我们将 解析文本的常见预处理步骤。 这些步骤通常包括:

1.将文本作为字符串加载到内存中。

2.将字符串切分为词元(如单词和字符)。

3.建立一个字典,将拆分的词元映射到数字索引。

4.将文本转换为数字索引序列,方便模型操作。

文本预处理实例:IMDB

IMDB影评数据集:

文本嵌入:

如何将词映射成向量?-----使用之前所述的独热向量——存在的问题:维数过高

词嵌入(word embedding)——将独热向量映射为低维向量

原始向量:𝑣维;映射后:𝑑维,𝑑 ≪ 𝑣; 映射矩阵:𝑑 × 𝑣,根据训练数据学习得到

理解映射参数矩阵

词嵌入训练效果

3.3 RNN模型

3.3.1 概要

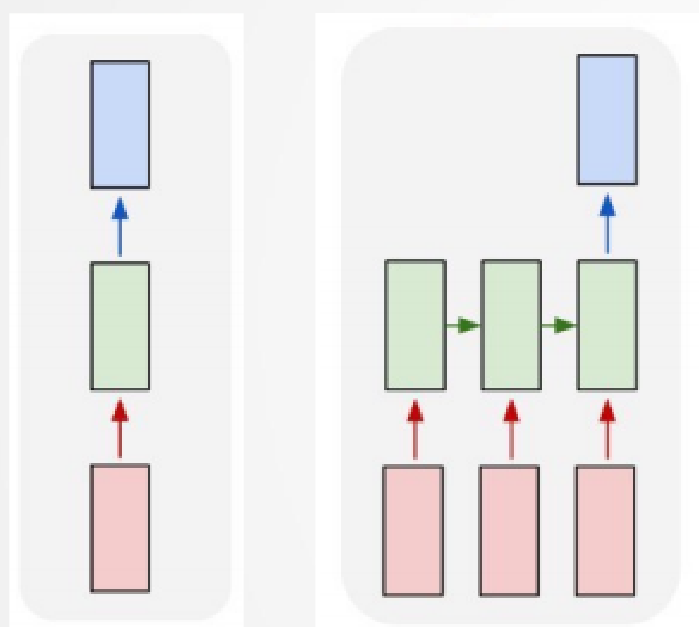

图像分类中使用:1对1模型 文本处理中:输入维度不定,输出维度不定或者是1

输入和输出维度:固定

3.3.2 用RNN建模训练数据

3.3.3 RNN模型

3.3.4 RNN问题

随着输入的增加,会产生“遗忘”问题

3.4 RNN误差反传

每个时间步的隐状态和输出可以写为:![]()

通过一个目标函数在所有𝑇个时间步内 评估输出和对应的标签

之间的差异:

![]()

按照链式法则:

既依赖于

,又依赖于

, 其中

的计算也依赖于

。

因此,用链式法则产生:

![]()

使用下面的公式移除上页中的循环计算:

截断时间步:我们可以在𝜏步后截断上页式中的求和计算

3.4 门控循环单元(GRU)

模型实现:

3.5 长短期记忆网络

LSTM网络模型:

“传送带”: 新引入记忆状态:

遗忘门:

×代表逐元素相乘(点积)

值为0:什么都记不住(0通过)

值为1:全记住(全部通过)

输入门:

计算传送带更新值:

输出门:

更新状态:

参数量:

输入输出和RNN相同:

967

967

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?