阿里BST

论文地址:https://arxiv.org/pdf/1905.06874.pdf

19年阿里这篇推荐论文也是紧贴热点,将Transformer应用到提取用户序列上面,提出Transformer Layer,提取用户序列信息。

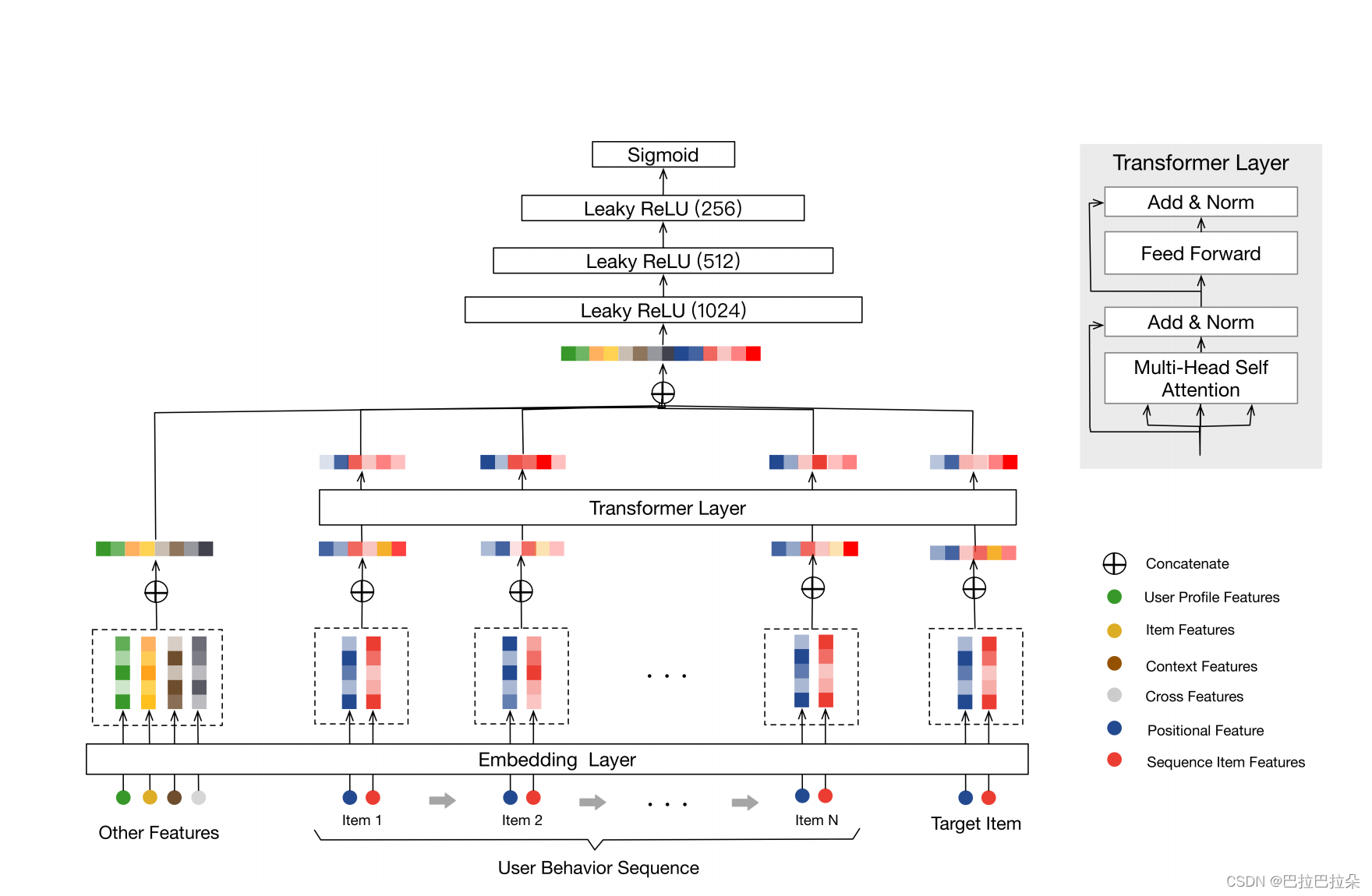

网络结构图如下

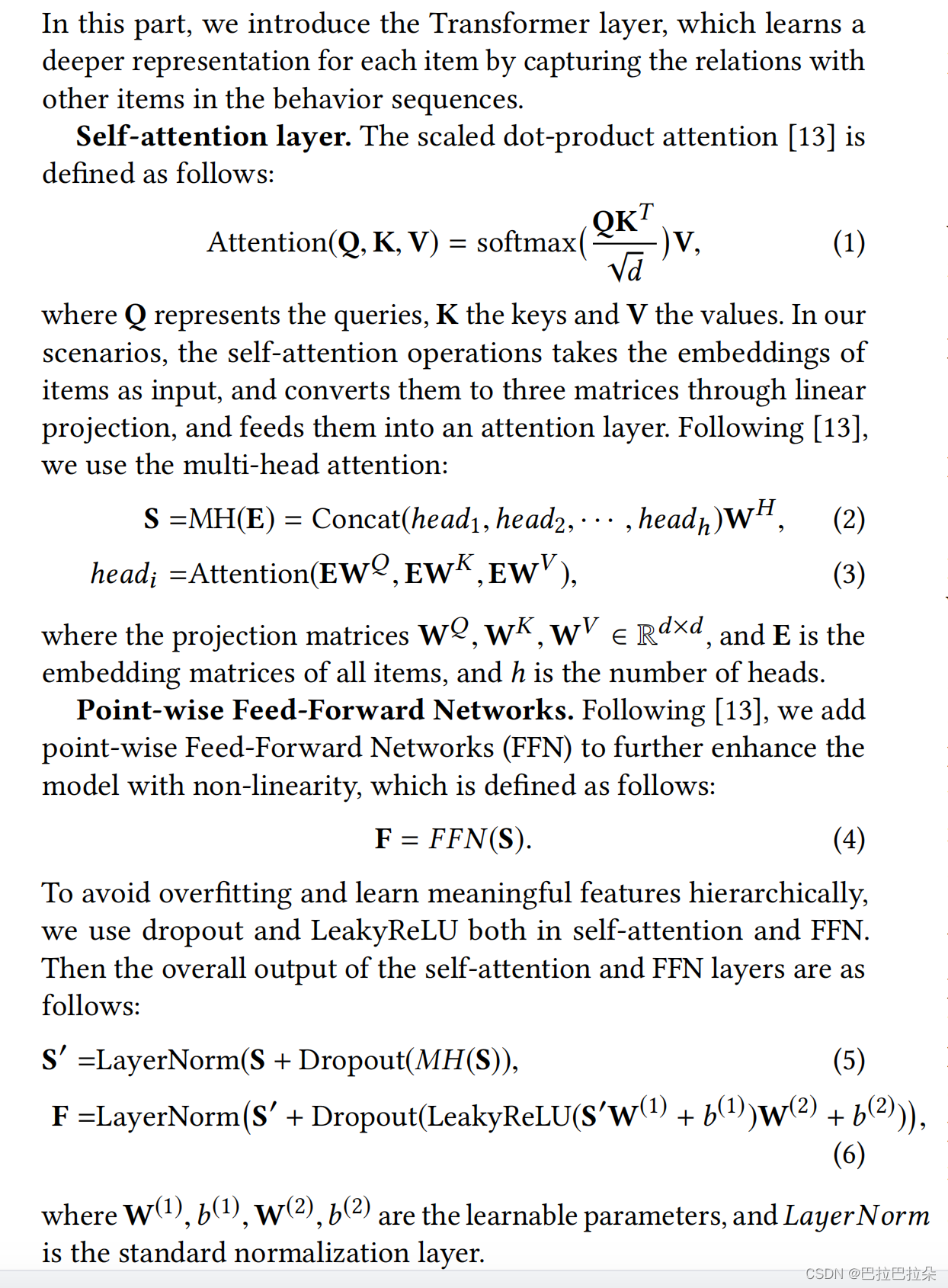

Transformer Layer其实是Transformer的encoder部分

用户序列的输入分为2种,一种叫Sequence Item Features,一种叫Positional Features

Sequence Item Features:包括 item_id 和 category_id

Positional Features:其实就是Transformer position Embedding的输入,item

v

i

v_i

vi的的位置特征值表示为

p

o

s

(

v

i

)

=

t

(

v

t

)

−

t

(

v

i

)

pos(v_i) = t(v_t) - t(v_i)

pos(vi)=t(vt)−t(vi),

t

(

v

t

)

t(v_t)

t(vt)表示当前推荐时间,

t

(

v

i

)

t(v_i)

t(vi)表示点击item

v

i

v_i

vi时间

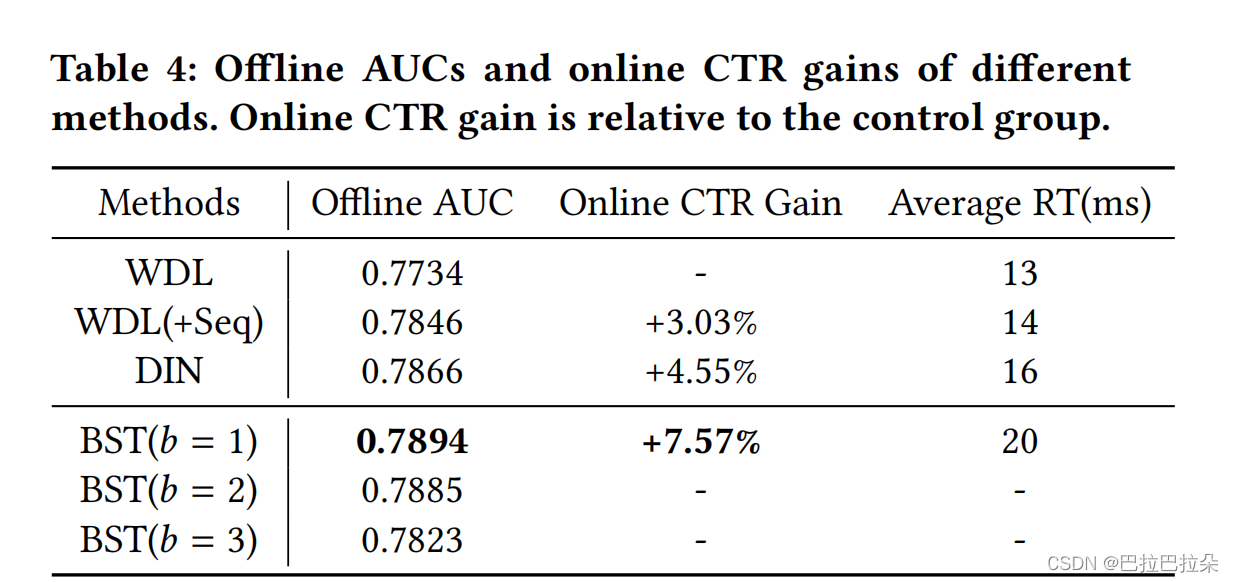

论文还实验了多个Transformer block的效果,发现1个block效果最好,给出的解释是用户序列相比NLP中的句子要简单些,一个block就能学到大部分信息。

加这样的结构比较简单,可以快速在业务中尝试,是个不错的选择

1443

1443

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?