更多资料获取

📚 个人网站:ipengtao.com

在机器学习模型的开发过程中,模型的可解释性变得越来越重要。SHAP(SHapley Additive exPlanations)是一种广泛使用的方法,用于解释模型的预测。通过交叉验证,我们可以确保模型的稳健性和解释结果的可靠性。本文将详细介绍如何在Python中使用交叉验证进行SHAP解释,包括具体的示例代码,帮助理解和应用这一强大的技术。

什么是SHAP

SHAP值是一种基于博弈论的解释方法,通过计算每个特征对预测的贡献度来解释模型的输出。SHAP值提供了一种统一的理论框架,能够解释任何机器学习模型。

SHAP的优点

- 一致性:SHAP值遵循一致性和局部准确性的原则。

- 全局和局部解释:SHAP可以提供单个预测的局部解释,也可以提供特征重要性的全局视图。

- 模型无关性:SHAP适用于任何机器学习模型。

什么是交叉验证

交叉验证是一种评估模型性能的技术,通过将数据集划分为多个互斥子集,轮流用一个子集验证模型,其余子集用于训练模型。常见的交叉验证方法包括K折交叉验证和留一法交叉验证。

交叉验证的优点

- 减小过拟合:通过多个子集的验证,减少了模型的过拟合。

- 更稳定的评估:提供了模型性能的稳定估计,适用于小数据集。

Python中使用交叉验证进行SHAP解释

环境准备

首先,需要安装必要的Python库:

pip install shap scikit-learn

数据准备

使用sklearn中的乳腺癌数据集作为示例数据。

import shap

import numpy as np

from sklearn.datasets import load_breast_cancer

from sklearn.model_selection import train_test_split, KFold

from sklearn.ensemble import RandomForestClassifier

# 加载数据集

data = load_breast_cancer()

X, y = data.data, data.target

# 划分训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.2, random_state=42)

模型训练和SHAP解释

将使用K折交叉验证进行模型训练,并计算每折的SHAP值。

kf = KFold(n_splits=5, shuffle=True, random_state=42)

model = RandomForestClassifier(n_estimators=100, random_state=42)

# 存储所有折的SHAP值

all_shap_values = []

all_expected_values = []

all_X_val = []

# 进行K折交叉验证

for train_index, val_index in kf.split(X_train):

X_train_fold, X_val_fold = X_train[train_index], X_train[val_index]

y_train_fold, y_val_fold = y_train[train_index], y_train[val_index]

# 训练模型

model.fit(X_train_fold, y_train_fold)

# 计算SHAP值

explainer = shap.TreeExplainer(model)

shap_values = explainer.shap_values(X_val_fold)

# 存储结果

all_shap_values.append(shap_values)

all_expected_values.append(explainer.expected_value)

all_X_val.append(X_val_fold)

# 合并所有折的结果

shap_values = np.concatenate(all_shap_values, axis=1)

expected_values = np.mean(all_expected_values, axis=0)

X_val = np.concatenate(all_X_val, axis=0)

可视化SHAP值

使用SHAP库中的绘图功能来可视化解释结果。

# 绘制单个预测的SHAP值

shap.initjs()

shap.force_plot(expected_values[1], shap_values[1][0], X_val[0], feature_names=data.feature_names)

# 绘制特征重要性

shap.summary_plot(shap_values[1], X_val, feature_names=data.feature_names)

# 绘制单个特征的SHAP值

shap.dependence_plot("mean radius", shap_values[1], X_val, feature_names=data.feature_names)

总结

本文详细介绍了如何在Python中使用交叉验证进行SHAP解释。通过结合交叉验证和SHAP,能够更好地评估和解释机器学习模型的稳定性和预测结果。具体步骤包括加载和准备数据、进行K折交叉验证训练模型、计算每折的SHAP值以及最终合并和可视化SHAP解释结果。使用SHAP值可以提供模型预测的全局和局部解释,提高模型的可解释性和可信度。通过这些方法,数据科学家和工程师能够更深入地了解模型的行为,提升模型在实际应用中的表现。

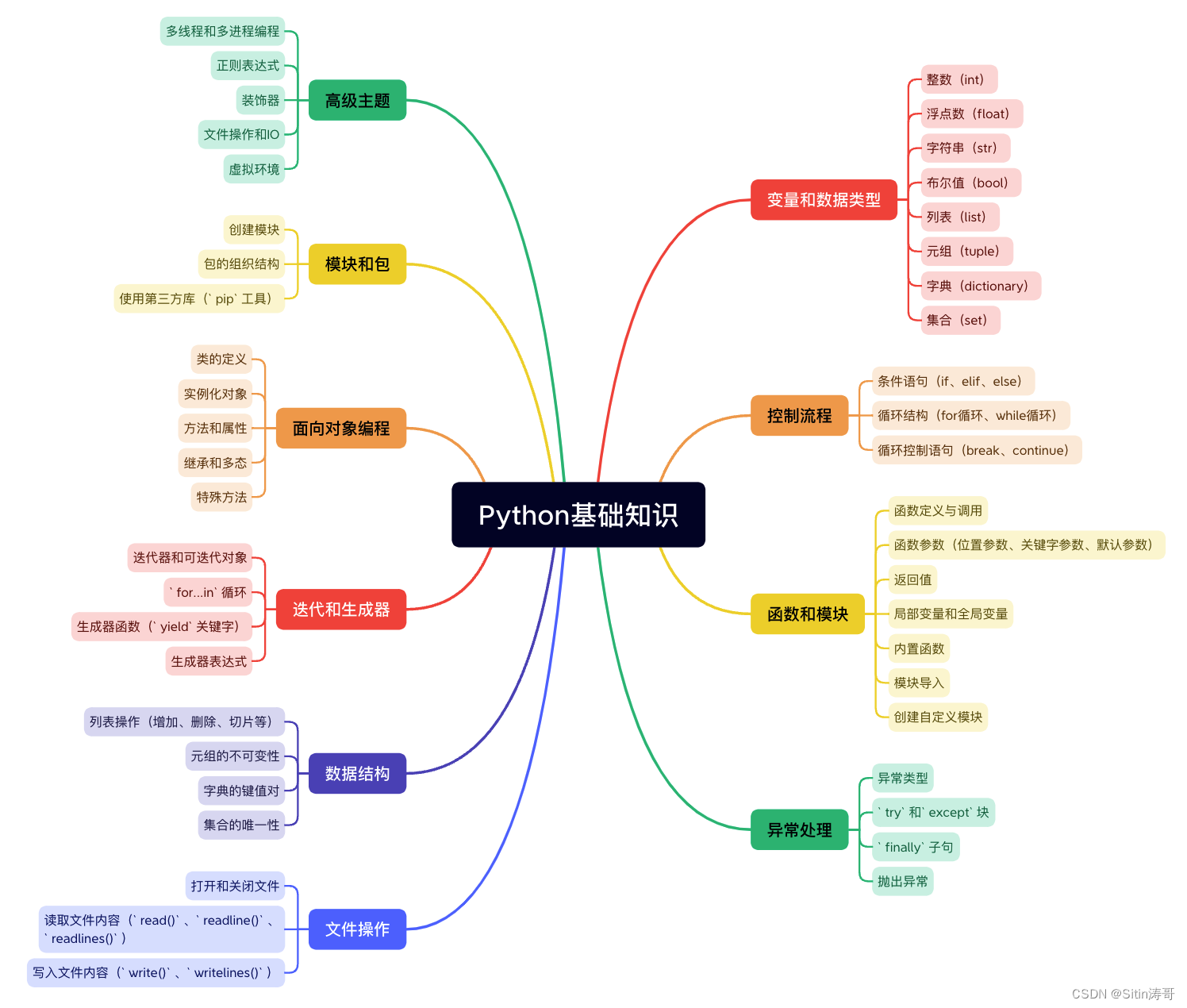

Python学习路线

更多资料获取

📚 个人网站:ipengtao.com

如果还想要领取更多更丰富的资料,可以点击文章下方名片,回复【优质资料】,即可获取 全方位学习资料包。

点击文章下方链接卡片,回复【优质资料】,可直接领取资料大礼包。

180

180

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?