目录

摘要

在本文中,我们研究了用于用户意图检测的少数快照多标签分类。对于多标签意图检测,最新的工作估计了标签实例相关性得分并使用阈值来选择帐篷标签中的多个相关标签。要确定适当的阈值,只需一个举几个例子,我们首先学习数据丰富域上的通用阈值体验,然后将阈值调整为某些基于非参数学习的校准的少数镜头域。为了更好地计算标签实例关联性得分,我们将标签名称嵌入作为表示空间中的一个关键点,从而细化了不同类别的表示,使其彼此很好地分离。在两个数据集上的实验表明,提出的模型一次都明显优于强基准和5-shot设置。

介绍

意图检测,面向任务的基本组成部分对话系统(Young等人,2013年)作为多标签分类(MLC)问题越来越受到关注(Xu and Sarikaya 2013; Qin et al.2020),因为单个ut通常会携带多个用户意图(请参见图。1)。在现实情况下,意图检测通常会遭受损失缺乏培训数据,因为对话任务/领域瞬息万变,新域通常只包含少数几个数据示例。少量学习(FSL)的近期成功提出了一种解决此类数据稀缺挑战的有前途的解决方案。它提供了更像人类的学习范例仅从几个学习示例中得出结论(通常是每堂课一个或两个)。

针对基于阈值的策略进行多标签意图检测的最新技术,其中一种常见做法是估计标签实例相关性得分并选择得分高于阈值(Xu等。 2017; Gangadharaiah和Narayanaswamy 2019;秦等。 2020)。通常,协调和各自的质量这两个模块中的一个,即阈值和相关性评分,对于MLC模型的性能至关重要。然而,在少数情况下,这种多标签设置对阈值估计和标签实例都构成了独特的挑战相关性评分。

对于阈值化,以前的工作探索调整固定门槛(Gangadharaiah and Narayanaswamy 2019; Qin等。 2020)或从数据中学习阈值(Xu et al.2017)。但是,仅当学习示例就足够时,这些阈值才能很好地起作用。在少数情况下,很难仅举几个例子来确定适当的阈值。此外,也很难直接转移预先学习的由于域差异(例如差异)而导致的阈值每个实例的标签编号,得分密度和等级。

标签实例相关性分数的估计也是具有挑战性的。快速学习取得了令人印象深刻的成绩基于相似度的方法取得了进展(Vinyals等人2016;Bao等。 2020年),其中相关性得分可以作为标签-实例相似性进行建模。可以从相应的支持示例中获得标签表示。不幸的是,尽管在先前的单标签任务中取得了巨大的成功,但是这些基于相似度的方法对于多标签问题却变得不切实际。当实例有多个标签,可以获得不同标签的表示来自相同的支持示例,并与彼此。对于图1的示例,查询时间的意图和查询loc共享相同的支持示例x1,因此标签具有相同的表示形式,因此无法预测具有相似性得分的正确标签。

在本文中,我们研究了少数的学习问题多标签意图检测并提出新框架应对阈值和标签实例相关性评分的挑战。

为了用有限的例子解决先验知识转移和领域适应的门槛困难,我们提出元校准阈值(MCT)机制首先学习有关数据丰富域的通用阈值处理经验,然后将阈值调整为适用于某些镜头域基于内核回归的校准。这样通用训练和领域特定校准的结合允许使用先前的领域来估计阈值经验和新领域知识。

应对混淆的标签表示的挑战在相关性评分中,我们建议使用锚定标签表示(ALR)来获得分隔良好的标签表示。受到将标签名称作为嵌入点来完善表示空间的想法的启发(Wang等人2018),ALR使用标签名称的嵌入作为附加杂项,并使用支持示例和相应的锚点表示每个标签。与以前使用标签嵌入的单标签意图检测不同作为其他功能(Chen,Hakkani-Tur和He 2016),我们的标签嵌入在这里具有独特的分离效果公制空间中的不同标签。

最后,为了鼓励脱粒处理和标签实例相关性评分之间的更好协调,我们引入自动适应MCT的Logit适应机制使阈值适应不同的分数密度。

在两个数据集上的实验表明,我们的方法明显优于强基准。我们的贡献是概括如下:(1)我们探索了面向任务的对话的意图检测中的少数多标签问题,这也是少量样本多标签的早期尝试分类。 (2)我们提出了一种具有内核回归和Logits自适应的元校准阈值旧机制使用先前的域经验来估计阈值和新的领域知识。 (3)介绍锚定标签表示可获取分隔良好的标签表示,以实现更好的标签实例相关性评分。

概念和初步

为了便于理解,我们简要介绍一下多标签分类和少量学习。

多标签分类

多标签任务研究分类问题,其中每个实例都同时带有一组标签。假设X表示实例空间,并且Y = {y1,y2,。 。 。 ,yN}表示具有N个可能标签的标签空间。多标签任务从中学习函数h(·):X→2Y多标签训练数据T = {(xi,Yi)} NT i,其中NT是数据集的大小。对于每个学习示例(xi,Yi),xi∈X是l维输入,Y i⊆Y是对应的标签集。然后对于一个看不见的实例x,分类器预测Y = h(x)⊆Y作为关联的标签集。

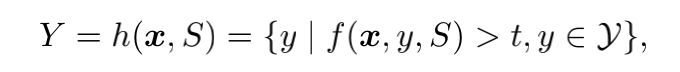

在大多数情况下(Zhang and Zhou 2013),多标签模型学习一个实值函数f:X→Y. f(x,y)计算标签实例相关性得分,反映了标签y∈Y的证据是x的正确标签。然后多标签分类器的推导为h(x)= {y | f(x,y)>t,y∈Y},其中t是阈值。

少样本学习

很少的学习可以提取以前的经验,从而使快速适应新任务(Finn 2018)。学到的先验经验通常包括针对不同领域和任务的通用元知识,例如相似性度量和模型建筑。在新任务上,很少有人使用这些模型先验知识和一些带有标签的示例(支持集)预测看不见的物品(查询)的类别。

很少有学习是基于相似度的方法,通常首先在一组模型上训练模型源域(任务){D1,D2 ... 。 。},然后直接进行另一组看不见的目标域(任务){D01,D02,。 。 。}无需微调。在每个目标域上,给出一个查询x,模型通过观察a来预测相应的标签y

标记支持集S = {(xi,yi)} NS i = 1。 S通常包括kN个标签(N向)中每个标签的示例(K幅)。

对于少量的多标签意图检测,我们定义每个用单词序列查询实例作为用户话语x =(x1,x2,...,xl)。而不是预测单个标签,模型预测一组意图标签Y = {y1,y2,。 。 。 ,ym}多标签支持集S = {(xi,Yi)} NS i = 1

方法

在本节中,我们首先介绍框架的概述,然后介绍拟议的Meta Calibrated阈值和锚定标签表示。在最后,我们介绍了如何优化整个框架。

我们的框架的工作流程如图2所示:看不见的查询话语和带有标签的支持集,我们首先从支持集中收集每个标签的表示,并计算与句子标签相似度的标签实例相关性得分。然后我们使用阈值将其二分将标签空间分为相关和不相关的标签集。在里面在MTF框架中,MCT有助于在少数情况下估计合理的阈值,而ALR提供了分隔良好的标签表示形式。

少样本多标签的拟议框架意图检测

我们定义了少样本多标签分类(MLC)与前述的普通MLC类似。给定一个查询句子x和支持集S,我们的框架预测关联标签集Y为:

其中f计算标签实例相关性得分,t为阈值。

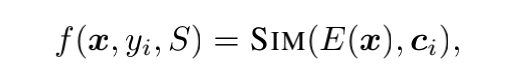

为了实现一次多标签分类,我们采用了基于流行的基于相似度的方法来计算标签实例的相关性得分。

首先,我们从支持集S。假设ci是yi标签的代表矢量,我们计算查询之间的相关性得分x句子和yi标签如下:

其中E(·)是嵌入函数。 SIM是相似的函数,并且我们使用点积相似度。我们采用BERT(Devlin et al.2019)作为嵌入者,句子嵌入E(x)计算为平均嵌入其令牌。为了获得分隔良好的标签表示,我们采用锚定标签表示法获取ci。

然后,我们估算一个阈值t来自源域的先验知识和对目标域中的示例。为此,我们建议元校准阈值以估计阈值t。

元校准阈值

在本节中,我们介绍了一种针对少数样本学习设置的阈值方法。在几次学习设置中,模型经过不同领域的培训和测试,通常阈值选择的不同偏好。此外,它是必须用不同的阈值标记每个实例,因为实例的标签数量和标签实例相关性分数的密度不同。

为此,我们首先学习一个领域通用元阈值,然后对其进行校准以适应目标主要和特定查询。

具有Logits自适应性的元阈值

达到领域一般阈值,我们提出一个元阈值具有自动适应性并共同优化的在各个领域。

对于自动适应性,我们提出了用于元阈值的Logit自适应机制,该机制可自动将阈值适应于特定查询和域。具体来说,考虑到实例在相关分数的规模/密度和阈值总是在最高和最低分数之间,我们建议将阈值设置为最大值的插值和最低分数:

其中T(·)是阈值函数,r是在源域中学习的插值率。图3,此类基于插值的阈值因不同而有所不同通过适应标签实例的不同密度进行查询相关性得分,并且比固定阈值更笼统。

此外,Logit-Adaptive机制还可以更好地促进阈值和相关性评分之间的协调。

带内核回归的阈值校准

直到现在,我们学习了Meta Threshold ,这对于各个领域,但缺乏特定领域的知识。至对此进行补救,我们估计特定于域/查询的阈值通过观察支撑装置进行测试,并使用测试来校准元阈值。但是,由于缺少黄金阈值,很难直接学习模型进行估计阈值。因此,我们转向估计标签的数量并间接推导出阈值。

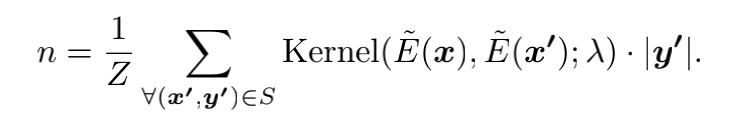

为了估计具有特定领域知识边缘的标签号,我们采用了内核回归(KR)(Nadaraya 1964)并根据其查询来估计查询的标签号支持示例的相似性。作为非参数方法,KR可以在不可见的域上工作而无需调整。比较一下到其他非参数回归方法,例如KNN

回归,KR允许使用所有支持示例并考虑距离的影响。

形式上,给定支持集S,我们估计标签查询x的数字n作为支持示例的加权平均标签数,其中权重计算为查询和支持示例之间的内核相似性:

在这里,Z是归一化因子,我们使用高斯核:Kernel(a,b;λ)= exp((((aab)2/2 /λ),其中λ是带宽因子。返回特征的特征提取器与句子x的标签号相关的向量。为了本文的意图检测任务,我们考虑语言学与句子的意图数量有关的特征,包括句子长度,连词数量,谓词数量,标点符号,疑问代词数量并对其进行编码具有MLP投影层的特征.

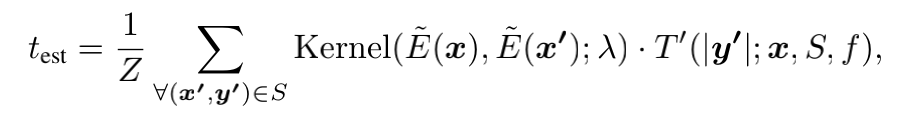

然后,我们导出特定于域/查询的阈值测试从估计的标签号n。具体来说,我们发现阈值测试,筛选出x的前n个标签实例相关分数。一种直观的想法是直接使用(n +1)个最大分数作为阈值。但是,这样的门槛是仅从一个标签实例相关性得分得出。所以我们通过使用学习的内核权重直接估计阈值,进一步改进它以利用所有相关分数:

其中T'(n; x,S,f)是返回第(n + 1)个函数查询x的最大标签实例相关性得分。

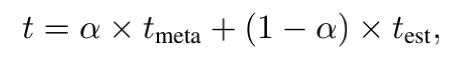

最后,我们使用特定于查询的阈值测试进行校准域一般的元阈值 。最终门槛对于查询x,其计算公式如下:

其中α是衡量...的重要性的超参数先前的阈值处理经验。

锚定标签表示

标签表示对于标签实例相关分数至关重要。获得高质量的标签实例相似性建模时,标签表示应(1)分开良好(2)能够充分表达语义,形成相应类别。

少量学习的标签表示

对于少量镜头学习,主要获得标签表示从支持集示例。最经典的想法之一是获得每个类别的原型表示作为标签表示(Snell,Swersky和Zemel 2017)。以及yi的原型表示计算为支持示例的平均嵌入:ci = 1Mi PMi j E(xj),其中每个xj∈{x | (x,Y)∈S∧yi∈Y}是标有yi的支撑实例和Mi是个支持集S中此类实例的总数。

这样的标签表示对标签之间的可分离性没有约束。此外,在多标签设置中,不同的标签可以共享相同的支持示例。这个可以导致标签表示之间的混淆和歧义。

用锚表示标签

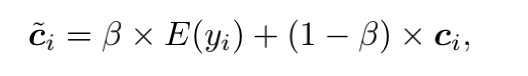

因为仅通过支持示例获得bel表示会带来很多麻烦,所以我们建议另外使用标签特定锚点,强调不同类别之间的差异。标签名称通常很自然彼此分开并包含良好的表达类别特定语义的定义(Wang等人2018)。因此,直观地讲,我们使用标签名称的语义嵌入作为锚,并使用锚和支撑示例代表每个标签。易标签,我们使用插值因子β计算锚定的bel表示c〜i:

这里ci是通过获得的原型表示支持实例。在这里,标签名称嵌入E(yi)动作作为原型表示向量的偏差。这个允许标签表示彼此分离并更好地描述类别语义。

优化

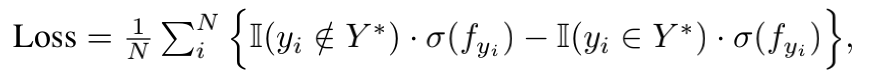

跟随Vinyals等。 (2016),我们通过一系列镜头少的学习情节训练了MLC框架,其中每个情节都包含一些镜头支持集和一个查询集。在数据丰富的域上模拟少数情况,可确保训练和少数测试之间的一致性。另外,该框架还针对不同的领域进行了优化,这鼓励了元阈值tmeta和标签-实例相关性评分函数f是领域通用的。我们采用了S型交叉熵损失(Cui等。2019年)以进行MLC培训:

其中N是可能标签的数量,fyi = f(x,yi,S)。 Y *是黄金标签集。 I(·)是一个指标4σ是Sigmoid函数。由于选择带有标签编号的阈值的不可区分的过程,我们在整个框架之前对内核参数进行预训练学习过程,即带宽和MLP投影层,在源域上丢失了MLE(nest,ngold)。

这是一个元学习过程,用于学习元参数(元阈值,内核回归,相似度计算),以改善未见的少量任务的非参数学习,也就是学习。

实验

我们对1-shot/5-shot设置的多标签意图检测任务进行评估,该任务可以转移知识从源域(培训)到看不见的目标域(测试)仅包含1-shot/5-shot支持集。

数据集

我们对公共数据集进行实验TourSG(Williams等,2012),并引入了一个新的多意图数据集StanfordLU。这两个数据集包含多个区域,因此可以模拟看不见的区域的少数情况。 TourSG(DSTC-4)包含25,751带有多种对话行为的注释和有关新加坡旅游信息的6个单独领域的注释:行程(It),住宿(Ac),景点(At),食物(Fo),交通(Tr),购物(Sh)。 StanfordLU是斯坦福大学对话数据集的重新注释版本(Eric et al。2017)包含来自3个域的8,038个用户讲话:时间表(Sc),导航(Na),天气(We)。我们重新注释每个带有意图标签的话语,不包含在其中原始数据集。

少样本数据构建

模拟情况下,我们将数据集重建为几次学习表格,其中每个样本都是立场查询(xq,yq)和相应的K-shot支持集S的组合。表1显示了实验数据的概述。

与单标签分类问题不同,多标签实例与多个标签相关联。在那里,我们不能保证每个标签都会出现K次在抽样支持语句时。为了解决这个问题,我们用最小包含算法(Hou et al.2020)。它通常根据以下两个标准来构建支持集:(1)全部

域中的标签在S中至少出现K次。(2)至少一个标签在S中出现的次数少于K次(x,y)对已从其中移除。

对于每个域,我们采样Ns个不同的K-shot支持端口集。然后,对于每个支持集,我们对Nq个不包含的话语进行抽样作为查询(查询集)。每个支持查询集对构成一个镜头集。最终,我们获取每个域的Ns集和Ns×Nq个样本。

对于TourSG,我们为每组构建100个镜头集源域和每个目标的50个少拍集确实很重要。并且查询集大小为16。因为StanfordLU具有较少的域,我们为每个域构建200个镜头集源域和每个目标的50个少拍集确实很重要。查询集大小为32。

评价

在少样本下进行可靠的评估设置,我们会交叉验证不同域上的模型。每次,我们选择一个目标域进行测试,一个主要域进行开发,并使用相同的其余域数据集作为训练的源域。

在目标域上测试模型时,我们会评估每个镜头几次情节中的微F1得分。然后,我们将所有情节的F1分数平均作为最终结果以应对支持集的随机性。控制神经网络训练的不确定性(Reimers和Gurevych2017年),我们报告了5个随机种子的平均得分。

实践

对于句子嵌入和标签名称,我们对预训练语言模型提供的令牌嵌入进行平均,然后使用Electra-small(Clark等人2020)以及此处未装箱的BERT-Base(Devlin等人,2019)。除了,我们采用双明智嵌入(Hou等。 2020)和逐步解冻(Howard and Ruder

2018)。我们使用ADAM(Kingma and Ba 2015)来训练批量大小为4的模型。两者的学习率均设置为1e-5我们的模型和基准模型。我们将α(等式1)设置为0.3并考虑标签名称具有不同数据集和支持集大小的取材能力,请在{0.1,0.5,0.9}中更改β(公式2)。对于内核回归的MLP,我们采用ReLU作为激活函数,并更改{1、2、3}和隐藏层{5,10,20}中的尺寸。最佳超参数在开发领域中确定。

Baselines

我们将模型与两种强基准进行比较:基于微调的转移学习方法(TransferM)和基于相似度的FSL方法(MPN和MMN)。

TransferM是具有大型预训练语言模型和多标签分类层的域传输模型。按照流行的MLC设置,我们使用固定的阈值调整开发集。我们在源域上对其进行预训练,并在开发集上选择最佳模型。我们应对不匹配通过重新训练针对不同领域的分类层来确定标签集。在目标域上,模型在支持集上进行了微调。

多标签原型网络(MPN)是相似的基于句子计算的短镜头学习模型原型网络的相关性得分(Snell,Swersky,和Zemel 2017),并使用针对开发人员调整的固定阈值组。它在源域上进行了预培训,可以直接工作在目标域上进行微调.

多标签匹配网络(MMN)完全相同作为MPN,但使用了Matching Network(Vinyals等。2016)。

主要结果

在这里,我们在1-shot/5-shot的多标签意图检测。

1-shot的结果

表2显示了1-的结果拍摄多标签意图检测。每列分别显示以某个域为主要目标(测试)并以其他域为源域(train&dev)的F1分数。使用BERT嵌入时,我们的模型优于TourSG的平均F1分数(39.57分)最强和斯坦福大学数据集上的10.45。我们对TourSG的改进比StanfordLU上的要高得多。我们发现差距主要来自标签集特征的差异对两个数据集进行分析。

BERT在现实世界的应用程序中有时在计算上过于昂贵。因此,我们还使用更浅的Electra-small嵌入来评估模型性能。只有1400万参数,比BERT的110M小得多。同样,我们的模型通过Elec tra达到了最佳性能。有趣的是,我们基于Electra的模型甚至比

所有的基线都使用BERT,这在计算资源有限的情况。

与传统的基于转移的方法相比(TransferM),所有非基于优化的方法(Ours,MPN和MMN)在StanfordLU数据集上获得了巨大的改进。这主要是由于非微调在过拟合阻力方面的优势。对于TourSG,领域差距较低,不同域的标签相似,使传输源域参数更加容易。如结果,TransferM在性能上比MPN稍好TourSG。相反,我们的模型在两种类型的数据集,都反映了模型的多功能性。

我们的模型可以看作是MPN + ALR + MCT。从而,MPN,MPN + ALR和Ours之间的逐步增长演示了ALR和MCT的有效性。

5-shot的结果

表3显示了5的结果镜头实验。结果与总体趋势中的1发设置一致。我们的方法可实现最佳性能。通过比较1发和5发的结果,我们发现我们的1发模型能够胜过大多数5发基线。这表明我们的模型可以更好地利用经验并减少对支持示例的依赖。

分析

消融测试

了解每个人的贡献框架组件,我们进行1-shot/5-shot消融表4中的Electra嵌入进行了研究。删除两个主要组件:锚定标签表示(ALR)和元校准阈值(MCT)。

删除ALR后,我们用仅从支持示例构建的原型嵌入。尤其是在F1成绩大幅下降方面TourSG。一方面,TourSG在不同的域中具有相似的标签,这大大有利于标签嵌入学习ALR。另一方面,没有ALR的模型通常会被同时出现的意图所混淆,例如“谢谢”和“

“确认”,可以使用ALR轻松分隔。

对于不带MCT的模型,我们使用在源域上调整过的原始阈值。我们发现,MCT对5镜头设置有更多影响。这是因为logits适应和MCT的KR校准利用了特定对象之间的关系查询和支持集,从而使模型受益从更多的支持示例中。

通过比较镜头数量对ALR和MCT,我们发现我们的框架达到了平衡,因为它的两个组成部分分别擅长转移环先验知识和开发领域知识。

元校准阈值的成分分析

我们将进一步分解MCT,并查看三个子组件的贡献。

删除Logits-Adapting时,我们将单个可学习值用作元阈值。性能下降表明Logits-Adaptiving阈值可提供更好的性能概括性高于传统阈值。

如果我们删除阈值的元学习,我们将替换具有固定Logits-Adapting阈值的meta阈值,以及无需学习内核中的元参数即可对其进行校准回归。我们将性能损失归因于以下事实:元学习过程提供了先验经验,可以有效地帮助目标域的非参数学习。

对于没有KR校准的模型,我们直接使用meta阈值预测标签。分数下降表明通过使阈值适应不同的域可以帮助进行校准。TourSG的下降是有限的,因为TourSG很小,即使没有校准,从源干线上学到的元阈值通常也足够好。

标签编号精度分析

为了了解阈值模块的作用,我们进行了准确性分析模型是否可以预测正确的标签数量。如表6显示,当添加Meta Threshold和KR校准时,我们可以观察到标签编号准确性的持续提高。这表明Meta Threshold和KR校准可以极大地帮助模型确定合适的标签号。

相关工作

通常,多标签分类(MLC)方法依赖于预测多个标签的阈值。对于MLC问题NLP,Wu,熊和王(2019)利用元学习估算数据丰富设置的阈值。对于意图检测的阈值,可以使用Gangadharaiah和Narayanaswamy(2019)在意图可能性上利用固定的阈值。许等。 (2017)通过线性回归学习阈值。

没有阈值,MLC的一种解决方案是标签电源设置(LP)(Tsoumakas,Katakis和Vlahavas 2010; Tsoumakas(Vlahavas 2007),将多个标签的组合视为一个标签。 Xu和Sarikaya(2013)探索LP在多标签意图检测中的想法。但是,LP经常由于标签组合而遭受数据稀疏的困扰在数据丰富的设置中。除了LP之外,Kim,Ryu和Lee(2017)建议从单一学习多目标检测意向数据。他们首先检测子句,然后预测子句的单一意图。但是,他们的方法是有限的通过数据中的显式连接,很难学会在连拍设定中检测子句。

NLP中的少量学习已被广泛探索用于单标签分类任务,包括文本分类(Sun et al.2019; Geng et al.2019; Yan,Zheng和Cao2018; Yu等。 2018; Bao等。 2020年; Vlasov,Drissner Schmid和Nichol 2018),关系分类(Lv等。2019;高等。 2019; Ye and Ling 2019),序列标记(Hou et al.2020)。但是,很少研究多标签问题。以前的作品集中在计算机上视觉(Xiang等人2019; Alfassy等人2019)和信号处理(Cheng,Chou和Yang 2019)。 Rios和Kavu luru(2018)研究了针对医学文本的少数镜头MLC。但,他们的方法需要标签的描述和EMR结构,这些信息通常很难获得,而在我们的手册中却找不到任务。对于标签名称语义的使用,已被证明有效解决两个插槽填充的数据短缺问题(Bapna et al.2017; Lee and Jha 2019; Shah et al.2019; Hou等。 2020)和意图检测(Xia et al.2020; Krone,Zhang和Diab 2020; Chen,Hakkani-Tur和He,2016年)。 ¨我们的方法具有类似的想法,但引入它来解决多标签设置的特殊挑战。

结论

在本文中,我们探索了少数的学习问题。多标签意图检测。为了仅使用几个支持示例来估计合理的脱粒时间,我们提出了Meta校准阈值可自适应地结合先前的经验和特定领域的知识。为了在几次拍摄的情况下获得标签实例的相关性评分,我们引入了基于锚定标签的基于度量学习的方法表示。它为标签实例相似度计算提供了分隔良好的标签表示。实验结果验证了Meta校准阈值和锚定标签表示可以改善几率多标签意图检测。

附表

1477

1477

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?