理论:

1.网络优化

递度下降: 批量递度下降(BGD)、随机梯度下降(SGD)、小批量递度下降(MBGD)

批量递度下降(BGD):

优点:

- 一次迭代是对所有样本进行计算,此时利用矩阵进行操作,实现了并行。

- 由全数据集确定的方向能够更好地代表样本总体,从而更准确地朝向极值所在的方向。当目标函数为凸函数时,BGD一定能够得到全局最优。

缺点:

- 当样本数目 m 很大时,每迭代一步都需要对所有样本计算,训练过程会很慢。

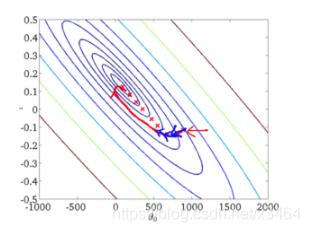

从迭代的次数上来看,BGD迭代的次数相对较少。其迭代的收敛曲线示意图可以表示如下:

随机梯度下降:

随机梯度下降法不同于批量梯度下降,随机梯度下降是每次迭代使用一个样本来对参数进行更新。使得训练速度加快。

优点:

- 由于不是在全部训练数据上的损失函数,而是在每轮迭代中,随机优化某一条训练数据上的损失函数,这样每一轮参数的更新速度大大加快。

缺点:

- 准确度下降。由于即使在目标函数为强凸函数的情况下,SGD仍旧无法做到线性收敛。

- 可能会收敛到局部最优,由于单个样本并不能代表全体样本的趋势。

- 不易于并行实现。

小批量递度下降:

小批量梯度下降,是对批量梯度下降以及随机梯度下降的一个折中办法。其思想是:每次迭代 使用 ** batch_size** 个样本来对参数进行更新。

优点:

- 通过矩阵运算,每次在一个batch上优化神经网络参数并不会比单个数据慢太多。

- 每次使用一个batch可以大大减小收敛所需要的迭代次数,同时可以使收敛到的结果更加接近梯度下降的效果。(比如上例中的30W,设置batch_size=100时,需要迭代3000次,远小于SGD的30W次)

- 可实现并行化。

缺点:

- batch_size的不当选择可能会带来一些问题。

batch_size的选择带来的影响:

- 在合理地范围内,增大batch_size的好处:

- 内存利用率提高了,大矩阵乘法的并行化效率提高。

- 跑完一次 epoch(全数据集)所需的迭代次数减少,对于相同数据量的处理速度进一步加快。

- 在一定范围内,一般来说 Batch_Size 越大,其确定的下降方向越准,引起训练震荡越小。

- 盲目增大batch_size的坏处:

- 内存利用率提高了,但是内存容量可能撑不住了。

- 跑完一次 epoch(全数据集)所需的迭代次数减少,要想达到相同的精度,其所花费的时间大大增加了,从而对参数的修正也就显得更加缓慢。

- Batch_Size 增大到一定程度,其确定的下降方向已经基本不再变化。

学习率衰减

https://zhuanlan.zhihu.com/p/93624972

随时间慢慢减少学习率来加快学习算法

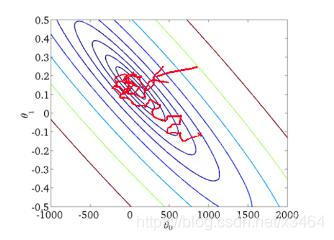

在使用mini-batch梯度下降法时,mini-batch数量不大,大概64或者128个样本,在迭代过程中会有噪音(蓝色线),下降朝向最小值,但是不会精确地收敛,所以你的算法最后在附近摆动,并不会真正收敛,因为你用的α是固定值,不同的mini-batch中有噪音。

但要慢慢减少学习率α的话,在初期的时候,α学习率还较大,你的学习还是相对较快,但随着α变小,你的步伐也会变慢变小,所以最后你的曲线(绿色线)会在最小值附近的一小块区域里摆动,

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

32万+

32万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?