第 11 章

在线与离线智能体自我改进

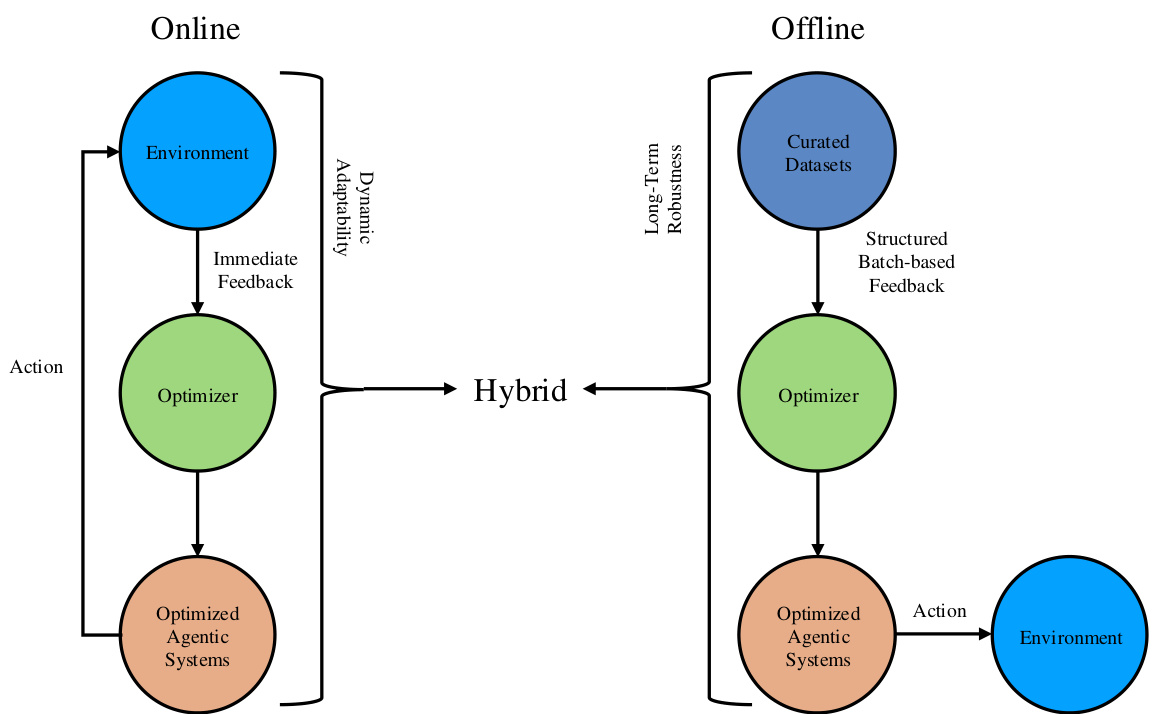

在追求自我改进的过程中,智能体利用优化,既作为一种精炼个体组件(如提示设计、工作流编排、工具利用、奖励函数调整,甚至优化算法本身)的机制,也作为一个战略框架,确保这些个体改进朝向一致的性能提升方向对齐。例如,孤立地优化奖励函数和提示设计可能会产生冲突的结果,但战略性方法会协调这些优化,以保持一致性并最大化整体效能。我们将自我进化分为两种主要范式:在线自我改进和离线自我改进。此外,我们还探讨了整合这两种方法以最大化效率和适应性的混合优化策略。

11.1 在线智能体自我改进

在线自我改进指的是实时优化,其中智能体根据即时反馈动态调整其行为。这种范式确保智能体对不断变化的环境保持响应,通过在迭代反馈循环中持续优化关键性能指标——例如任务成功率、延迟、成本和稳定性。在线自我改进在需要动态适应性的应用中尤其有效,例如实时决策、个性化用户交互和自动化推理系统。在线自我改进中的关键优化策略可分为以下四类:迭代反馈与自我反思、多智能体系统中的主动探索、实时奖励塑造和动态参数调整。

迭代反馈与自我反思 这些方法论 [48, 67, 72, 70, 847, 47] 专注于使智能体能够迭代地批判和改进其自身的输出。Reflexion [48]、Self-Refine [67] 和 Tree of Thoughts [72] 引入了自我批判循环,模型在其中实时识别错误并提出修订。ReAct [70] 将思维链“推理”与“行动”相结合,允许模型在观察到外部反馈后迭代地修正步骤。此外,其他方法要么依赖于自洽性 [78] 来选择最一致的解决方案,要么利用过程奖励模型 (PRM) Lightman et al. [847] 从候选方案中选择最佳解决方案。总的来说,这些框架减少了错误传播并支持快速适应,无需单独的离线微调周期。

多智能体系统中的主动探索 这些方法 [626, 848, 627, 152] 在多智能体系统中主动探索并动态搜索新模式和工作流改进。MetaGPT [626]、CAMEL [848] 和 ChatDev [627] 展示了多角色或多智能体生态系统,它们实时交互,交换持续反馈以改进彼此的贡献。类似地,HuggingGPT [152] 通过一个中央大语言模型控制器协调(托管在 Hugging Face 上的)专门模型,该控制器动态路由任务并收集反馈。这些协作策略进一步突显了智能体之间的在线更新如何能够逐步改进集体成果。

实时奖励塑造 一些框架 [731, 91, 105, 849] 不仅整合即时反馈信号来纠正错误,而且还用其来调整内部奖励函数和策略,而不是依赖固定或纯粹离线的奖励规范。这实现了自我适应的奖励校准,平衡了性能、计算成本和延迟之间的权衡,允许智能体根据用户交互动态优化奖励机制。

图 11.1:在线、离线和混合自我改进三种不同应用场景下的自我改进示意图。

动态参数调整 在此类别中,智能体实时自主更新其内部参数(包括提示模板、工具调用阈值、搜索启发式等),利用无梯度或近似梯度方法。这些更新优化了计算效率和决策准确性,从而能够无缝适应不断变化的环境。Self-Steering Optimization (SSO) [850] 消除了手动标注的需求,并在迭代训练期间通过自主生成偏好信号来保持信号准确性,同时维持在策略训练。

在线自我改进促进了一个持续演进的智能体框架,其中学习嵌入在任务执行中,从而提升了实时适应性、以用户为中心的优化和强大的问题解决能力。

11.2 离线智能体自我改进

相比之下,离线自我改进利用结构化的、基于批处理的优化。这种范式利用使用高质量策划数据集的预定训练会话,来系统地提高智能体的泛化能力 [851, 667, 852, 853, 854]。与在线方法不同,离线方法可以容纳计算密集型更高的方法论,包括批量参数更新与微调、元优化和系统性奖励模型校准。

批量参数更新与微调 在此类别中,智能体使用监督学习或强化学习 (RL) 技术进行广泛的微调,在多个训练周期内优化跨大规模数据集的性能。检索增强生成 (RAG) 常被整合进来,以增强上下文理解和长期记忆检索 [740, 741]。此类方法允许智能体优化检索策略,从而改进对广泛知识库的推理能力。

智能体组件的元优化 这里的离线训练不仅限于提高任务性能,还扩展到改进优化算法本身。优化超参数甚至动态重构优化过程的元学习策略已显示出有希望的结果 [731, 91]。这些元优化方法使智能体能够为新的问题领域发现最有效的学习参数。

系统性奖励模型校准 离线设置有助于奖励模型的精确校准,整合分层或列表式奖励集成框架(例如 LIRE [855]),通过基于梯度的奖励优化,使智能体行为与长期目标保持一致。这种校准确保奖励函数反映现实世界的任务复杂性,从而减轻偏差并增强泛化能力。

离线优化的结构化特性产生了一个稳健的智能体基线,其性能在实际部署前经过微调,以优化稳定性、效率和计算成本。离线训练允许高保真度的模型精炼,并且对于需要可预测性能保证的关键任务应用至关重要。

11.3 在线与离线改进的比较

在线和离线优化提供了互补的优势,各自在自我改进的不同方面表现出色。在线优化在动态环境中蓬勃发展,实时反馈使得能够持续适应。它非常适合需要即时响应的应用,例如交互式智能体、实时决策和强化学习系统。然而,频繁更新可能会引入不稳定或漂移,需要机制来缓解随时间推移的性能下降。

相比之下,离线优化强调使用预先收集的数据集进行结构化、高保真度的训练,确保部署前具有稳健和稳定的性能。通过利用计算密集型的学习方法,如批量训练、微调和元优化,离线方法提供了强大的泛化能力和长期一致性。然而,它们缺乏在线学习的敏捷性,并且在没有额外再训练的情况下,可能难以高效适应新场景。表 11.1 总结了这两种范式之间的关键区别。

| 特性 | 在线优化 | 离线优化 |

| 学习过程 | 基于实时反馈的持续更新 | 在预定训练阶段进行批量更新 |

| 适应性 | 高,能够动态调整 | 较低,仅在再训练后适应 |

| 计算效率 | 对于增量更新更高效 | 由于批量训练,资源密集度更高 |

| 数据依赖性 | 需要实时数据流 | 依赖于策划的高质量数据集 |

| 过拟合风险 | 因持续学习而较低 | 如果训练数据不多样化则较高 |

| 稳定性 | 由于频繁更新,可能稳定性较差 | 在受控的训练设置下更稳定 |

表 11.1:自我改进智能体中在线与离线优化策略的比较

虽然两种方法都有其固有的优势和权衡,但现代智能系统越来越多地通过混合优化策略将它们整合起来。这些混合框架利用离线训练的稳定性,同时融入实时适应性,使智能体能够在动态环境中持续改进性能的同时保持长期稳健性。

11.4 混合方法

认识到在线和离线方法都有其固有的局限性,许多当代系统采用混合优化策略。这些混合方法将结构化的离线优化与响应式的在线更新相结合,以实现持续的增量智能体增强。

混合优化通过赋能智能体自主评估、适应和增强其行为,明确支持自我改进,这通过不同但相互关联的阶段实现:

• 离线预训练:在这个基础阶段,智能体通过在策划数据集上进行广泛的离线训练来获取稳健的基线能力。此阶段建立基本技能,例如推理和决策,这是初始自主性能所必需的。例如,Schrittwieser et al. [856] 引入的框架展示了离线预训练如何系统性地增强初始智能体能力,确保后续的在线改进建立在稳定的基础上。

• 用于动态适应的在线微调:智能体通过自主评估其性能、识别不足之处,并根据实时反馈动态调整策略,从而积极地改进其能力。这个自适应微调阶段直接符合智能体自我改进范式,通过允许实时优化特定于智能体的工作流和行为来实现,以 Decision Mamba-Hybrid (DM-H) [857] 为例,其中智能体能高效适应复杂、不断变化的场景。

• 用于长期改进的周期性离线巩固:在周期性的离线巩固阶段,智能体系统地整合和固化在线交互过程中识别出的改进。这确保了增量的、在线获得的技能和改进被系统地整合到智能体的核心模型中,保持长期稳定性和有效性。Uni-O4 框架 [858] 例证了这一过程如何实现离线知识巩固和在线自适应改进之间的无缝过渡。

因此,混合优化通过将结构化的离线学习与主动的、实时的在线适应无缝地交织在一起,明确支持自主、持续的进化。这种循环方法使智能体同时具备即时响应能力和稳定的长期改进能力,使其非常适合复杂的现实世界场景,例如自主机器人、个性化智能助手和交互式系统。

1762

1762

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?