目录

前言

在当今人工智能飞速发展的时代,如何让AI更好地理解和操作图形用户界面(GUI)成为了研究的热点。前段时间,微软开源的OmniParser为这一领域带来了重大突破,它作为一款纯视觉基础的AI工具,正引领着智能GUI自动化迈向新的台阶.

一、项目背景:填补屏幕解析技术空白

OmniParser 是微软研究院推出的一款屏幕解析工具,它专门设计用于将用户界面的屏幕截图转换成结构化数据。这个工具的主要目的是为了提高基于大型语言模型(如GPT-4V)的UI代理系统的性能,通过准确识别可交互图标和理解截图元素的语义,增强代理执行任务的能力。

传统的自动化方法往往依赖于解析HTML或视图层次结构,这在很大程度上限制了其在非网络环境中的应用范围。而现有的视觉语言模型,如GPT-4V等,在解读复杂GUI元素以及准确定位动作方面存在不足,难以满足实际应用中对高精度界面理解和操作的需求。微软正是看到了这一技术短板,推出了OmniParser,旨在填补当前屏幕解析技术中的空白,为智能GUI自动化提供更强大的支持.

二、技术原理:精密协同的解析架构

OmniParser 依托一套高度集成且协同运作的模块体系,对 GUI 屏幕截图开展深度剖析,将视觉信息转化为结构化、可操作的数据表征。

- 可交互区域精准探测:构建大规模可交互图标检测数据集是其基石,精心采集流行网页 DOM 树衍生的 67k 幅带精确标注的屏幕截图,以此为“燃料”,对基于 YOLOv8 的深度学习模型进行微调训练。历经多轮迭代优化,该模型仿若具备敏锐视觉“触觉”,能在复杂界面中精准锁定各类可交互图标、按钮,从微小的设置按键到醒目的功能模块,皆能精准勾勒边界框,识别其空间位置与轮廓,迈出解析流程关键第一步。

- 文字信息智能萃取与整合:内置先进 OCR(光学字符识别)模块登场,对屏幕文本逐行扫描、精准识别,生成对应的文本边界框。后续借助精细算法,与前述图标边界框交叉比对、去重融合,剔除重叠冗余信息,从而构建完整涵盖图标与文字的边界框体系,完整勾勒界面元素布局架构,确保视觉信息提取无遗漏。

- 功能语义深度嵌入赋能:鉴于大型语言模型处理多模态信息时面临语义理解与操作决策两难困境,OmniParser 另辟蹊径。利用收集的 7000 对图标与描述样本集,对 BLIP - v2 模型微调优化,为每个检测到的图标生成贴合功能语境的专属描述,恰似赋予图标“语义身份证”。再将这些描述与 OCR 提取文本一并融入提示信息,投喂下游模型,有效疏解模型语义处理压力,引导其聚焦精准操作预测,极大提升决策准确性。

- 结构化整合输出:完成上述多元信息提取后,OmniParser 施展结构化整合“魔法”,将图标、文字、边界框及语义标签编织为类似 DOM 结构的有序体系,层次清晰展现元素间逻辑关联、隶属关系,叠加功能标注于关键元素,宛如绘制精细“作战地图”,助力智能体明晰界面意图,高效生成行动指令。

三、功能特点:卓越不凡的性能优势

- 跨平台无缝适配:挣脱对 HTML 标签、视图层级架构等底层依赖“枷锁”,OmniParser 以视觉感知为“利刃”,畅行桌面(Windows、MacOS 等)、移动端(iOS、Android)及网页浏览器多元平台生态,无论何种操作系统“方言”、应用样式“穿搭”,皆能精准解析,为智能体跨平台作业筑牢根基,拓宽应用“疆域”。

- 解析精度行业领先:相较于传统依赖 HTML 解析的竞品模型,OmniParser 在多平台 GUI 样本测试(如 ScreenSpot 数据集评测)中表现卓越,凭借独特模块融合与算法精研,对界面元素识别准确率实现质的飞跃,输出结构化数据保真度高,为智能体决策注入“强心针”,奠定坚实可靠数据基石。

- 智能体性能显著增效:与 GPT - 4V 等大型语言模型协同作业时,OmniParser 展现强大“助攻”实力。以图标正确标记率为观测指标,二者联手使其从 70.5%飙升至 93.8%,有效攻克智能体在 GUI 交互中长期存在的语义模糊、操作误判“顽疾”,赋能智能体操作指令生成与界面场景高度契合。

四、测试表现:显著超越现有技术

OmniParser在多个基准测试中展现出卓越性能,为其在智能 GUI 自动化领域的应用提供有力数据支撑。

1、SeeAssign 任务评估

SeeAssign 任务测试构建了含 112 个多平台任务的数据集,任务描述指向特定界面元素。评估中,GPT - 4V 依截图与任务描述预测边界框 ID。未加局部语义时,GPT - 4V 易出错;引入 OmniParser 提供的框内文本与图标描述等局部语义后,正确分配图标准确率从 0.705 大幅提升至 0.938,彰显 OmniParser 辅助 GPT - 4V 理解界面元素的强大效能。

2、ScreenSpot 基准测试

ScreenSpot 数据集含多平台超 600 个界面截图及手动创建任务指令。OmniParser 表现出色,远超 GPT - 4V 基线性能,在各平台均有显著准确率提升,还超越 SeeClick、CogAgent 和 Fuyu 等专门微调模型。融入局部语义信息后性能进一步优化,且其微调的可交互区域检测模型比 Grounding DINO 模型整体准确性额外提高 4.3%,凸显 OmniParser 在提升 UI 屏幕理解能力上的卓越贡献。

3、Mind2Web 评估

Mind2Web 基准测试专注网页导航场景,测试集含跨域、跨网站和跨任务等不同类别任务。OmniParser 将解析结果与操作历史以文本提示输入 GPT - 4V 并结合截图。实验表明,OmniParser(结合局部语义和微调可交互区域检测模型)在多数类别表现优异,跨网站和跨域类别分别提升+4.1%和+5.2%,虽跨任务类别略逊于 GPT - 4V + 文本选择(-0.8%),但总体证明其在网页导航场景的有效性与优越性。

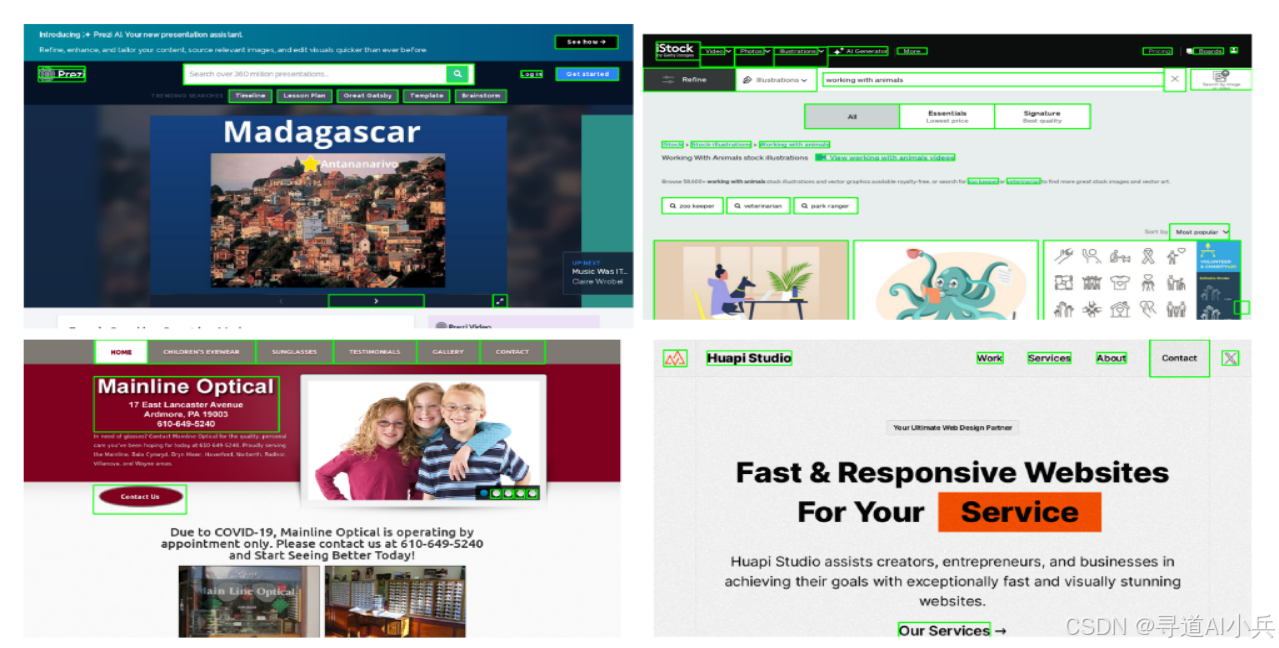

在这里插入图片描述

4、AITW 基准测试

AITW 移动导航基准测试含大量指令与操作轨迹。OmniParser 相比 GPT - 4V + 历史记录基线,总体得分提升 4.7%,多数子类别有明显改进,再次证明其在移动设备自动化操作中的有效性与通用性。

五、应用场景:多元领域的价值彰显

1、智能办公自动化提效

在企业办公日常里,效率就是竞争力。OmniParser 如同一位得力的“智能助手”,赋予办公软件操作流程自动化的能力。面对海量文档,它助力智能体批量处理格式,将参差不齐的 Word 文档排版迅速规整统一,或是把 Excel 表格数据按既定规则精准填充,减少人工手动录入的繁琐与差错。邮件发送环节,也能依据联系人列表自动匹配收件人,附上对应附件后群发,原本耗时费力的事务性工作,在其助力下高效完成,员工得以将精力聚焦于更具创造性、策略性的核心工作,企业运营效率显著攀升。

2、无障碍交互贴心助力

视力障碍群体以往面对图形用户界面,仿若隔了一堵无形且厚重的“墙”,信息获取艰难。OmniParser 与辅助技术紧密融合,变身“贴心翻译”,把屏幕上的视觉元素巧妙转化为语音提示,从电商平台琳琅满目的商品详情介绍,到社交软件里亲朋好友的消息内容,再到在线课程的章节讲解,皆能清晰“读”出,还能适配盲人点显器等设备,化作可感知的触觉反馈,帮助视障人士自如穿梭于数字空间,顺利购物、畅快社交、安心学习,真正融入数字生活浪潮之中。

3、智能用户辅助便捷指引

日常使用电子设备时,复杂操作常让人挠头,不知所措。OmniParser 宛如一位洞察先机的“贴心参谋”,实时紧盯屏幕界面,结合用户过往操作习惯与当下使用情境,精准推送便捷操作建议。在手机端,能迅速告知用户单手模式如何快速切换,分屏操作怎样便捷开启;于电脑软件里,那些藏在层层菜单下的实用功能,也能被挖掘出来,让用户一键调用,人机交互瞬间变得顺滑流畅,操作不再令人困扰。

4、自动化软件测试严谨把关

软件开发恰似精心雕琢艺术品,测试环节则是检验品质的“试金石”。OmniParser 主动担起“把关卫士”职责,严格依照预设测试脚本开展工作。它精准识别 UI 元素,模拟真实用户点击按钮、输入文本、滑动屏幕等交互动作,细致排查登录注册流程是否顺畅无阻,核心业务功能交互有无漏洞,不放过任何一处界面显示异常、逻辑错误等瑕疵,如同细密滤网,筛除软件潜在问题,保障上线产品稳定可靠。

5、虚拟助手效能升级赋能

虚拟助手立志成为用户的“万能帮手”,处理繁杂日常事务。OmniParser 恰似为其植入“智慧芯片”,深度赋能助手解读屏幕场景。当接到预订出行票务指令,能综合考量航班时刻、火车车次、酒店性价比等诸多因素,择优预订;碰上信息查询需求,在海量资讯中精准筛选提炼,呈现关键内容;面对表单填写,迅速按要求填充各类繁琐资料,无论界面多复杂多变,指令都能精准落地执行,服务品质得以进阶。

6、UI 设计验证精准洞察

设计师呕心沥血雕琢 UI 时,最担忧交互元素“中看不中用”。OmniParser 化身“锐利鹰眼”,审视设计稿时,严谨校验可交互元素功能是否到位、提示语义是否清晰准确。按钮点击会不会失效、弹窗提示是否会误导用户,诸如此类隐患,都能提前察觉并预警,确保最终上线产品契合用户操作预期,交互体验顺滑自然,不负设计初衷。

7、跨平台应用开发品质护航

跨平台应用开发之路布满挑战,确保各端体验一致是重中之重。OmniParser 如同经验老到的“品质导师”,辅助开发者展开多轮 UI 测试优化。从适配不同屏幕尺寸的界面布局调整,到平衡触摸操作与鼠标操作响应差异的交互细节打磨,逐一排查、校准偏差,使应用无论在手机移动端,还是电脑桌面端,都能展现优质交互品质,吸引多端用户欣然使用。

六、快速使用:简易上手实操指南

以下为您介绍 OmniParser 的快速使用步骤,助您高效开启智能 GUI 自动化之旅:

1、克隆代码

克隆OmniParser仓库代码到本地

git clone https://github.com/microsoft/OmniParser.git

2、安装依赖

本地环境借助 conda 或 venv 工具创建 Python 3.12 虚拟环境,命名为“omni”并激活,隔离外部依赖干扰

conda create -n "omni" python==3.12

conda activate omni

pip install -r requirements.txt

3、下载模型

在 https://huggingface.co/microsoft/OmniParser 中下载模型 ckpts 文件,并将它们放在 weights/ 下,默认文件夹结构为:weights/icon_detect、weights/icon_caption_florence、weights/icon_caption_blip2。

最后,将 safetensor 转换为 .pt 文件。

python weights/convert_safetensor_to_pt.py

4、启动运行

要运行 gradio demo,只需运行:

python gradio_demo.py

其他代码样例可参考:https://github.com/microsoft/OmniParser/blob/master/demo.ipynb

结语

微软开源的 OmniParser 无疑在智能 GUI 自动化领域踏出了坚实且意义深远的一步。通过对其技术原理的深度剖析、主要功能的全面展示、测试表现的有力验证、应用领域的广泛探索以及快速使用的简要介绍,我们清晰地目睹了它在提升人机交互体验方面的巨大潜力。尽管目前仍存在一些有待攻克的挑战,但随着技术的持续演进与完善,相信 OmniParser 将在未来的数字化浪潮中持续发光发热。它有望进一步打破人机交互的壁垒,为更多用户群体创造便捷、高效且无障碍的交互环境,在智能设备、办公自动化以及无障碍辅助等诸多领域掀起创新的浪潮,引领智能 GUI 自动化迈向更加辉煌的新征程,让我们满怀期待地见证它在未来为科技世界带来更多的惊喜与变革。

OmniParser项目资料

Github地址:https://github.com/microsoft/OmniParser

HuggingFace 模型库:https://huggingface.co/microsoft/OmniParser

arXiv 技术论文:https://arxiv.org/pdf/2408.00203

🎯🔖更多专栏系列文章:AI大模型提示工程完全指南、AI大模型探索之路(零基础入门)、AI大模型预训练微调进阶、AI大模型开源精选实践、AI大模型RAG应用探索实践🔥🔥🔥 其他专栏可以查看博客主页📑

😎 作者介绍:我是寻道AI小兵,资深程序老猿,从业10年+、互联网系统架构师,目前专注于AIGC的探索。

📖 技术交流:欢迎关注【小兵的AI视界】公众号或扫描下方👇二维码,加入技术交流群,开启编程探索之旅。

💘精心准备📚500本编程经典书籍、💎AI专业教程,以及高效AI工具。等你加入,与我们一同成长,共铸辉煌未来。

如果文章内容对您有所触动,别忘了点赞、⭐关注,收藏!加入我,让我们携手同行AI的探索之旅,一起开启智能时代的大门!

1462

1462

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?