- 版权声明:该文是博主个人的学习笔记,如有错误,恳请看官在评论区指出,在下不胜感激~如要转载注明出处即可~

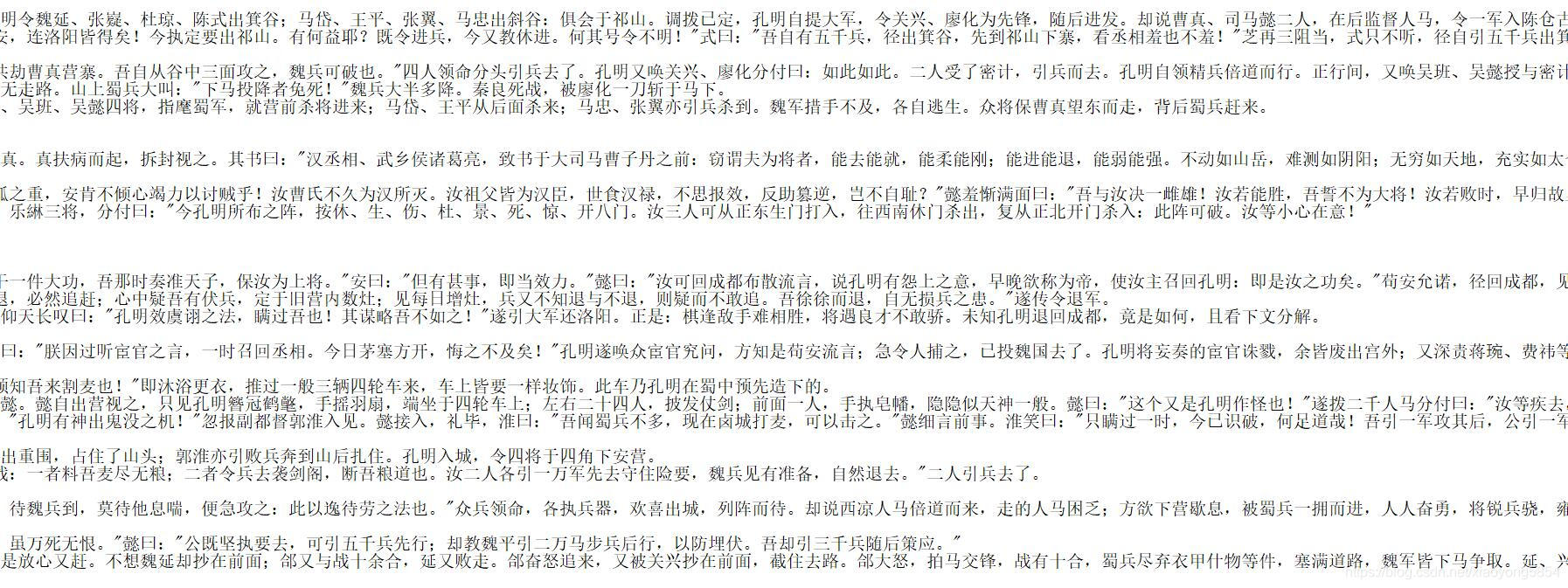

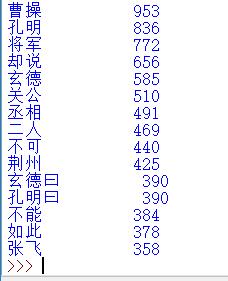

人物出场设计对词汇的统计。中文文章需要分词才能进行词频统计,这需要用到jieba库。

《三国演义》文本保存为三国演义》.txt,实现代码如下:

#CalThreekingdomsV1.py

import jieba

txt =open("三国演义.txt", "r", encoding = 'utf - 8').read()

words = jieba.lcut(txt)

counts = {}

for word in words:

if len(word) == 1:#排除单个字符的分词结果

continue

else:

counts[word] = counts.get(word, 0) + 1

items = list(counts.items())

items.sort(key = lambda x:x[1], reverse=True)

for i in range (15):

word, count = items[i]

print("{0:<10}{1:>5}".format(word, count))

排除一些与人

本文是作者对《三国演义》的人物出场进行统计的学习笔记,利用jieba库对中文文本进行分词处理,以便进行词频统计。通过优化代码,排除了无关词汇,对文本进行深入分析。

本文是作者对《三国演义》的人物出场进行统计的学习笔记,利用jieba库对中文文本进行分词处理,以便进行词频统计。通过优化代码,排除了无关词汇,对文本进行深入分析。

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

2313

2313

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?