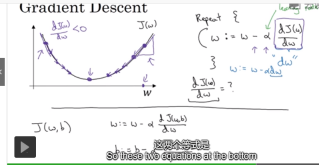

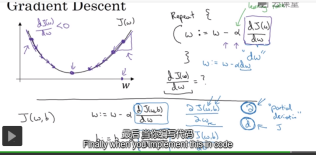

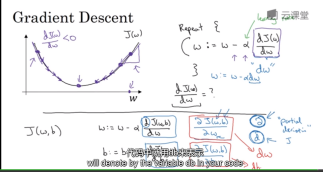

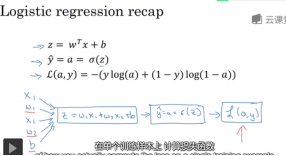

Logistic 回归是一个二分分类的算法。包括正向传播和反向传播两个过程。正向过程计算代价函数,反向过程训练参数。logistic 回归算法可以被看作是一个非常小的神经网络。通过梯度下降法,来训练w或者b,使得代价函数最小化。代价函数是一个凸函数,这样可以找到全局最优解。函数的凸性也是为什么选择在这个函数的原因。函数是凸的,无论从哪一点开始都应该到达同一点。 梯度下降法就是从初始点开始,每次朝最抖的下坡方向走一步

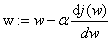

。从而确定合适的解w使代价函数值j(w)逼近最小值。最抖的方向数学上需要借助偏导数。偏导数的计算是通过数学上的链式求导法则。

1.基本概念 样本,训练集。

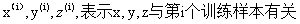

(x,y)代表样本。输x是nx维的特征向量。输出y值是 0或者1.代表第i个样本,m个样本形成整个训练集。m_train训练集样本个数,m_test测试集样本个数。训练集更紧凑的表示形式是将x向量按列堆叠成矩阵。矩阵x,nx(训练集向量)m(训练集个数)。输出y矩阵1m. Python 中x.shap.可以输出矩阵的维度(nx,m). y.shap输出1*m.

好的惯例符号,可以将不同训练样本的数据联系起来。

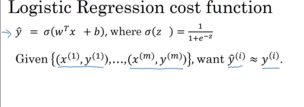

2.logistic 回归的输出

logistic回归的输出是 其中。引用的目的是映射到0到1.

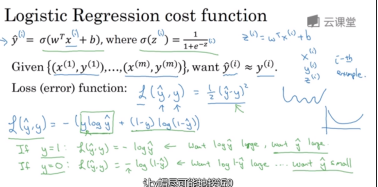

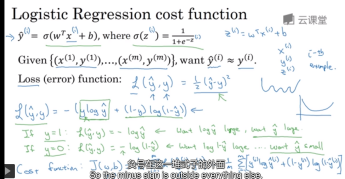

3.Logistic 回归的损失函数和代价函数

为了训练线性回归模型中的参数W,b.需要定一个成本函数。我们希望成本函数值越小越好,希望预测值能够接近实际值。代价函数可以用估计值和实际值差的方差描述。但是logisitic算法不采用那种算法。

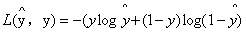

损失函数L用来定义。 损失函数是定义在单个训练样本的情况下的。

损失函数是定义在单个训练样本的情况下的。

多个训练样本用代价函数描述:

4.梯度下降法

图中简化一个随机变量,依据每次使得函数向下降最快的方向移动一步,迭代更新求解。

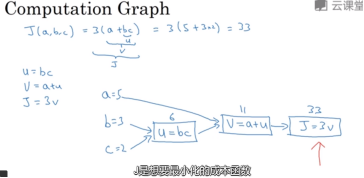

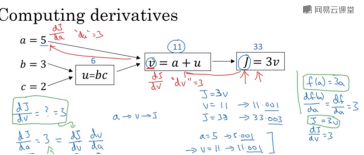

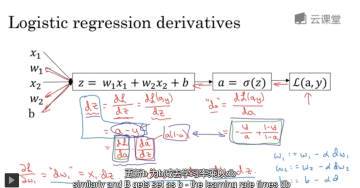

5.导数的计算----链式求导法则

相反的过程。

dvar你关心的最终变量的导数。

代码实现中dv/da 记作da.dj/dv 记作dv 就是省略d目标函数。

一个计算图从左到右计算成本函数j。从右到左计算导数。

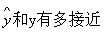

计算偏导数来实现logistic的梯度下降法。通过导数流程图来计算梯度。

其中a是logistic的输出,也就是做出估计。y是样本真实的值(1或者0)。

更换w1,w2,b的值是损失函数最小。

1198

1198

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?