论文解读——DynGEM: Deep Embedding Method for Dynamic Graphs

论文链接:https://arxiv.org/abs/1805.11273

一. 摘要

大规模图嵌入技术在图可视化、链路预测和节点分类等领域的领域的广泛应用引起了研究者的广泛关注。当前的图嵌入技术主要是处理静态图,然而在实际应用场景中,大部分图数据都是随时间动态演化的。直接对动态图的每个快照应用图嵌入方法无法满足稳定性、灵活性和效率等方面的需求。本质上孤立的考虑各个快照会把相同的节点映射到不同的向量空间中,没有考虑同一节点随着时间的演化性。为解决上述问题,本文提出了一种基于深度自编码的有效图嵌入方法-DynGEM。DynGEM方法的主要优点:1.图嵌入技术随时间是稳定的;2.可以增量的处理动态图;3 有更好的性能。最后,在合成数据集和真实数据中测试了本文方法的性能,通过在图可视化、图重构、链路预测和异常检测四个应用场景的对比分析中看出本文化方法有良好的稳定性和可扩展性。

二. 引言

图分析中的很多应用都涉及到图中顶点与边的预测,这就需要从复杂的多维的图模型中提取有效的模式或构建预测特征。在众多的图特征表示技术中,图嵌入技术通过扑捉与其他节点的关系来学习图中每个节点的向量表示,并获得了较好的性能成为当前图特征表示的研究热点。已经有大量的研究工作证明,图嵌入技术在许多有监督学习任务,如节点分类、链路预测和图重构中优于其他方法。

针对静态图的嵌入技术已经有了大量的研究工作,这里就不详细列举。显示在实际场景中,很多图模型是动态的,需要随时间进行更新演化,比如社交网络。

当前动态图的处理方法通常是对于动态图的每一个快照直接利用静态图嵌入方法进行表示学习然后按对于每一个快照的结果按时间进旋转对齐。该方法性能不理想的主要原因如下:

1 稳定性:静态方法生成的嵌入表示是不稳定的,在图没有很大变化的情况下,图的嵌入表示在连续时间步内会有很大不同。

2 增长图:随着时间的演化,会增加新的节点,同时增加新节点到现有节点的连接。而当前的的图嵌入技术都是假定图的节点是固定的,因此无法处理这种演化图。

3 可扩展性:对于动态图的每个快照独立的进行嵌入学习的方法的运行时间与动态图的快照是线性关系。当前间个图嵌入学习的计算代码就已经很昂贵,因此,这种方法并不能很好的展到动态图中。

当前已经有的动态图嵌入技术通过加入时序正则化来保证动态图连续快照的嵌入表示的时序平滑性。这类方法很难处理连续的快照存在显示差异的动态图。

本文化提出一种有效的动态图嵌入方法DynGEM,该方法能生成稳定的动态图嵌入表示。DynGEM方法的核心是一个深度自编码器,并采用深度学习方法生成高度非线性的嵌入表示。DynGEM并不是从头开始学习每个图快照的嵌入表示,而是基于前一个图快照的嵌入表示增量的生成当前时刻的图快照的嵌入表示。具体来说,以前一个时刻的图快照的嵌入表示为初始值,执行梯度训练。

由于该方法对图的嵌入表示都是基于前一个时间快照训练的,相对于说一个时间间隔内图的变化并不会特别大,因此该方法能学习较稳定的图嵌入表示,同时只需要每少的迭代步骤就能达到收敛,是一种增量式的嵌入表示学习方法。同时为了处理节点增量变化的情况,本文采用启发式算法PropSize逐步增加神经网络的大小来动态的确定每个图快照所需要的隐藏单元个数。此外,本文还提出了一个严格的稳定度量标准。

最后,在合成数据集和真实数据集对本文方法进行了验证,与现有的静态图算法相比,本文的方法在图重构和链路预测上有较好的性能。DynGEM同样适用于动态图的异常。

三. 先验知识

定义加权图为G(V,E),其中V是节点值,E是边集合,加权图的G的加权邻接矩阵个为S。图嵌入是一个映射 ![]() 即

即 ![]() ,其中d远远小于图中顶点的个数据,图嵌入学习的映射函数f在映射到低维向量空间时尽可能的保留了图G中的近邻关系。直观的来说,如果在图G中两个节点相似,那么两个顶点在图嵌入学习后的低维向量空间中的距离也比较近。

,其中d远远小于图中顶点的个数据,图嵌入学习的映射函数f在映射到低维向量空间时尽可能的保留了图G中的近邻关系。直观的来说,如果在图G中两个节点相似,那么两个顶点在图嵌入学习后的低维向量空间中的距离也比较近。

本文主要解决动态图嵌入问题,把动态图表示成一系列快照,如![]() ,其中

,其中![]() , T是动态图中快照的数目。本文只考虑节点的增加,而不考虑节点的删除,删除节点只需要把与该节点相关联的出入边的权值变为0即可。

, T是动态图中快照的数目。本文只考虑节点的增加,而不考虑节点的删除,删除节点只需要把与该节点相关联的出入边的权值变为0即可。

动态图嵌入就是将图嵌入的概念扩展到了动态图中。给定一个动态图 ![]() ,动态图嵌入本质就是一个时序映射

,动态图嵌入本质就是一个时序映射![]() ,其中

,其中![]() 表示动态图快照

表示动态图快照![]() 的映射。

的映射。

一个成功的动态图嵌入技术应该是随时间演化而稳定的。所谓的稳定的图嵌入是指,对于连续的图快照,如果两个快照的图变化较小的话这两个快照对应的嵌入表示的差异也小。

具体来说,![]() 是节点集

是节点集![]() 的诱导子图的加权邻接矩阵,

的诱导子图的加权邻接矩阵,![]() 表示第t个图快照的所有节点

表示第t个图快照的所有节点 ![]() 的嵌入映射。图嵌入表示的绝对稳定性可以定义为:

的嵌入映射。图嵌入表示的绝对稳定性可以定义为:

![]()

通过上式可以看出,对于任意图嵌入表示,它的绝对稳定性是两个连续图快照的嵌入表示之差与邻接矩阵之差的比值。由于该稳定性的度量依赖于邻接矩阵的大小,为此提出了一种相对稳定性,该稳定性的大小与邻接矩阵与嵌入矩阵的大小无关:

![]()

进一步定义了稳定性常量:

![]()

本文认为只要图嵌入的稳定数量小那么该图嵌入技术就是稳定的。在后面的实验中,使用稳定常量作为算法稳定性的度量标准。

四. 动态图嵌入模型DynGEM

深度无监督学习相关的最新研究表明,自编码器能够成功的学习各类任务复杂的低维向量表示。DynGEM使用深度自编码器将输入数据映射到一个高度非线性的潜在空间,该方法能捕捉图快照在演化过程的连续趋势。该方法是半监督的方法,目标函数选择一阶近似和二阶近似的组合。

图4.1 动态图嵌入模型

自编码器模型哪图上图4.1所示,关于自编码器的术语如表1所示。

表1相关术语

节点![]() 的领节点表示为

的领节点表示为![]() 。对于图中任意的节点对vi 和vj ,模型以这两个节点的邻节点为输入:

。对于图中任意的节点对vi 和vj ,模型以这两个节点的邻节点为输入:![]() 和

和![]() ,并把该输入传递给自编码器生成d维的嵌入向量

,并把该输入传递给自编码器生成d维的嵌入向量 ![]() 和

和 ![]() 作这编码器的输出,解码器根据嵌入表示yi 重构这两个节点的邻节点

作这编码器的输出,解码器根据嵌入表示yi 重构这两个节点的邻节点 ![]() 和

和 ![]() 。

。

4.1增长图

处理不断增量的动态图需要有效的机制来扩展自编码器模型。在动态图嵌入过程中自编码器所面临的一个关键问题是如何根据图规模的增长而决定隐藏层的数目和隐藏单元的数目。本文提出了一种启动式的算法-PropSzie,用于计算新层的大小,以确定连续层在的在一个固定范围内。

PropSize是用于计算新神经网络层大小的启发式算法。对于编码器,神经网络层宽需要在每一对连续的层之间进行计算,从输入层开始直到满足如下条件才结束:

![]()

其中ρ 是一个取值在0到1范围内的超参数。如果对于任一连续的层都不满足上式的条件,那么,k+1层的层宽就被增加到满足该条件。嵌入表示层总是保证d维固定大小,并不会随着图的规模变化而变化。如果编码器的倒数第二层和嵌入层不满足PropSize规则,那么增加更多层直到满足规则。该过程也适用于解码过程。

在确定了神经网络层的数量和隐藏层的单元数目后,本文采用文献[Chen et al., 2015]中提出的Net2widerNet和Net2DeeperNet两种访求 扩展深度自编码器。Net2widerNet主要是扩展神经网络层,在尽可能保留该层的计算攻击的情况下增加隐藏层单元数。Net2DeeperNetd 在两层之间插入一个新层,该中间层尽可能的复杂标志映射。可以使用ReLU激活函数,但是不能使用sigmoid激活函数。每一时间步内通过PropSize启动式方法结合自编码的宽度与深度能够处有效处理节点数不断增加的动态图。最近通过本文实验显示,本文方法与已有方法相比有显著提升。

4.2损失函数及训练过程

为了学习模型参数,最小化如下三个目标函数的加权组合:

![]()

其中a,v1和v2是各目标函数之间的权重。![]() 表示对应于图局部结构的一阶近似。

表示对应于图局部结构的一阶近似。![]() 图的二阶近似,表示图中每个节点的全局近邻,并通过无监督生构每个节点的近邻进行保存。bi 是一个向量,如果sij=0 那么bij=0 ,否则,bij=β>1 。相对于未观察到的边,这将惩罚观察到边的不准确生构。增加正则化L1和L2为了提交网络权重的稀疏性,同时防止图结构表示学习的过拟合问题。在每一个图快照中,DynGEM都学习了一个深度自编码器的超参数

图的二阶近似,表示图中每个节点的全局近邻,并通过无监督生构每个节点的近邻进行保存。bi 是一个向量,如果sij=0 那么bij=0 ,否则,bij=β>1 。相对于未观察到的边,这将惩罚观察到边的不准确生构。增加正则化L1和L2为了提交网络权重的稀疏性,同时防止图结构表示学习的过拟合问题。在每一个图快照中,DynGEM都学习了一个深度自编码器的超参数![]() ,并使用

,并使用 ![]() 作为图快照的 的嵌入学习的输出。

作为图快照的 的嵌入学习的输出。

4.3增量图嵌入的稳定性

动态图 ![]() ,在图快照G1上利用深度自编码器进行学习,并随机初始化超参数Q1 。对于之后的图快照进行处理里,在扩展/深化模型之前,使用之前模型的参数Qt-1 初始化本步的参数Qt 。这样会导致结构从ft-1 到ft 的直接知识转换,因此模型只需要学习图快照Gt 和Gt-1 之间的差异即可。因此,在之后的过程中训练过程只需要几步迭代就能快速收敛。最主要提通过保证相邻两个快照的嵌入学习Yt 和Yt-1 的相近性来保证了整个图嵌入表示的稳定性。因此,无需对每一个快照的结果强加一个正则化来保证相邻的图快照的嵌入表示相似。

,在图快照G1上利用深度自编码器进行学习,并随机初始化超参数Q1 。对于之后的图快照进行处理里,在扩展/深化模型之前,使用之前模型的参数Qt-1 初始化本步的参数Qt 。这样会导致结构从ft-1 到ft 的直接知识转换,因此模型只需要学习图快照Gt 和Gt-1 之间的差异即可。因此,在之后的过程中训练过程只需要几步迭代就能快速收敛。最主要提通过保证相邻两个快照的嵌入学习Yt 和Yt-1 的相近性来保证了整个图嵌入表示的稳定性。因此,无需对每一个快照的结果强加一个正则化来保证相邻的图快照的嵌入表示相似。

4.4本文技术的可扩展性

之前的处理静态图嵌入技术的深度自编码器模型使用了sigmoid激活函数,并在训练的过程中使用了随机梯度下降法(SGD)。

本文在自编码器所有层都使用了ReLU激活函数来支持加权图,同时使用ReLU也加速了训练过程,因为它的导数很空间计算,而sigmoid函数导数的计算复杂性是指数级的。最后,ReLU允许针对两个目标函数的梯度,并通过编码器有效的传播,避免了sigmoid函数导致的梯度消失问题。

同时本文使用了nesterov动量和适当调整的超参数,这比直接使用SGD要收敛的快。通过实验观察,使用L1和L2范式的联合正则化在所有的应用中都有很好的性能表现。

本文提出算法如上图算法1所示。动态图中的每个快照都可以调用伪代码中的算法来生成动态图嵌入表示。

-

五实验

5.1数据集

图5.1 静态数据集

本文提出的算法DynGEM在合成图和真实动态图数据集上进行了性能评估。数据集如图5.1所示。

合成数据(SYN):使用随机块模型生成合成动态图方法参考文献[Wang and Wong, 1987]。生成动态图的第一个快照,其具有三个大小相等的社区,块内概率为0.2,块间概率为0.01。为了生成后续的图快照,在每个时间步随机选取节点并将它们移动到另一个社区。当节点改变社区时,使用SYN来可视化嵌入表示的的变化。

HEP-TH数据集:原始数据集包含1993年1月至2003年4月高能物理理论会议论文摘要。对每个月的数据创建一个协作网络。取前五年的数据,生成一个包含60个图快照的动态图,节点数从1424个增加到7980个。

Autonomous Systems(AS)数据集:这是一个通过BGP(边界网关协议)的通信网络。该数据集包含了从1997年11月8日到2000年1月2日的733个实例。在评估中,我们考虑这个数据集的一个子集,它包含前100个图快照。

ENRON :该数据集包含1999年1月至2002年7月ENRON 公司员工之间的电子邮件。我们按照文献[Park et al., 2009]的方法处理图,从1999年1月开始,每周只考虑高管之间的电子邮件通信。

5.2算法及评估标准

主要的对比算法SDNE和GF。有兴趣的可以参考原文。

六. 实验结果分析

6.1图重构

图嵌入技术作为一个有效的图低维向量表示技术,可以用于重构图。这里使用我们的自动编码器模型中的解码器,由嵌入表示重构节点对之间边。根据对应的重构邻近度对节点对进行排序。然后,计算节点对真实边重构的准确性。

图6.1 图重构的平均MAP

图6.1显示了图重构中各种算法的平均MAP度量的对比,结果显DynGEM在除了数据集HEP-TH数据集外均优于所有图分解(GF)算法。

6.2链路预测

图嵌入的另一个重要应用是链接预测,它测试模型对未观测边的预测能力。一个好的网络表示不仅应该能够重建训练过程中可见的边,而且应该能够预测训练数据中可能存在的潜在的边。为了测试,在t时刻的图快照中一次随机隐藏15%的边。使用快照{G1,···,Gt−1,G\Gt}训练动态嵌入,并在预测t时刻快照的边。把预测结果与隐藏之前的图进行对比分析得出算法的准确度得分。结果如图6.2所示。

图6.2 链路预测的准确度

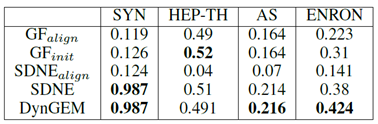

6.3嵌入方法的稳定性

嵌入的稳定性对于异常检测等任务至关重要。这里评估了本文模型的稳定性,并在图6.3的稳定性常数方面与四个数据集上的其他方法进行了比较。本文模型在很大程度上优于其他模型,并提供了稳定的嵌入以及更好的图形重建性能。在下一节中,将说明如何利用这种稳定性来可视化和检测真实动态网络中的异常。

图6.3 动态图嵌入技术的稳定常数

6.4可视化

可视化是图嵌入别一个生要应用。

图6.4 图嵌入可视化

本文在SYN数据集上进行了可视化实验。将t-SNE[Maaten and Hinton,2008]应用于DynGEM在每个时间步生成的嵌入表示,绘制2D可视化图。为了避免可视化在时间步上的不稳定性,对所有时间步用相同的随机状态初始化t-SNE。图6.4显示了当节点在连续图快照中有跨社区的变化 时,SYN数据集的100维嵌入的二维可视化结果。每个子图中的左(右)图显示节点更改其社区之前(之后)的嵌入表示。节点表示该顶点在图嵌入表示空间中的位置,节点的颜色表示该节点属于的社区。可观察到,社区发生的节点的DynGEM嵌入表示准确地跟踪社区结构的变化情况,而且没有干扰其他节点的嵌入。这有力地证明了我们技术的稳定性。

6.5神经网络层的扩展效果

实验HEP-TH数据集在评估了神经网络层扩展的效果。分别利用DynGEM执行了有层扩展和没有层扩展的情况。在没有层扩展的问题下,模型的平均MAP达到0.46,并且图重建和链路预测分别为0.19。而有层扩展模型的平均MAP是0.491和0.26,显示有层扩展的情况下性能更好。

6.6可扩展性

图6.5 不同时间长度的图嵌入表示的计算时间

比较学习不同嵌入模型所需的时间。从图6.5中,观察到DynGEM明显快于SDNE。我们不将其与基于图分解的方法进行比较,因为尽管速度很快,但它们的性能远远不如深度自动编码器的模型。最终结果就是DynGEM在执行时间上要比这些方法快2到3倍。

3132

3132

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?