激活函数的作用

在线性不可分的情况下,激活函数可以给模型引入非线性因素。什么意思呢?比如下面异或问题。

| x | y | z |

|---|---|---|

| 1 | 0 | 1 |

| 0 | 1 | 1 |

| 1 | 1 | 0 |

| 0 | 0 | 0 |

这个问题是线性不可分的,假设有一个单隐藏层的神经网络,如图:

上图线上数字表示权重,下面两个节点是异或问题的输入,中间隐藏层的1.5表示大于1.5才激活输出1,否则输出0,后面输出层0.5同理。

如果熟悉神经网络的前向传播,容易看出, 这个网络的输出就是我们的异或真值表,而网络中1.5,0.5这样的阈值阶跃函数 就是我们的激活函数。

常见的激活函数

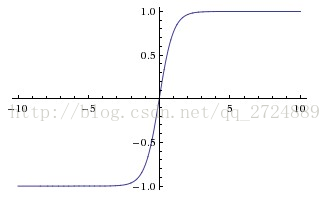

sigmoid函数 σ(z)=11+e−z σ ( z ) = 1 1 + e − z

- 从图像可以看出来sigmoid函数越远离原点,图像越平滑,梯度越小,我们知道在神经网络BP的时候需要求权重的梯度,当经过sigmoid激活时梯度信息会变小,如果层数变深,会产生梯度弥散现象。

tanh函数 tanh(x)=ex−e−xex+e−x tanh ( x ) = e x − e − x e x + e − x

- tanh是双曲正切函数,tanh函数和sigmod函数的曲线是比较相近的,咱们来比较一下看看。首先相同的是,这两个函数在输入很大或是很小的时候,输出都几乎平滑,梯度很小,不利于权重更新;不同的是输出区间,tanh的输出区间是在(-1,1)之间,而且整个函数是以0为中心的,这个特点比sigmod的好。但梯度消失现象依然存在。

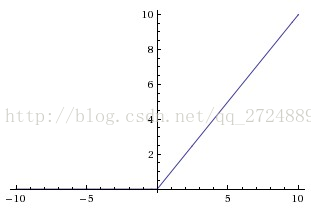

Relu函数 f(x)=max(0,x) f ( x ) = m a x ( 0 , x )

- relu是目前神经网络最常用的激活函数,相对于前两个,在输入为正数的时候,不存在梯度饱和问题。

- 计算速度要快很多。

- 但是输入为负数的时候,是完全不激活的,在BP过程中,也会导致梯度消失,只能说relu能一定程度解决梯度弥散问题。

228

228

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?