尽管Qwen2.5、DeepSeek v2.5这样的基础模型具备强大的能力,仅通过精心设计提示词就可以执行具体任务,但拥有这些基础模型还不够,通过提示工程驯化的Instruct模型也无法让你感到满意。

在将大模型应用于特定行业应用时,为了拥有独特产品优势以及更好的用户体验,你要的是一个高度满足特定场景的“定制化”模型——你需要微调模型。

不过,对不熟悉微调的开发者而言,可能会认为微调就像调算法那样门槛很高而不敢尝试。实际上,现在通过大模型云服务平台,开发者只需简单调整一些参数,在几分钟内就可以微调一个专属LLM。对个人开发者及生成式AI团队而言,这会是高效应对特定领域任务的绝佳策略。

为更好满足特定领域任务需求并降低微调门槛,硅基流动的大模型云服务平台SiliconCloud上线了微调功能,提供原生推理加速能力,以及极具性价比的服务,为微调服务提供最佳实践。目前,SiliconCloud微调功能已支持训练Qwen/Qwen2.5-72B-Instruct、Qwen/Qwen2.5-7B-Instruct,更多模型正在支持中。

在线微调:https://cloud.siliconflow.cn/fine-tune

为什么需要模型微调?

微调已有基础模型可以有效提升其在特定任务中的效果,并以高性价比的成本满足特定领域的任务需求。具体而言,模型微调主要包括以下好处:

1. 提高特定任务的效果

微调可以让模型更好地理解特定领域的语言或任务需求,例如特定行业术语、格式化输出或特定语言。虽然基础模型在大规模的未标注数据上进行预训练,学习到的是通用的语言表示和知识,但这些并不能完全适用于特定任务。

一方面,基础模型通常具有大量的参数,容易在特定任务上过拟合,通过微调可以快速调整模型的参数,将基础模型在大规模数据上学到的知识迁移到特定任务上,从而提高模型的泛化能力;另一方面,不同的下游任务(如文本分类、命名实体识别、情感分析等)有特定的需求和特点,微调模型可以学习到更具体的特征和模式,以帮助模型更好地适应这些特定任务,提高在该任务上的效果。

2. 数量级降低Token消耗量,更快的推理速度

使用上下文学习的提示工程需要消耗大量Token,推理速度会变慢。微调模型后,输入长度变少,消耗的Token跨数量级降低,响应速度更快。(见后文“智说新语”的微调实例)

3. 实现全流程自动化

在模型升级或切换基座模型时,需要人工重新调整提示词,以确保提示词在新版本模型中仍能有效运行。相比之下,微调模型不用改动提示词就可以自动适配新模型,大幅提高模型更新的效率与便捷性。

4. 快速迭代,性价比高

微调模型通常比从头训练模型更快,由于基础模型已经学习到了大量的通用知识,这使得研究人员和开发者可以快速迭代和实验不同的任务和模型配置,提高开发效率。此外,在许多实际应用中,标注数据的获取成本较高,数量有限。微调可以在少量标注数据上进行,使模型在这些数据上学习到特定任务的特征,从而在资源有限的情况下取得较好的效果。

5. 创建独特的产品优势与知识产权**

微调模型能将组织内的专有数据与模型结合,形成独有的竞争优势,同时满足监管和合规需求。

以提高Qwen2.5-72B大语言模型在情感分析任务的实用性为例。首先,需要收集和准备情感分析任务的标注数据集,然后将Qwen 2.5在这些数据集上微调,通过调参来适应情感分析任务,随后在验证集上评估微调后的模型效果,确保模型在特定任务上表现良好,最后再将微调后的模型部署到实际应用中,就可以更好地用于情感分析任务。

SiliconCloud微调服务:简单、快速训练专属LLM

尽管微调能够显著提升模型的效果,但在微调过程中,从完整的训练批处理到对模型特定部分进行高效和精准的调整仍面临不少挑战。主要包括:

-

技术难度高:如果自己部署模型来进行微调,需要对模型的结构和参数有深入的理解,这要求开发者具备较高的技术水平和经验。此外,在微调中进行频繁试验和调整,可能会导致GPU资源的利用率不高,造成资源浪费。

-

迭代时间长:已有平台通常需要数小时来完成模型微调。微调完成后,还需要额外的时间来部署模型,长时间的迭代周期不仅影响开发效率,还可能导致延误项目进度。

-

成本高昂:已有平台单次微调任务费用较高,如果需要进行多次迭代,费用会显著增加,对于个人开发者或资源有限的团队具有比较大的财务负担。

SiliconCloud的微调功能主要使用LoRA技术,让开发者在不需要大量数据的情况下提高模型效果,更重要的是,SiliconCloud为微调模型提供了原生的推理加速能力。具体体现在以下方面:

1. 极致推理速度:基于大模型推理引擎的SiliconCloud微调服务具有原生加速能力,将LLM微调模型的推理速度最快提升2.7倍,将文生图模型的推理速度最快提升3倍(即将支持)。

2. 高效、无缝微调:上传数据集后,仅需修改少量参数,最快3分钟就可以微调一个模型,并可直接通过API调用。

3. 极致性价比:微调模型价格按微调模型训练及微调模型生成价格计算,延续了SiliconCloud API的成本优势,提供最具性价比的服务。

如何用SiliconCloud微调模型

1. 准备数据

-

文件格式:JSONL后缀,每行一个JSON对象

-

每行数据结构:

-

-

每行必须是一个完整的JSON对象

-

必须包含

messages数组字段 -

messages中的每条消息必须包含role和content字段 -

role仅支持:system/user/assistant如下为数据示例: -

{"messages": [{"role": "user", "content": "饥饿营销"}, {"role": "assistant", "content": "商家高呼库存紧张时,消费者已自觉排队,等到真相大白,才发现饥饿的不过是自己的钱包。"}]} {"messages": [{"role": "user", "content": "提示词赛道"}, {"role": "assistant", "content": "赛道上人人争先恐后,以为奔跑就能抵达终点,却不知真正的胜负早已在起跑线上划定。"}]} {"messages": [{"role": "user", "content": "产品经理"}, {"role": "assistant", "content": "产品经理,一边吹嘘着用户体验至上的圣歌,一边悄悄在后台数着广告点击的金币。"}]} -

(数据要求详情见文档:https://docs.siliconflow.cn/guides/fine_tuning)

-

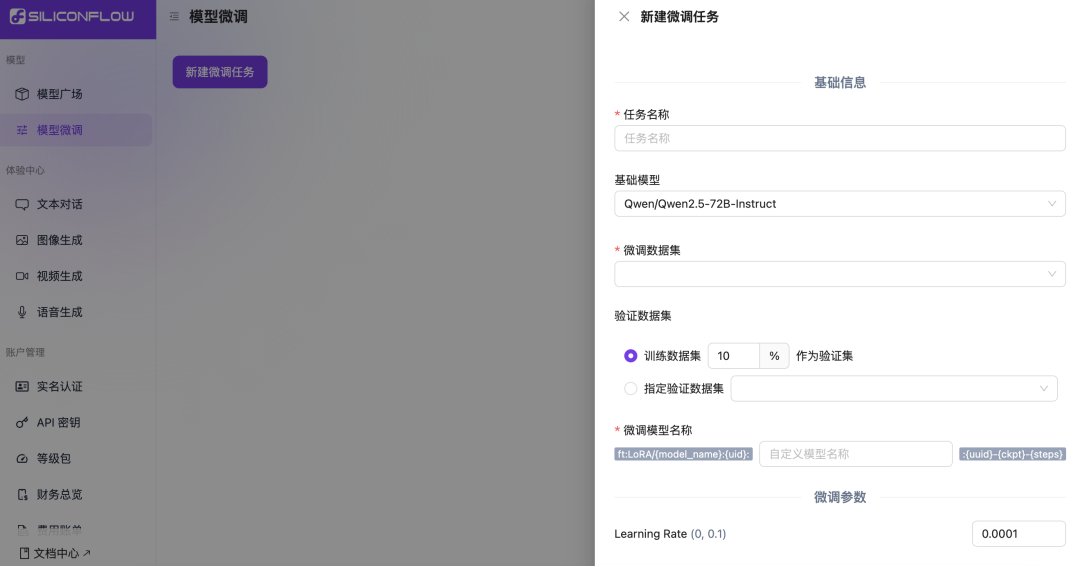

2. 配置任务

- 填写任务名称

- 选择基础模型

- 上传或选取已上传的训练数据

- 设置验证数据,支持训练集按比例切分(默认 10%),或单独选定验证集

- 配置训练参数(详情见文档:https://docs.siliconflow.cn/guides/fine_tuning)

3. 开始训练

- 点击”开始微调”

- 等待任务完成

- 获取模型标识符

4. 直接调用

-

复制模型标识符

-

通过

/chat/completionsAPI 即可直接调用微调后的模型(在线体验即将支持)

更多微调详情,请查看文档:https://docs.siliconflow.cn/guides/fine-tune

基于SiliconCloud微调服务来优化业务实战

之前硅基流动开发了“智说新语” 应用,我们通过提示词工程提供一个复杂的提示词来让大模型生成“金句”风格的描述语句。现在,我们可通过平台的微调功能来压缩提示词并提升效果,让整个的文本生成风格更统一,速度更快,且进一步优化 成本。

智说新语使用地址: *https://xy.siliconflow.cn*

\1. 在平台上使用“智说新语”的语料按上述步骤进行微调。

详细语料和代码见:https://github.com/siliconflow/siliconcloud-cookbook/tree/main/examples/fine-tune

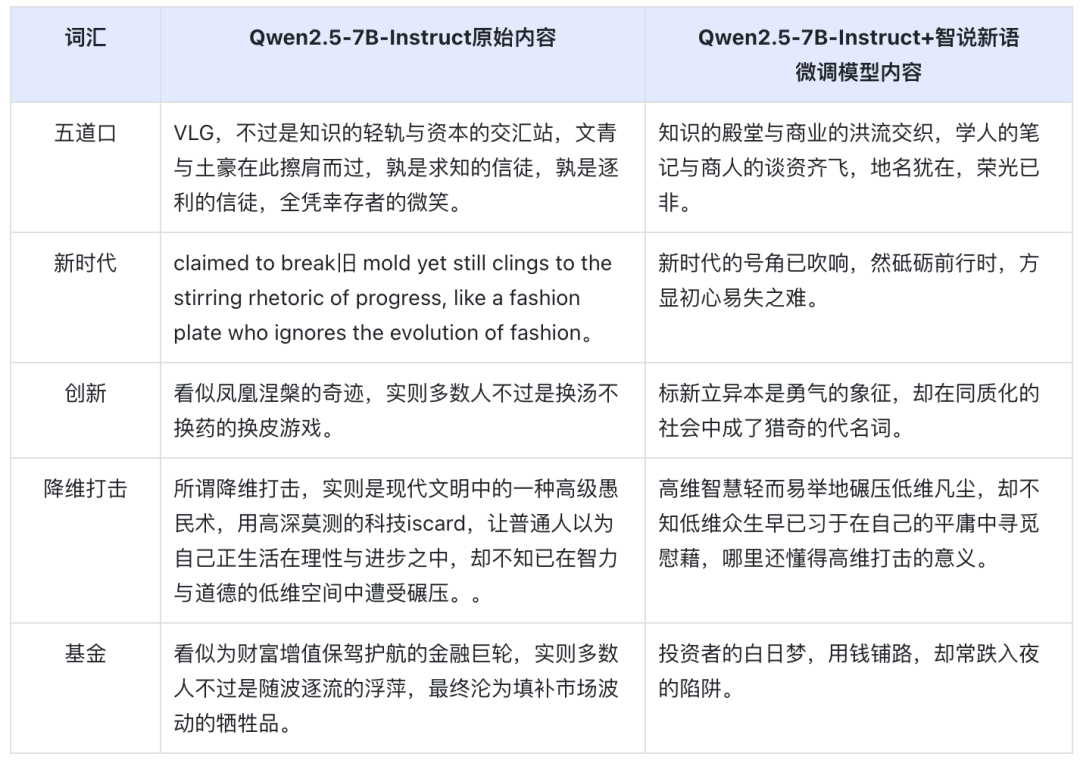

\2. 查看微调前后的效果:

输入的Prompt:

输出的内容:

智说新语语料微调总结:

\1. 微调后模型的输出内容风格更统一,整体输出效果更稳定可控。

\2. 微调后模型的输入长度从原始的203个Token降低至8个Token,显著降低了输入Token长度,响应速度更快,成本得以进一步优化。

结语

对个人开发者与生成式AI团队而言,微调模型以应对特定业务需求已是常态,这种方式让他们不必承担从头训练的高昂成本,而是利用自己业务的特定数据集,就可以增强顶尖语言模型的能力,更好满足特定行业需求和应用场景。

SiliconCloud上线的微调服务能帮助用户以高性价比的成本快速训练专属模型。很快,SiliconCloud还将支持模型托管服务,支持微调到部署的全流程服务,让用户无需关注模型层面的底层技术细节,而是专注高效产品开发,以极低成本开发出有独特优势的生成式AI应用。

如何学习大模型

现在社会上大模型越来越普及了,已经有很多人都想往这里面扎,但是却找不到适合的方法去学习。

作为一名资深码农,初入大模型时也吃了很多亏,踩了无数坑。现在我想把我的经验和知识分享给你们,帮助你们学习AI大模型,能够解决你们学习中的困难。

下面这些都是我当初辛苦整理和花钱购买的资料,现在我已将重要的AI大模型资料包括市面上AI大模型各大白皮书、AGI大模型系统学习路线、AI大模型视频教程、实战学习,等录播视频免费分享出来,需要的小伙伴可以扫取。

一、AGI大模型系统学习路线

很多人学习大模型的时候没有方向,东学一点西学一点,像只无头苍蝇乱撞,我下面分享的这个学习路线希望能够帮助到你们学习AI大模型。

二、AI大模型视频教程

三、AI大模型各大学习书籍

四、AI大模型各大场景实战案例

五、结束语

学习AI大模型是当前科技发展的趋势,它不仅能够为我们提供更多的机会和挑战,还能够让我们更好地理解和应用人工智能技术。通过学习AI大模型,我们可以深入了解深度学习、神经网络等核心概念,并将其应用于自然语言处理、计算机视觉、语音识别等领域。同时,掌握AI大模型还能够为我们的职业发展增添竞争力,成为未来技术领域的领导者。

再者,学习AI大模型也能为我们自己创造更多的价值,提供更多的岗位以及副业创收,让自己的生活更上一层楼。

因此,学习AI大模型是一项有前景且值得投入的时间和精力的重要选择。

237

237

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?