1 简介

MindIE Service是面向通用模型场景的推理服务化框架,通过开放、可扩展的推理服务化平台架构提供推理服务化能力,支持对接业界主流推理框架接口,满足大语言模型的高性能推理需求。

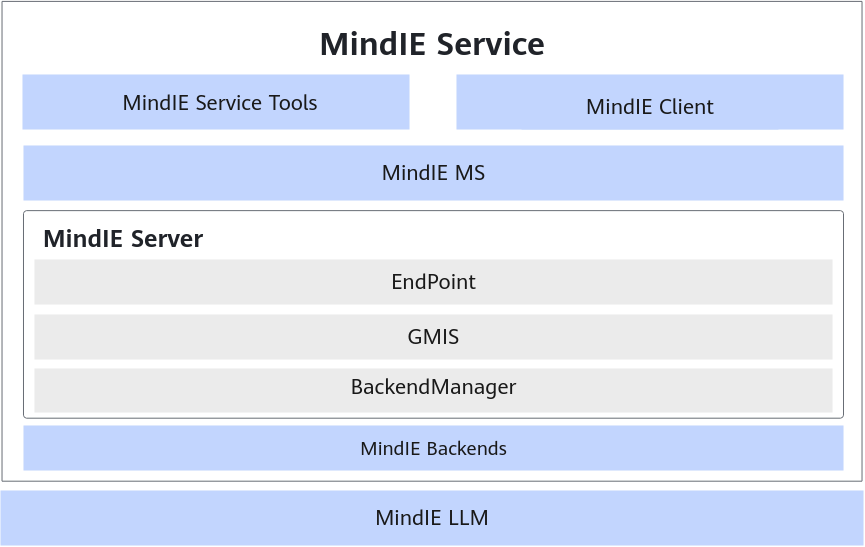

MindIE Service的组件包括MindIE Service Tools、MindIE Client、MindIE MS(MindIE Management Service)和MindIE Server,通过对接昇腾推理加速引擎带来大模型在昇腾环境中的性能提升,并逐渐以高性能和易用性牵引用户向MindIE原生推理服务化框架迁移。其架构图如图1所示。

MindIE Service 提供推理服务化部署和运维能力。

- MindIE Service Tools:昇腾推理服务化工具;主要功能有大模型推理性能测试、精度测试、可视化以及自动寻优的能力,并且支持通过配置提升吞吐。

- MindIE Client:昇腾推理服务化完整的Client客户端;配套昇腾推理服务化MindIE Server提供完整的推理服务化能力,包括对接MindIE Server的通信协议、请求和返回的接口,提供给用户应用对接。

- MindIE MS:服务策略管理,提供服务运维能力。主要功能包括模型Pod级和Pod内实例级管理、简化部署并提供服务质量监控、模型更新、故障重调度和自动扩缩负载均衡能力,不仅能够提升服务质量,同时也能提高推理硬件资源利用率。

- MindIE Server

:推理服务端;提供模型推理服务化能力,支持命令行部署RESTful服务。- EndPoint:提供RESTful接口;EndPoint面向推理服务开发者提供RESTful接口,推理服务化协议和接口封装,支持Triton/OpenAI/TGI/vLLM主流推理框架请求接口。

- GMIS:模型推理调度器,提供多实例调度能力;实现从推理任务调度到任务执行的可扩展架构,适应各类推理方法。

- BackendManager:模型执行后端,昇腾后端和自定义后端的管理模块;Backend管理模块面向不同推理引擎,不同模型,提供统一抽象接口,便于扩展,减少推理引擎、模型变化带来的修改。

- MindIE Backends:支持昇腾MindIE LLM后端。

- MindIE LLM:提供大模型推理能力,同时提供多并发请求的调度功能。

2 性能调优流程

通过参数调优,使吞吐率(TPS)达到时延约束条件下的最大值。

首先,大家需要对调优的一些参数做一个了解。

2.1 最优性能参数配置项

最优性能配置各参数说明及取值如下表所示。

最优性能参数配置

| 配置类型 | 配置项 | 配置介绍 | 推荐配置 |

|---|---|---|---|

| 调度配置 | maxPrefillBatchSize | Prefill阶段一个batch中包含请求个数的上限。 | 小于等于maxBatchSize的值,建议设置为:maxBatchSize/2 ,若显存溢出可适当调小。 |

| maxPrefillTokens | Prefill阶段一个batch中 |

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

1360

1360

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?