传统卷积神经网络最后使用全连接层,NiN只对通道层做全连接并且像素之间共享权重。

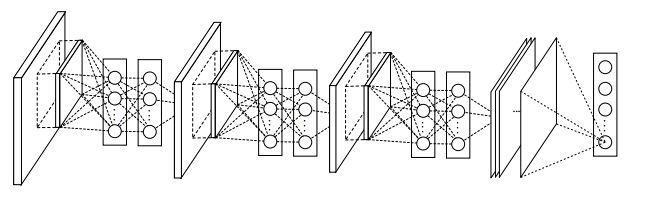

网络结构图如下:

NiN有两个特点:

1.使用mlpconv网络层替代传统的convolution层。

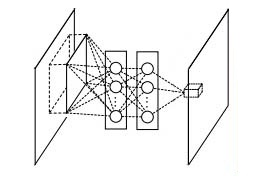

mlpconv层可以看成是每个卷积的局部感受野中还包含了一个微型的多层网络。

mlp层实际上是卷积加传统的mlp(多层感知器),因为convolution是线性的,而mlp是非线性的,后者能够得到更高的抽象,泛化能力更强。

mlp结构为一个卷积层加上两个(1*1)卷积层。

利用多层mlp的微型网络,对每个局部感受野的神经元进行更加复杂的运算,而以前的卷积层,局部感受野的运算仅仅只是一个单层的神经网络。一般来说mlp是一个三层的网络结构。

1×1的卷积作用:

a.实现跨通道的交互和信息整合

如果当前层和下一层都只有一个通道那么1×1卷积核确实没什么作用,但是如果它们分别为m层和n层的话,1×1卷积核可以起到一个跨通道聚合的作用.

b.进行卷积核通道数的降维和升维

如当前层为 (x×x×m),即图像大小为(x×x),特征层数为m,然后如果将其通过

1×1的卷积核,特征层数为n,只要

n<m

就能起到降维的目的,减少之后步骤的运算量

2.不使用全连接层

传统的卷积神经网络卷积运算一般是出现在低层网络,最后一个卷积层的特征图通过量化然后与全连接层连接,最后在接一个softmax逻辑回归分类层。然而,全连接层因为参数个数太多,往往容易出现过拟合。

NiN使用Global Average Pooling取代最后的全连接层,因为全连接层参数多且易过拟合。具体的做法是移除全连接层,在最后一层,后面加一层Average Pooling层。

Average Pooling层,对每个特征图一整张图片进行全局均值池化,这样每张特征图都可以得到一个输出。这样采用均值池化,连参数都省了,可以大大减小网络,避免过拟合,另一方面它有一个特点,每张特征图相当于一个输出特征,然后这个特征就表示了我们输出类的特征。

Network in Network

最新推荐文章于 2024-03-20 00:40:28 发布

2万+

2万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?