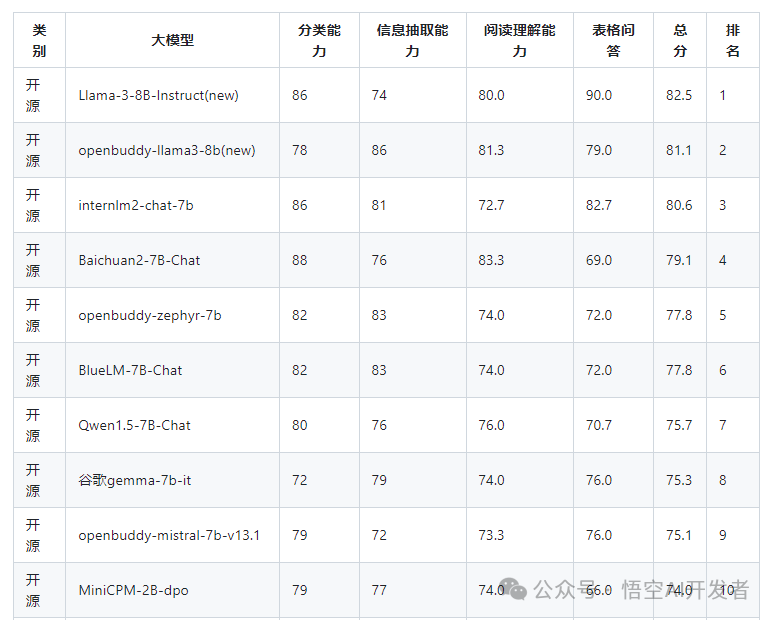

今天给大家带来 AI 大模型领域的国产之光 - InternLM2,在10B量级开源大模型领域取得了全球 Top 3 的成绩,仅次于 Meta 发布的 Llama-3,在国内则是第一名的存在!

简介

InternLM2是由上海人工智能实验室和商汤科技联合研发的一款大型语言模型(LLM),它在多个基准测试中展现出卓越的性能,尤其在长文本处理和开放式主观评估方面。以下是InternLM2的几个关键特点:

-

长文本处理能力:InternLM2特别设计了长上下文处理能力,能够处理长达200k个令牌的文本,这使得它在处理长篇幅内容时表现出色。

-

开源和免费商用:InternLM2模型及其全链条开源工具体系面向公众全面开源,并且可以免费商用,这促进了其在学术和工业界的广泛应用。

-

多阶段训练:模型的训练包括预训练、监督微调(SFT)和基于人类反馈的强化学习(RLHF)。这些阶段确保了模型在遵循指令和符合人类价值观方面的性能。

-

技术创新:InternLM2采用了分组查询注意力(GQA)技术来减少长序列推断时的内存占用,并通过位置编码外推技术进一步提升了模型的上下文长度处理能力。

-

性能提升:通过条件在线RLHF(COOL RLHF)技术,InternLM2能够协调多样但可能冲突的偏好,并通过多轮Proximal Policy Optimization(PPO)来减少奖励作弊问题。

-

社区贡献:InternLM2的贡献不仅在于其高性能,还在于提供了全面的数据准备指南和创新的RLHF训练技术,为社区提供了深入理解和进一步研究的基础。

-

模型规模:InternLM2发布了不同规模的模型,包括18亿、70亿和200亿参数的版本,以适应不同的研究和应用需求。

分类

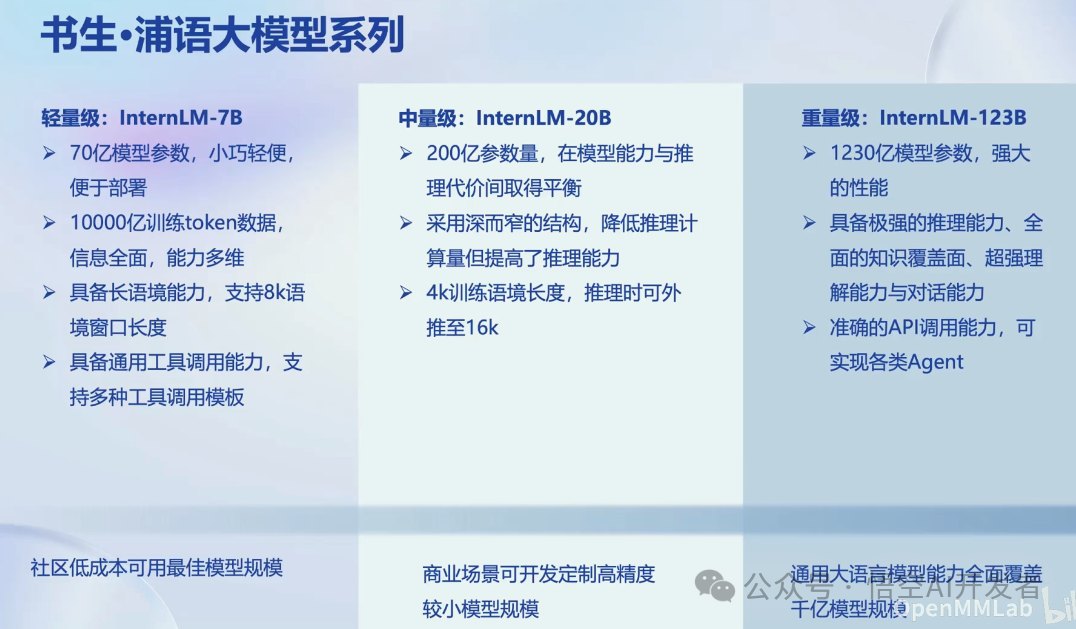

按照模型大小分类

7B:为轻量级的研究和应用提供了一个轻便但性能不俗的模型

20B:模型的综合性能更为强劲,可有效支持更加复杂的使用场景

按照模型命名分类

InternLM2-Base:高质量和具有很强可塑性的模型基座,是模型进行深度领域适配的高质量起点

InternLM2:在Base基础上,在多个能力方向进行了强化,在评测中成绩优异,同时保持了很好的通用语言能力,是我们推荐的在大部分应用中考虑选用的优秀基座

InternLM2-Chat:在Base基础上,经过SFT和RLHF,面向对话交互进行了优化,具有很好的指令遵循,共情聊天和调用工具等能力

技术生态

训练&评测数据

模型微调

模型评测

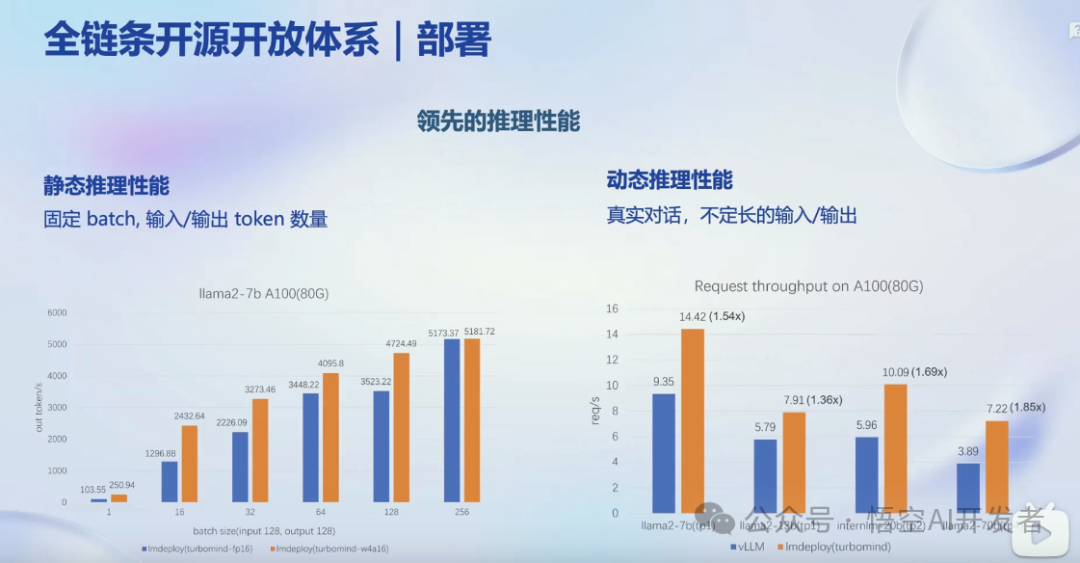

模型部署

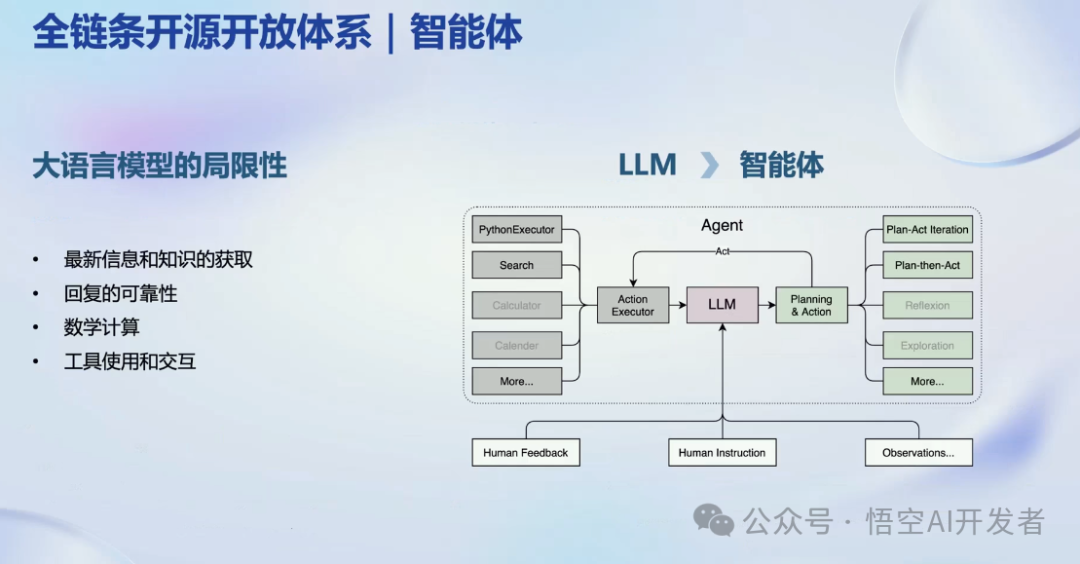

AI 智能体

接下来的文章将详细讲解如何用 internLM2 训练我们自己的 chatGPT,感兴趣的可以点赞收藏关注!

1816

1816

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?