目录

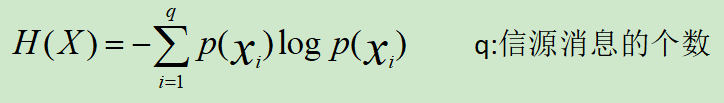

信息熵:

信源所含有的信息量称为信息熵,定义为信源发出的所有可能消息的平均不确定性,为自信息的统计平均。(自信息:某个消息X出现的不确定性的大小)

含义:①信源的平均不确定性的大小②信源输出消息平均所含的信息量

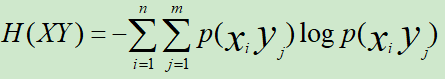

联合熵:

二维随机变量XY的联合熵定义为联合自信息的数学期望,表征XY的不确定性

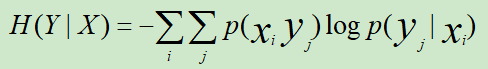

条件熵:

条件熵定义为给定条件下Y的条件概率分布的熵对X的数学期望

其中,联合熵=信息熵+条件熵。

![]()

熵是服从某一特定概率分布事件的理论最小平均编码长度。只要我们知道了任何事件的概率分布,我们就可以计算它的熵;那如果我们不知道事件的概率分布,又想计算熵,该怎么做呢?那我们来对熵做一个估计吧,熵的估计的过程自然而然的引出了交叉熵。

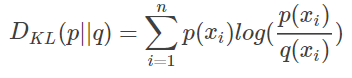

相对熵:(KL散度)

如果我们对于同一个随机变量 x 有两个单独的概率分布😋 P(x) 和😌 Q(x),我们可以使用KL散度来衡量这两个分布之间的差距

即用P描述目标问题,和用Q描述目标问题,之间的信息增量

而P往往表示样本的真实分布,比如[1,0,0]表示样本属于第一类;Q用来表示模型所预测的分布,比如[0.8,0.1,0.1]也可以描述样本属于第一类,但不够完美,离真实值有一定差距。

如果我们可以用P来描述样本就好了,所以Q需要用一些信息增量才可以达到P。

此时就需要训练Q,使之Q等价于P,也就不再需要信息增量。

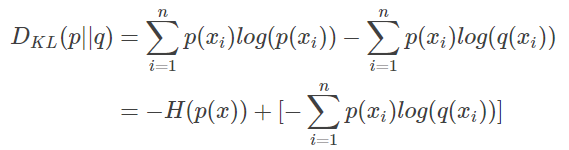

KL散度的公式为:

,其中n为个数。DKL越小,证明P和Q越接近

对DKL进行变形得到:

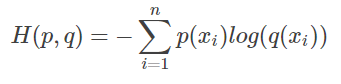

可以发现前面其实就是P的熵,而后面则定义为交叉熵

DKL(p||q)=H(p,q)−H(p)(当用非真实分布 q(x) 得到的平均码长比真实分布 p(x) 得到的平均码长多出的比特数就是相对熵),即在给定的真实分布下,使用非真实分布所指定的策略消除系统的不确定性所需要付出的努力的大小

19万+

19万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?