1.1 AlphaGo的主要原理

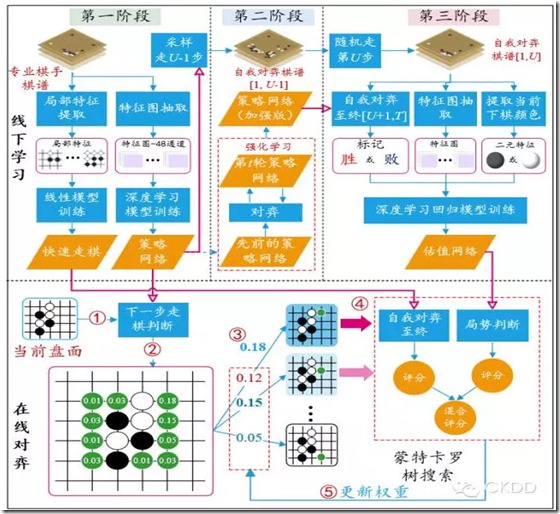

AlphaGo是由三个不同部分组成:

(1)估值网络:估计棋局的状态(运行时没有任何搜素动作),计算谁领先了,领先了多少步--计算每一方赢的概率

(2)走棋策略网络:给定当前局面,预测/采样下一步的走棋,运行时也没有进行任何搜索。

(3)树搜索(MCTS, 蒙特卡洛树搜索):把两个网络结合在一起,模拟下一步会发生什么,并通过策略网络选择最佳的落子位置。

1.1.1 策略网络

1.1.2 MCTS拯救了围棋算法

1.1.3 强化学习:“周伯通,左右互搏”

1.1.4 估值网络

1.1.5 将所有组合到一起:树搜索

1.1.6 AlphaGo有多好

1.1.7 总结

可简单总结为:首先通过估值网络评估棋局情况,其次再通过一个快速的策略网络选择下一步的位置,一直下到最后。

参考:http://www.leiphone.com/news/201603/VARZ2sn7aC2DPBkw.html

1930

1930

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?