回顾去年的DCNN成果和深度学习发展,就必然会提及到到Kaiming He的深度残差网络 (

https://arxiv.org/abs/1512.03385)。这不仅是因为ResNet一举拿到了CV下多个比赛项目的冠军,更重要的是这一结构解决了训练极深网络时的degradation问题。作为我来到MSRA第一个月重点学习的论文,现在在这里分享一下我这大半个月以来的学习成果。

1.论文解读

He首先提出一个问题:Is learning better networks as easy as stacking more layers?回答这个问题的一个障碍在于一个著名的问题:梯度消失/爆炸,然而这个障碍可以通过合理的初始化和其他一些技术来解决,接下来看一张图:

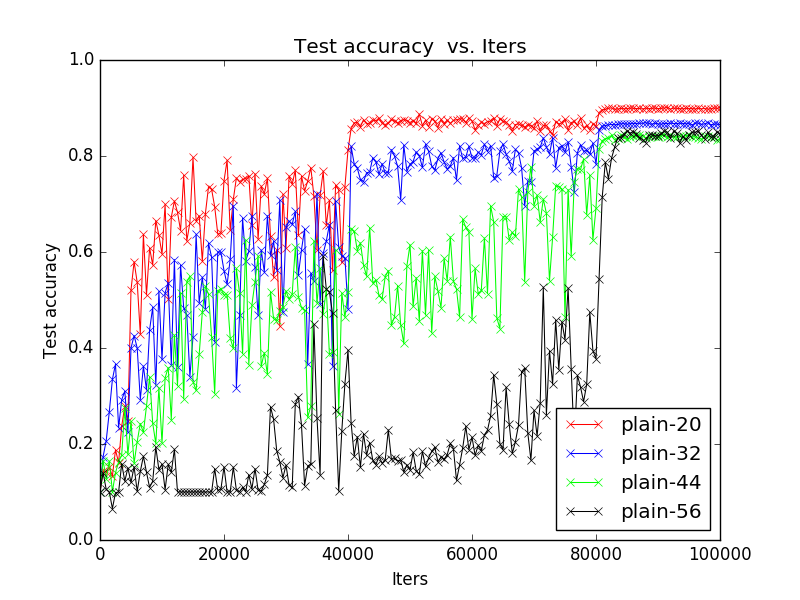

这是我在论文结果复现时在CIfar10上复现的训练过程图,plain-20代表不含残差结构的纯粹的20层的网络结构,很明显可以看出随着网络深度增加,performance却在下降。He将这一现象称为degradation,亦即随着网络深度的增

本文深入探讨了深度残差网络(Deep Residual Network, ResNet)的设计思想,旨在解决深度神经网络中的退化问题。作者通过复现实验展示了ResNet如何在增加网络深度的同时避免性能下降,对比了不同初始化方法对网络性能的影响,并讨论了未来的研究方向,包括数据增强、批量归一化和更深层次网络的实现。"

84911089,8136609,链家网大数据平台构建:从0到1再到平台化,"['大数据', '运维', 'Python', '数据仓库']

本文深入探讨了深度残差网络(Deep Residual Network, ResNet)的设计思想,旨在解决深度神经网络中的退化问题。作者通过复现实验展示了ResNet如何在增加网络深度的同时避免性能下降,对比了不同初始化方法对网络性能的影响,并讨论了未来的研究方向,包括数据增强、批量归一化和更深层次网络的实现。"

84911089,8136609,链家网大数据平台构建:从0到1再到平台化,"['大数据', '运维', 'Python', '数据仓库']

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

3366

3366

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?