1. Why we need Machine Learning

我们很难找到一些规则或者直接编写程序来解决一个问题,比如这样的问题:

- 三维物体的识别——我们不知道我们的大脑是如何识别物体的,不能找到很好地规则来描述这个问题,即使能找到比较好的规则,编程的复杂度也可能会非常高。

- 欺骗性的信用卡交易——所谓道高一尺魔高一丈,骗子的手法总是在不断更新的,我们需要一个可以不断更新,并不断识别骗局的程序。

使用机器学习的方法可以很好地解决上面的问题:

- 我们不用自己去设计规则,只需要给定足够多的数据就好了

- 我们不用担心场景的变化(比如骗子的手法更新),只要新的数据在变化,我们的判断标准也再相应的变化。

- 现在的计算资源非常充足,这也使得机器学习成为了可能。

实际生活中有很多机器学习的问题:

- 语音识别(My major research)

- 图像的识别

- 欺骗性信用卡交易的识别

这些都是使用机器学习非常好的动力。那么问题来了,机器学习是什么?

2. What is Machine Learning

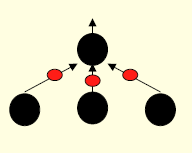

在谈什么是机器学习之前,我们必须先对人大脑中的神经进行一些了解。下面是一个典型的突触结构:

我们的神经元大多是这样联系在一起的,一个神经元的轴突末端变大,与另一个的神经元的胞体(细胞体)或树突联系在一起,中间包含突触前膜、突触间隙、突触后膜。一次神经间的信息传递是这样一个过程(这只是一个大概的过程,其中也许有不严谨的地方,欢迎批评指出,毕竟这也不是我的专业。。。):

- 上一个神经元的电信号传递过来之后,线粒体产生能量,推动突触小泡移动到突触前膜,释放相应的神经递质

- 突触小泡与突触前膜融合释放神经递质到突触间隙

- 神经递质移动到突触后膜或者移动到别的地方,总之在下一次之前这次的神经递质一定会被消耗(被受体,或者被以其他的方式消耗,也许被分解?anyway)

- 突触后膜上的受体接受到神经递质之后会产生电位变化,产生脉冲信号。从而将刺激向后传递

突触中有几个地方需要注意:

- 神经元中的递质有兴奋性和抑制性两种,所以神经元也分成了兴奋性和抑制性两种

- 在不同的神经元中囊泡(递质就在这里面)的数量是不同的

- 每个神经元都不是与单个神经元连接的,通常一个神经元会有 104 个神经元与它连接

- 本次神经元产生冲动与否取决于所有与它相连的神经递质效果的总和。

神经元之间关系的一个抽象表示

另外,我们的大脑有值得注意的特点:

- 大脑是分区的,不同的区域有不同的分工

- 大脑中的区域一开始有相同的功能,后面逐步变化,开始做不同的工作

- 大脑是高度并发计算的,和我们传统的计算机的串行计算不同(一条指令一条指令的执行,图灵机模型)

3. Some simple neurons

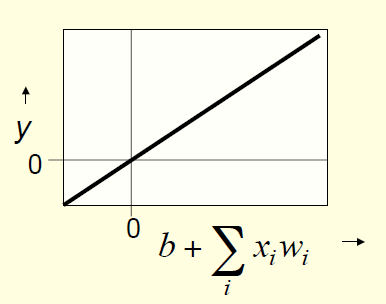

1. Linear neurons

考虑突触的特点,我们可以得到一种可能的,同时也是最简单,最理想化的神经元抽象:

y=b+∑ixiwi

其中:

- y 表示神经元的输出

xi 表示与该神经元相连的第i个神经元的输出- wi 表示这第i个神经元的权重

b 是一个偏置常数,暂时可以先不管

Linear neurons

在这个最简单的神经元中我们忽略了很多真实神经元的特征,比如,我们神经元可能并不是线性的,它对其他神经元递质的综合方式可能不是简单的加权求和。为什么呢?因为这样会导致它的变化是没有界的,可能会很大也可能会很小,而我们身体中能产生的电流基本是恒定大小的,电位差也是在一个区间内变化的。所以人们又找了很多函数来对神经元进行建模。

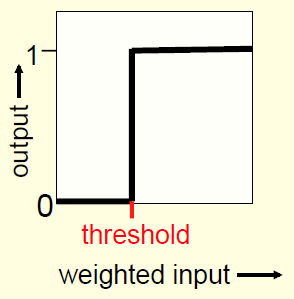

2. Binary threshold neurons

Binary threshold neurons

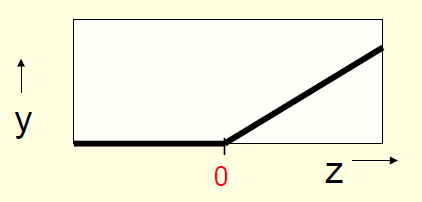

3. Rectified Linear Neurons

z=b+∑ixiwiy={z,0,if z > 0otherwise

Rectified Linear Neurons

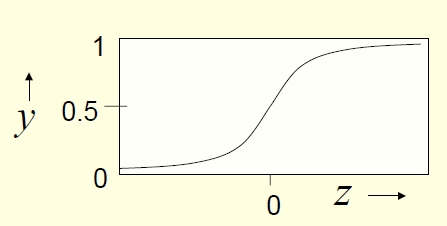

4. Sigmoid neurons

z=b+∑ixiwiy=11+e−z

Sigmoid neurons

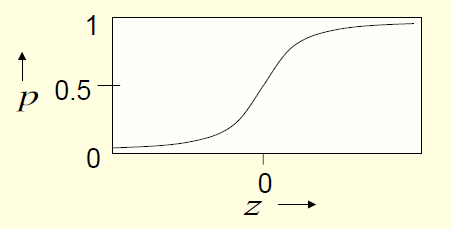

5. Stochastic binary neurons

z=b+∑ixiwip(y=1)=11+e−z

Stochastic binary neurons

注意:这个和Sigmoid neurons的区别,它表示神经元兴奋的可能性,也就是兴奋与否的概率大小。

4. Types of Machine Learning

机器学习的任务通常可以划分成如下的三种:

- 有监督学习,通常对于每个输入都会有一个事先标记好的输出作为对应。可以分为回归问题和分类问题两种。

- 增强学习,它的任务是确定一系列的决策,这系列的决策在将来看来可以避免最多的损失,或者获得最大的收益。

- 无监督学习,这个学习任务通常被理解为聚类的操作,即把一些一些数据分为一类,它通常可以看做是在找到一些事物的内部特征。可以用来做数据压缩等任务。

5951

5951

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?