22年10月来自华盛顿大学、Meta 和 AI2 (Seattle) 研究的论文“Rethinking the Role of Demonstrations: What Makes In-Context Learning Work?“。

大语言模型(LM)能够进行上下文学习——对一些输入-标签对(演示)进行调节并对新输入进行预测,仅通过推理来执行新任务。 然而,人们对模型如何学习以及演示的哪些方面有助于最终任务的性能知之甚少。 本文表明事实上不需要真值演示——随机替换演示中的标签几乎不会影响一系列分类和多选任务的性能,包括 GPT-3 在内的 12 个不同模型,结果始终如此。 相反,演示的其他方面是最终任务性能的关键驱动因素,包括它们提供一些示例:(1) 标签空间,(2) 输入文本的分布,以及 ( 3)序列的整体格式。 总之,其分析提供了一种新的方式来理解上下文学习如何出现以及为何起作用,同时提出了新的问题:仅通过推理可以从大语言模型中学到多少东西。

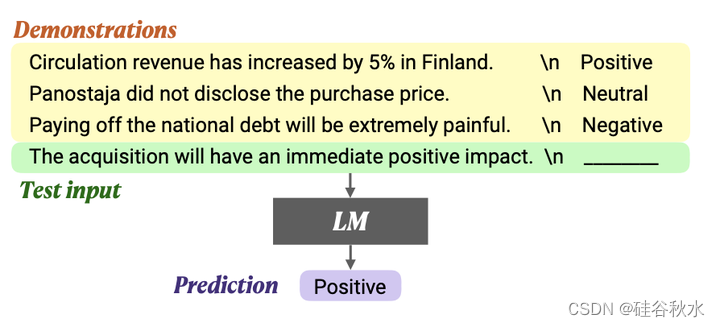

大语言模型(LM)在下游任务中表现出了令人印象深刻的性能,只需简单地以几个输入标签对为条件(演示);这种类型的推理被称为上下文学习(Brown2020)。尽管上下文学习在广泛的任务中始终优于零样本推理(Zhao2021;Liu2021),但人们对其工作原理以及演示的哪些方面有助于最终任务的表现知之甚少。

事实上,有效的上下文学习并不需要基本事实证明。具体来说,在一系列分类和多选任务中,用随机标签替换演示中的标签几乎不会影响性能。包括GPT-3家族在内的12个不同模型的结果是一致的(Radford2019;Min2021b;Wang and Komatsuzaki2021;Artetxe2021;Brown2020)。这说明与直觉相反,模型不依赖于演示中的输入标签映射来执行任务。

进一步的分析调研演示的哪些部分确实对性能有贡献。可确认演示的可能方面(例如,标签空间和输入文本的分布),并评估演示的一系列变型,量化每种变型的影响。发现:(1)由演示指定的标签空间和输入文本的分布都是上下文学习的关键(无论标签是否对单个输入正确);(2) 指定整体格式也是至关重要的,例如,当标签空间未知时,使用随机英语单词作为标签比不使用标签要好得多;以及(3)具有上下文学习目标的元训练(Min2021b)放大了这些效果——模型几乎完全利用了演示的更简单方面,如格式,而不是输入标签映射。

如图是上下文学习概述:演示由来自训练数据的 k 个输入-标签对组成(图中 k = 3);具体来说,用随机标签替换演示中的标签几乎不会影响一系列分类和多选任务的性能。

如图展示演示中的四个不同方面:输入-标签映射、输入文本的分布、标签空间以及演示的格式。

具体说:

- 输入-标签映射,即每个输入 xi 是否与正确的标签 yi 配对。

- 输入文本的分布,即 x1…xk 的分布。

- 标签空间,即 y1 …yk 覆盖的空间。

- 演示的格式——输入-标签配为格式。

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?