转发自:https://zhuanlan.zhihu.com/p/20924220892

DeepSeek-R1 是由深度求索(DeepSeek)公司开发的高性能 AI 推理模型,专注于数学、代码和自然语言推理任务。其核心优势包括:

- 强化学习驱动:通过强化学习技术显著提升推理能力,仅需少量标注数据即可高效训练。

- 长链推理(CoT):支持多步骤逻辑推理,能够逐步分解复杂问题并解决。

- 模型蒸馏:支持将推理能力迁移到更小型的模型中,适合资源有限的场景。

- 开源生态:遵循 MIT 开源协议,允许用户自由使用、修改和商用。

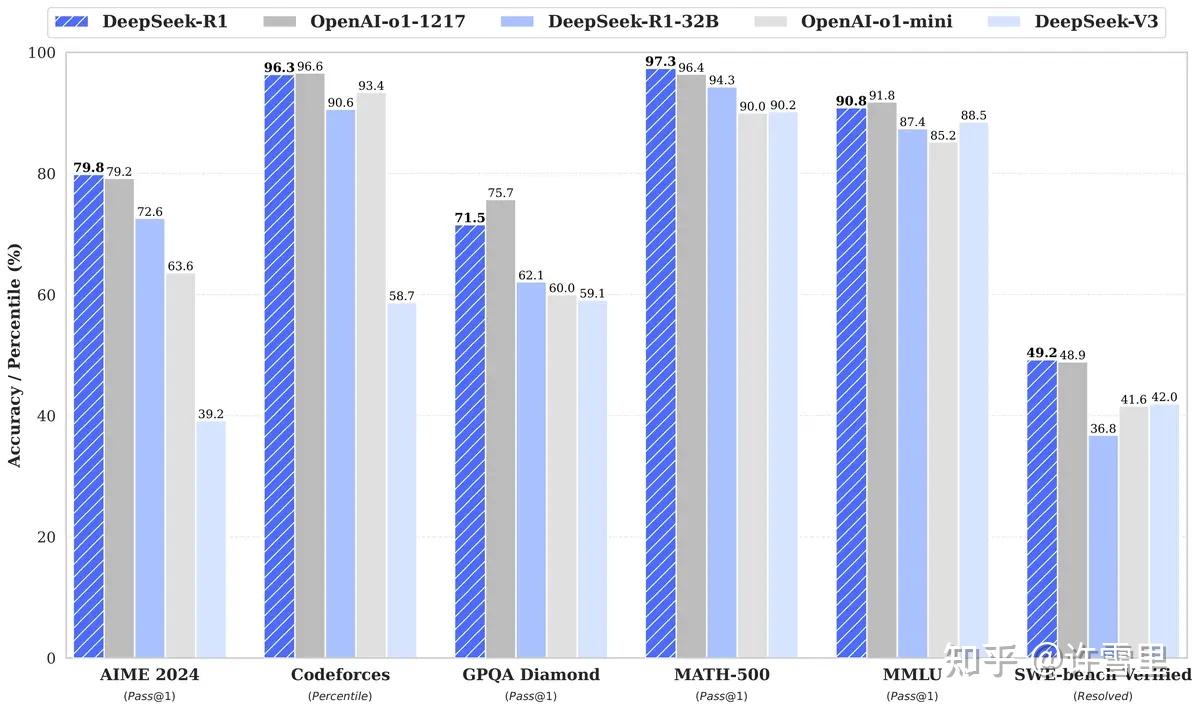

DeepSeek-R1 在多个基准测试中表现优异,性能对标 OpenAI 的 o1 正式版,同时具有更高的性价比。

image.png

3、使用 Ollama 部署 DeepSeek-R1

3.1、安装 Ollama

下载 Ollama: 访问 Ollama 官网,根据操作系统(Windows、macOS 或 Linux)下载安装包,并按照说明进行安装。

验证安装:在终端中运行以下命令验证安装:

ollama --version

如果安装成功,命令行会显示 Ollama 的版本信息。

admin@Mac-miniM4 ~ % ollama --version

ollama version is 0.5.7

3.2、下载 DeepSeek-R1 模型

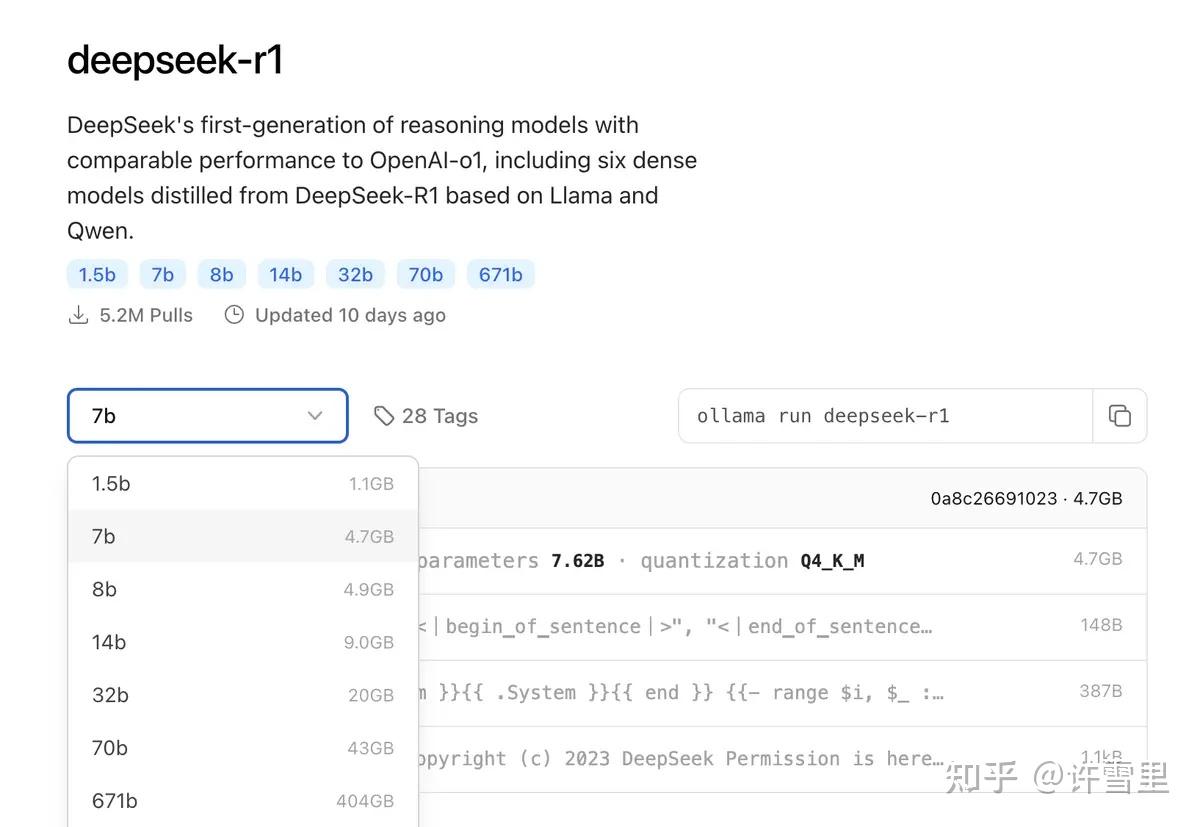

Ollama已支持DeepSeek-R1, 模型地址:deepseek-r1 。

image.png

下载模型:

根据自己的显存选择对应的模型,macmini m4 16g 可流畅支持 7b。 使用以下命令下载 DeepSeek-R1 模型:

ollama pull deepseek-r1:1.5b

查看模型信息:

下载完成后,可以使用以下命令查看模型信息:

ollama list

该命令会显示已下载的模型列表,包括名称、大小和路径等。

运行 DeepSeek-R1:

使用以下命令启动 DeepSeek-R1 模型:

ollama run deepseek-r1:1.5b

该命令会启动 DeepSeek-R1 模型,并启动一个 REPL(交互式终端),你可以在这里输入问题,模型会根据问题生成回答。

admin@Mac-miniM4 ~ % ollama run deepseek-r1:1.5b

>>> 你好,介绍一下你自己

<think>

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所

能为您提供帮助。

</think>

您好!我是由中国的深度求索(DeepSeek)公司开发的智能助手DeepSeek-R1。如您有任何任何问题,我会尽我所

能为您提供帮助。

4、部署 Open-WebUI 增强交互体验

Ollama与Open WebUI结合,可以提供更丰富的交互体验。 可选择任意支持Ollama的webUI,如 AnythingLLM、Dify、Open-WebUI 等。 - AnythingLLM:更专注于文档知识库与问答场景,自带向量检索管理,可“多文档整合”,接入 Ollama 后实现本地化问答。 - Dify:功能多元,适合对话流管理、插件化扩展、团队协同等复杂需求。只要能在其后台正确配置 Ollama 地址,即可灵活调用。 - Open-WebUI:定位纯聊天界面,支持多模型集成,你可以把它当做一个能“轻松切换模型、马上对话”的 Web 面板,如果只是想单纯体验 Ollama 的生成效果,Open-WebUI 是最方便的。

本文场景比较简单,选择与Ollama结合比较紧密的open-webui。

- Open-WebUI:https://github.com/open-webui/open-webui

- 官方文档:https://docs.openwebui.com/getting-started/quick-start/

下载 Open-WebUI:

本地使用 docker 部署Open-WebUI,使用以下命令下载 Open-WebUI:

docker pull ghcr.io/open-webui/open-webui:main

启动 Open-WebUI:

// 创建本地目录,避免重启后数据丢失

mkdir /Users/admin/program/docker/instance/open-webui/data

cd /Users/admin/program/docker/instance/open-webui

// 启动容器

docker run -d -p 3000:8080 -v $PWD/data:/app/backend/data --name open-webui ghcr.io/open-webui/open-webui:main

启动成功后,可在终端中查看容器状态,通过浏览器访问Open-WebUI:http://localhost:3000

配置 Ollama 地址:

浏览器进入 Open-WebUI 后,点击右上角的设置图标 进入设置页面。在“模型”选项卡中,点击“添加模型”,选择“Ollama”,并输入 Ollama 的地址(默认为 http://localhost:11434)。

测试功能:

在 Open-WebUI 中,你可以选择使用 Ollama 的不同模型,新建对话并体验不同的功能。

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?