代码关键词:需求响应 强化学习 动态定价

编程语言:python平台

主题:16、基于强化学习(Q-learning算法)的需求响应动态定价研究

代码内容:

代码提出了一种考虑服务提供商(SP)利润和客户(CUs)成本的分层电力市场能源管理动态定价DR算法。

用强化学习(RL)描述了动态定价问题为离散有限马尔可夫决策过程(MDP)的递阶决策框架,并采用Q学习来求解该决策问题。

在在线学习过程中,利用RL,SP可以自适应地确定零售电价,其中考虑了用户负荷需求曲线的不确定性和批发电价的灵活性。

仿真结果表明,本文提出的DR算法能够提高SP的盈利能力,降低CUs的能源成本,平衡电力市场的能源供需,提高电力系统的可靠性,是SP和CUs双赢的策略

复现论文题目:A Dynamic pricing demand response algorithm for smart grid: Reinforcement learning approach

ID:4869692877864074

小代码狂人

基于强化学习(Q-learning算法)的需求响应动态定价研究

摘要:随着智能电网的发展,电力市场的能源管理变得更加复杂。为了实现有效的需求响应和动态定价,本研究使用强化学习算法Q-learning对分层电力市场提出了一种新的动态定价算法。该算法考虑了服务提供商(SP)的利润和客户(CUs)的成本,通过自适应地确定零售电价来平衡电力市场的能源供需。

-

引言

随着智能电网技术的快速发展,电力市场能源管理的复杂性日益增加。需求响应和动态定价作为重要的研究领域,旨在实现电力市场的有效运作。本研究旨在通过使用强化学习算法Q-learning,提出一种基于需求响应的动态定价算法,以实现电力市场的供需平衡和SP与CUs的双赢。 -

需求响应与动态定价

需求响应是指通过调整用户负荷需求曲线来平衡电力供应与需求。动态定价则是根据市场条件和用户需求,灵活地确定零售电价。两者的结合可以实现电力市场的高效运行和资源优化。 -

Q-learning算法

Q-learning是一种基于强化学习的算法,用于解决离散有限马尔可夫决策过程(MDP)问题。在本研究中,我们将动态定价问题描述为MDP,并使用Q-learning算法来求解该决策问题。通过不断迭代更新Q值,算法可以寻找到最优的定价策略。 -

强化学习算法在需求响应动态定价中的应用

本研究将强化学习算法应用于需求响应动态定价中,以实现电力市场的供需平衡和SP与CUs的双赢。通过在线学习过程,SP可以根据用户负荷需求曲线的不确定性和批发电价的灵活性,自适应地确定零售电价。 -

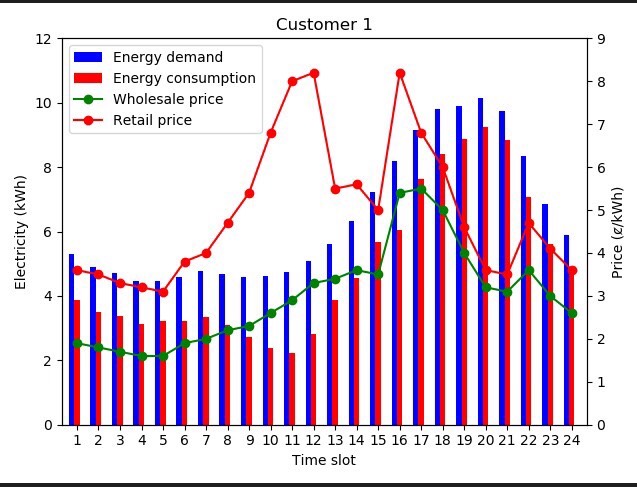

仿真实验及结果分析

本研究通过仿真实验验证了所提出的DR算法的有效性。结果表明,该算法能够提高SP的盈利能力,降低CUs的能源成本,平衡电力市场的能源供需,并提高电力系统的可靠性。这一策略为SP和CUs带来了双赢的局面。 -

结论

本研究通过基于强化学习的需求响应动态定价算法,实现了电力市场的供需平衡和SP与CUs的双赢。通过不断优化零售电价,该算法能够提高SP的盈利能力,降低CUs的能源成本,并增强电力系统的可靠性。未来,我们将进一步研究该算法在实际电力市场中的应用。

关键词:强化学习、需求响应、动态定价、Q-learning算法、电力市场、智能电网

【相关代码 程序地址】: http://nodep.cn/692877864074.html

376

376

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?