背景:

卷积神经网络已经被证明是一个在应用于各种视觉任务上能够获得有效效果的模型。在现有的神经网络模型的每个卷积网络层中,各个卷积核学习输入的特征图中各个通道以及特征图的空间上的局部关联模式的表达(局部关联就是局部在卷积核的大小上)。通过多个卷积层中的一系列的非线性相关的卷积核以及下采样层来捕捉全局感受野上的各个层次的图片表示,而近期的神经网络模型的发展过程也显示了网络模型的捕捉数据空间关联性(就是——提取特征)的能力可以在无需通过附加的更多监督学习方式的情况下只通过在网络模型中精准的嵌入相应学习机制来改善。(整句话的大意就是神经网络模型的特征提取能力可以通过改进网络结构来提高,而无需通过更多的监督学习方式来提高)。已有的网络模型改进技术有谷歌的Inception系列的网络模型架构,Inception通过在网络模型中嵌入多尺度特征提取方法来使得网络模型能够获得相当的准确率。除此之外还有许多工作从寻找更好的网络模型依赖关系以及整合特征空间倾向机制角度进行展开。

总体技术思路:

在以上工作的背景下,作者提出了一种新的网络模型设计角度——即通道关系,从这个角度出发作者提出了一种新的网络结构单元,作者称之为“Squeeze-and-Excitation”网络块。作者的定位是通过精确的建模卷积特征各个通道之间的作用关系来改善网络模型的表达能力。为了达到这个期望,作者提出了一种能够让网络模型对特征进行校准的机制,使网络从全局信息出发来选择性的放大有价值的特征通道并且抑制无用的特征通道。

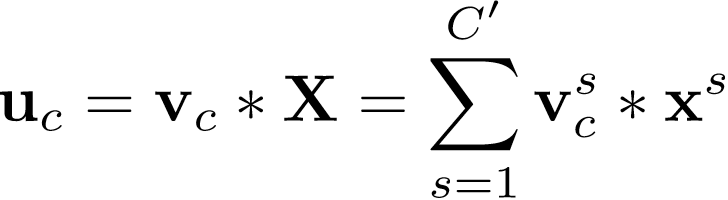

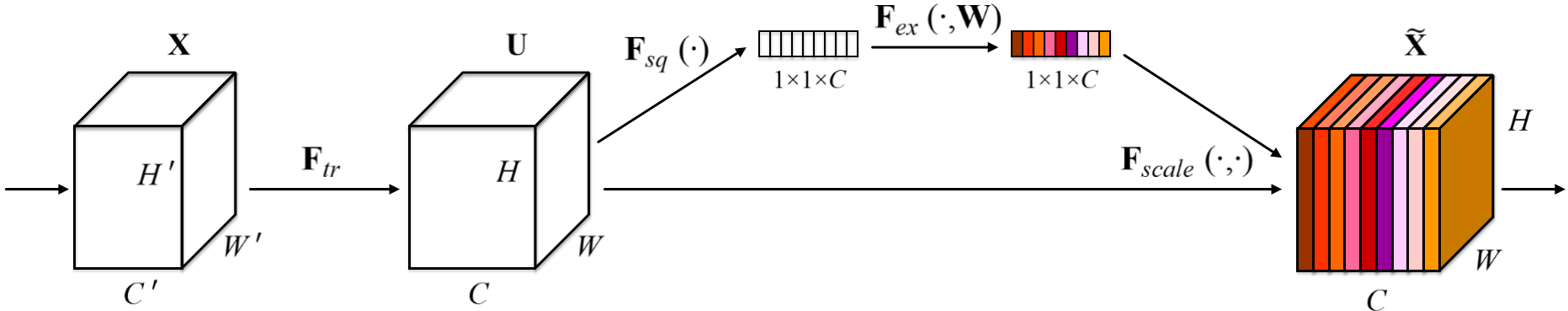

作者所提出的SE网络模块如下图1所示,对于任意给定的信息进入网络模块后进行操作为:,

,

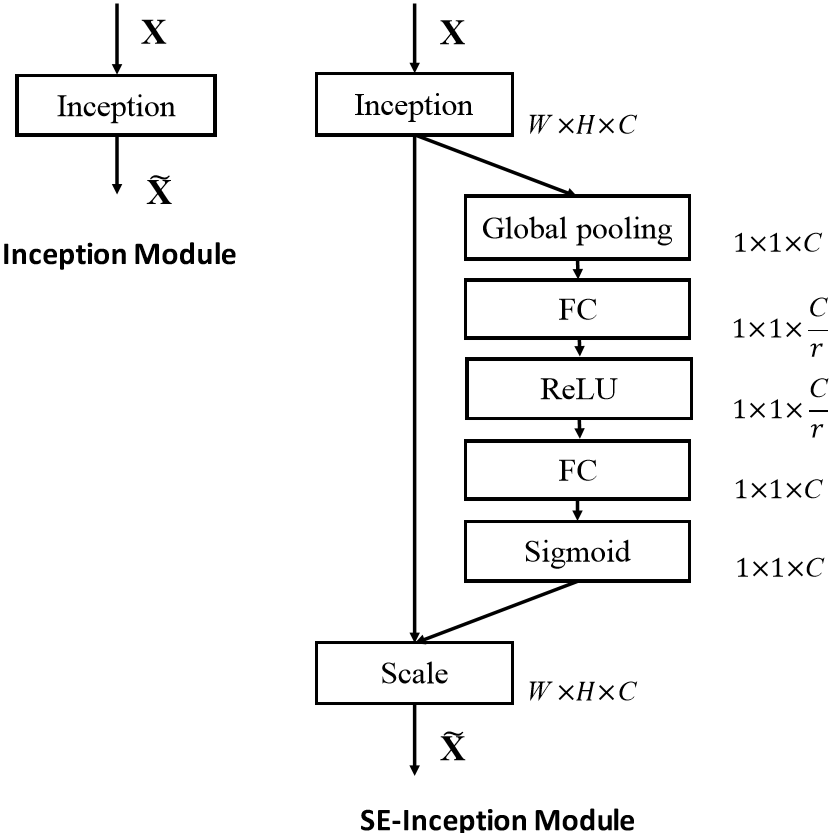

(此处可表示一次或多次卷积操作),作者构建SE网络模块进行特征调整的过程如下图1所示,特征U首先通过一个squeeze操作,将特征图聚合获得维度为WxH的特征图以此作为特征描述器,经过池化操作将各个特征图的全局感受野的空间信息置入到特征图中这个特征图成为descriptor(描述器),而后面的网络层就能够根据这个descriptor特征图获得全局感受野的信息——这就是整个squeeze操作。随后再接着进行excitation操作,在excitation操作中,每层卷积操作之后都接着一个样例特化(sample-specific)激活函数,基于通道之间的依赖关系对每各个通道过一种筛选机制(self-gating mechanism)操作,以此来对各个通道进行权值评比(excitation),特征图组U在经过这种筛选机制对feature maps中的特征图进行权值评估(excitation)后就是SE网络模块的最终输出了,之后再将这些特征图组作为后续网络层的输入。整个个SE网络模型通过不断堆叠SE网络模块进行构造,SE网络模块能够在一个网络模型中的任意深度位置进行插入替换,如下图2所示,SE网络模块可以随着在网络层任意插入而自动适应网络模型的需求。SE网络模块能够以一种未知的方式(因为现在神经网络的具体原理机制还是黑匣子)对特征组进行权值奖惩,加强了所在位置的特征图组的表达能力,在之后的网络层,SE网络模块会不断的特化,并且以一个高度特化类别的方式对所在不同深度的SE网络模块的输入进行相应,因此在整个网络模型中,特征组图的调整的优点能够通过SE网络模块不断地累计。

图1

图2

技术详解:

注意力和门控机制(Attention and gating mechanisms):

广泛的讲,注意力(Attention)可以被看作是一个工具,它用于 将可用处理资源的分配偏向一个输入信号量中 的最有价值的信息进行分配,注意力(Attention)机制在神经元科学中是一个具有相当的研究历史的领域,在近年来的研究工作中,在图像标题和唇语领域注意力(Attention)机制被应用于高效的聚合多模块数据的应用,这也展现了它的可应用性,在这些应用中,它一般被用于多个模块之间在一层或多层表示的更高维抽象信息表示的调整。在门机制的研究领域中,Highway网络使用了一种门机制来调节shortcut conection,以帮助非常深的网络模型进行学习。SE网络模块的提出就是一种轻量级的门机制,针对特征图通道中的关系以一种高效的计算方式进行建模并在网络中被设计用于增强网络模块的表达能力。

压缩奖惩网络模块(Squeeze-and-Excitation Blocks)

Squeeze-and-Excitation网络模块是一种能够对任意输入信息:

此处*操作符表示卷积操作,,

(为了简化符号表示,此处两个符号解释省略了偏置项参数),式中

是一个二维空间卷积,vc表示它的每个通道作用于X的对应的通道特征图。因为如上所示的输出是由所有通道之和产生的,通道之间的依赖关系隐藏在vc中,但这些依赖关系也和卷积核捕捉的特征图组空间关系相纠缠。作者的目标是确保网络能够利用增加网络本身对有价值信息的敏感性以使得这些有价值的信息在之后的网络层中能够得到利用,而没有什么用的特征信息则被舍弃。为了达到对通道之间的依赖关系进行精确建模以校准卷积核操作这个期望,作者提出的方案分为两步,分别是squeeze和excitation。

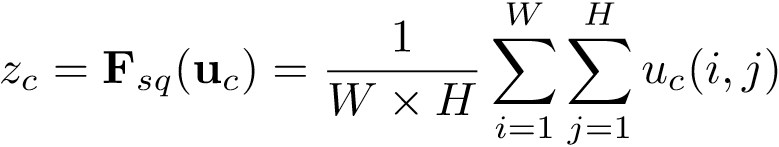

(1)Squeeze:Globa Information Embedding

为了解决利用通道之间的依赖关系的问题,作者首先考虑了在输出特征组图中各个通道的信号量本身的问题,由于每个学习好的卷积核都是以一个局部感受野的方式进行卷积因此在经过SE网络模块转换之后的输出U的各个数据单元不能利用数据单元以外的纹理信息。这个问题在较浅的网络层的时候感受野还很小的时候最为严重。为了解决这个问题,作者提出了压缩(squeeze)全局空间信息成一个通道描述器(个人认为这里的意思就是将一个通道特征图中的整个图中位置的信息相融合,避免对通道进行权值评估时由于卷积核尺寸问题造成的局部感受野提取信息范围太小参考信息量不足使得评估不准确),这个squeeze过程通过一个全局平均池化层来实现以产生通道的统计信息,统计信息是通过缩放U的尺度为WxH产生的。此处z的第c个元素计算过程如下式所示:

输出U可以被认为是一组局部描述器集合对整幅通道图的描述信息,为了简化运算,作者使用了全局平均池化替代更复杂的方法。

(2)奖惩:自适应校准(Excutation:Adaptive Recalibration)

在上一步squeeze操作获得的信息的基础上,作者以捕捉通道的依赖关系为目的进行了第二步操作,为了达到期望,第二步的函数应该满足两个标准:首先,它必须灵活(它尤其应该能够捕捉通道之间的非线性相互作用关系),其次它必须能够在多个通道在经过多次激活函数情况下学习多个通道之间非互斥关系。为了满足这些标准,作者借助sigmoid激活函数使用了一种简单的门机制进行操作,对数据的具体运算如下式所示:

(3)

式中δ是进行线性激活函数操作,以及

。为了防止模型变得复杂并且考虑到泛化因素,作者围绕非线性设置了两层全连接层(其实无所谓全连接还是卷积层因为在这里特征图的空间维度经过Globa-Average-Pooling层已经是1*1了)来作为瓶颈对对门机制进行参数化。最终整个网络模块的输出在经过rescaling操作。

至此整个SENet介绍基本完成。

68

68

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?