Resnet所提出的Residual connection作为现代神经网络中最为有效的加深网络深度的技巧,被广泛使用,但是我实际上从来没有看过Resnet的原文。前几天写本科毕业论文吃瘪,在这里还是得好好的看一看这篇文章,不仅是学习扎实的实验技术,也是学习大神的写作方法。

文章是2016年的CVPR:Deep Residual Learning for Image Recognition

1.1 我的Pass1

这篇文章没有结论,有点神奇,不过摘要里大部分都在讲实验结果。

摘要提到的问题:深度神经网络非常难以训练,解决方法是提出了一个residual learning framework,但之后具体的那句话不是很懂。结果就是使得网络能够非常深,并且提升在ImageNet和Cifar数据集上的效果。作者认为网络的深度十分重要,作为Backbone直接替换使得相关任务(目标检测、分割)的效果提升很大

1.2 沐神的Pass1

作者提出的具体解决方法是:We explicitly reformulate the layers as learning residual functions with reference to the layer inputs, instead of learning unreferenced functions.这句话其实非常奇怪,因为我们在阅读文章之前,我们根本就看不懂。

本文的摘要部分其实说了非常多的结论,一个是在目标分类方面,Resnet在ImageNet的比赛上取得了冠军;而比较关键的是,只需要将检测或者分割网络的骨干网络替换,在COCO数据集上的目标检测和分割的结果非常好,这是非常强的一点。

由于本文方法大道至简,实验很充分;但是由于CVPR的篇幅限制,所以没有结论。。

- 注意,作为赢得重要比赛的冠军,并且采用了不同的网络架构的文章,那么是容易收到追捧的,因为很可能蕴含着较为深刻的思想。

- 计算机视觉和图形学,以视觉效果为第一,所以看图很重要。

2 沐神的pass2

2.1 介绍

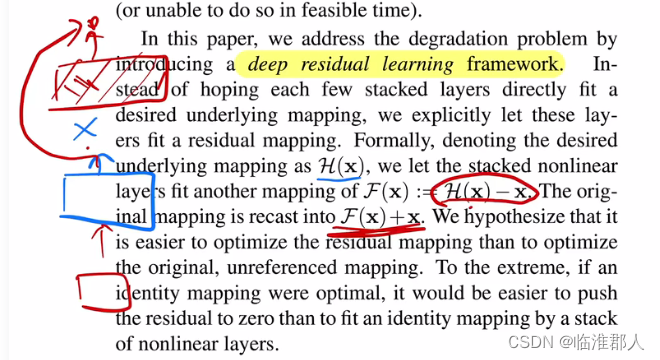

简介就是摘要的增强、扩充版本,是对本文工作比较完整的一个描述,写作上比较标准。虽然还不知道Resnet的具体设计,但本文的精髓实际上在读简介部分就已经知到了,就是residual learning,具体的实现就是给网络加一个shortcut connection。

2.2 相关工作

这里讲述了Residual learning(残差)以及神经网络设计的shortcut connection,实际上之前所谓的Highway网络已经提出过残差链接了,但是还不够本质,用的技巧比较花哨。回过头来说,ResNet之所以是经典,表面上看起来并没有做出很多的创新,但是实际上是把之前的内容都集大成,巧妙的统合或者说深入的去剖析,而解决了时下最为关心的问题,也就是网络不够深、出现退化的问题。

- 沐神补充:Residual在机器学习或者统计中比较多,即残差,一个是gradient boosting通过残差学习网络,将弱分类器叠加;第二个是线性模型的迭代解法。Resnet是在特征上做Residual,gradient boosting是

- 很多问题其实前人可能都讨论过,但是现在重新构想,那么出发点可能不太一样,也没问题。例如深度学习的很多想法,在20年前都可能在理论上讨论过,但是现在有了实现手段,可以去证明他们;但有时确实也很难找到,那么就是to our best knowledge,我们是第一个。

2.3 深度残差学习

首先是,网络的残差维度不同怎么办?如果是CNN怎么办?

3. 尾声

本文属于是大道至简,内容很简单,但是很有效,实验做得好,做的非常充分。沐神认为本文的写作,值得学习,因为就是把一个非常简单的内容讲的非常清楚,而有些时候很多文章的思想很简单,但是写作非常复杂让人看不懂了。

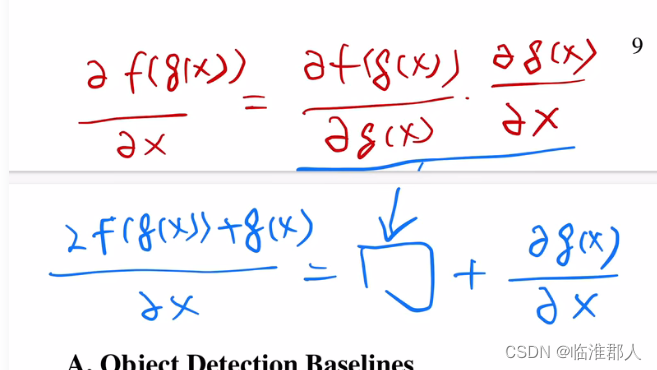

本文的直觉时,对于复杂模型,通过学习Residual增量的方法,起到使得模型能够忽视复杂的额外内容的效果,避免模型过于复杂而训练不好;但是没有什么公式,没有什么证明。沐神认为,作为CV的文章,其实问题也不大。。6年后的回顾,一部分研究者认为ResNet其实是梯度保持的比较好,避免深层网络的梯度消失问题,简单的话,如下所示,因为梯度本身其实很小,尤其是深层次部分的输出,值很小,加上Res链接后,可以使得浅层网络学习到它自己那个部分。也就是说,深层网络可以训练。

为什么Resnet在Ciffar-10上没有过拟合?尚待讨论。。时至如今,如何把巨大的Transformer模型训练的动?可能是加了Residual connection的模型使得模型的内在复杂度降低了。。?或者说就是加了模型的先验结构吧。

总之,本文虽然理论不深刻,但是实验效果无敌,很有启发性,所以瑕不掩瑜。

- 这里其实没有必要把Resnet替换目标检测的结果放上去,之前的工作基本是完整的,这一部分类似锦上添花的内容,这部分内容如果放到新论文,那么显然也不太合适。。

1万+

1万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?