(来源:https://arxiv.org/pdf/2409.02060)

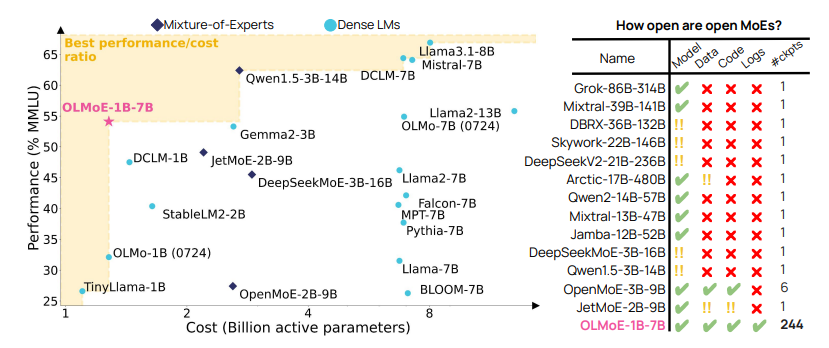

We introduce OLMOE, a fully open, state-of-the-art language model leveraging sparse Mixture-of-Experts (MoE). OLMOE-1B-7B has 7 billion (B) parameters but uses only 1B per input token. We pretrain it on 5 trillion tokens and further adapt it to create OLMOE-1B-7B-INSTRUCT. Our models outperform all available models with similar active parameters, even surpassing larger ones like Llama2-13B-Chat and DeepSeekMoE-16B. We present various experiments on MoE training, analyze routing in our model showing high specialization, and open-source all aspects of our work: model weights, training data, code, and logs.

OLMOE——一个完全开源、采用稀疏混合专家模型架构的尖端语言模型。OLMOE-1B-7B模型虽拥有70亿参数总量,但每个输入令牌仅激活10亿参数。该模型基于5万亿令牌进行预训练,并通过指令微调衍生出OLMOE-1B-7B-INSTRUCT版本。在激活参数量相当的现有模型中,我们的模型表现全面领先,甚至超越了参数量更大的Llama2-13B-Chat和DeepSeekMoE-16B等模型。我们不仅提供了混合专家训练的系统实验,还分析了模型内部路由机制展现出的高度专业化特性,并完整开源了项目所有组成部分:模型权重、训练数据、代码及日志记录。

Model: hf.co/allenai/OLMoE-1B-7B-0924

Data: hf.co/datasets/allenai/OLMoE-mix-0924

Code: github.com/allenai/OLMoE

Logs:wandb.ai/ai2-llm/olmoe/reports/OLMoE-1B-7B-0924–Vmlldzo4OTcyMjU3

(来源:https://arxiv.org/pdf/2409.02060)

1. 前言

尽管大型语言模型(LM)在各种任务上取得了重大进展,但在训练和推理的性能和成本之间仍然存在明显的权衡。许多学者和开源开发人员无法访问高性能的LM,因为它们的构建和部署成本过高。提高性价比权衡的一种方法是使用解析器激活的混合专家(MoE)。MoE在每一层都有几个专家,一次只激活其中的一个子集(见图2)。这使得MoE比总参数数量相似的密集模型更有效,后者为每个输入激活所有参数。因此,行业前沿模型使用MoE,包括Gemini-1.5和报道的GPT-4。

然而,大多数MoE模型都是闭源的:虽然有些模型已经公开发布了模型权重,但它们提供的训练数据、代码或配方信息有限,甚至没有(见图1)。虽然之前有人努力使语言建模研究完全可访问,但它们在很大程度上仅限于密集的LM。尽管MoE需要更多的开放性,因为它们为LM添加了复杂的新设计问题,例如使用多少总参数与活动参数,是使用许多小型专家还是少数大型专家,是否应该共享专家,以及使用什么路由算法。缺乏开放资源和对这些细节的了解阻碍了该领域构建成本效益高的开放式MoE,使其接近闭源前沿模型的能力。

针对这些问题,我们推出OLMOE——一个完全开放的专家混合语言模型,在同等规模模型中实现了顶尖性能。我们基于6.9B总参数量对OLMOE-1B-7B进行了5.1万亿token的预训练,其中每个输入token仅激活13亿参数。这使得其推理成本与OLMo 1B[65]、TinyLlama 1B[210]等约10亿参数的稠密模型相当,但需要更多GPU内存来存储其70亿总参数。实验表明,在激活参数量相同的情况下,专家混合模型的训练速度比稠密语言模型快约2倍。图1显示,OLMOE-1B-7B显著超越

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

274

274

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?