摘要:

本文将深度探讨如何构建一个既高效又稳定的爬虫系统,以应对日益复杂的数据采集挑战。通过策略优化、技术选型与实战技巧,揭示构建数据抓取引擎的核心要素,助力企业和开发者高效获取网络信息,提升数据驱动决策的能力。

一、为何高效稳定的爬虫管理至关重要?

在大数据时代背景下,信息量呈指数级增长,高效爬虫管理成为企业与开发者获取竞争优势的关键。它不仅关乎数据的时效性和完整性,更直接影响到业务分析的准确性和决策效率。

高效性意味着快速响应市场变化,第一时间捕获数据动态;而稳定性则是确保数据采集流程无间断,减少因故障导致的数据丢失风险。

二、高效爬虫管理的基石:任务调度的艺术

海量任务调度是爬虫系统高效运行的命脉。合理设计任务队列,采用分布式架构,能有效分散请求压力,避免单一节点过载。动态调整爬取频率,依据目标网站规则智能调度,可大幅提升采集效率。

三、技术集成:三方应用如何为数据抓取赋能?

集成三方应用,如IP代理服务、数据解析工具等,能显著提升爬虫的灵活性与稳定性。例如,自动切换IP地址避免被封禁,利用高级解析库快速处理复杂页面结构,确保数据抓取不间断。

四、数据存储:构建稳固的数据仓库

数据抓取后的存储策略同样重要。选择合适的数据库(如MongoDB、Elasticsearch)并设计高效索引,可以加速数据检索速度,同时保障数据安全与持久化存储。

五、监控与日志:确保引擎稳健运行

实施监控告警机制,实时跟踪爬虫状态,一旦发现异常立即响应。运行日志查看功能则帮助开发者快速定位问题,优化爬虫性能,确保数据采集活动的持续稳定。

六、实战技巧:提升爬虫稳定性的秘诀

遵守Robots协议,尊重网站规则。

限速设置,模拟人类浏览行为,避免被识别为爬虫。

异常处理机制,如重试策略、错误日志记录,提高系统健壮性。

代码优化,减少资源消耗,提升执行效率。

常见问题解答:

如何选择合适的爬虫框架? 根据项目需求、团队熟悉度及技术支持选择,如Scrapy适用于Python项目,Colly对于轻量级需求友好。

如何避免被目标网站封IP? 使用IP代理池轮换IP地址,控制访问频率,模拟浏览器行为。

数据存储时如何保证隐私合规? 只采集公开数据,遵循相关法律法规,必要时对敏感信息脱敏处理。

如何优化爬虫速度? 并发请求、异步IO、减少不必要的数据处理,以及利用缓存减少重复请求。

遇到反爬措施怎么办? 分析反爬机制,如验证码、动态加载等,采取对应策略绕过,或寻找官方API接口合作。

推荐工具:

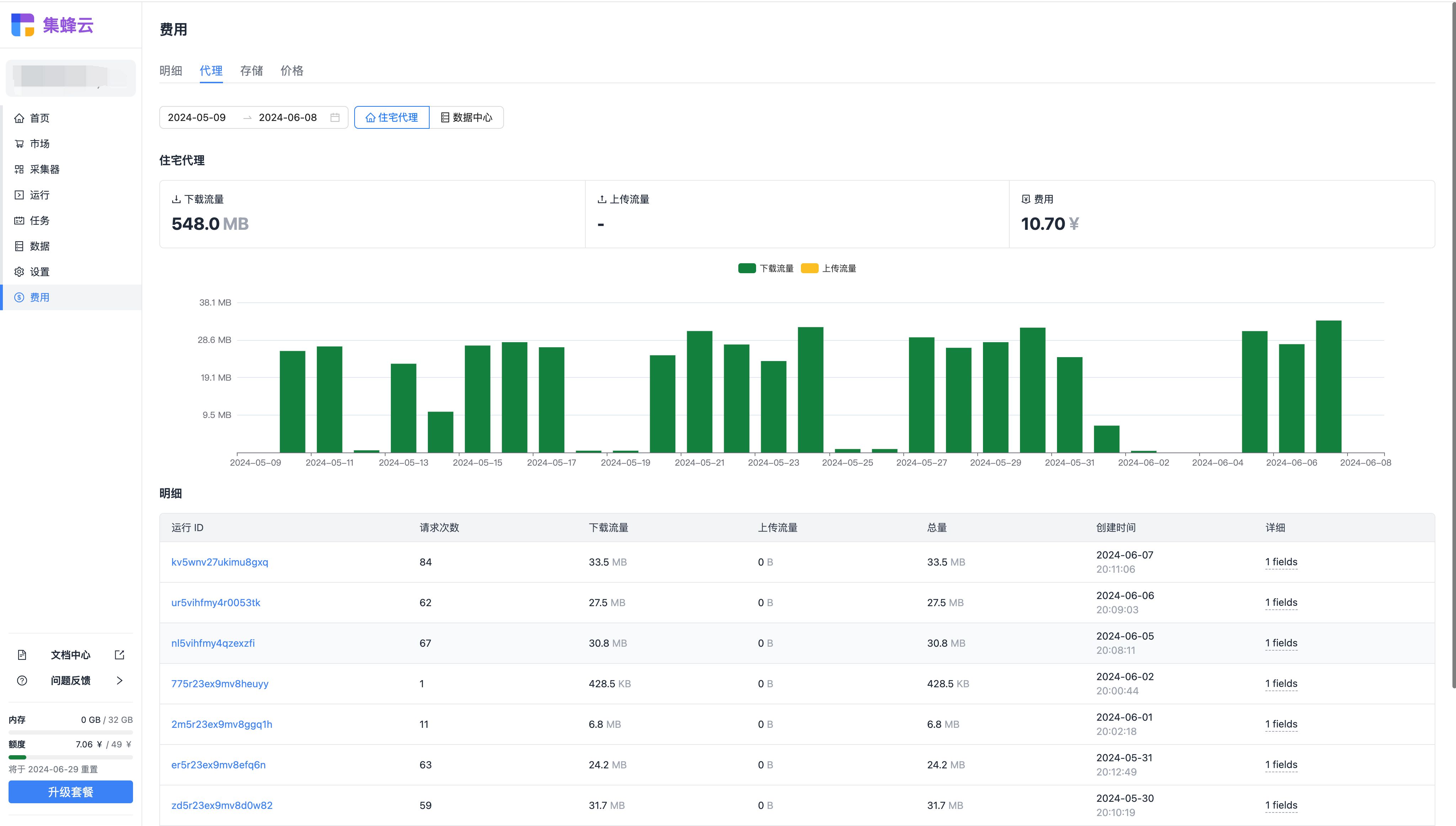

对于寻求一站式解决方案的用户,推荐使用集蜂云平台进行数据采集。其强大的任务调度能力、灵活的应用集成选项、以及全面的监控体系,能有效支持高效、稳定的数据抓取需求,无需从零开始搭建复杂的爬虫系统。

引用:

“数据是新时代的石油。” —— Clive Humby, 数据科学家

4万+

4万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?