Time-Series Representation Learning via Temporal and Contextual Contrasting

从具有时间动态的未标记时间序列数据中学习体面的表示是一项非常具有挑战性的任务。本文提出了一种基于时间与上下文对比(TS-TCC)的无监督时间序列表示学习框架,用于学习无标记数据的时间序列表示。首先,利用弱增强和强增强将原始时间序列数据转换为两个不同但相关的视图。其次,我们提出了一个新的时间对比模块,通过设计一个复杂的跨视图预测任务来学习鲁棒的时间表示。最后,为了进一步学习区别表示,我们提出了一个基于时间对比模块的上下文对比模块。它试图使同一样本的不同上下文之间的相似性最大化,同时使不同样本上下文之间的相似性最小化。实验已经在三个真实世界的时间序列数据集上进行。结果表明,在我们提出的TS-TCC学习的特征上训练一个线性分类器可以与监督训练相媲美。此外,我们提出的TS-TCC在少标记数据和迁移学习场景中具有很高的效率。

背景:

首先,他们可能无法解决数据的时间依赖性,这是时间序列的关键特征

其次,一些用于图像的增强技术,如颜色失真,一般不能很好地拟合时间序列数据。到目前为止,关于时间序列数据的对比学习的研究还很少。

方案:

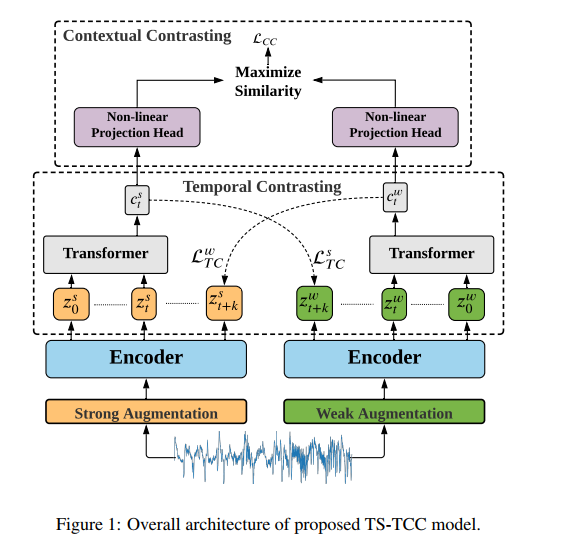

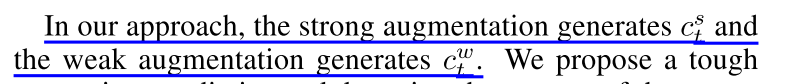

我们提出了一个通过时间和上下文对比(TS-TCC)时间序列表征学习框架。我们的框架使用了简单而有效的数据扩展,可以适合任何时间序列数据,因此可以创建输入数据的两个不同但相关的视图。接下来,我们提出了一个新的时间对比模块,通过设计一个严格的跨视图预测任务来学习鲁棒表示,该任务针对特定的时间步长,一个增强的过去潜在特征来预测另一个增强的未来。这一新的操作将迫使模型通过更难的预测任务来学习鲁棒表示,以对抗由不同的时间步长和增广引入的任何扰动。此外,我们在TS-TCC中提出了一个上下文对比模块,在时间对比模块学习到的鲁棒表征的基础上进一步学习判别表征。在这个语境对比模块中,我们的目标是最大化相同样本的不同语境之间的相似性,同时最小化不同样本之间的相似性。

总结:时间序列对比学习

框架

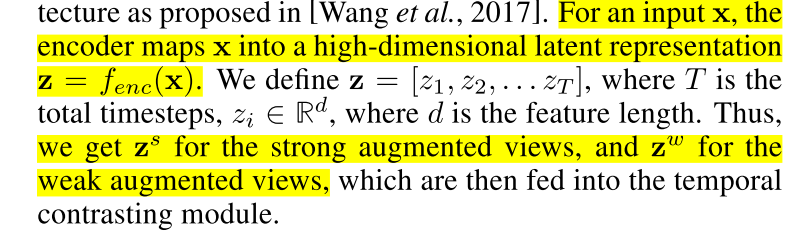

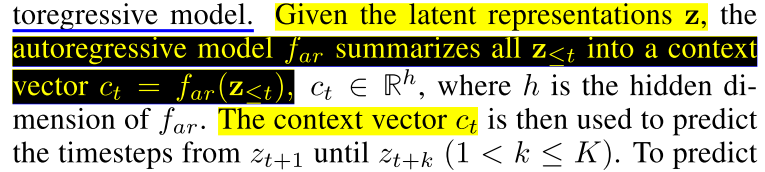

我们首先根据强增强和弱增强生成输入数据的两个不同但相关的视图。然后,提出了一个时间对比模块,以探索数据的时间特征与自回归模型。这些模型通过使用一个视图的过去来预测另一个视图的未来,完成了一项艰巨的交叉视图预测任务。我们进一步使协议最大化在通过上下文对比模块对自回归模型的上下文进行分析。

Time-Series Data Augmentation

对比方法试图使同一样本的不同视图之间的相似性最大化,同时使其与其他样本的相似性最小化。

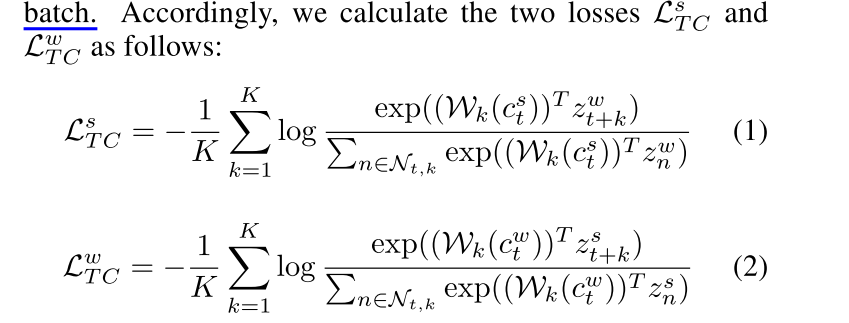

Temporal Contrasting

时间对比模块利用一个自回归模型,利用对比损失提取潜在空间中的时间特征。

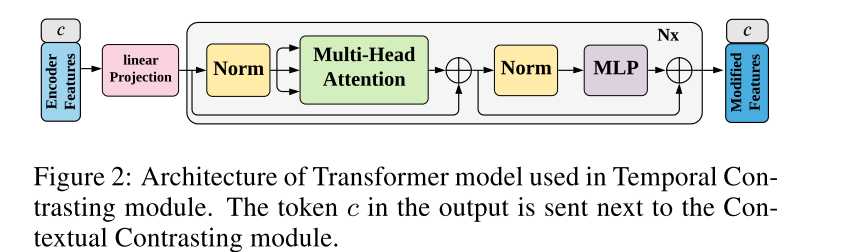

Transformer模型的体系结构如图2所示。它主要由连续的多头注意块(MHA)和随后的MLP块组成。MLP块由两个完全连接的层组成,层间具有非线性ReLU函数和dropout。我们的变压器采用了能产生更稳定梯度的预范数剩余连接[Wang et al., 2019]。我们堆叠L个相同的层来生成最终的特征。

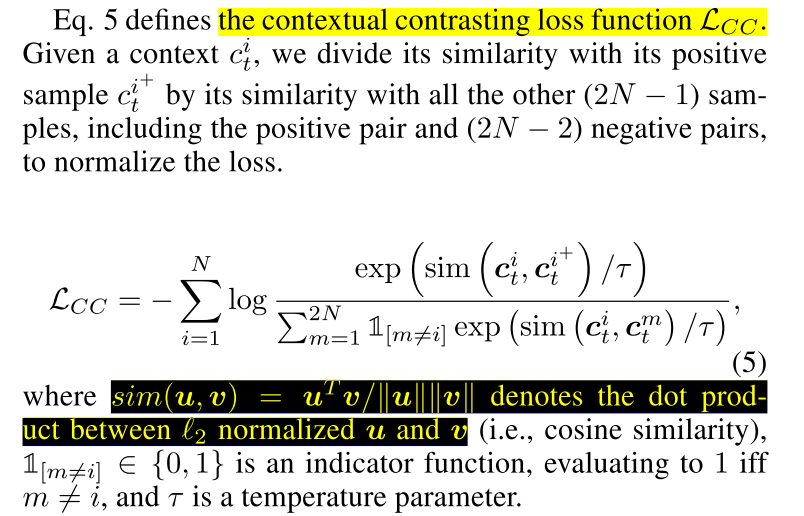

Contextual Contrasting

我们进一步提出了一个上下文对比模块,旨在学习更有区别的表征。

整体的自我监督损失是两个时间对比损失和上下文对比损失的组合

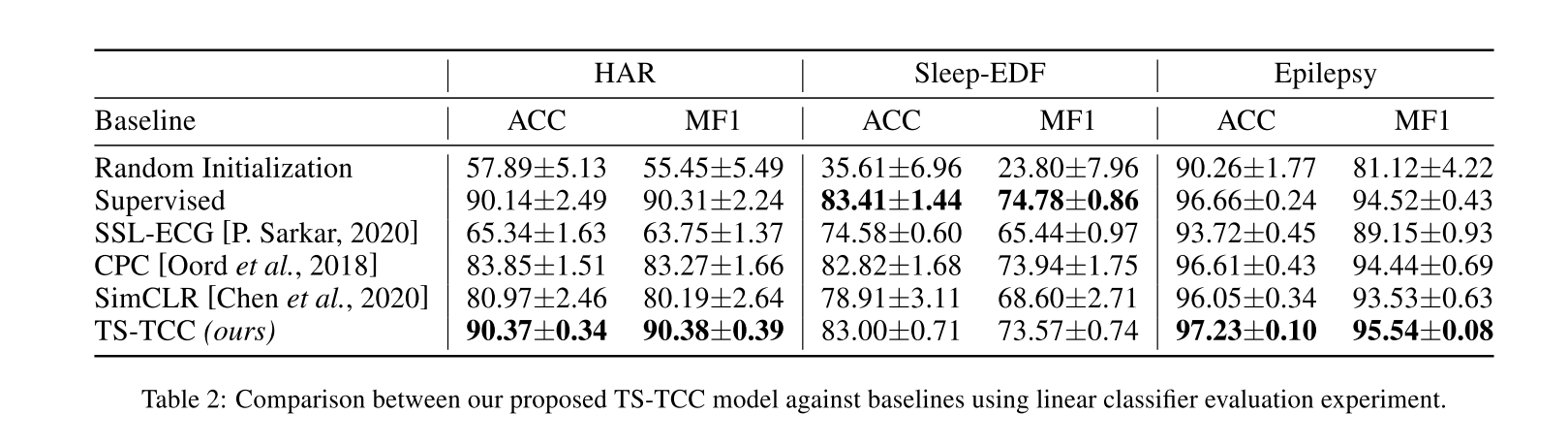

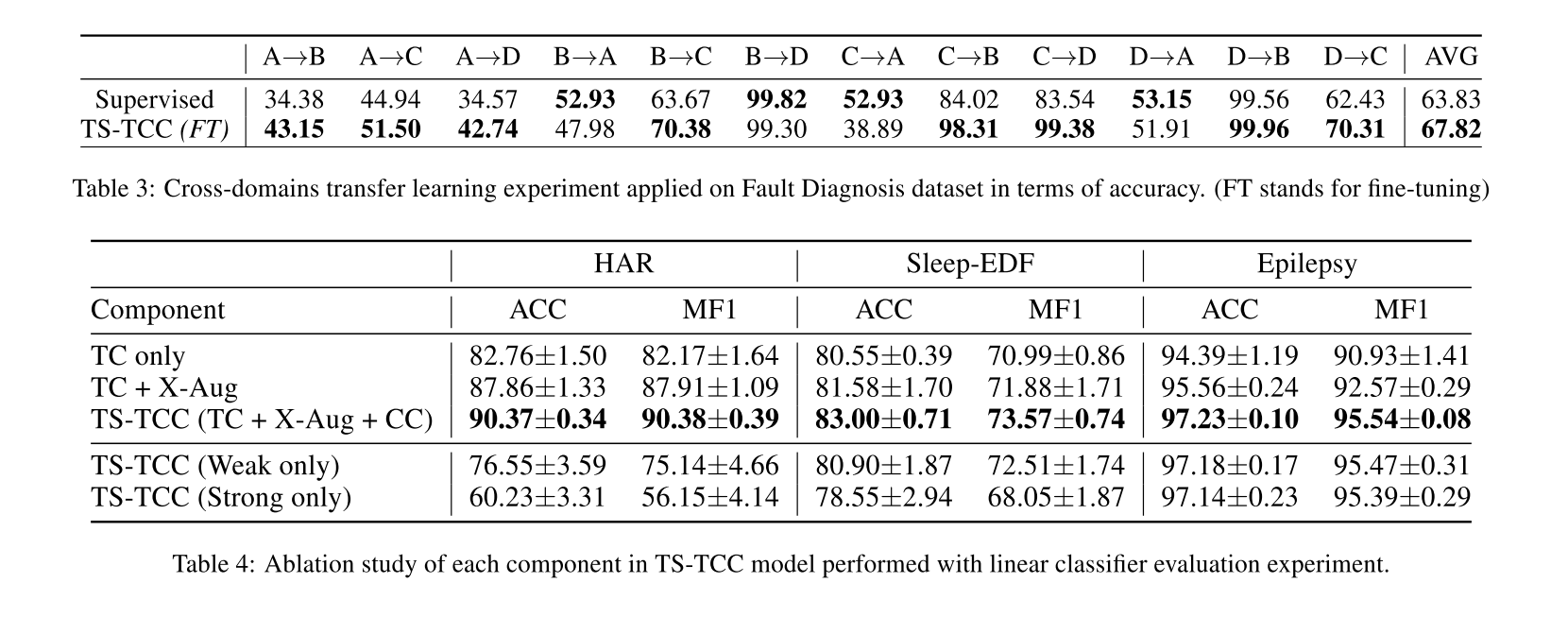

实验

类似文献:

Unsupervised Scalable Representation Learning for Multivariate Time Series(NIPS2019)

UNSUPERVISED REPRESENTATION LEARNING FOR TIME SERIES WITH TEMPORAL NEIGHBORHOOD CODING(ICLR2020)

864

864

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?