转载地址:http://www.cnblogs.com/Rambler1995/articles/5467074.html

对LeNet-5卷积神经网络的理解

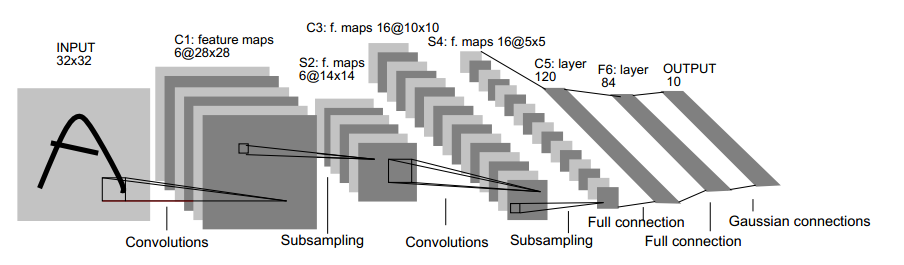

首先,我们给出LeNet-5卷积神经网络的整体框架:

可以看出LeNet-5包含输入层共有8层,每一层都包含多个参数(权重)。C层代表的是卷积层,通过卷积操作,可以使原信号特征增强,并且降低噪音。 S层是一个下采样层,利用图像局部相关性的原理,对图像进行子抽样,可以减少数据处理量同时保留有用信息。

下面针对每一层进行解释:

- 输入层是

大小的图像。

- C1层是一个卷积层,有6个feature map,由于用的

大小的卷积核,每个feature map有

即

个神经元,每个神经元都与输入层的

大小的区域相连。所以C1层一共有

个参数(同一feature map的每个神经元共享权值,一共

个unite参数和每个feature map固有的一个bias参数,一共6个feature map)。两层之间的连接数为

(C1层的每个feature map的每个神经元都与输入层有

个连接,每个feature map层又有

个神经元,一共有6个feature map层,故可以得到122304个连接)

- S2层是一个下采样层,有6个feature map,每个feature map中的每个神经元都与C1层对应的feature map中的

的区域相连。S2层中的每个神经元是由这4个输入相加,再乘以一个训练参数,再加上这个feature map的偏置参数,结果通过sigmoid函数计算而得。所以S2各层中的神经元个数:C1中各层的神经个数等于1:4(行列各除以2),故S2中各feature map有

个神经元。由于S2各feature map中的每个神经元都只需要两个参数,一共6个feature map,故S2层所有的参数为

个。而S2中各feature map的每个神经元都与C1层的4个神经元和一个偏置单元相连,一共

个神经元,6个feature map,故可以得到

个连接。

- C3层也是一个卷积层,它也是运用

的卷积核,去处理S2层。可以计算出C3各feature map的神经元个数为

即

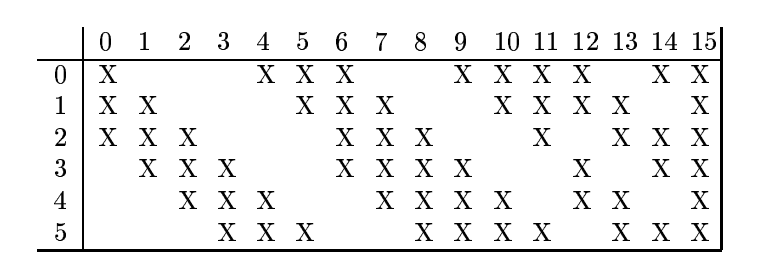

。可以看到C3有16个feature map,每个feature map都是由上一层的各feature map之间的不同组合。如本例所示的组合方式如下:

可以得知:C3层的第0个feature map是由S2层的第0,1,2个feature map组合得到的,C3层的第1个feature map是由S2层的第1,2,3个feature map组合得到的。。。看图类推即可。

可以得知:C3层的第0个feature map是由S2层的第0,1,2个feature map组合得到的,C3层的第1个feature map是由S2层的第1,2,3个feature map组合得到的。。。看图类推即可。

现在我们可以计算出C3层的训练参数个数为。(此时要注意,是每个feature map对应一个偏置参数,而不是用如下公式

,这种计算是错误的,因为多计算了每个feature map的偏置参数的个数。)通过这样,所以有151600个连接。

- S4层是一个下采样层,同理,由16个

大小的feature map构成,每个神经元都与C3中对应feature map的

大小的区域相连。同样可以计算出来有

个参数,和

个连接。

- C5层是一个卷积层,同样使用

的卷积核,所以每个feature map有

即

个神经元,每个单元都与S4层的全部16个feature map的

区域相连(全相连)。C5层一共有120个feature map。C5层的参数和连接均为

。

- F6层有84个feature map(取决于输出层的设计),每个feature map只有一个神经元,与C5层全相连。故有

个参数和连接。F6层计算输入向量和权重向量之间的点积,再加上一个偏置。然后将其传递给sigmoid函数来计算神经元。

- 输出层由欧式径向基函数(Euclidean Radial Basis Function)神经元组成,每个类别对应一个神经元,一共10类,故10个神经元,每个神经元都有84个输入。

3万+

3万+

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?