接上一节 第二章-信源与信息熵(二)

2.4 连续信源的熵与互信息

1. 实际中,连续信源

a) 幅度连续

b) 时间或频率上也连续

2. 统计特性

a) 概率密度函数

3. 用离散变量来逼近连续变量

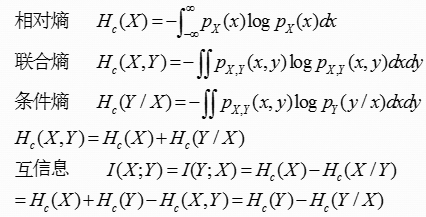

连续信源熵

1. 定义

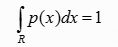

连续信源的状态概率用概率密度来表示。如果连续随机变量X,取值为实数域R,其概率密度函数为p(x),则

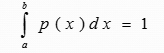

如果取值为有限实数域[a,b],则

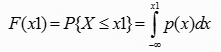

X的概率分布函数为

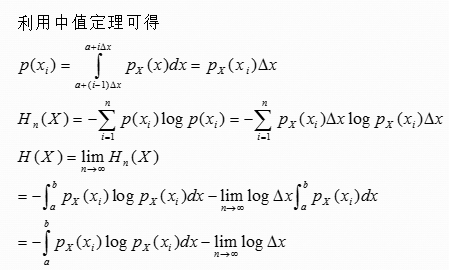

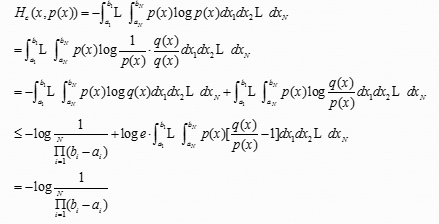

利用离散信源熵的概念来定义连续信源熵

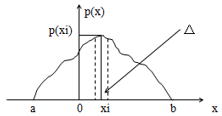

设一在[a,b]取间的连续随机变量

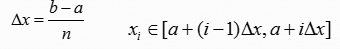

把X的取值区间[a,b]分割为n个小区间,小区间宽度为

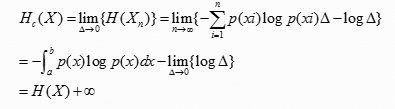

当△趋于0,n趋于无穷时,离散随机变量Xn将接近于连续随机变量X,这时可以得到连续信源的熵为

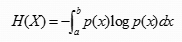

其中,连续信源的熵定义为

2. 解释

1) 连续信源熵为一个相对熵,其值为绝对熵减去一个无穷大量

2) 连续信源有无穷多个状态,因此根据SHANNON熵的定义必然为无穷大。

3) 连续信源的熵不等于一个消息状态具有的平均信息量。其熵是有限的,而信息量是无限的。

4) 连续信源熵不具有非负性,可以为负值

5) 尽管连续信源的绝对熵为一个无穷大量,但信息论的主要问题是信息传输问题,连续信道的输入输出都是连续变量,当分析其交互信息量时是求两个熵的差,当采用相同的量化过程时,两个无穷大量将被抵消,不影响分析。

3. 连续信源的最大熵定理

限峰功率最大熵定理:定义域受限的随机变量X,均匀分布时,具有最大熵

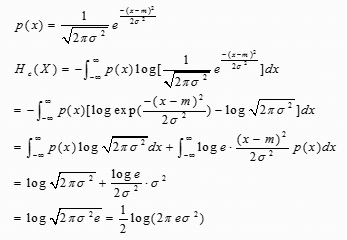

限平均功率最大熵定理:对于相关矩阵一定随机变量X,当它是正态分布时具有最大熵

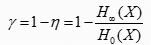

2.5 冗余度

表示给定信源在实际发出消息时所包含的多余信息

来源

信源符号间的相关性

信源符号分布的不均匀性

定义

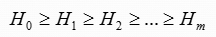

衡量信源的相关性程度

信源输出符号间相关长度长,则信源的实际熵小,熵的相对率小,信源的冗余度越大

反之,信源冗余度小

复习——概念

1. 信息是可以定量描述的,可以比较大小,由概率决定;

a) 对应特定信源,可以求出所含不确定度,也就是消除不确定度所需的信息量;

b) 可通过对信源的观察、测量获得信息,以减少对信源的不确定度;

c) 考虑信源符号概率分布和符号之间的相关性,信源不确定度会下降

d) H(X)就是信源无失真时必需输出的最小信息量;

2. 通过传输,信宿可以得到信息I(X;Y),从而减小对信源的不确定度:

H(X/Y)=H(X)-I(X;Y)

a) 信息通过系统传输,只会丢失信息,不会增加

b) 丢失部分H(X/Y)是由噪声引起的

复习——计算公式、相互关系

- 自信息量、信源熵、相对熵

- 互信息、条件熵、联合熵

- 序列熵、平均符号熵、极限熵

- 冗余度

4795

4795

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?