Reference: Min Lin,Qiang Chen,Shuicheng Yan.Network in network

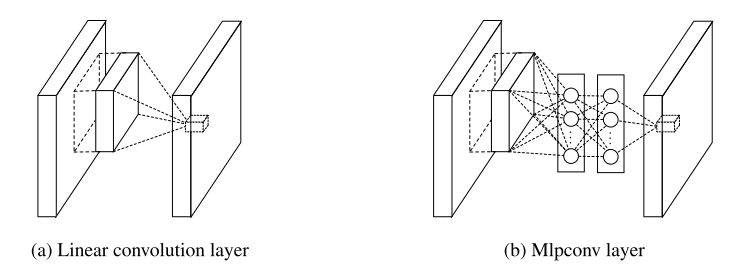

经典CNN中的卷积层其实就是用线性滤波器对图像进行内积运算,在每个局部输出后面跟着一个非线性的激活函数,最终得到的叫作特征图。而这种卷积滤波器是一种广义线性模型。所以用CNN进行特征提取时,其实就隐含地假设了特征是线性可分的,可实际问题往往是难以线性可分的。

GLM:(Generalized linear model)广义线性模型

GLM的抽象能力是比较低水平的,自然而然地我们想到用一种抽象能力更强的模型去替换它,从而提升传统CNN的表达能力。

抽象:指得到对同一概念的不同变体保持不变的特征。

什么样的模型抽象水平更高呢?当然是比线性模型更有表达能力的非线性函数近似器了(比如MLP,径向基神经)。

MLP的优点:

- 非常有效的通用函数近似器

- 可用BP算法训练,可以完美地融合进CNN

- 其本身也是一种深度模型,可以特征再利用

(MLP中的激活函数采用的是整流线性单元(即ReLU:max(wx+b,0))

采用了NIN改进CNN后,我们增强了局部模型的表达能力,这样我们可以在分类层对特征图进行全局平均池化,这种方式更有意义和容易解释(可将最后一层输出的特征图的空间平均值解释为相应类别的置信度!为什

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

632

632

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?