之前写过两篇文章,分别是

1)矩阵分解的综述:scikit-learn:2.5.矩阵因子分解问题

2)关于TruncatedSVD的简单介绍:scikit-learn:通过TruncatedSVD实现LSA(隐含语义分析)

今天发现NMF也是一个很好很实用的模型,就简单介绍一下,它也属于scikit-learn:2.5.矩阵因子分解问题的一部分。

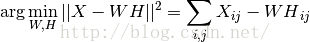

NMF是另一种压缩方法,前提是假设数据矩阵是非负的。在数据矩阵不包含负值的情况下, NMF可以代替PCA及他的变形(NMF can be plugged in instead of PCA or its variants, in the cases where the data matrix does not contain negative values.)。他通过把X分解成W和H,并优化下式:

This norm is an obvious extension of the Euclidean norm to matrices. (Other optimization objectives have been suggested in the NMF literature, in particular Kullback-Leibler divergence, but these are not currently implemented.)

和PCA不同的是,NNMF通过增量式(通过叠加每一个子成分而不做相减操作)的方式表示一个向量,这种增量式模型能有效表示图像和文本。

NNMF实现了非负双奇异值分解( Nonnegative Double Singular Value Decomposition,NNDSVD)。NNDSVD基于两个SVD过程,一个SVD过程用来近似数据矩阵,另一个SVD过程利用单位秩矩阵的代数性质来近似第一步产生的SVD因子的正值部分。NNDSVD的基本实现能很好地用于稀疏矩阵分解。

对于非稀疏矩阵,可以使用变形NNDSVDa (in which all zeros are set equal to the mean of all elements of the data)和NNDSVDar (in which the zeros are set to random perturbations less than the mean of the data divided by 100)

这个例子很不错哦:

http://scikit-learn.org/stable/auto_examples/applications/topics_extraction_with_nmf.html#example-applications-topics-extraction-with-nmf-py

621

621

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?