翻译自numerical optimization Chapter3 Line Search Methods

【没写完,可参考http://blog.csdn.net/fangqingan_java/article/details/46405669】

Wolfe条件(或强Wolfe条件)是广泛使用并且较为有效的终止条件。

下面描述一个一维的线搜索过程,该过程确保对于给定的任意参数c1,c2(1>c2>c>0),能够找到一个能够满足强Wolfe条件的步长。 首先,我们假设方向p是下降方向,函数f沿着该方向在下面是有界的。

算法分为两个步骤,第一步首先开始于一个对于步长α的估计值α1,然后后续不断扩大其大小,直到找到一个合适的步长或者一个包含目标步长的区间。如果是后者的话(找到区间),就需要不断调用第二步,称为zoom的函数,来不断缩小区间大小,直到找到合适步长。

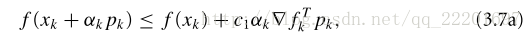

line search算法的一个形式说明如下。公式

最低0.47元/天 解锁文章

最低0.47元/天 解锁文章

644

644

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?