传送门🔍

📕什么是NLP?

自然语言处理(Natural Language Processing,NLP)是计算机科学、人工智能和语言学领域的一个交叉学科,主要研究如何让计算机能够理解、处理、生成和模拟人类语言的能力,从而实现与人类进行自然对话的能力。通过自然语言处理技术,可以实现机器翻译、问答系统、情感分析、文本摘要等多种应用。随着深度学习技术的发展,人工神经网络和其他机器学习方法已经在自然语言处理领域取得了重要的进展。未来的发展方向包括更深入的语义理解、更好的对话系统、更广泛的跨语言处理和更强大的迁移学习技术。

🚀NLP国内外发展

自然语言处理的发展可追溯到20世纪50年代,当时计算机科学家开始尝试通过计算机程序来实现对自然语言的理解和生成。早期研究主要关注规则和基于知识的方法,如编写语法规则和词典来进行句子分析。20世纪80年代,随着计算能力的提高和大量语料库的出现,统计方法在自然语言处理领域逐渐占据主导地位。这一时期,许多基于统计的机器翻译、分词、词性标注等方法相继出现。进入21世纪,尤其是近十年来,深度学习技术的发展极大地推动了自然语言处理的进步。基于深度神经网络的模型,如循环神经网络(RNN)、长短时记忆网络(LSTM)和Transformer等,这些技术大大提高了自然语言处理的效率和准确性。

-

在国内,自然语言处理研究和产业发展也取得了丰硕的成果。目前,国内的自然语言处理研究机构和企业有很多,如中科院计算所、清华大学、百度、腾讯等,其中百度的ERNIE、阿里巴巴的BERT等预训练模型在多种中文自然语言处理任务上表现出色。同时,许多国内公司也已经将自然语言处理技术应用于智能客服、搜索引擎、推荐系统等场景。

-

在国际上,谷歌、Facebook、OpenAI等科技巨头在自然语言处理领域也取得了一系列重要的突破。例如,谷歌推出的BERT模型和OpenAI的GPT系列模型,都在多个自然语言处理任务上取得了超过人类水平的表现。

🔒NLP底层原理

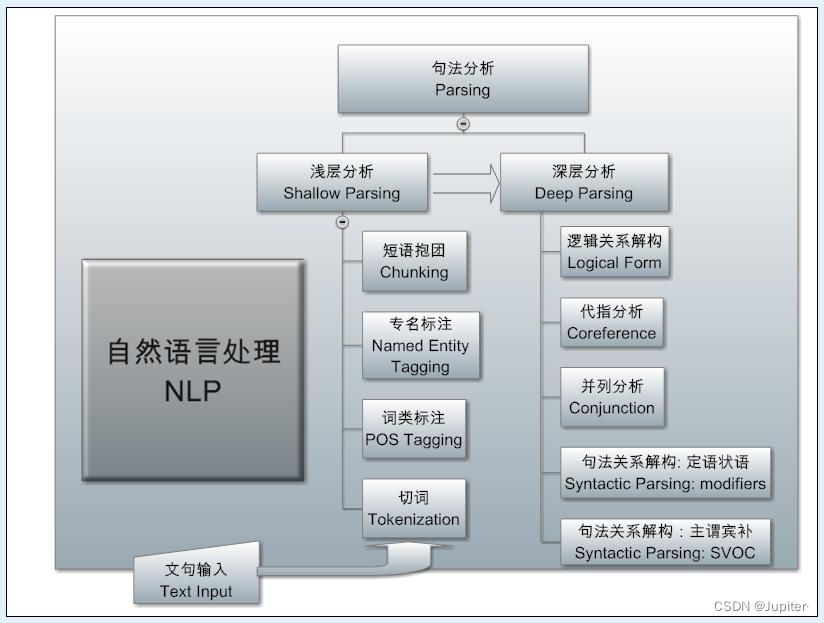

自然语言处理的底层原理涉及多个层面,包括语言学、计算机科学和统计学等。它涉及对语言的结构、语义、语法和语用等方面的研究,以及对大规模语料库的统计分析和模型建立。在具体实现过程中,需要对自然语言进行多个层次的处理,主要包括以下几个方面:

🌈语言模型

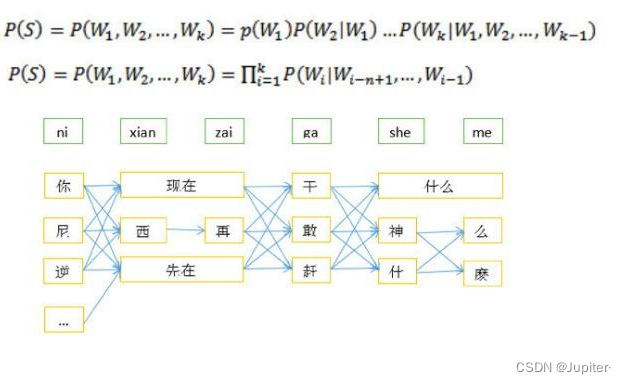

语言模型是自然语言处理中最重要的概念之一,它用于计算给定文本序列的概率。语言模型可以基于规则、统计或深度学习等方法构建。在语言模型中,通常会使用一些概率模型来表示文本的生成概率,如n-gram模型、隐马尔可夫模型(HMM)和条件随机场(CRF)等。

什么是n-gram模型?

n-gram模型是一种基于统计语言学的模型,它用于预测文本中下一个词或字符的可能性。n-gram模型是一种条件概率模型,它通过计算一个文本序列中的n个连续词或字符的概率来预测下一个词或字符的可能性。在n-gram模型中,n表示一个文本序列中包含n个连续的词或字符。例如,当n=2时,n-gram模型会计算文本中每个相邻的词对出现的概率;当n=3时,n-gram模型会计算文本中每个相邻的三个词组成的三元组出现的概率,以此类推。

什么是隐马尔可夫模型?

HMM是一种概率模型,它用于描述某个系统由一系列隐含的状态组成,每个状态都与一系列可观测的事件相关联。HMM假设这些事件的生成过程是由一个马尔可夫过程控制的,即当前状态只与前一个状态有关,与之前的状态和观测值无关。HMM由两个部分组成:状态转移概率矩阵和观测概率矩阵。状态转移概率矩阵描述了状态之间的转移关系,而观测概率矩阵描述了每个状态生成观测值的概率分布。

HMM的基本原理

HMM模型可以用三个参数来描述:初始状态概率分布、状态转移概率矩阵和观测概率矩阵。其中,初始状态概率分布描述了系统在初始时刻各个状态的出现概率;状态转移概率矩阵描述了系统从一个状态转移到另一个状态的概率;观测概率矩阵描述了系统在每个状态下观测值的概率分布。在HMM中,我们可以根据已知的观测序列来求解最可能的状态序列,或者根据已知的状态序列来求解最可能的观测序列。这个过程可以使用前向算法、后向算法和维特比算法等方法来实现。

⭐词向量表示和语义分析

词向量表示是将自然语言文本转换为计算机可以处理的向量形式。在词向量表示中,通常会使用词袋模型(Bag of Words Model)或者分布式表示(Distributional Representation)等方法。其中,分布式表示方法是一种由Geoffrey Hinton提出的技术,它通过在大规模语料库上训练神经网络来实现词向量的表示。语义分析关注句子的意义,其目标是将自然语言表示转换为一种计算机可以理解的形式。这通常涉及实体识别、关系抽取和指代消解等任务。在语义分析中,通常会使用词向量的平均值、加权平均值或者递归神经网络(Recursive Neural Network)等方法来表示句子的语义信息。

💪深度学习

深度学习是自然语言处理中的一种重要技术,它可以通过训练大量的数据来提高自然语言处理的准确性。在深度学习中,常用的模型包括卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)和Transformer等。这些模型可以应用于自然语言处理中的各种任务,如文本分类、情感分析、机器翻译等。当然除了深度学习模型,还有机器学习等其他自然语言处理模型。

🎬NLP流程逻辑

自然语言处理的流程逻辑通常包括以下几个步骤:

数据收集和预处理:获取和清洗原始语言数据,包括文本、语料库或语音数据;

分词和词法分析:将原始文本数据转换为适合模型输入的格式,如分词、去除停用词、词干提取等。

特征提取:将文本转换为计算机可以处理的向量形式,如词向量表示、句子向量表示等。常用的特征提取方法包括词袋模型、TF-IDF、词嵌入等。

模型训练:利用训练数据集,采用机器学习或深度学习方法训练自然语言处理模型。

模型评估:使用验证数据集评估模型的性能,如准确率、召回率、F1值等指标。

模型应用:将训练好的模型应用于实际问题,如文本分类、情感分析、机器翻译等任务。

🚀NLP实现方法

在实现自然语言处理时,首先需要考虑数据集的选择和预处理。数据集的选择和质量对于自然语言处理的效果有着很大的影响,因此需要选择合适的数据集,并进行数据清洗和预处理。其次还需要采用一些自然语言处理工具和技术。常用的自然语言处理工具包括NLTK、spaCy、Stanford CoreNLP等。这些工具包提供了很多自然语言处理的功能,如分词、词性标注、命名实体识别、句法分析等。最后,还需要选择合适的算法和模型。常用的算法包括朴素贝叶斯、支持向量机、决策树、随机森林等。同时,深度学习也成为自然语言处理中的主流技术,常用的模型包括卷积神经网络(Convolutional Neural Network,CNN)、循环神经网络(Recurrent Neural Network,RNN)和Transformer等。

自然语言处理领域的具体实现主要包括以下几类:

🔒规则和基于知识的方法

规则和基于知识的方法主要依赖于预先编写的语法规则和词典来实现自然语言处理任务。这类方法在早期研究中占据主导地位,但由于其维护成本高且泛化能力有限,逐渐被基于统计的方法所取代。

以下是一个基于规则和知识的自然语言处理算法的Python代码示例,该算法实现了简单的问答系统,可以回答有关天气的问题

import re

def get_weather_info(question):

# 使用正则表达式匹配问题

if re.search('天气|气温|温度|雨', question):

# 匹配到天气相关问题,返回固定的回答

return "今天天气晴朗,温度为25度,没有下雨。"

else:

# 没有匹配到相关问题,返回默认的回答

return "抱歉,我不知道你在问什么。"

# 测试问答系统

question = "今天会下雨吗?"

answer = get_weather_info(question)

print(answer)

question = "明天气温会降低吗?"

answer = get_weather_info(question)

print(answer)

在这个代码示例中,我们使用了Python的re模块来实现正则表达式匹配,用于匹配天气相关的问题。这个问答系统非常简单,但是可以说明基于规则和知识的自然语言处理算法的实现思路。我们可以根据问题的特征和模式来实现相应的规则,从而实现基本的自然语言处理功能。

NLTK

Natural Language Toolkit(NLTK)是一个流行的自然语言处理库,它提供了许多工具和函数,可用于实现基于规则和知识的自然语言处理算法。例如,我们可以使用NLTK中的词性标注器、实体识别器和句法分析器等工具来分析自然语言文本。

spaCy

spaCy是另一个流行的自然语言处理库,它提供了高效的自然语言处理工具和算法。spaCy中提供了一些强大的工具,包括词性标注器、实体识别器、依存关系分析器和句法分析器等。

知识图谱

知识图谱是一种表示知识的方式,它可以用于实现基于知识的自然语言处理算法。Python中有许多知识图谱的实现库,如Pyke和RDFLib等,可以帮助我们构建和管理知识图谱。

📕规则引擎

规则引擎是一种将规则映射到行动的软件,可以用于实现基于规则的自然语言处理算法。Python中有许多规则引擎的实现库,如Pyke和PyCLIPS等,可以帮助我们实现基于规则的自然语言处理算法。

🌂基于统计的方法

基于统计的方法利用大量语料库来学习自然语言的规律。这类方法在20世纪80年代开始崛起,取得了一系列重要的成果。例如,统计机器翻译、隐马尔可夫模型等。

以下是一个基于统计方法的自然语言处理算法的Python代码示例,该算法实现了文本分类任务,可以将文本分为两个类别:积极和消极。

import nltk

from nltk.corpus import movie_reviews

from nltk.classify import NaiveBayesClassifier

from nltk.classify.util import accuracy

# 获取电影评论数据集

documents = [(list(movie_reviews.words(fileid)), category)

for category in movie_reviews.categories()

for fileid in movie_reviews.fileids(category)]

# 分割数据集为训练集和测试集

train_set = documents[:800]

test_set = documents[800:]

# 提取特征

all_words = nltk.FreqDist(w.lower() for w in movie_reviews.words())

word_features = list(all_words)[:2000]

def document_features(document):

document_words = set(document)

features = {}

for word in word_features:

features['contains({})'.format(word)] = (word in document_words)

return features

# 提取特征并训练分类器

train_features = [(document_features(d), c) for (d,c) in train_set]

classifier = NaiveBayesClassifier.train(train_features)

# 测试分类器

test_features = [(document_features(d), c) for (d,c) in test_set]

print("Accuracy:", accuracy(classifier, test_features))

# 对新文本进行分类

text = "This movie is great!"

features = document_features(text.split())

print("Classification:", classifier.classify(features))

在这个代码示例中,我们使用了Python的nltk库来实现了一个基于朴素贝叶斯分类器的文本分类算法,该算法可以将电影评论分为积极和消极两个类别。具体实现步骤如下:

①、获取电影评论数据集,将数据集分为训练集和测试集;

②、提取文本特征,这里使用了单词出现的频率作为特征,并提取了前2000个最常出现的单词作为特征集;

③、使用特征集训练朴素贝叶斯分类器;

④、对测试集进行测试,并计算分类器的准确率;

⑤、对新文本进行分类,输出分类结果。

这个代码示例非常简单,但是可以说明基于统计方法的自然语言处理算法的实现思路。我们可以通过提取文本特征,构建分类器,并对新文本进行分类,从而实现文本分类任务。当然,这个算法还有很多改进的空间,可以改进特征提取方法,优化分类器的性能等,以提高文本分类的准确性和可靠性。

🌠基于深度学习的方法

基于深度学习的方法使用人工神经网络来学习自然语言的表示和处理能力。这类方法在近十年来取得了显著的进展,如CNN、RNN和Transformer等。

以下是一个基于深度学习的自然语言处理算法的Python代码示例,该算法实现了情感分析任务,可以对电影评论进行情感分类。

import numpy as np

import tensorflow as tf

from tensorflow.keras.datasets import imdb

from tensorflow.keras.preprocessing.sequence import pad_sequences

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, Flatten, Embedding, Dropout

# 设置超参数

vocab_size = 10000

max_length = 256

embedding_dim = 16

num_epochs = 10

batch_size = 128

# 加载数据集

(x_train, y_train), (x_test, y_test) = imdb.load_data(num_words=vocab_size)

# 数据预处理

x_train = pad_sequences(x_train, maxlen=max_length, padding='post', truncating='post')

x_test = pad_sequences(x_test, maxlen=max_length, padding='post', truncating='post')

# 构建模型

model = Sequential([

Embedding(input_dim=vocab_size, output_dim=embedding_dim, input_length=max_length),

Flatten(),

Dense(64, activation='relu'),

Dropout(0.5),

Dense(1, activation='sigmoid')

])

model.compile(optimizer='adam', loss='binary_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(x_train, y_train, epochs=num_epochs, batch_size=batch_size, validation_data=(x_test, y_test))

# 测试模型

test_text = "This movie is great!"

test_text_sequence = np.array([np.array([word_index[word] if word in word_index else 0 for word in test_text.split()])])

test_text_sequence = pad_sequences(test_text_sequence, maxlen=max_length, padding='post', truncating='post')

prediction = model.predict(test_text_sequence)[0][0]

if prediction >= 0.5:

print("Positive sentiment")

else:

print("Negative sentiment")

在这个代码示例中,我们使用了Python的TensorFlow库来实现了一个基于深度学习的情感分析算法,该算法可以对电影评论进行情感分类,这个demo比较简单,但是也说明了基于深度学习的自然语言处理算法的实现思路。我们可以使用深度学习模型来处理自然语言文本,从而实现各种自然语言处理任务。

🌈模型评估

在自然语言处理任务的结果分析中,通常需要关注以下几个方面:

模型性能:通过准确率、召回率、F1值等指标评估模型在各个任务上的表现。

泛化能力:评估模型在未见过的数据上的表现,以验证其在实际应用中的可靠性。

模型可解释性:分析模型的内部结构和参数,以理解其模型的预测结果和行为。

💪总结

随着人工智能和自然语言处理技术的不断发展,NLP技术的应用范围也将会不断扩大。所以,我们需要理解各种算法的工作原理和应用场景,来帮助我们更好地学习和应用NLP算法。

243

243

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?