目录

前言

📅大四是整个大学期间最忙碌的时光,一边要忙着备考或实习为毕业后面临的就业升学做准备,一边要为毕业设计耗费大量精力。近几年各个学校要求的毕设项目越来越难,有不少课题是研究生级别难度的,对本科同学来说是充满挑战。为帮助大家顺利通过和节省时间与精力投入到更重要的就业和考试中去,学长分享优质的选题经验和毕设项目与技术思路。

🚀对毕设有任何疑问都可以问学长哦!

选题指导:

大家好,这里是海浪学长毕设专题,本次分享的课题是

🎯基于大数据技术的招聘市场数据分析可视化系统

设计思路

一、课题背景与意义

随着互联网的迅速发展,招聘市场变得越来越庞大和复杂。为了更好地理解和分析招聘市场的趋势、需求和竞争状况,基于大数据技术的招聘市场数据分析可视化系统应运而生。这样的系统可以帮助招聘机构、求职者和决策者深入了解招聘市场的情况,掌握关键信息,做出更明智的决策。通过分析招聘市场的数据,可以发现潜在的人才供需关系、热门职位和行业趋势,从而为企业的人力资源规划和求职者的职业发展提供支持。

二、算法理论原理

2.1 文本向量化

TF-IDF模型是一种用于衡量词语在文本中的重要性的技术。该模型结合了词频和逆文档频率两个指标,用于确定一个词在文档集合中的重要程度。词频指的是一个词在文档中出现的频率,而逆文档频率指的是一个词在整个文档集合中的稀有程度。通过将词频和逆文档频率相乘,TF-IDF模型能够计算出一个词的TF-IDF值,该值越高表示该词在文档中越重要且在整个文档集合中越稀有。TF-IDF模型常用于信息检索、文本分类和关键词提取等任务,能够帮助我们确定文本中词语的重要性,从而提高文本挖掘和信息检索的效果。

Word2Vec模型是一种用于将单词表示为连续向量空间的技术,它能够捕捉到单词之间的语义和关联关系。该模型基于分布假设,即相似上下文中出现的单词往往具有相似的语义含义。通过训练大规模语料库,Word2Vec模型可以学习到单词向量的表示,使得语义相似的单词在向量空间中距离较近。另外,Word2Vec模型还可以进行词语之间的计算,如词语的加减运算,从而实现了一定程度的语义推理。因此,Word2Vec模型在自然语言处理领域广泛应用,包括词义相似度计算、文本分类、命名实体识别等任务。通过使用Word2Vec模型,我们能够获取到更丰富、更准确的单词表示,提高了文本理解和语义分析的能力。

2.2 LDA主题模型

主题模型是一种无监督学习的技术,通过挖掘文本中的语义关系对文本进行聚类。其中,LDA是一种常用的主题模型。LDA模型利用词语的分布概率来构建主题,反映了特定词语在对应主题中的出现频率,而常见的词语可以解释该主题的特征。一个文本可能包含多个主题,其中每个词语都属于所有主题,但不同主题下词语的分布有所差别。主题模型通过统计文本中的词语,生成一系列词语的概率分布来表达主题内容,并计算文本中每个主题所占的比例。每个主题的解读会根据词语分布的不同而变化,每个文本会根据生成的主题分布进行解读。在LDA模型中,文本集中的每篇文本都可以得到主题的概率分布。通过LDA主题模型的使用过程,可以提取文本的主题以及主题下的关键词,用于进行特征解释。举例来说,在数据分析师的招聘需求中,每个需求要求可以看作一个文本,通过LDA主题模型可以自动提取出主题,并计算每个主题的分布以及词语的分布情况,从而理解和解释每项招聘要求的特征。

2.3 聚类算法

自适应加权聚类算法是一种用于数据聚类的方法,其原理是在传统聚类算法(如K均值)的基础上引入自适应权重,以更好地适应数据的分布和特点。该算法通过考虑样本之间的相似性和权重调整的方式,将具有相似特征的数据点聚类在一起。在传统聚类算法中,所有数据点的权重都是相等的,而自适应加权聚类算法会根据数据点之间的距离和相似性动态地调整权重。这样,距离较近、相似度较高的数据点会被赋予更高的权重,而距离较远、相似度较低的数据点则会被赋予较低的权重。通过自适应权重的引入,算法可以更准确地识别和分离不同的数据簇,提高聚类结果的质量。

自适应权重的计算是自适应加权聚类算法中的关键步骤。主要参数包括距离函数和相似度度量。首先,通过选择合适的距离函数(如欧氏距离、曼哈顿距离等),计算数据点之间的距离。然后,使用相似度度量方法(如余弦相似度、相关系数等)计算数据点之间的相似度。基于距离和相似度的计算结果,可以确定数据点的自适应权重。一种常见的计算方式是使用距离和相似度的函数关系来计算权重,例如,可以采用高斯核函数将距离转化为相似度,并将相似度作为权重的一部分。

三、检测的实现

3.1 数据集

由于网络上没有现有的合适的数据集,我决定自己进行数据收集。通过使用网络爬虫技术,我收集了大量的招聘市场数据,包括职位信息、公司信息、薪资水平、地理位置等。这个自制数据集涵盖了多个招聘网站和招聘平台的数据,具有广泛的覆盖范围和多样性。为了进一步丰富数据集并提高数据质量,进行了数据扩充和数据标注的工作。数据扩充方面,我利用数据增强技术对原始数据进行了变换和合成,生成了更多样化和丰富的数据样本。数据标注方面,我对收集到的数据进行了人工标注,为每个样本添加了类别标签和其他相关信息,以便进行更精确的分析和可视化展示。通过数据扩充和标注,我增强了数据集的多样性和可用性,为后续的数据分析和可视化工作奠定了基础。

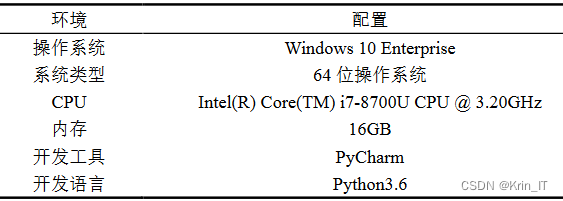

3.2 实验环境搭建

3.3 实验及结果分析

设计一个基于大数据技术的招聘市场数据分析可视化系统涉及多个关键方面:

- 系统需要收集和整合来自不同招聘网站和数据源的大量招聘市场数据,包括职位信息、薪资水平、公司信息等。这些数据可以通过网络爬虫技术实时获取,并通过大数据存储和处理技术进行高效管理和处理。

- 为了提供可视化的数据分析功能,系统需要设计和实现多种数据可视化技术,例如图表、地图、热力图等。这些可视化方式可以帮助用户更直观地理解和分析招聘市场的趋势和模式。通过交互式的界面,用户可以选择感兴趣的数据维度和指标,并对数据进行筛选和过滤,以便深入挖掘数据背后的信息。

- 为了提供更深入的数据分析和洞察,系统可以利用机器学习和数据挖掘算法。通过这些算法,系统可以发现潜在的招聘市场趋势、职位需求预测和薪资变化预测等。这些分析结果可以通过可视化方式展示给用户,并帮助他们做出更明智的招聘决策。

- 除了数据分析和可视化功能,系统还应该考虑用户体验和易用性。用户应该能够轻松地使用系统进行数据查询、分析和可视化操作,而无需具备深入的数据分析技能。因此,系统的界面设计应简洁直观,操作流程应清晰易懂。同时,系统还可以提供用户个性化的设置和定制功能,以满足不同用户的需求和偏好。

相关代码示例:

def adaptive_clustering(data, k, max_iterations=100, tolerance=0.0001):

# 初始化聚类中心

centers = data[np.random.choice(range(len(data)), k, replace=False)]

for _ in range(max_iterations):

# 计算每个样本与聚类中心的距离

distances = np.linalg.norm(data[:, np.newaxis] - centers, axis=2)

# 计算权重

weights = 1 / (distances + 1e-8)

weights /= np.sum(weights, axis=1)[:, np.newaxis]

# 计算新的聚类中心

new_centers = np.dot(weights.T, data)

new_centers /= np.sum(weights, axis=0)[:, np.newaxis]

# 计算聚类中心的变化量

center_shift = np.linalg.norm(new_centers - centers)

if center_shift < tolerance:

break

centers = new_centers

# 根据最终的聚类中心,确定每个样本的簇标签

labels = np.argmin(np.linalg.norm(data[:, np.newaxis] - centers, axis=2), axis=1)

return labels, centers

实现效果图样例:

创作不易,欢迎点赞、关注、收藏。

毕设帮助,疑难解答,欢迎打扰!

本文介绍了基于大数据技术的招聘市场数据分析可视化系统的开发,包括课题背景、算法理论(如TF-IDF、Word2Vec、LDA和自适应加权聚类),数据集的收集与处理,以及实验实现过程。系统旨在帮助用户理解招聘市场趋势,进行智能决策。

本文介绍了基于大数据技术的招聘市场数据分析可视化系统的开发,包括课题背景、算法理论(如TF-IDF、Word2Vec、LDA和自适应加权聚类),数据集的收集与处理,以及实验实现过程。系统旨在帮助用户理解招聘市场趋势,进行智能决策。

5062

5062

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?