引言:

非线性激活函数是在神经网络中使用的一种函数,它的作用是引入非线性特性,使得神经网络可以学习和表示更加复杂的函数关系。在神经网络中,激活函数通常被应用于每个神经元的输出,将输入信号进行转换后输出给下一层。

常见的两个函数:

- Sigmoid函数:

- 将输入值映射到(0, 1)之间,适合用于输出层二分类任务,但在深层网络中容易出现梯度消失的问题。

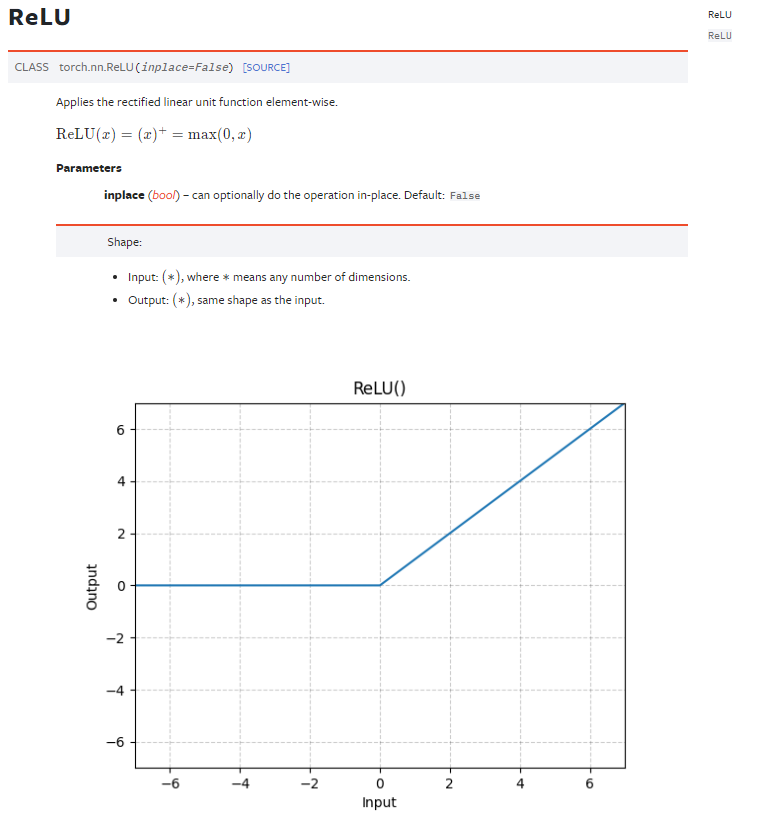

- ReLU函数

- 当输入为正时,输出等于输入;当输入为负时,输出为0。ReLU函数解决了梯度消失的问题,并且计算简单,因此在深度学习中广泛应用。

以ReLU函数为例:

ReLU函数的相关参数:

inplace:表示将是否将数据进行替换;

如图,如果 inplace 的值为True的话,新的值就会将旧的值进行覆盖;如果是False的话,就会将新的值返回,而不会将旧的数据覆盖,False保证了旧数据不会丢失;

代码示例:

import torch

import torchvision.datasets

from torch import nn

from torch.nn import ReLU, Sigmoid

from torch.utils.data import DataLoader

from torch.utils.tensorboard import SummaryWriter

input = torch.tensor([[1, -0.5],

[-1, 3]])

input = torch.reshape(input, (-1, 1, 2, 2))

print(input.shape)

dataset = torchvision.datasets.CIFAR10("../data", train=False, download=True,

transform=torchvision.transforms.ToTensor())

dataloader = DataLoader(dataset, batch_size=64)

class Module(nn.Module):

def __init__(self):

super(Module, self).__init__()

self.relu1 = ReLU()

self.sigmoid1 = Sigmoid()

def forward(self, input):

output = self.sigmoid1(input)

return output

module = Module()

writer = SummaryWriter("./logs_relu")

step = 0

for data in dataloader:

imgs, targets = data

writer.add_images("input", imgs, step)

output = module(imgs)

writer.add_images("output", output, step)

step += 1

writer.close()

710

710

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?