人工智能的兴起

连接主义架构已经存在了 70 多年,但新的架构和图形处理单元 (GPU) 将它们带到了人工智能的最前沿。深度学习不是一种单一的方法,而是一类算法和拓扑结构,可以应用于广泛的问题。

虽然深度学习当然不是什么新鲜事物,但由于深度分层神经网络和使用 GPU 加速其执行的交集,它正在经历爆炸性增长。大数据也推动了这种增长。由于深度学习依赖于使用示例数据训练神经网络,并根据其成功情况对其进行奖励,因此数据越多,构建这些深度学习结构就越好。

深度学习中使用的架构和算法种类繁多。本节探讨了过去 20 年中的六种深度学习架构。值得注意的是,长短期记忆 (LSTM) 和卷积神经网络 (CNN) 是此列表中最古老的两种方法,也是各种应用中最常用的两种方法。

本文将深度学习架构分为监督学习和无监督学习,并介绍了几种流行的深度学习架构:卷积神经网络、循环神经网络 (RNN)、长短期记忆/门控循环单元 (GRU)、自组织映射 (SOM)、自动编码器 (AE) 和受限玻尔兹曼机 (RBM)。它还概述了深度置信网络 (DBN) 和深度堆叠网络 (DSN)

人工神经网络 (ANN) 是深度学习背后的底层架构。基于ANN,已经发明了算法的几种变体。要了解深度学习和人工神经网络的基础知识,请阅读深度学习简介一文。

监督式深度学习

监督学习是指在用于训练的数据中清楚地标记要预测的目标的问题空间。

在本节中,我们将介绍两种最流行的监督式深度学习架构——卷积神经网络和递归神经网络以及它们的一些变体。

卷积神经网络

CNN是一个多层神经网络,在生物学上受到动物视觉皮层的启发。该架构在图像处理应用中特别有用。第一个CNN是由Yann LeCun创建的;当时,该架构专注于手写字符识别,例如邮政编码解释。作为深度网络,早期图层识别要素(例如边),后期图层将这些要素重新组合为输入的更高级别属性。

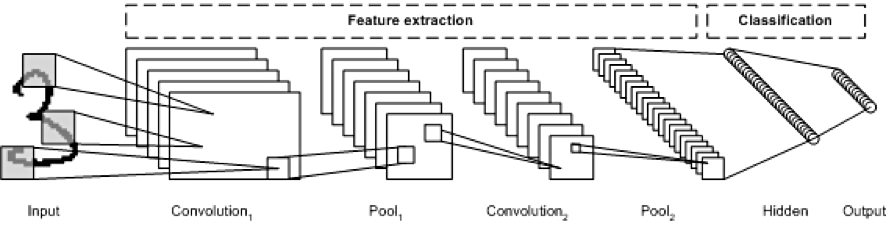

LeNet CNN 架构由多个层组成,这些层实现了特征提取和分类(见下图)。图像被划分为感受野,这些感受野馈送到卷积层,然后卷积层从输入图像中提取特征。下一步是池化,它降低了提取特征的维数(通过下采样),同时保留了最重要的信息(通常通过最大池化)。然后执行另一个卷积和池化步骤,将其馈入完全连接的多层感知器。该网络的最终输出层是一组用于标识图像特征的节点(在本例中,每个标识编号一个节点)。您可以使用反向传播来训练网络。

使用深层处理、卷积、池化和全连接分类层为深度学习神经网络的各种新应用打开了大门。除了图像处理之外,CNN还成功地应用于视频识别和自然语言处理中的各种任务。

应用示例:图像识别、视频分析和自然语言处理

递归神经网络

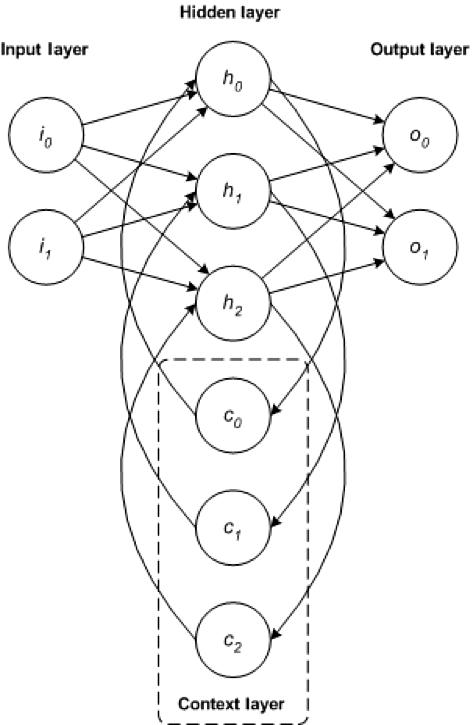

RNN 是构建其他深度学习架构的基础网络架构之一。典型的多层网络和循环网络之间的主要区别在于,循环网络可能具有反馈到前一层(或同一层)的连接,而不是完全的前馈连接。这种反馈使 RNN 能够及时保持对过去输入和建模问题的记忆。

RNN 由一组丰富的架构组成(接下来我们将研究一种称为 LSTM 的流行拓扑)。关键的区别在于网络内的反馈,它可以从隐藏层、输出层或它们的某种组合中表现出来。

RNN 可以及时展开并使用标准反向传播或使用称为时间反向传播 (BPTT) 的反向传播变体进行训练。

应用示例:语音识别和手写识别

LSTM 网络

LSTM 由 Hochreiter 和 Schimdhuber 于 1997 年创建,但近年来它作为各种应用程序的 RNN 架构越来越受欢迎。您会在日常使用的产品(例如智能手机)中找到 LSTM。IBM 在 IBM Watson® 中应用了 LSTM,以实现里程碑式的对话语音识别。

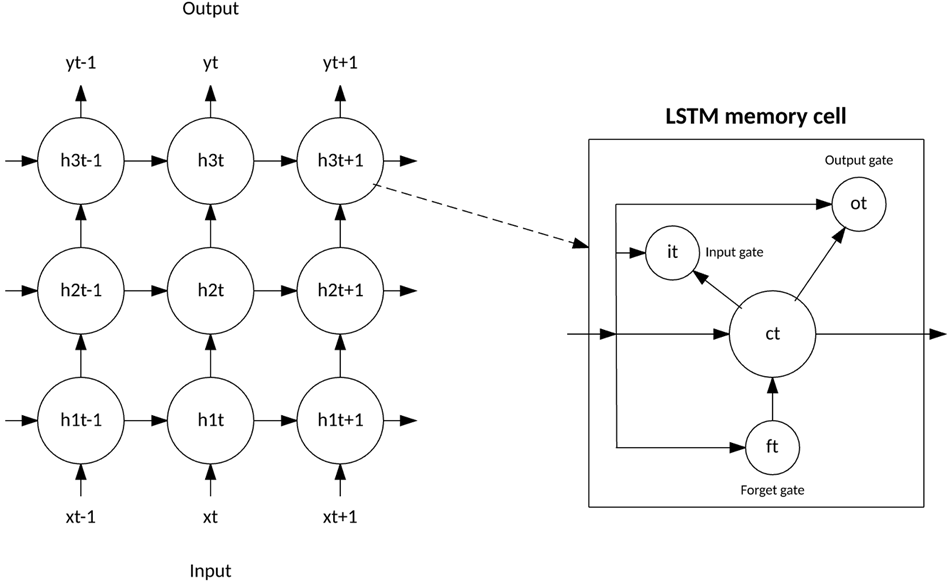

LSTM背离了典型的基于神经元的神经网络架构,而是引入了存储单元的概念。存储单元可以在短时间或长时间内保留其值作为其输入的函数,这使得单元能够记住重要的东西,而不仅仅是其最后计算的值。

LSTM 存储单元包含三个门,用于控制信息如何流入或流出单元。输入门控制新信息何时可以流入存储器。遗忘门控制现有信息何时被遗忘,允许单元记住新数据。最后,输出门控制何时将单元中包含的信息用于单元的输出。该单元还包含控制每个门的权重。训练算法(通常是 BPTT)根据生成的网络输出误差来优化这些权重。

CNN 和 LSTM 的最新应用产生了图像和视频字幕系统,其中图像或视频以自然语言字幕。CNN 实现图像或视频处理,LSTM 经过训练以将 CNN 输出转换为自然语言。

应用示例:图像和视频字幕系统

GRU网络

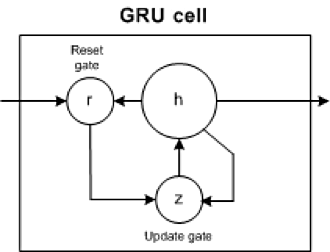

2014 年,引入了 LSTM 的简化,称为门控循环单元。该模型有两个门,摆脱了 LSTM 模型中存在的输出门。这些门是更新门和复位门。更新门指示要维护多少以前的单元格内容。复位门定义了如何将新输入与以前的单元内容合并。GRU 只需将复位门设置为 1 并将更新门设置为 0 即可对标准 RNN 进行建模。

GRU 比 LSTM 更简单,可以更快地进行训练,并且可以更有效地执行。但是,LSTM 可以更具表现力,并且使用更多数据可以带来更好的结果。

示例应用:自然语言文本压缩、手写识别、语音识别、手势识别、图像字幕

在线教程

- 麻省理工学院人工智能视频教程 – 麻省理工人工智能课程

- 人工智能入门 – 人工智能基础学习。Peter Norvig举办的课程

- EdX 人工智能 – 此课程讲授人工智能计算机系统设计的基本概念和技术。

- 人工智能中的计划 – 计划是人工智能系统的基础部分之一。在这个课程中,你将会学习到让机器人执行一系列动作所需要的基本算法。

- 机器人人工智能 – 这个课程将会教授你实现人工智能的基本方法,包括:概率推算,计划和搜索,本地化,跟踪和控制,全部都是围绕有关机器人设计。

- 机器学习 – 有指导和无指导情况下的基本机器学习算法

- 机器学习中的神经网络 – 智能神经网络上的算法和实践经验

- 斯坦福统计学习

有需要的小伙伴,可以点击下方链接免费领取或者V扫描下方二维码免费领取🆓

人工智能书籍

- OpenCV(中文版).(布拉德斯基等)

- OpenCV+3计算机视觉++Python语言实现+第二版

- OpenCV3编程入门 毛星云编著

- 数字图像处理_第三版

- 人工智能:一种现代的方法

- 深度学习面试宝典

- 深度学习之PyTorch物体检测实战

- 吴恩达DeepLearning.ai中文版笔记

- 计算机视觉中的多视图几何

- PyTorch-官方推荐教程-英文版

- 《神经网络与深度学习》(邱锡鹏-20191121)

- …

第一阶段:零基础入门(3-6个月)

新手应首先通过少而精的学习,看到全景图,建立大局观。 通过完成小实验,建立信心,才能避免“从入门到放弃”的尴尬。因此,第一阶段只推荐4本最必要的书(而且这些书到了第二、三阶段也能继续用),入门以后,在后续学习中再“哪里不会补哪里”即可。

第二阶段:基础进阶(3-6个月)

熟读《机器学习算法的数学解析与Python实现》并动手实践后,你已经对机器学习有了基本的了解,不再是小白了。这时可以开始触类旁通,学习热门技术,加强实践水平。在深入学习的同时,也可以探索自己感兴趣的方向,为求职面试打好基础。

第三阶段:工作应用

这一阶段你已经不再需要引导,只需要一些推荐书目。如果你从入门时就确认了未来的工作方向,可以在第二阶段就提前阅读相关入门书籍(对应“商业落地五大方向”中的前两本),然后再“哪里不会补哪里”。

有需要的小伙伴,可以点击下方链接免费领取或者V扫描下方二维码免费领取🆓

2016

2016

被折叠的 条评论

为什么被折叠?

被折叠的 条评论

为什么被折叠?